Künstliche Intelligenz auf dem Weg zum Mainstream?

Kaum ein Bereich diskutiert aktuell nicht die Chancen und Risiken von KI. Neben den eigentlichen Anwendungen bzw. und den daraus entstehenden Möglichkeiten diskutieren Anbieter und Anwender auch die Anforderungen an die IT-Infrastruktur, künstliche Intelligenz praxistauglich einzusetzen.

- Künstliche Intelligenz auf dem Weg zum Mainstream?

- Softwareentwicklung und Standard-Best-Practices

Als erstes Unternehmen, dass sich und seine Storage-Lösungen voll und ganz der Flash-Technologie verschrieben hat, ist Pure Storage an vielen Diskussionen und Entwicklungen aktiv beteiligt. Die zahlreichen Eindrücke auf dem diesjährigen AI-Gipfel in San Francisco fasst Güner Aksoy, Regional Sales Director Central Europe bei Pure Storage, in acht Punkten zusammen:

Breites Interesse, KI gewinnt an Fahrt

Künstliche Intelligenz ist ein Thema, das praktisch alle Branchen umfasst. Viele „Global 2000“-Unternehmen aus sämtlichen Branchen - Einzelhandelsfirmen, Telekommunikationsunternehmen, Automobilhersteller, Gesundheitsdienstleister, Pharma- und Medizingeräteunternehmen, Fluggesellschaften und Versicherer – interessieren sich zunehmend für die Möglichkeiten des maschinellen Lernens und der künstlichen Intelligenz.

Deep Learning ist anders als herkömmliche, analytische KI

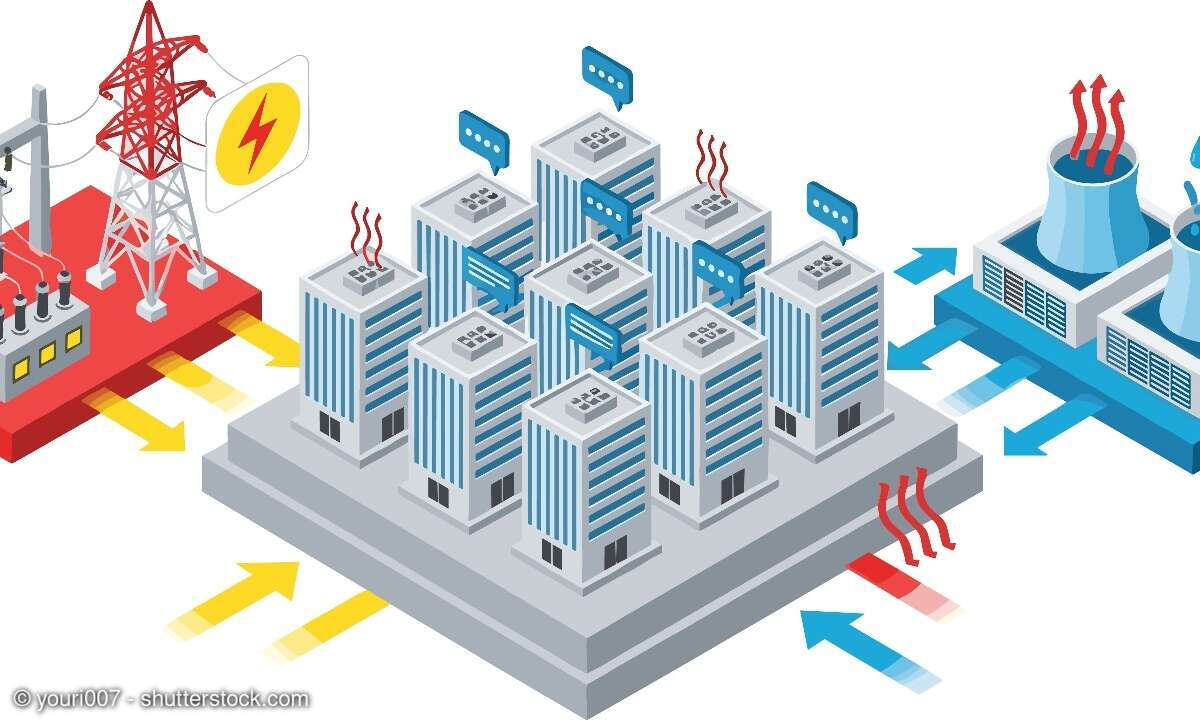

Statistische Regression, Korrelation, Scoring und traditionelle Formen der Analytik können als KI klassifiziert werden. Sie unterscheiden sich jedoch deutlich vom Megatrend der Nutzung von neuronalen Netzwerken für Deep Learning. Es gibt Unterschiede in den Software-Tools, der Infrastruktur und den Fähigkeiten der Datenwissenschaftler, die sie anwenden. Beide Formen werden parallel existieren, aber die größten radikalen Innovationen werden von neuronalen Netzen ausgehen. Die Zeit ist reif für diese Entwicklung, weil die richtigen technischen „Zutaten“ alle gleichzeitig zusammenkommen. Auf der Software-Seite gibt es neue Software-Algorithmen, auf der Infrastrukturseite ist es eine Kombination aus GPU-getriebener Rechenleistung, schnelleren Netzwerken und Flash-Speicher zu beobachten.

Es geht um Datenpipelines

Ein Großteil des anfänglichen Hypes um KI konzentriert sich auf das Training von neuronalen Netzwerken. Um die Nutzung von KI in der Praxis erfolgreich umzusetzen, ist es wichtig zu verstehen, dass die meiste harte Arbeit vor der Trainingsphase erfolgt. Das Sammeln, Extrahieren und Transformieren von Daten sind die ersten Schritte in dieser neuen Datenpipeline. Es gibt zwar unzählige Tools aus jahrzehntelangem Data Warehousing, aber ist es nicht einfach, gute Ergebnisse zu liefern.

Bei vielen Deep-Learning-Projekten werden die Herausforderungen im Zusammenhang mit der Datenmarkierung und dem Debugging des ursprünglichen Modells deutlich. Die Fähigkeit, diese beiden Phasen effektiv zu bewältigen, ist die größte Herausforderung – und ein Wettbewerbsvorteil für diejenigen, die es gut können. Sobald dies abgeschlossen ist, wird noch jede Menge GPU-, Netzwerk- und Speicher-Performance benötigt, um das Training selbst abzuschließen. Schneller, gemeinsam genutzter Speicher wird von großem Wert sein, ebenso wie die Möglichkeit, die Daten effizient durch diese neue Datenpipeline zu bewegen. Das manuelle Kopieren großer Datenmengen auf lokale SSDs für jede Stufe bietet keine Skalierbarkeit und behindert den schnellen Fortschritt.

Müll rein, Müll raus

Das Datenpipeline-Konzept ist wichtig, aber die Weisheit „Garbage in, Garbage out“ gilt immer noch. Wenn man schlechte Daten in ein neuronales Netzwerk einspeist, wird man nicht das erhoffte Ergebnis erzielen. Dies ist ein weiterer Grund, um Datenquellen richtig abzubilden und angemessene Anstrengungen bei der Erfassung, Extraktion und Transformation von Daten zu unternehmen.