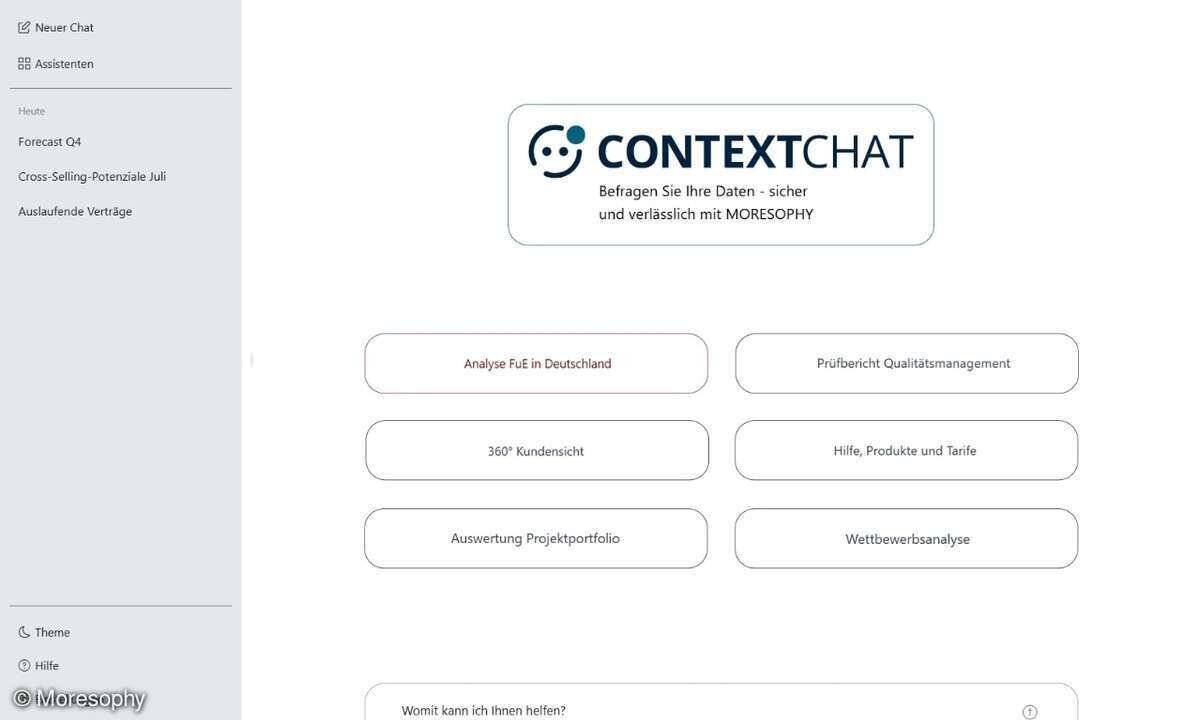

KI-Speicher beschleunigt Daten-Pipelines

Supermicro, Hersteller von IT-Gesamtlösungen für KI, Cloud, Speicherung und 5G/Edge, bringt eine optimierte Full-Stack-Speicherlösung für KI- und ML-Daten-Pipelines auf den Markt – von der Datenerfassung bis zur hochleistungsfähigen Datenbereitstellung.

Die neue Lösung maximiere die Time-to-Value von KI, heißt es seitens des Anbieters, indem sie die GPU-Daten-Pipelines vollständig auslastet. Für das KI-Training können riesige Mengen an Rohdaten mit Kapazitäten im Petascale-Bereich gesammelt, umgewandelt und in die KI-Workflow-Pipeline eines Unternehmens geladen werden.

Die Multi-Tier-Lösung liefere nachweislich Datenmengen im Bereich von mehreren Petabyte für AIOps und MLOps in Produktionsumgebungen. Die gesamte Multi-Rack-Lösung habe man entwickelt, um Implementierungsrisiken zu reduzieren, Unternehmen in die Lage zu versetzen, Modelle schneller zu trainieren und die daraus resultierenden Daten schnell für KI-Inferenzen zu nutzen.

„Mit 20 PByte pro Rack an Hochleistungs-Flash-Speicher mit vier anwendungsoptimierten Nvidia-HGX-H100-8-GPU-basierenden luftgekühlten Servern oder acht flüssigkeitsgekühlten Servern können Kunden ihre KI- und ML-Anwendungen im Rack-Format betreiben und beschleunigen", sagte Charles Liang, President und CEO von Supermicro. Die Lösung biete einen hohe Lesedurchsatz und 3,9 Millionen IOPS pro Speicher-Cluster in der kleinsten Implementierung und sei zudem problemlos auf Hunderte von Petabyte skalierbar.