Digitale Fußabdrücke mit Folgen

Social-Media-Kanäle sind mehr als bloße Plattformen. Sie machen uns identifizierbar, manipulierbar und damit angreifbar. Prof. Dr. Michaela Geierhos erklärt, wie sich digitale Spuren in Sicherheitsrisiken verwandeln und welche Rolle Forschung, KI und Aufklärung dabei spielen.

Soziale Medien sind zum festen Bestandteil unseres Alltags geworden – privat, beruflich, gesellschaftlich. Doch mit jedem Like, jedem Post und jeder Verknüpfung wächst auch unser digitaler Fußabdruck. Was als Vernetzung gedacht war, kann zur Gefahrenquelle werden. Auf der D21-Tagung in Tutzing referierte Prof. Dr. Michaela Geierhos, Professorin für Data Science an der Universität der Bundeswehr München und Forscherin am Institut CODE, genau zu diesem Thema: Social Media als Sicherheitsproblem. connect professional hatte im Vorfeld die Gelegenheit, mit der Informatikprofessorin darüber zu sprechen. Sie beschreibt die Lage nüchtern: „Die Identifizierbarkeit über Social Media macht Nutzerinnen und Nutzer angreifbar, sowohl technisch als auch psychologisch.“ Besonders gefährlich ist die scheinbare Harmlosigkeit vieler preisgegebener Informationen: Interessen, Aufenthaltsorte, Kontakte – sie lassen sich aus öffentlich zugänglichen Profilen und Posts leicht extrahieren.

Anbieter zum Thema

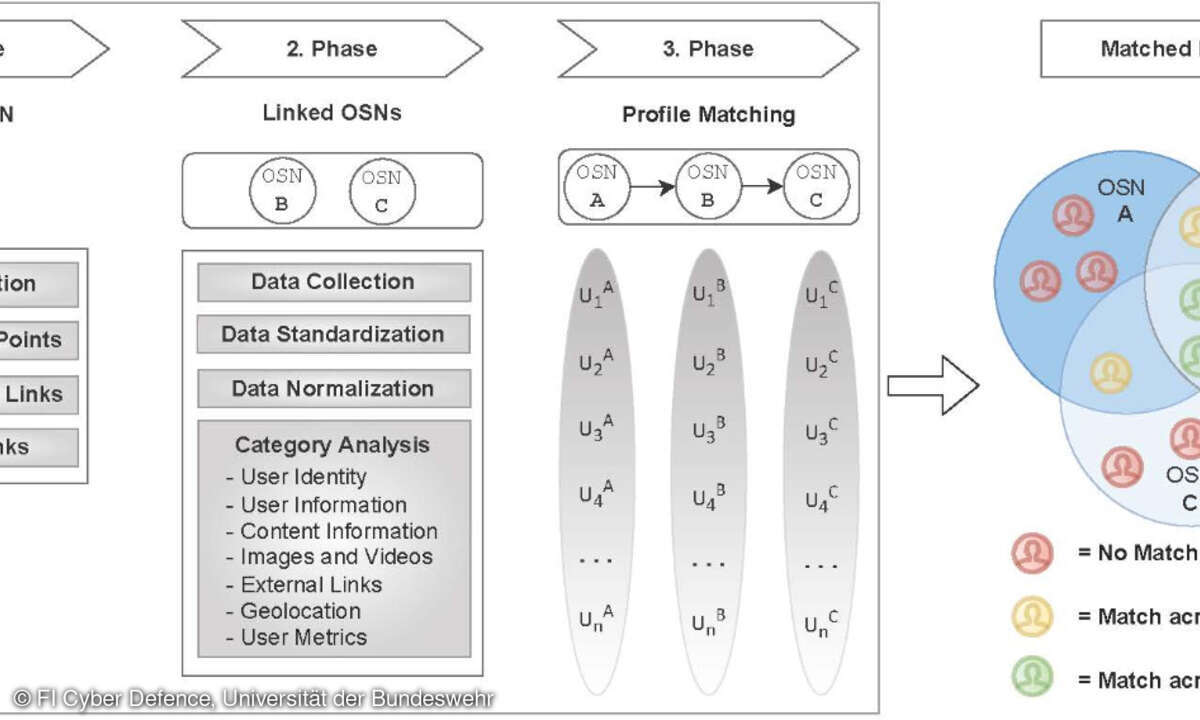

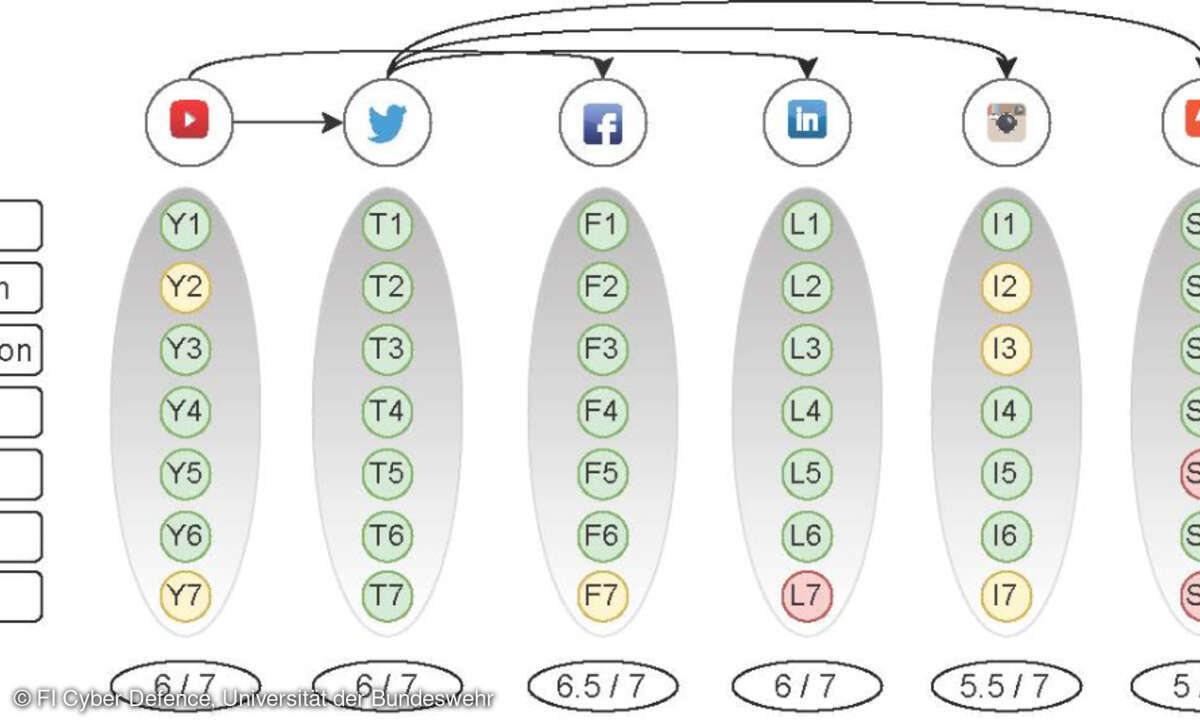

Gerade auf Plattformen wie Facebook, Instagram oder LinkedIn lassen sich aus solch öffentlich zugänglichen Informationen ganze Persönlichkeitsprofile rekonstruieren. Besonders gefährdet: Nutzer:innen, die unbewusst Daten preisgeben oder Plattformen beruflich und privat vermischen. „Schon das identische Profilbild in mehreren Apps kann reichen, um Bewegungsprofile zu erstellen – etwa über Laufstrecken, die Rückschlüsse auf Wohn- oder Arbeitsort erlauben.“ Problematisch sei dabei auch die Bequemlichkeit vieler Nutzer:innen, etwa durch die Nutzung schwacher Passwörter oder durch automatische Log-ins via Facebook- oder Google-Konto. Diese Komfortmechanismen vereinfachen digitale Angriffe, ohne dass es den Betroffenen bewusst ist. „Diese Informationen können gezielt missbraucht werden, beispielsweise für Social Engineering, Identitätsdiebstahl oder Zielgruppenmanipulation“, so Geierhos. Dabei sei Sichtbarkeit allein nicht problematisch, „aber ungeschützte, dauerhafte Sichtbarkeit in einem manipulationsanfälligen digitalen Raum ist es sehr wohl.“

Digitale Risikotypen (Beispiele aus der Forschung)

- Die geschwätzige Mutter postet regelmäßig Fotos und Geschichten über ihre Kinder – oft mit Ort, Zeit und privaten Details.

Der Karrierebewusste dokumentiert auf LinkedIn jede Veranstaltung, jeden Jobwechsel – inklusive Aufenthaltsorten und beruflichem Netzwerk.

Die Bequeme nutzt überall denselben Nutzernamen, dasselbe Profilbild – und liefert so unbeabsichtigt ein verknüpfbares Datennetzwerk. - Fazit: Jedes digitale Verhalten kann zum Risiko werden, wenn es konsistent über Plattformen hinweg sichtbar ist.

Social Engineering, Doxing und Reputationsrisiken

Was folgt aus dieser Sichtbarkeit? Prof. Geierhos warnt: „Viele Menschen können nicht einschätzen, welche Informationen sie preisgeben, oft unbewusst durch Likes, Kommentare oder geteilte Inhalte.“ Die Folge: maßgeschneiderte Phishing-Mails oder Identitätsdiebstahl mit täuschend echter Kommunikation. Besonders perfide: Der sogenannte CEO-Fraud, bei dem sich Täter als Führungskraft ausgeben, um Geldtransfers auszulösen.

Ein Spezialfall ist das sogenannte Doxing, die gezielte Veröffentlichung oder Verwendung privater Informationen zur Erpressung oder öffentlichen Diskreditierung. Dazu zählen etwa Adressen, Familieninformationen oder vertrauliche Gesprächsinhalte. Diese Daten stammen meist nicht aus professionellem Hacking, sondern aus offenen Quellen und sozialen Medien. „Wir beobachten regelmäßig, dass selbst harmlose Angaben wie Restaurantbesuche oder Familienbilder ungewollt gefährliche Angriffsflächen erzeugen“, so Geierhos. Gleichzeitig geraten Unternehmen ins Visier, etwa durch Fake-Bewertungen, gefälschte Pressemitteilungen oder negative Narrative in sozialen Netzwerken. Reputationsverlust ist dabei nicht nur ein Imageproblem, sondern hat messbare wirtschaftliche Folgen: Umsatzeinbrüche, Boykotte, Vertrauensverluste bei Partnern. Auch die psychologische Belastung von Mitarbeitenden nimmt bei digitalem Mobbing oder gezielter Hetze zu.

Wenn Cyberangriff, Desinformation und PsyOps verschmelzen

Besonders gefährlich sind sogenannte hybride Bedrohungen, also das orchestrierte Zusammenspiel verschiedener Angriffsformen. „Ein Cyberangriff auf eine kritische Infrastruktur kann mit einer Desinformationskampagne kombiniert werden, um Verunsicherung oder Panik zu erzeugen“, erläutert Geierhos. Diese Strategie zielt nicht nur auf technische Infrastrukturen, sondern auf gesellschaftliche Stabilität, staatliche Handlungsfähigkeit oder demokratische Prozesse. Die psychologische Komponente spielt dabei eine zentrale Rolle.

Ein Beispiel aus der Praxis: Während der Corona-Pandemie wurden Impfstoffe gezielt diskreditiert – mit emotionalisierten Videos, gefälschten Studien und koordinierten Hashtag-Kampagnen. Geierhos weist darauf hin, dass solche Kampagnen oft grenzüberschreitend ablaufen: „Wir haben gesehen, dass Narrative aus dem russischen Raum zuerst in Nachbarsprachen gestreut und später automatisiert ins Deutsche übertragen wurden.“ Früher war dies durch schlechte Übersetzungen noch zu erkennen. Heute sei das deutlich schwieriger.

Schutz beginnt beim Menschen

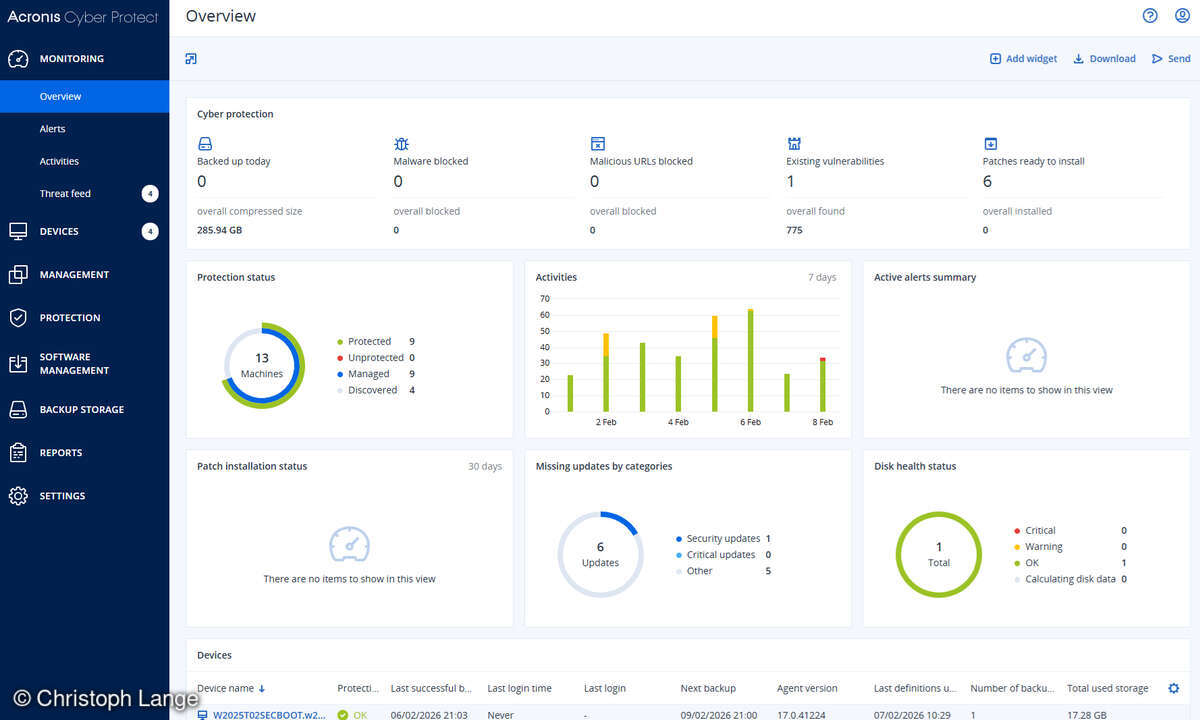

Was können Organisationen tun? Für Geierhos liegt die Antwort nicht nur in der Technik, sondern in der Aufklärung. Denn der Mensch ist das schwächste Glied, aber auch der entscheidende Hebel. Sie plädiert für kontinuierliche, praxisnahe Schulungen, die sich an aktuellen Bedrohungen orientieren. Besonders effektiv seien simulationsbasierte Trainings, in denen Mitarbeitende mit realistischen Angriffsszenarien konfrontiert werden. Entscheidend sei auch, Desinformation nicht als reines IT-Problem zu betrachten, sondern als organisationsweites Thema.

Künstliche Intelligenz verschärft diese Bedrohung. Auf Angreiferseite wird sie genutzt für Deepfakes, automatisierte Falschnachrichten oder Zielgruppenanalyse. Auf Verteidigungsseite setzen Sicherheitsforscher:innen auf KI-gestützte Anomaliedetektion, semantische Textanalysen und narrative Verfolgung. Neben den klassischen Monitoring-Tools setzt CODE beispielsweise zunehmend auf KI-gestützte Frühwarnsysteme. „Diese können Muster in Texten oder Netzwerkanalysen identifizieren und plötzliche Themenaufschwünge erkennen“, erklärt Geierhos. Ein bewährter Ansatz sei auch das sogenannte „Narrative Tracking“, bei dem die Verbreitungswege bestimmter Geschichten analysiert werden. Wichtig sei dabei die Kombination technischer und menschlicher Auswertung – durch interdisziplinäre Teams aus IT, Kommunikation und Sicherheit.

Forschungseinrichtungen wie CODE leisten hier wertvolle Arbeit: Sie entwickeln technische Lösungen, schaffen Bewusstsein für ethische Fragen und beraten politische Institutionen. Geierhos betont: „Forschungseinrichtungen […] können Brücken schlagen zwischen Grundlagenforschung, anwendungsorientierter Technologieentwicklung und politischer Beratung.“ Dabei gehe es nicht nur um Technik, sondern auch um Fragen wie digitaler Resilienz, KI-Sicherheit oder Datenethik. Die verwendeten Tools sind Eigenentwicklungen, die Daten werden anonymisiert und abstrahiert, nicht auf Einzelpersonen zurückführbar. Ein weiterer zentraler Punkt ist der Zugang zu Plattformdaten für die Forschung. „Der Digital Services Act ist ein wichtiger Schritt“, sagt Geierhos, „da er Plattformen stärker in die Verantwortung nimmt […].“ Sie fordert dynamische Regulierung, mehr Transparenz und internationale Kooperation. Denn digitale Manipulation kennt keine Landesgrenzen.

Für junge Fachkräfte in Cybersecurity und Data Science hat sie einen klaren Rat: „Bleiben Sie neugierig und entwickeln Sie neben technischen Fähigkeiten auch ein Verständnis für gesellschaftliche Zusammenhänge.“ Sicherheit sei nicht nur ein technisches, sondern immer auch ein gesellschaftliches Problem.