Raus aus dem Rack? Anbieter müssen nachlegen

Professionelle Infrastruktur, hohe Verfügbarkeit und klar kalkulierbare Kosten sprechen für die IT-Auslagerung ins Rechenzentrum. Doch der Markt verändert sich: Steigende Energiepreise, neue gesetzliche Vorgaben und die wachsende Dynamik moderner IT-Architekturen veranlassen immer mehr Unternehmen dazu, das Portfolio ihres Colocation-Anbieters zu hinterfragen.

Gerade für Unternehmen, die wachsende IT-Landschaften betreiben oder auf neue Dienste wie Containerisierung und hybride Cloud-Lösungen setzen, wird Colocation oft zu unflexibel und teuer. Gleichzeitig erscheinen neue Abrechnungsmodelle wie Pay-per-Use oder nutzungsbasierte Cloud-Tarife immer attraktiver. In der Praxis bedeutet das: Unternehmen müssen heute deutlich granularer planen, welchen IT-Bedarf sie zu welchem Zeitpunkt haben – und wie viel sie bereit sind, dafür zu zahlen. Während traditionelle Colocation-Modelle auf langfristigen Mietverträgen und fixen Service-Level-Agreements (SLAs) basieren, ermöglichen moderne Alternativen dynamische Abrechnungen nach Ressourcenverbrauch, etwa CPU-Stunden, Speicherbedarf oder Netzwerk-Traffic.

EnEfG: Gesetzliche Vorgaben forcieren den Wechsel

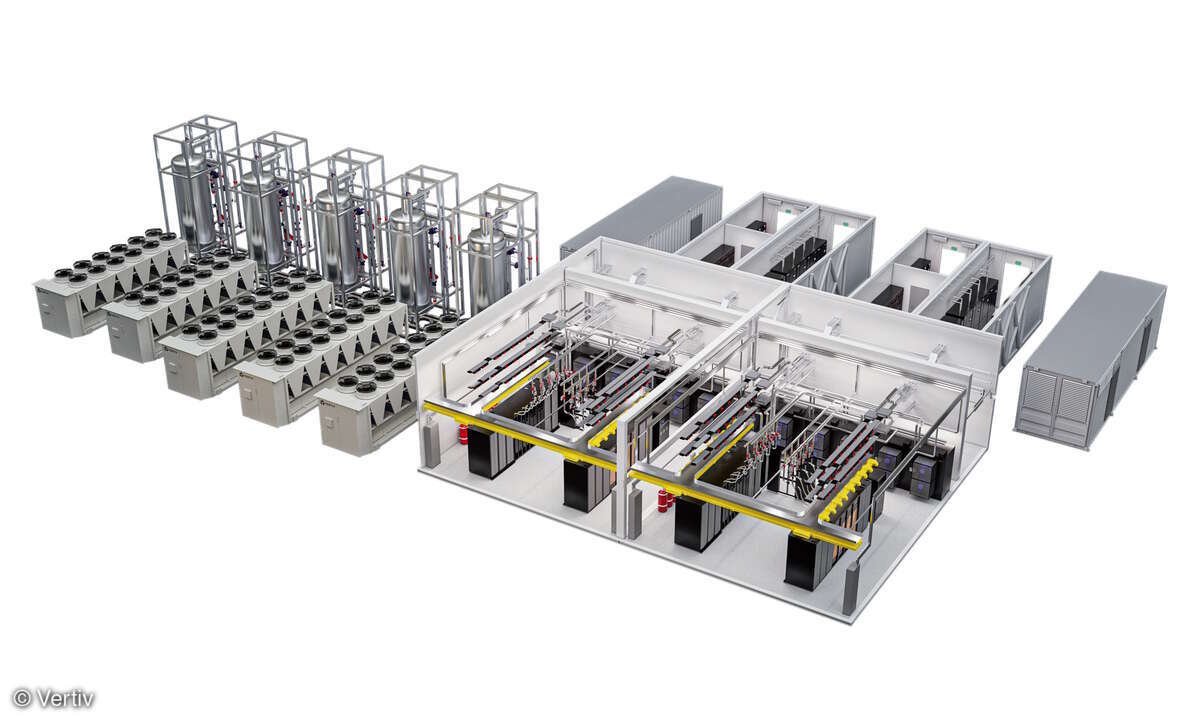

Mit dem Inkrafttreten des Energieeffizienzgesetzes (EnEfG) rückt zudem die Energieeffizienz von Rechenzentren in den Fokus. Unternehmen müssen sicherstellen, dass ihr IT-Betrieb den gesetzlichen Vorgaben entspricht. An Bedeutung gewinnt hierbei der sogenannte Power Usage Effectiveness (PUE)-Wert: Je näher dieser Wert an 1,0 liegt, desto effizienter ist das Rechenzentrum im Energieverbrauch. Viele ältere Colocation-Rechenzentren erreichen allerdings nur Werte zwischen 1,6 und 2,0, während moderne modulare oder Cloud-Infrastrukturen mit Werten um 1,2 oder darunter arbeiten. Kann oder will ein Colocation-Anbieter die erforderlichen Energiekennzahlen nicht einhalten, drohen nicht nur regulatorische Konsequenzen, sondern auch Imageverlust und technische Rückbaukosten. In solchen Fällen wird der Wechsel unausweichlich – auch deshalb, weil sich Unternehmen zunehmend ESG-Kriterien (Environmental, Social and Governance) verpflichtet sehen.

Gleichzeitig verändern sich aber auch die Anforderungen an die IT-Infrastruktur. Unternehmen wachsen, erschließen neue Standorte oder müssen kritische Systeme besser absichern. Georedundanz wird so für viele Organisationen zur Pflicht, was den Bedarf an mehreren Rechenzentrumsstandorten erhöht. Im Kontext von Hochverfügbarkeit und Business Continuity Planning bedeutet das konkret: Daten und Dienste müssen über mindestens zwei, besser drei physisch getrennte Standorte repliziert und synchronisiert werden. Ist der bestehende Anbieter hier nicht skalierbar oder nur mit hohen Investitionen in der Lage, weitere Standorte zu erschließen, suchen viele IT-Verantwortliche nach Alternativen, die flexibler und wirtschaftlicher arbeiten. Auch das Einhalten von Latenzanforderungen – etwa für Finanztransaktionen, IoT- oder Industrie-4.0-Anwendungen – kann dabei ein Argument für regionale Standorte mit spezifischer Netzwerkanbindung sein.

Managed Services werden zum Alleinstellungsmerkmal

Nicht zuletzt führt die zunehmende Dynamik in der IT-Welt dazu, dass klassische Colocation-Angebote an ihre Grenzen stoßen. Colocation bedeutet, die eigene Hardware in fremden Räumen zu betreiben – inklusive Wartung, Monitoring und Ersatzteilmanagement. In Zeiten von Infrastructure-as-Code, automatisierter Skalierung und globaler Verfügbarkeit erreichen solche Lösungen schnell ihren Zenit. Unternehmen suchen zunehmend Anbieter, die nicht nur Stellfläche und Strom liefern, sondern auch Hardware, Plattformdienste oder Managed Services gleich mit anbieten. Der Trend geht hier klar in Richtung IT-as-a-Service. Dabei übernehmen Dienstleister neben dem physischen Hosting auch das Betriebssystem- und Patch-Management, Sicherheits-Updates, Monitoring sowie Backup- und Recovery-Services. In Kombination mit Container-Orchestrierung können diese Modelle sogar komplette Entwicklungs- und Produktionsumgebungen in kürzester Zeit bereitstellen – etwas, das im klassischen Colocation-Umfeld nicht oder nur schwer abzubilden ist.

Ein oft unterschätzter Aspekt ist darüber hinaus die Standortbindung. Colocation ist an die physische Lage des Rechenzentrums gebunden. Expandiert ein Unternehmen, kann das zu Problemen führen. Gleiches gilt, wenn gesetzliche Vorgaben eingehalten werden müssen. Zertifizierungen wie ISO 27001, TISAX oder branchenspezifische Anforderungen im Gesundheits- oder Finanzwesen machen eine Verlagerung notwendig. Wer sich regional breiter aufstellen oder internationale Kunden bedienen möchte, ist auf flexiblere Anbieter angewiesen. Darüber hinaus spielt die physische Anbindung an zentrale Internetknoten wie DE-CIX, AMS-IX oder LINX eine entscheidende Rolle für die Performance. Rechenzentren, die direkte Peering-Verbindungen zu diesen Knotenpunkten bieten, können deutlich geringere Latenzen und höhere Bandbreiten garantieren – ein Wettbewerbsvorteil, insbesondere für Unternehmen mit Echtzeitanforderungen.

Hohe Betriebssicherheit durch Remote Hands

Hinzu kommt der Aspekt des Supports. Gerade im Störungsfall zeigt sich, wie wertvoll ein guter Colocation-Partner sein kann. Standardisierte Ticketsysteme und lange Reaktionszeiten können zu ernsten Problemen führen. Unternehmen, die auf lokale Rechenzentren mit persönlichem Ansprechpartner und schnellen Remote Hands setzen, berichten von deutlich höherer Betriebssicherheit. In vielen Fällen geht es um Minuten – etwa bei einem Hardwareausfall oder einer fehlerhaften Konfiguration. Wenn dann kein qualifizierter Techniker vor Ort ist, kann der Ausfall schnell zur Unterbrechung geschäftskritischer Prozesse führen. Ein direkter Draht zur Technik, transparente Eskalationspfade und individuelle SLAs werden deshalb zunehmend zur Grundvoraussetzung für eine langfristige Zusammenarbeit.

Und natürlich rücken Themen wie Datenschutz, Sicherheitsstandards und Nachhaltigkeit immer mehr in den Fokus. Unternehmen in regulierten Branchen müssen sicherstellen, dass ihre IT-Infrastruktur aktuellen Anforderungen entspricht. Fehlen dem Anbieter entsprechende Zertifizierungen oder Transparenz beim CO2-Ausstoß, geraten Kunden unter Zugzwang. Lokale Anbieter mit grüner Energieversorgung, effizienter Kühlung und klaren ESG-Strategien können hier deutliche Vorteile bieten.

Unbestritten ist: Colocation bleibt für viele Unternehmen eine sinnvolle Option – aber nur, wenn der Anbieter mit der Dynamik der IT-Landschaft Schritt halten kann. Wer Kosten, Flexibilität, Skalierbarkeit und Support neu bewertet, stellt schnell fest, dass sich der Wechsel lohnen kann. Neue Betreiber, hybride Modelle oder integrierte Services bieten deutlich mehr Spielraum. Und in einer Zeit, in der jede Entscheidung zur IT-Infrastruktur auch strategische Auswirkungen hat, ist dieser Spielraum wertvoller denn je. Langfristig wird sich die Colocation-Branche also nur behaupten können, wenn sie über das reine Bereitstellen von Fläche und Strom hinauswächst – hin zu einem echten Infrastrukturdienstleister mit Fokus auf Automatisierung, Compliance und Kundennähe.