Viele Wege führen zum Ziel

In den Rechenzentren tut sich was: Neben der (Re-)Zentralisierung und der Server-Konsolidierung existiert auch das entgegengesetzte Phänomen. Unter dem Stichwort »Scale out« wird dabei für jede Applikation ein eigener Intel-Server eingesetzt. Beide Ansätze haben Vor- und Nachteile.

Von großer Bedeutung bei einer Scale-out-Lösung ist die Administrierbarkeit und damit das Systemmanagement der Server.

Der Trend ist eindeutig: Noch vor zehn Jahren machten Systeme mit einer Intel-Architektur nur ein Drittel aller Server-Verkäufe aus – aktuell beträgt ihr Anteil 90 Prozent. Kostengünstige Standard-Server verfügen heute über den Funktionsumfang (Hardware, Software und Support) von zwei bis drei Jahre alten Unix-Midrange- und Highend-Systemen, kosten aber nur einen Bruchteil proprietärer Systeme. Das gute Preis-Leistungs-Verhältnis hat wesentlich zur Verbreitung von Standard-Plattformen in IT-Infrastrukturen beigetragen.

Was bei Servern zählt, ist neben der Leistung die Verfügbarkeit und Flexibilität. Dies sind die Grundvoraussetzungen für den Einsatz bei der geschäftskritischen Datenverarbeitung. Die Anforderung, die Serverkapazität abhängig von den jeweiligen Anforderungen zu gestalten, bezeichnet Intel als »Skalieren nach Maß«. Oder neudeutsch Scale-right. Dabei gilt es, zwei Vorgehensweisen zu unterscheiden: Erstens die Aufrüstung einzelner Server

(Scale-up) und zweitens die Erweiterung der Infrastruktur mit zusätzlichen gleichartigen Servern (Scale-out). In der Scale-out-Variante lassen sich zwei weitere Implementierungsformen unterscheiden: Möglichkeit eins besteht im Aufbau einer Serverfarm, bei der jedes System einzelne Applikationen bedient, und Möglichkeit zwei bedeutet die Errichtung einer Cluster-Infrastruktur, bei der eine Anwendung die gesamte verfügbare Rechenkapazität etwa für technisch-wissenschaftliche Berechnungen beansprucht.

Scale-out und Scale-up

In vielen herkömmlichen Anwendungsszenarien mit E-Mail- und Datenbankapplikationen sowie betriebswirtschaftlicher Standardsoftware können Scale-out-Lösungen klare Pluspunkte verbuchen. Zwei- und Vier-Prozessor-Server stellen heute problemlos die Performance zur Verfügung, die noch vor kurzem Acht-Prozessor-Maschinen vorbehalten war. Bei gleicher Leistung sind Zwei- und Vier-Prozessor-Systeme heute sowohl bei den Anschaffungs- als auch bei den Betriebskosten deutlich günstiger als Acht-Wege-Server und sie haben diese für die Mehrzahl der Unternehmen praktisch überflüssig gemacht.

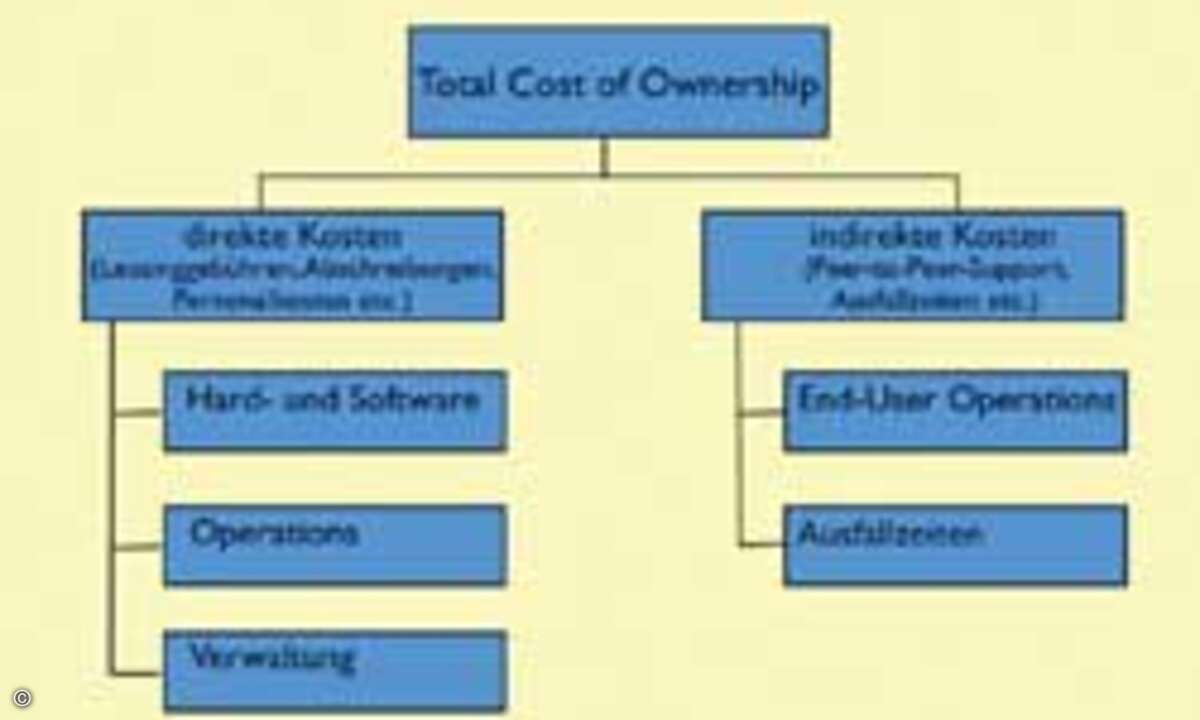

Von großer Bedeutung bei einer Scale-out-Lösung ist die Administrierbarkeit und damit das Systemmanagement. Nachhaltig lassen sich Betriebskosten, auch Total-Cost-of-Ownership oder kurz TCO genannt, durch eine Konsolidierung und Standardisierung von Administrationssoftware senken. Der erste Schritt besteht darin, die im Lieferumfang eines Servers vorhandenen Tools zur Systemadministration zu nutzen. So werden beispielsweise Dell-Poweredge-Server mit der Openmanage-Systemverwaltung ausgeliefert. Sie enthält vielfältige Tools und Verfahren, die Unternehmen benötigen, um Standard-basierte Server installieren und betreiben zu können. Das gleiche gilt für das Änderungsmanagement verfügbarer Hardwareressourcen. Die Systemadministration beginnt mit der Implementierung und erstreckt sich über die gesamte Betriebs- und Lebensdauer einer IT-Infrastruktur. Zudem haben Großunternehmen mit einer langen Rechenzentrumstradition bereits beachtliche Investitionen in Enterprise-Management-Systeme wie Microsoft-Operations-Manager (MOM), BMC-Patrol, CA-Unicenter und andere getätigt. Über entsprechende Interfaces lassen sich daher die Server in übergeordnete Managementframeworks integrieren.

Alles auf eine Karte setzen

Was sich in Anwendungsszenarien mit typischen Standardanwendungen als Vorteil erweist, kann sich bei hoch spezialisierten und anspruchsvollen Applikationen sehr wohl als Nachteil entpuppen. Anders als beim Scale-out lautet beim Scale-up das Leitmotiv: Weg von dedizierten Servern, auf denen sich jeweils nur eine Applikation befindet, hin zu zentralen Systemen, auf denen mehrere Anwendungen laufen.

Scale-up bedeutet, einen Server mit höherer Leistungsdichte zu bestücken: zusätzliche und schnellere Prozessoren, mehr Hauptspeicher, größerer Cache. Gemeint ist damit in der Regel ein Symmetrisches Multi-Prozessor-System (SMP). Im Idealfall wird dabei unterstellt, dass die Leistungsfähigkeit eines solchen Systems linear mit den zusätzlichen Serverressourcen wie Prozessoren, Hauptspeicher und der Datenbreite des Systembusses steigt. Der Vorteil hierbei liegt in der gemeinsamen Nutzbarkeit aller Ressourcen. Allerdings stellt dies – insbesondere bei Systemen mit mehr als vier CPUs – relativ hohe Anforderungen an die Implementierung und lässt die Kosten in die Höhe schnellen. Denn mit Standardkomponenten sind 8- oder gar 16-Prozessor-Server nicht zu realisieren. Darüber hinaus gilt es zu berücksichtigen, dass eine Applikation, die nicht auf das Genaueste für ein SMP-System optimiert wurde, kaum mehr als vier CPUs effektiv nutzen kann. Das heißt: Nur Spezialanwendungen profitieren von Serverlösungen mit acht oder gar mehr Prozessoren.

Konsolidierung kennt vielfältige Erscheinungsformen

Dem Marktforschungsunternehmen IDC zufolge kann eine Konsolidierung von Servern – und konsequenterweise auch von Storage-Systemen – auf unterschiedlichen Ebenen erfolgen – abhängig etwa von konkreten Geschäftsanforderungen oder bei Auswechslung beziehungsweise Ergänzung alter durch neue Technologie. Auf einer gedachten, kontinuierlichen Stufenleiter, mit ansteigendem ROI-Potenzial, unterscheidet IDC vier Konsolidierungsformen:

- Eine logische Konsolidierung,

- eine physikalische Konsolidierung,

- eine Konsolidierung der Arbeitslasten sowie

- eine Konsolidierung von Applikationen.

Bei einer logischen Konsolidierung ändert sich die Zahl der Server – wenn überhaupt – nur unwesentlich. Stattdessen werden jedoch Management- und Administrationsaufgaben wie Datensicherung, regelmäßige Wartung oder der Benutzersupport zentralisiert und aus der Ferne durchgeführt. Diese logische Konsolidierung führt zu einer Reduktion des Personalbedarfs und spart damit unmittelbar Kosten. Denn von einer zentralen Konsole aus kann ein Administrator mehr Server und zusätzliche Speicherkapazität verwalten. Anwender erhalten so einen besseren Service – und dies bei gleichzeitig niedrigeren Kosten für das Unternehmen.

Die nächste Stufe nach einer logischen ist die physikalische Konsolidierung – sprich die zentrale Unterbringung von Servern und Storage-Systemen in einem Rechenzentrum. In erster Linie geht es hier um Servermodelle, die eigens für den Einbau in Racks konzipiert sind. Bei Dell etwa ist bereits jedes zweite verkaufte Server-System ein Rack-Modell. Die Serverlandschaft in den Unternehmen hat sich dadurch erheblich gewandelt, Tower-Modelle befinden auf dem Rückzug. Statt proprietärer Architekturen haben sich auf Industriestandards beruhende Systeme in den Rechenzentren durchgesetzt – nicht zuletzt wegen ihres attraktiven Preis-Leistungs-Verhältnisses.

In Form so genannter Blades zeichnet sich die technologische Weiterentwicklung von Rack-Servern bereits deutlich ab. Statt horizontal werden Blades vertikal eingebaut. Auf jedem dieser Blades läuft eine eigene Instanz des Betriebssystems. Der Administrator hat dann die Möglichkeit, bestimmte Blades für spezifische Anwendungen oder Benutzergruppen zu konfigurieren und Hardware hinzufügen oder zu deaktivieren, ohne dass andere Blades davon beeinträchtigt werden. Eine Optimierung des vorhandenen Platzes und der Ressourcen wird durch Steckverbindungen in der Rückwand eines Rack-Schrankes erzielt. Damit können eine Vielzahl von Blades Infrastrukturkomponenten wie Stromversorgung, Kühlung, Anschluss an lokale Netze und Speichersubsysteme gemeinsam verwenden. Dies senkt Kosten und steigert den Nutzwert von Rack-Servern.

Die Workload-Konsolidierung umfasst der Nomenklatur von IDC zufolge Highend-Server auf Basis von Standardkomponenten sowie Storage-Systeme und andere Netzwerkkomponenten. Auf der Serverseite sind hier Kriterien wie Top-Performance, Multiprozessorfähigkeit, große Caches, riesige Arbeitsspeicher und hohe I/O-Bandbreiten gefragt. Derartige Systeme eignen sich zum Einsatz in Rechenzentren oder Cluster. Zusätzlich zur Technologie kommt es hier auch darauf an, die IT-Prozesse zu standardisieren und so viele Aktivitäten wie möglich zu automatisieren.

Die Konsolidierung von Applikationen, unter Einbeziehung der Storage-Systeme, bildet den vorläufigen Abschluss aller Maßnahmen zur Zentralisierung einer IT-Infrastruktur. Wobei die Zentralisierung hier nicht wörtlich zu nehmen ist, sondern eher als »virtuelle Zentralisierung«, bei der etwa die auf dem Firmengelände oder in Filialen angesiedelten Rechenzentren sowie die Storage-Area-Networks so zusammengefasst werden, dass daraus ein einziges virtuelles Set von IT-Ressourcen entsteht.

Die Basis dieser Art der Konsolidierung von Applikationen bilden so genannte Virtualisierungstechnologien, deren Ausgangspunkt eine Entkopplung von Hard- und Software ist. Wer in diesem Zusammenhang an das Konzept der virtuellen Maschine von Java denkt, liegt so falsch nicht. Eine Java-Virtual-Machine ist ein virtueller Prozessor, der den Java-Byte-Code interpretiert und in Prozessorbefehle der Plattform umsetzt, auf der die Virtual-Machine läuft. Die Plattformunabhängigkeit bedeutet in diesem Fall eine Trennung von Hard- und Software.

Eine Virtual-Machine ist demnach eine Software, die funktional physikalischer Hardware äquivalent ist – zumindest aus der Perspektive ihrer Fähigkeit, Programme ausführen zu können. Bei der Implementierung einer Virtual-Machine existieren zwei Optionen. Beiden gemeinsam ist eine Untergliederung des Hardware-/Software-Stacks in drei Schichten: Applikationen, Virtualisierungsschicht und physikalische Hardware. Der Unterschied zwischen den zwei Modellen besteht lediglich darin, wie die mittlere Virtualisierungsschicht realisiert wird.

E Virtualisierungsschicht als eigenes Betriebssystem: In diesem Fall übernimmt die Virtualisierungsschicht – installiert direkt auf der physikalischen Hardware – die Aufgaben eines herkömmlichen universellen Betriebssystems. Da hier kein generisches Gastbetriebssystem vorhanden ist, bietet dieser Ansatz eine bessere Performance als die zweite Variante. In diese Produktkategorie gehört beispielsweise der ESX-Server von VMware.

E Virtualisierungsschicht als Applikation eines Host-Betriebssystems: In diesem Fall besteht die Virtualisierungsschicht aus der Kombination eines generisches Betriebssystems wie Windows oder Linux und einer Virtualisierungs-Applikation. Da hier die Virtualisierungsschicht alle Services des Hosts nutzen kann, gewährleistet diese Variante eine recht gute Kompatibilität mit bereits vorhandener physikalischer Hardware-Infrastruktur. In diese Produktkategorie gehören etwa der GSX-Server von VMware sowie der Microsoft-Virtual-Server-2005.

Im Übrigen bleibt festzuhalten, dass die Virtualisierung für die IT kein völlig neues Thema ist. Sie ist auf Mainframes seit langem bekannt und wird dort auch eifrig praktiziert. Sie erlaubt es einem bestimmten Betriebssystem als Host (Gastgeber) weiterer Betriebssysteme zu agieren. Insbesondere im Segment der x86-Architekturen erweist sich die Virtualisierung als Technologie mit viel Potenzial, verspricht sie doch die mit Scale-out-Architekturen verbundenen Managementprobleme in den Unternehmen zu lindern.

Ihren Nutzen zeigt die Virtualisierung auch dort, wo Server nur wenig ausgelastet sind. Das mag von Fall zu Fall unterschiedlich sein, vielfach sind Systeme jedoch nur zu 20 Prozent »beschäftigt«. Hier besteht die Chance, per ESX-Server und Vmotion-Technologie eine bessere Auslastung der vorhandenen Hardware zu erzielen. Ein weiterer Aspekt: Virtualisierung ermöglicht, auf brandneuer Hardware weiterhin Windows-NT oder auch Legacy-Applikationen zu unterstützen. Das wichtigste Einsatzgebiet sind Konsolidierungsprojekte, insbesondere dort, wo es um den Aufbau von Test- und Entwicklungsumgebungen geht. Aber auch in ausgewählten Produktivumgebungen erobert sich die Virtualiserung nach und nach ihren Platz, beispielsweise in Serverfarmen.

Peter Dümig, Product Manager Server, Dell