Das Jahrzehnt der Desillusionierung

Das Jahrzehnt der Desillusionierung Von vielen »High Hopes«, mit denen anfangs die moderne Unternehmens-IT befrachtet wurde, ist heute nichts mehr übrig. Das bedeutet jedoch nicht, dass die Kernkomponenten der IT-Infrastruktur, also Rechner, Netzwerke und Speicher, plötzlich unwichtig wären. Im Gegenteil.

Die Geschichte der IT lässt sich aus vielen Perspektiven schreiben: Man kann einzelne Produktkategorien, einzelne Hersteller oder einzelner Technologien betrachten. Oder man kann die Trends, die Produkt- und Technologieentwicklungen aus dem Hintergrund steuern, analysieren und zu verstehen versuchen, wie sie die Entwicklung beeinflussen. Das soll im Folgenden versucht werden. Die InformationWeek gibt es seit 1997. Man muss allerdings etwas weiter zurück gehen, um zu verstehen, was von 1997 bis heute geschehen ist. Der PC hatte ab Mitte der 80er seinen Siegeszug angetreten. Mit der Ausbreitung intelligenter Rechner und leistungsstarker Workstations auf den Arbeitsplätzen verbanden sich sattsam bekannte Ideen. Einige typische lauteten: Wenn es erst genug PCs gibt und man alles digitalisiert hat, kommt das papierlose Büro. Der Mainframe wird irgendwann komplett überflüssig. Firmen müssen nur genug Geld in ihre IT stecken, dann ist ihr Erfolg quasi unausweichlich. Dass das nicht ganz stimmte, stellte man relativ schnell fest. Man musste all die vielen PCs verwalten und wurde fast irre daran. Deshalb erfand man Client/Server-Infrastrukturen. Nun waren die Arbeitsplatz-Rechner wieder etwas dümmer, aber meistens immer noch ziemlich schlau. Dafür entstand der Serverzoo. Auf ihn wurden jetzt die Hoffnungen verlagert, die sich vorher mit PCs verbanden.

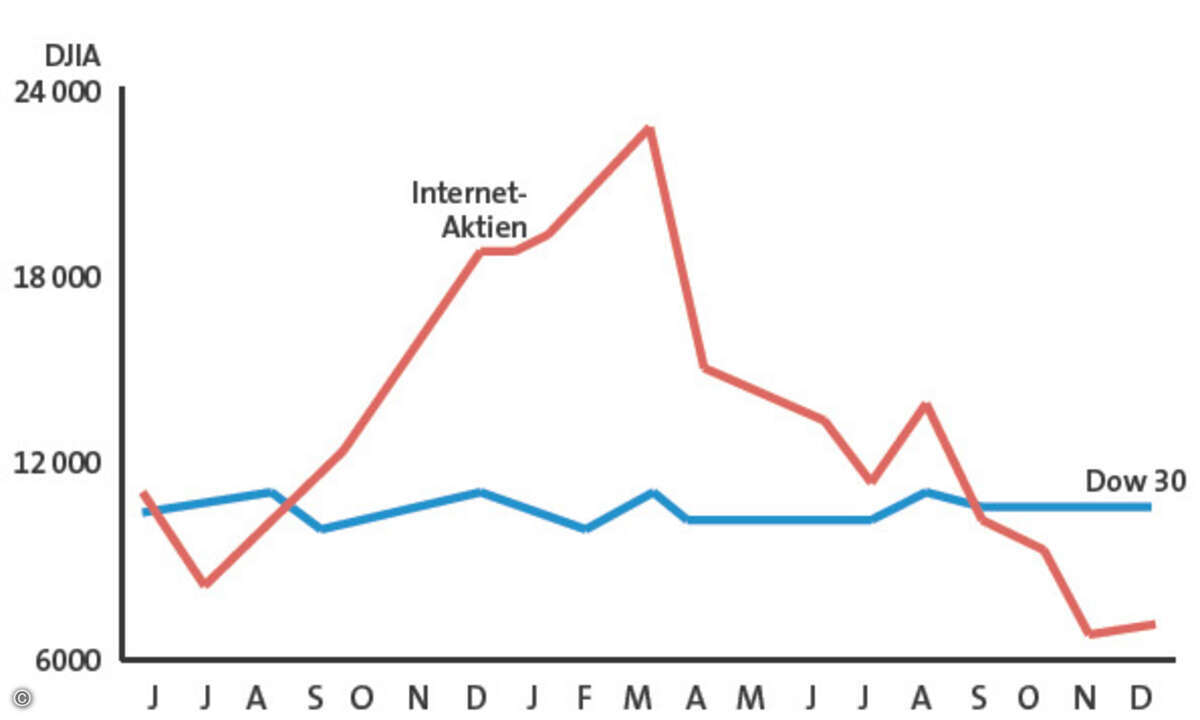

Bruchlandung statt Techno-Euphorie Spätestens ab Mitte der Neunziger Jahre gingen diese Illusionen gründlich zu Bruch. Die Initialzündung dazu gaben unter anderem 1993 die Amerikaner Michael Hammer und James Champy. Ihr Buch trug den schlichten Titel »Reengineering the Corporation« und löste ein Erdbeben in der Branche aus. Die Autoren fragten nach ein paar Dingen, vor denen man bisher schamhaft die Augen verschlossen hatte: Woran liegt es, dass Firmen Unsummen in IT investieren und dennoch – oder vielleicht sogar deswegen – erfolglos sind? Wie müssen Geschäftsmodelle und Prozesse aussehen, die das Optimum aus der IT herausholen? Und wie muss umgekehrt eine IT aussehen, in deren Mittelpunkt nicht die Hatz nach der neuesten technologischen Entwicklung, sondern ihr Beitrag zum Unternehmenserfolg steht? Im Grunde sind das die Fragen, die bis heute in den Köpfen der CIOs kreisen und die letztlich in eine Flut von Entwicklungen mündeten. Im Kern des heutigen IT-Infrastruktur-Designs steht nicht mehr die Frage danach, wie schnell der Prozessor getaktet ist. Gefragt wird viel mehr nach ROI (Return on Investment) und TCO (Total Cost of Ownership). Dass das so ist, verdanken die CIOs in letzter Konsequenz den beiden Amerikanern. Einige weitere Ereignisse trugen dazu bei, dass sich Anfang des neuen Jahrtausends die Konzentration auf das technisch-ökonomisch Sinnvolle nochmals beschleunigte. Das wichtigste war sicher das Platzen der Dotcom-Blase. Sie stand für die letzte, quasi die ultimative Illusion, die den Blick auf die IT-Realität mit ihren vielen lästigen Dollarzeichen verstellt hatte: Das Internet wird es schon richten. Steckt man nur genug Geld in möglichst ausgeflippte Internet-Technik, wird mein Büro papierlos und mein Unternehmen erfolgreich. Die Konsequenzen sind bekannt. Zum Thema Internet findet sich ab Seite 32 in diesem Jubiläumsheft weit mehr, deshalb hier nur so viel: Der bodenlose Absturz vieler Aktien brachte nicht nur die IT-Firmen in die Bredouille, sondern auch viele ihrer Kunden. Sie hatten plötzlich kein Geld mehr, schon gar nicht für Investitionen in windige IT-Technologie.

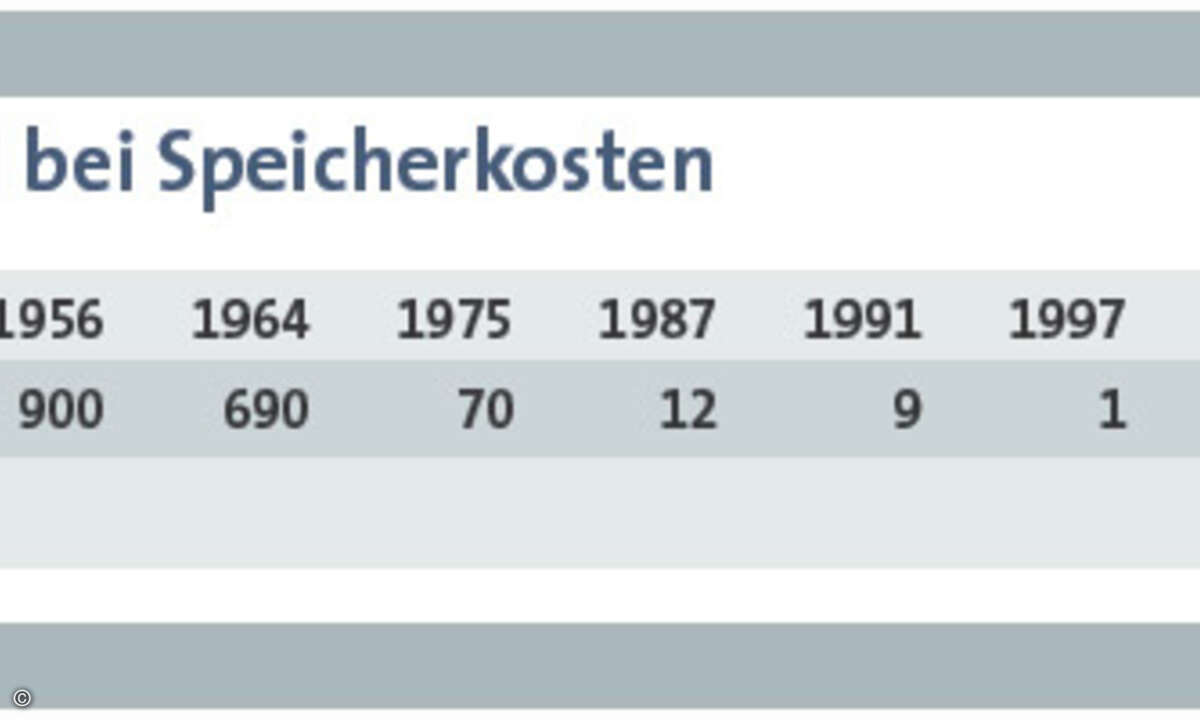

Unangenehme Fragen Notgedrungen begannen die IT-Verantwortlichen zu fragen: Gibt es wirklich keine andere Möglichkeit, als für jede auch noch so lächerliche Anwendung einen neuen Server zu kaufen, wo doch der alte vielleicht nur zu einem Zehntel ausgelastet ist? Muss jeder Server in einem separaten Kästchen stecken, mit Stromversorgung, Lüfter und allem Drum und Dran? Muss ich wirklich in überteuerte Software vom Marktführer investieren, wo es doch quelloffene Lösungen gibt, die noch dazu sicherer arbeiten? Warum soll ich Anwendungen, die auf quelloffenen Systemen arbeiten, eigentlich nicht auf dem Mainframe betreiben können, nur weil der von IBM stammt? Brauche ich tatsächlich immerzu neue Speichersysteme, nur, weil sich der Speicher nicht zwischen mehreren Servern aufteilen lässt? Warum muss ich dieselbe Datei eigentlich zehnmal speichern, und warum landen auch die wertlosesten Daten auf teuren Speichermedien? Seit Neuestem auch: Muss das alles eigentlich so viel Strom verbrauchen, wo der doch immer teurer wird? Warum brauche ich eigentlich zwei Infrastrukturen: eine fürs Telefonieren und eine für Daten? Und in letzter Konsequenz: Warum soll ich das alles eigentlich selbst verwalten? Das kann doch genauso ein Unternehmen von draußen, das nichts anderes tut, während die IT für meine Firma nun wirklich nicht das Kerngeschäft ist. Natürlich merkte die Industrie, dass ein neuer Wind wehte, sie ist schließlich nicht dumm, sondern lediglich profitorientiert. Wahrscheinlich war den Chefstrategen schon lange klar, dass derartige Dinge irgendwann auf sie zukommen würden. Die Konzepte lagen schon in der Schublade, manche waren sogar schon als Produkt zu haben. Nur durchgesetzt hatten sie sich noch nicht. Das kam Anfang des neuen Jahrtausends. Es breiteten sich (neben dem Internet) eine ganze Reihe neuer Technologien aus, die letztlich als Antwort auf die oben angesprochenen Fragen gelten können. Diese Entwicklung ist noch längst nicht abgeschlossen, sondern befindet sich im vollen Lauf. Der gewaltige Preisverfall und technische Fortschritte, zum Beispiel bei der Speicherdichte, tragen dazu bei, diese Trends zu fördern.

Neue Infrastruktur-Technologien Einige Beispiele: Über SANs (Storage Area Networks) kann man heute Speichersysteme gleichzeitig an mehrere Server anschließen und somit ihre Auslastung erhöhen. Außerdem lassen sich durch neue Technologien, die Daten auch aus der Ferne schnell und sicher in die Zentrale übertragen, ganze Speicherlandschaften konsolidieren. Deduplizierung, eine noch sehr neue Technik, durchforstet Datenbestände wirksam nach Dubletten und beseitigt sie. Gleichzeitig bemüht sich die Branche unter dem Stichworten ILM (Information Lifecycle Management) seit mindestens drei Jahren um Lösungen, mit denen sich Daten nach ihrem Wert unterscheiden und dementsprechend auf teuren oder billigen Medien speichern lassen. Solche Lösungen verlagern sie sogar automatisch zwischen diesen Medien, wenn sich ihr Wert ändert. Andere Lösungen sind auf die sich anhäufenden Berge unstrukturierter Daten spezialisiert. Blade-Systeme integrieren viele Server in einem Chassis, das alle gemeinsam mit Strom, Lüftung und Verbindungstechnik ausrüstet. In das Chassis integrieren lassen sich auch andere Funktionsbausteine, beispielsweise der Speicher oder ein SAN. Entsprechende »Scheiben« werden einfach hineingesteckt. Virtualisierung integriert viele Server oder Speichersysteme zu einem und teilt ein leistungsstarkes System in viele Untersysteme auf, ohne dass die Hardware verändert wird. Neben der Vernetzung ist es vor allem sie, die als Königsdisziplin der Infrastrukturoptimierung gesehen werden muss. In letzter Konsequenz trennt sie Hardware komplett von Software. Das ist kein neues Konzept, Mainframes nutzen es schon immer. Neu ist allerdings die Übertragung dieser Technologie auf die vergleichsweise winzigen Serversysteme der heutigen Infrastrukturen. Die Umsetzung dieses Prinzips hat gerade erst richtig angefangen. Multicore-Prozessoren erhöhen die Leistungsfähigkeit des einzelnen Systems. Mit ihnen verabschiedet man sich von immer höheren Taktraten und damit auch von immer mehr Stromverbrauch pro Prozessor. Gegenwärtig kommt gerade die erste Gerätegeneration mit Standard-Quadcore-Prozessoren auf den Markt. Open Source macht Microsoft und den Unix-Anbietern ernsthafte Konkurrenz. Gerade im Bereich der Web-Server oder der Spezialsysteme, beispielsweise Firewalls, machen viele Hersteller und auch Anbieter einen großen Bogen um Microsofts angreifbare und fehlerbehaftete Plattform. Zudem läuft seit 2004 Linux auch auf dem Mainframe, der so zu zig kleinen Servern unter einem Dach wird.

Mehr Befugnisse für CIOs Es ist wahrscheinlich illusionär zu glauben, Microsoft werde irgendwann ernsthaften Schaden nehmen, so lange immer neue Märkte erobert werden können – gerade sind Indien und China dran. Doch mit Linux haben die Anwender eine Betriebssystem-Alternative, und das ist allemal besser als keine. Dass sie diese Wahlfreiheit nutzen, beweisen spektakuläre Fälle wie die Stadt München, die ihre IT auf Linux umstellen will. On-Demand-Computing, ebenfalls ein Kind des letzten Jahrzehnts, ködert Anwender mit dem Versprechen, nur noch so viel Serverleistung und Speicher bezahlen zu müssen wie gerade im Moment benötigt wird. Grid Computing verspricht, große IT-Aufgaben mit relativ kleinen, verteilten Einzelressourcen gemeinsam zu lösen, indem diese gebündelt eingesetzt werden. Gegenwärtig hakt es bei diesen Konzepten noch gewaltig, aber ihnen gehört ein Teil der Zukunft. Green IT schließlich bemüht sich, die Kosten für Strom und Kühlung endlich nach unten zu drücken und dabei auch noch die eine oder andere Tonne Kohlendioxid zu sparen. Gerade werden die ersten stromsparenden RZ-Designs gebaut und die ersten energieoptimierten Router vorgestellt. Man staunt, was alles geht, wenn man nur will. Für die Industrie bedeutete und bedeutet die sich abzeichnende Entwicklung hin zu Effizienz und schmaleren Infrastrukturen vor allem eins: Konsolidierung. Spektakuläre Deals gab es jede Menge: HP-Compaq oder Sun-StorageTek sind nur zwei von vielen. Der Markt für Speicherswitches ist auf zwei große und zwei kleinere Hersteller geschrumpft, der für Speichersoftware bis auf einige kleinere Unternehmen quasi verschwunden, einverleibt entweder von Hardwarevendoren wie EMC oder von Softwarefirmen wie Symantec. Wenig profitträchtige Bereiche werden ausgelagert – spektakulärstes Beispiel: IBM verkauft sein PC-Geschäft an Lenovo und gründet mit Hitachi ein Festplattenfertigungs-Unternehmen. Das Spiel ist noch nicht zu Ende, und es wird sicher spannend zu sehen, was die nächsten Jahre bringen. Was nun bedeutet das für den CIO, den Leser der InformationWeek? Viel Druck, natürlich. Aber auch mehr Entscheidungsbefugnisse und Verantwortung – schließlich soll er nun IT-gestützte Geschäftsprozesse designen statt nur Hard- und Software zu kaufen und zu betreiben. Daran geknüpft ist oft der Aufstieg in die oberste Entscheidungsebene des Unternehmens, wohin ihn InformationWeek gern begleitet.