Server-Leistung scheibchenweise

Server-Leistung scheibchenweise Virtualisierung revolutioniert den Server-Raum: Maschinen müssen mehreren Applikationen dienen, Software wird bedarfsgerecht modularisiert. Anwender sparen bares Geld, Hardware-Lieferanten lernen das Fürchten.

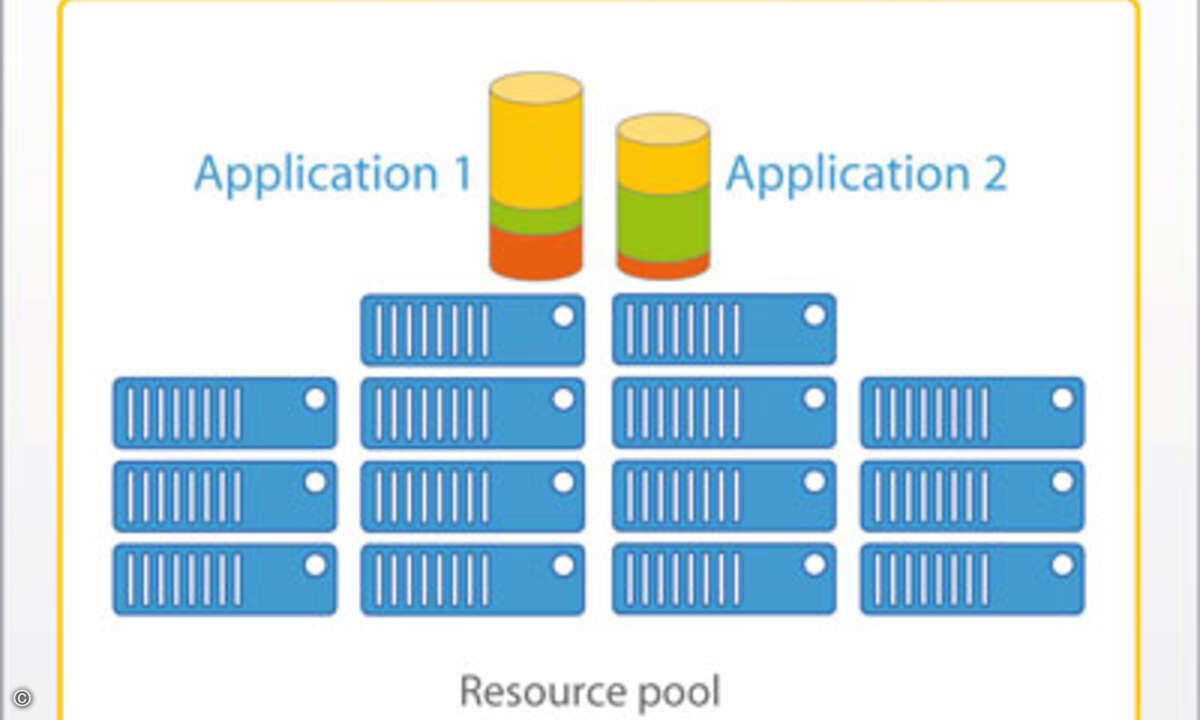

Immer mehr Unternehmen haben genug von überquellenden Server-Räumen und entdecken die Virtualisierung als Lösung für ihre Platz- und Auslastungsprobleme. Virtualisierung ist die Kunst, verschiedene in sich abgeschlossene Anwendungsumgebungen auf nur einem physikalischen Server zu betreiben. Das verändert das Management der IT-Ressourcen und die Anforderungen ans IT-Personal, lastet vorhandene Hardware effizienter aus, verteilt die Ressourcen gleichmäßiger, flexibilisiert die Anwendungsdienste und spart zudem bares Geld. Allerdings sind virtualisierte IT-Umgebungen nicht billig. Auch Sicherheitsfragen sind noch offen. Die Leistung der Anwendungen kann bis um 15 Prozent sinken. Und der Support der Hersteller für virtualisierte Anwendungen ist zuweilen problematisch. Korrekt verwaltet, und dafür gibt es bereits gute Tools, bietet Virtualisierung IT-Verantwortlichen aber einen sehr brauchbaren Werkzeugkasten, um Datenzentren von Grund auf neu und effizienter zu konzipieren.

Good Vibrations Wie wichtig Virtualisierung ist, zeigte die Versechsfachung der Besucherzahl auf der VMworld zwischen 2004 und heute. »Die Stimmung ist hier so wie früher bei der Mac-Community«, sagte Andy Bechtolsheim, der fürs Systemdesign bei der Sun Microsystems Network Systems Group verantwortlich ist, während der Veranstaltung. Tatsächlich eröffnet Virtualisierung den geplagten IT-Verantwortlichen völlig neue Perspektiven. Bis vor kurzem konnten IT-Leiter auftretende Engpässe vor allem durch den Kauf neuer Hardware beseitigen. Nun dienen die oft nur spärlich ausgelasteten Server per Virtualisierungssoftware mehreren Anwendungen gleichzeitig als Basis. Einige Beispiele: Die private Conrad Hinrich Donner Bank in Hamburg, ein Unternehmen der Signal Iduna Gruppe, betreibt auf zwei ESX-Servern 24 virtuelle Server, auf denen größtenteils Microsofts Windows 2000 als Betriebssystem läuft, und spart so Server- und Energiekosten. Auch bei dem Stuttgarter Energiegroßhändler Friedrich Scharr laufen mittlerweile auf zwei IBM-Xseries-Maschinen mit jeweils vier Prozessoren unter Vmware ESX insgesamt 28 Anwendungen. THK, ein führender Hersteller von Linearsystemen, virtualisierte die Server-Plattformen und reduzierte die Server-Hardware so von 60 Maschinen auf drei. Vmware-Präsidentin Diane Greene erklärt, Virtualiserungstechnologie erlaube es den Managern von Rechenzentren, kleinere, für virtuelle Maschinen optimierte Software-Einheiten statt monolithischer Software für Standalone-Server zu nutzen. Allerdings predigt sie nicht die Revolution: Anwender können in kleinen Schritten beginnen und Applikation für Applikation fortschreiten. »Virtualisierung ist die am wenigsten disruptive der disruptiven Technologien«, sagt sie. Virtualisierung geht über bloße Server-Konsolidierung hinaus. Eine in den USA durchgeführte Studie von Enterprise Management Associates bei 150 Early Adoptern ergab, dass Disaster Recovery und Business Continuity die wichtigsten Treiber der Virtualisierung sind. Ein weiterer ist die Möglichkeit zur schnellen Migration, etwa beim Kauf neuer Hardware. Kopien der jeweiligen Software-Konfigurationen auf den Rechnern eines Unternehmens können zusammengestellt und auf andernorts befindliche Rechner gespielt werden. Dort sind sie auf virtualisierten Maschinen bei Bedarf in Minuten lauffähig.

Hardeware-investitionen erübrigen sich Diese »augenblickliche Recovery«, wie Green es nennt, erfordert keinerlei Investitionen in dedizierte Hardware. Denn die virtualisierten Programme laufen in virtuellen Maschinen auf jeder verfügbaren Hardware. Zwei Rechenzentren dienen füreinander als Hot Standby. Von diesem Konzept profitierte beispielsweise die Bezirksregierung Münster, die mittels Virtualisierung 80 Server in ein neues, hochverfügbares Rechenzentrum verlegte, ohne den Betrieb zu unterbrechen.

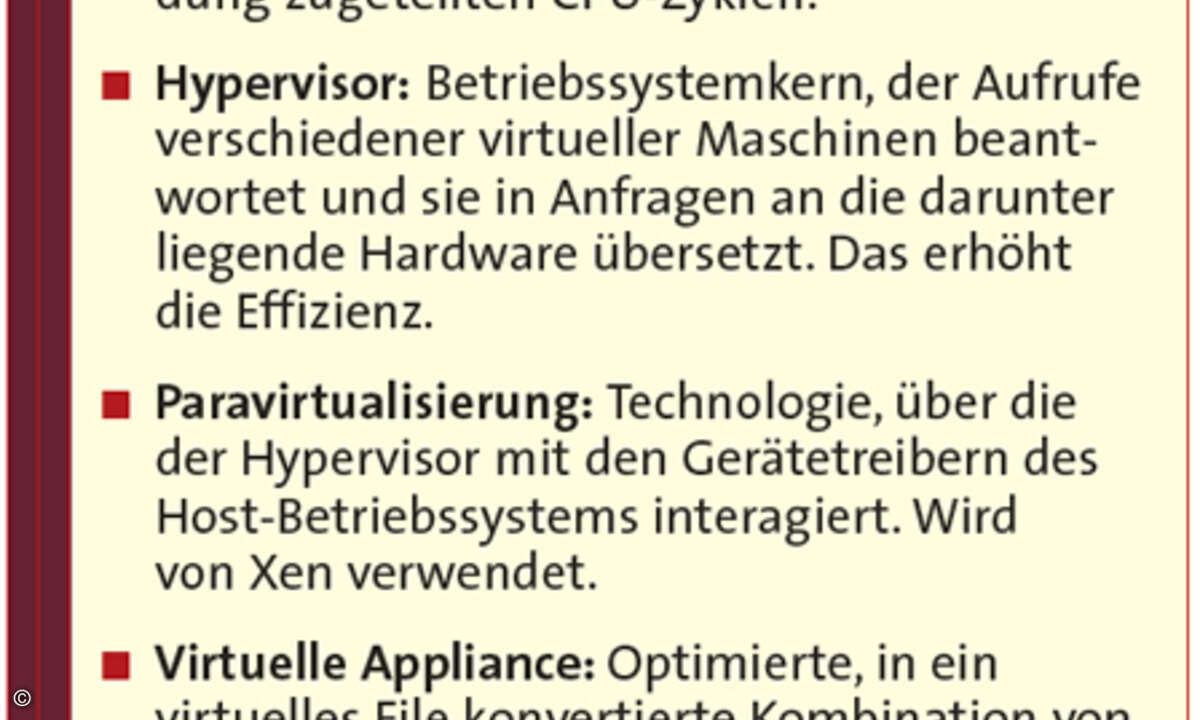

Eine Verbindung löst sich auf Zudem verändert Virtualisierung ganz grundsätzlich das Verhältnis von Soft- und Hardware. Eine Anwendung läuft normalerweise auf einem Betriebssystem, das auf eine spezielle Hardware angepasst wurde. Virtualisierung etabliert stattdessen eine direkte Verbindung des Betriebssystems mit der Anwendung. Das Betriebssystem wird dabei nicht mehr auf die Hardware, sondern auf eine bestimmte Applikation optimiert. Dann werden Betriebssystem und Anwendung zu einem virtuellen Dateiformat kombiniert, das auf einer virtuellen Maschine läuft. Das Ergebnis heißt »virtuelle Appliance«. Solche Appliances können aus dem Web herunter geladen und von einem Gerät auf ein anderes verschoben werden. Vmware betreibt einen Appliance-Markt mit Hunderten vorkonfigurierter Anwendungen im Internet (http://www.vmware.com/vmtn/ appliances/directory/partners/). Lädt man Virtual Appliances herunter, sind sie sofort ohne Setup lauffähig. Sie könnten, so Rich Lechner, IBMs Vice President Virtualisierung, den Wartungsanteil der IT-Budgets, der heute bis zu 70 Prozent beträgt, signifikant reduzieren. Die Flexibilität der Virtual-Appliance-Technologie ist einer der Schlüssel zum Abschied von der starren Silo-Architektur im Rechenzentrum auf dem Weg zur anpassungsfähigen IT-Infrastruktur. Allerdings birgt sie auch neue Herausforderungen. So sehen die meisten Systemmanagement-Tools entweder physikalische oder virtuelle Server, nicht beides. Derzeit können nur CAs Unicenter ASM 11.1 und Werkzeuge einiger Startups beide Servertypen darstellen und zwischen ihnen Mappings durchführen. Hier gibt es also Nachholbedarf bei den Anbietern von Management-Tools, denn Administratoren wünschen sich Virtualisierungsmanagement eng integriert mit den schon existierenden Systemmanagement-Konsolen. Weiter können Supportprobleme auftauchen, wenn eine der virtuellen Appliances, im Grunde ein ineinander verschachteltes Paket mehrerer Software-Komponenten, auf einer virtuellen Maschine läuft. Support-Spezialisten können nämlich nicht erkennen, ob das Problem bei der Anwendung selbst oder bei der Virtualisierungssoftware liegt. Sie könnten also darauf bestehen, dass das Problem auf einem realen Server dupliziert wird, bevor sie bereit sind, zu helfen.

Patch-Probleme möglich Außerdem gibt es nur wenige Software-Werkzeuge, die dafür sorgen, dass bei der Aktualisierung eines Server-Betriebssystems auch das Betriebssystem jeder virtuellen Maschine korrekt gepatcht wird. »Was ist, wenn eine der virtuellen Maschinen keinen Sicherheits-Patch bekommt?«, fragt Gordon Haff, Analyst beim Marktforschungsunternehmen Illuminata. Und wer garantiert die Sicherheit der virtuellen Maschinen, besonders in Hosting-Umgebungen, wo die Anwendungen eines Unternehmens nur Nanosekunden von denen eines Wettbewerbers getrennt liegen? Andererseits könnten virtualisierte Umgebungen bezüglich der Sicherheit sogar Vorteile bieten: Bei einer virtuellen Appliance wurden alle unnötigen Teile des Betriebssystems entweder entfernt oder abgeschaltet, so dass mögliche Einfallstore für Schädlinge und Hacker fehlen. Auch serviceorientierte Architekturen profitieren von Virtualisierung, denn sie lassen sich damit etwas weniger aufwendig realisieren. Services sind kleine Anwendungen, die schnell verfügbar sein müssen. Dafür kann man sie so formatieren, dass sie auf virtuellen Maschinen laufen. Virtualisierung vereinfacht es, diese Anwendungen als Reihe von kleinen Diensten zu verwalten, von denen jeder in seiner isolierten Umgebung läuft, erklärt IBM-Manager Lechner. Aber dafür müssten bis zu 90 Prozent der Anwendungen in auf virtuellen Maschinen lauffähige Dateien konvertiert werden – eine Herkulesaufgabe.

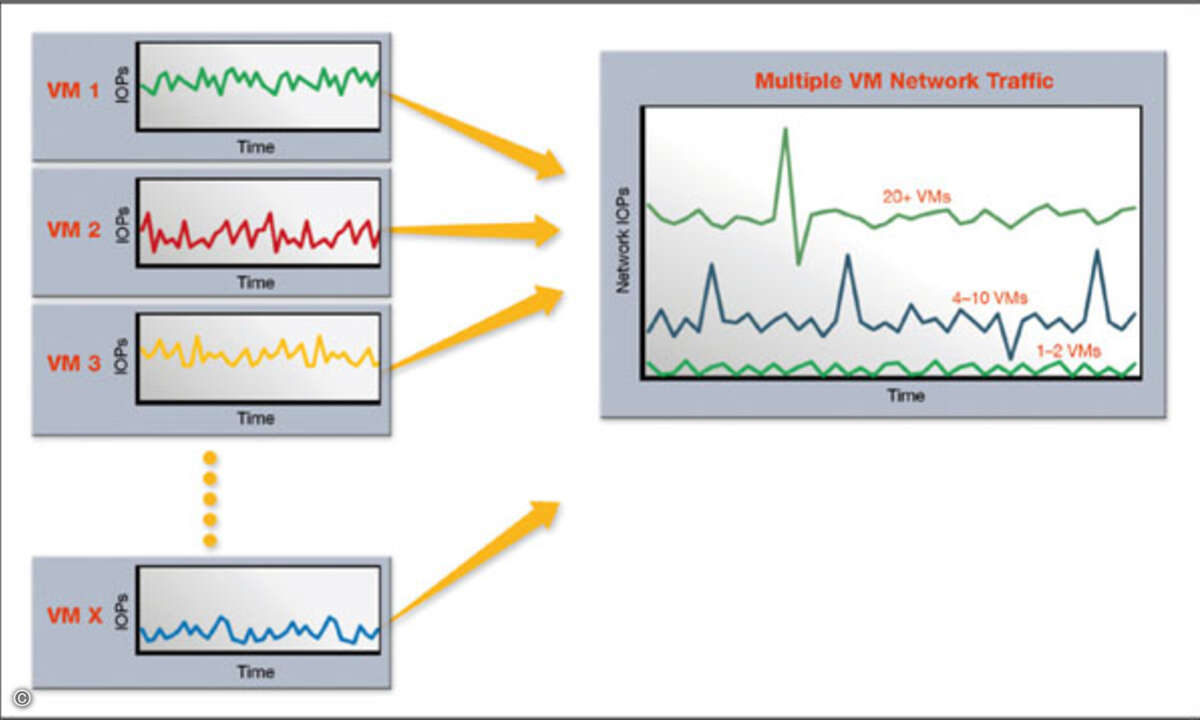

Verschiedene Virtualisierungstypen IBM, HP und Sun Microsystems nutzen schon lange proprietäre Virtualisierungstechnologien. IBM verwendete sie zum Beispiel in seinem Mainframe-Betriebssystem VM. HP kann virtuelle Maschinen mit seinem Virtual Server Environment herstellen. Außerdem vermarktet HP zusammen mit Vmware die Virtual Desktop Infrastructure, die Anwender mit virtuellen Anwendungen abseits vom Zentral-Server versorgt. Einfache Virtualisierungsprodukte wie GSX von Vmware und Microsofts Virtual Server duplizieren Betriebssystem und Anwendungen auf jede virtuelle Maschine. Das virtuelle Betriebssystem gibt hierbei die Befehle an die Hardware weiter. Die Replikation des Betriebssystems macht Virtualisierung zum Speicherfresser. Dazu kommen im Fall von Windows erhebliche Lizenzkosten. Vmwares ESX-Server und das Open-Source-Produkt Xen arbeiten dagegen als Hypervisors. Hier handhabt eine einzige Instanz der Virtualisierungssoftware die Hardware-Aufrufe aller Ressourcen auf virtuellen Maschinen auf einem Server. Ein Hypervisor kann viele virtuelle Maschinen unterstützten und Software-Befehle direkt an die Hardware übergeben. Suns Virtualisierungsmethode generiert sogenannte Container: Diverse Anwendungen laufen unter einer Instanz von Solaris 10. Overhead entstehe dabei kaum, sagt Sun-Produktmanager Joost Pronk van Hoogeveen. Virtuozzo, ein Produkt des Startups Swsoft, das in Deutschland zum Beispiel der Server-Hersteller Thomas Krenn verwendet, tut dasselbe für Windows und Linux. Mit Virtuozzo können diverse Anwendungen unter einer einzigen Kopie des Betriebssystems laufen. Besonders sinnvoll ist die Lösung in Hosting-Umgebungen, da dann ein physikalischer Server Software mehrerer Kunden verarbeitet. Marktführend bei der Virtualisierung von x86-Systemen ist derzeit die 1998 gegründete, nunmehr zu EMC gehörende Firma Vmware. Mit virtuellen Maschinen auf Multicore-Servern können Anwender endlich voll von der Leistungsfähigkeit dieser Maschinen profitieren, ohne Anwendungen parallelisieren zu müssen. Zu einer Alternative könnte sich das Open-Source-Projekt Xensource entwickeln. Sein Produkt Xen basiert auf einem Paravirtualisierungs-Konzept: Das Betriebssystem unter Xen »weiß«, dass es virtualisiert wurde und belastet deshalb den Hypervisor weniger durch die Kommunikation mit der Server-Hardware. Xen benötigt nicht für jede unterstützte Hardware-Plattform Device-Treiber wie unter ESX, sondern kann Treiber von Red Hat, Suse Linux oder Microsoft nutzen. Der verringerte Aufwand macht sich bemerkbar: Die Lösung bietet 80 Prozent der Funktionen von Vmware für nur 20 Prozent des Preises.

Microsoft hinkt hinterher Auch Microsoft will in Zukunft eine wichtige Rolle im Virtualisierungsmarkt spielen. Das könnte jedoch schwierig werden: Virtual Server läuft immer noch als Engine unter Windows, Windows ist nicht, wie Linux, modular aufgebaut. Dadurch lassen sich neue Komponenten schwer hinzufügen oder entfernen. Nur ein modularer Aufbau aber sichert, dass das Betriebssystem leicht an die jeweilige Anwendung angepasst werden kann. Bisher ist daher der Markt für Virtual Appliances fast ausschließlich in Linux-Händen. Xensource und Novell helfen Microsoft nun dabei, Linux-Virtualisierung in Longhorn, die Server-Entsprechung zu Vista, zu integrieren. Irgendwann diesen Sommer wird der noch nicht fertig gestellte Hypervisor mit dem Codenamen Viridian in Longhorn integriert – mit Linux als virtueller Maschine.

Charles Babcock ist Redakteur der amerikanischen Ausgabe der InformationWeek