Cloudian: Vom Objektspeicher zum aktiven KI-Datenkern

Cloudian entwickelt sich vom Objektspeicheranbieter zur integrierten KI-Datenplattform. Gemeinsam mit Nvidia entsteht eine Lösung, die Leistung, Datensouveränität und einfache Implementierung vereint – und dem Channel völlig neue Möglichkeiten eröffnet.

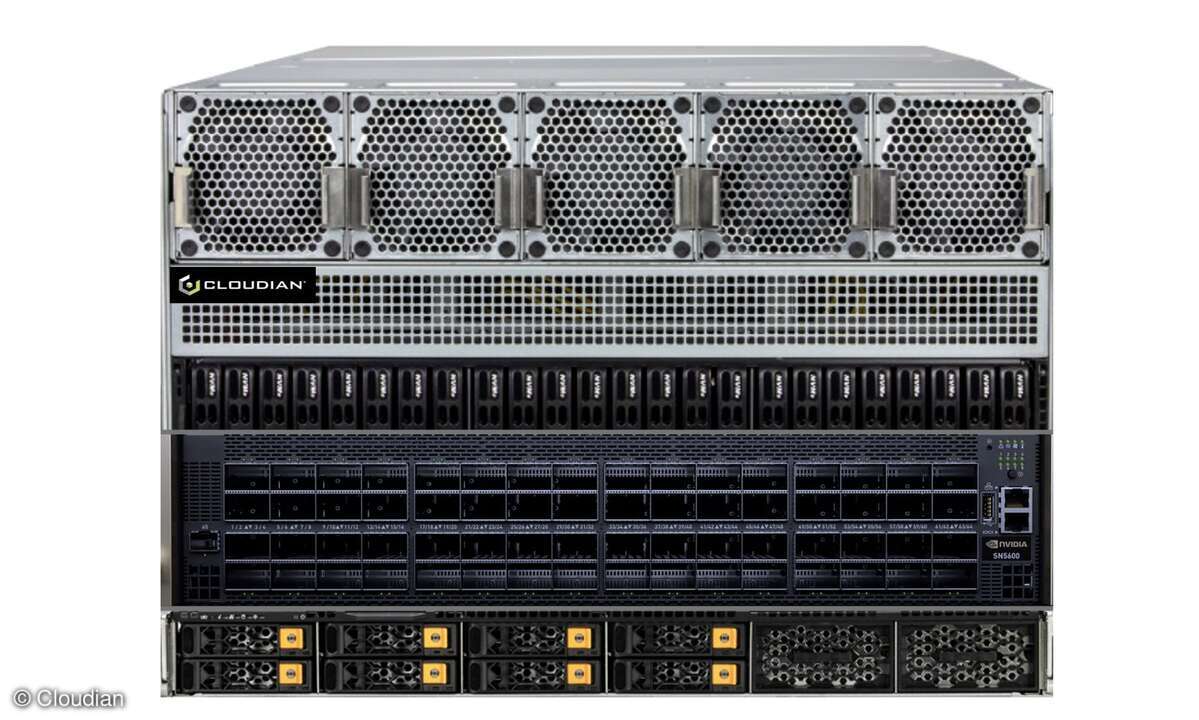

Cloudian ist seit seiner Gründung 2011 konsequent auf das S3-Protokoll fokussiert. Was als softwaredefinierter Objektspeicher begann, entwickelt sich nun zur vollständigen AI Data Platform: Die neue HyperScale AI Data Platform verbindet S3-Storage, GPU-Compute und Software Stack mit integrierter Vektordatenbank in einem Turnkey-fähigen System.

„Wir positionieren uns im Endeffekt als One-Stop-Shopping-Lösung für alles rund um KI – vom Storage bis zur Datenbankmanagementlösung“, sagt Carsten Graf, VP EMEA Sales bei Cloudian. Statt viele Einzellösungen zu kombinieren, erhalten Kunden eine komplett gemanagte Plattform, „die alles integriert hat“, inklusive Monitoring, Betrieb und Support.

Anbieter zum Thema

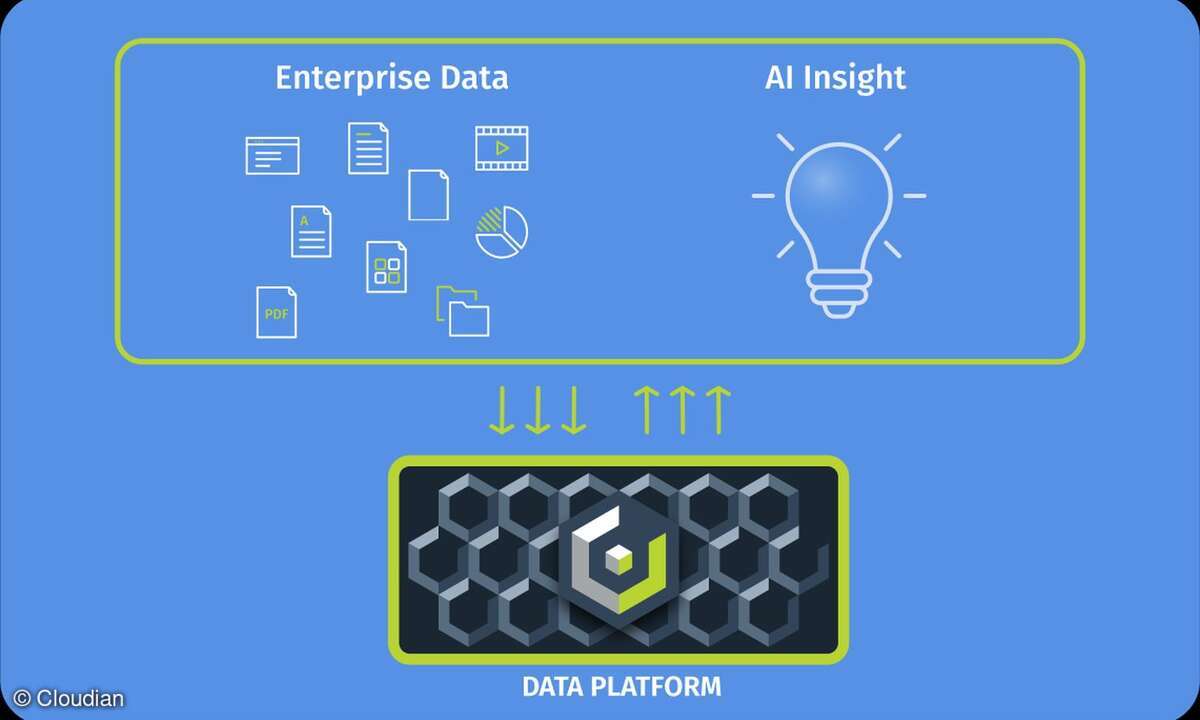

Der Unterschied zu klassischem Objektspeicher ist grundlegend: HyperScale AIDP speichert Daten nicht nur, sondern analysiert und vektorisiert sie direkt auf der Speicherebene. Unstrukturierte Inhalte – von PDFs über Präsentationen bis hin zu Multimedia – werden beim Schreiben automatisch klassifiziert, mit Metadaten angereichert und als Embeddings abgelegt. Die Lösung geht über das Thema Storage hinaus und wird zum aktiven KI-Baustein, der integraler Bestandteil von RAG-Workflows, semantischer Suche und Inferenz ist.

Sascha Uhl, Senior Solutions Architect, beschreibt den Ansatz so: „Bei vielen Kunden landen die Daten ohnehin schon im Object Storage. Wir ermöglichen es, diese Daten relativ einfach in die KI-Welt mit reinzuziehen und dort nutzbar zu machen – ohne zusätzliche Datenbank-Schicht.“ Modell-Metadaten, Tags oder Label können direkt im Storage verwaltet werden. „Der Kunde muss keine zusätzliche Datenbank aufsetzen, um seine Hunde- und Katzenbilder zu markieren. Das passiert alles direkt im Storage.“

Warum Nvidia auf Cloudian zukam

Besonders bemerkenswert ist die Entstehung der Zusammenarbeit: Nicht Cloudian suchte Nvidia – sondern Nvidia klopfte an. Auslöser waren außergewöhnlich starke Benchmark-Ergebnisse, die Cloudian auf einer AMD/Micron-Referenzplattform erreicht hatte. Die Tests zeigten, dass Objektspeicher bei KI-Workloads mit File-Lösungen wie Weka oder Vast mithalten kann. „In manchen Szenarien waren wir sogar besser aufgestellt“, berichtet Uhl. Für Nvidia war dies der Startpunkt, Object Storage als performanten KI-Datenpfad neu zu denken.

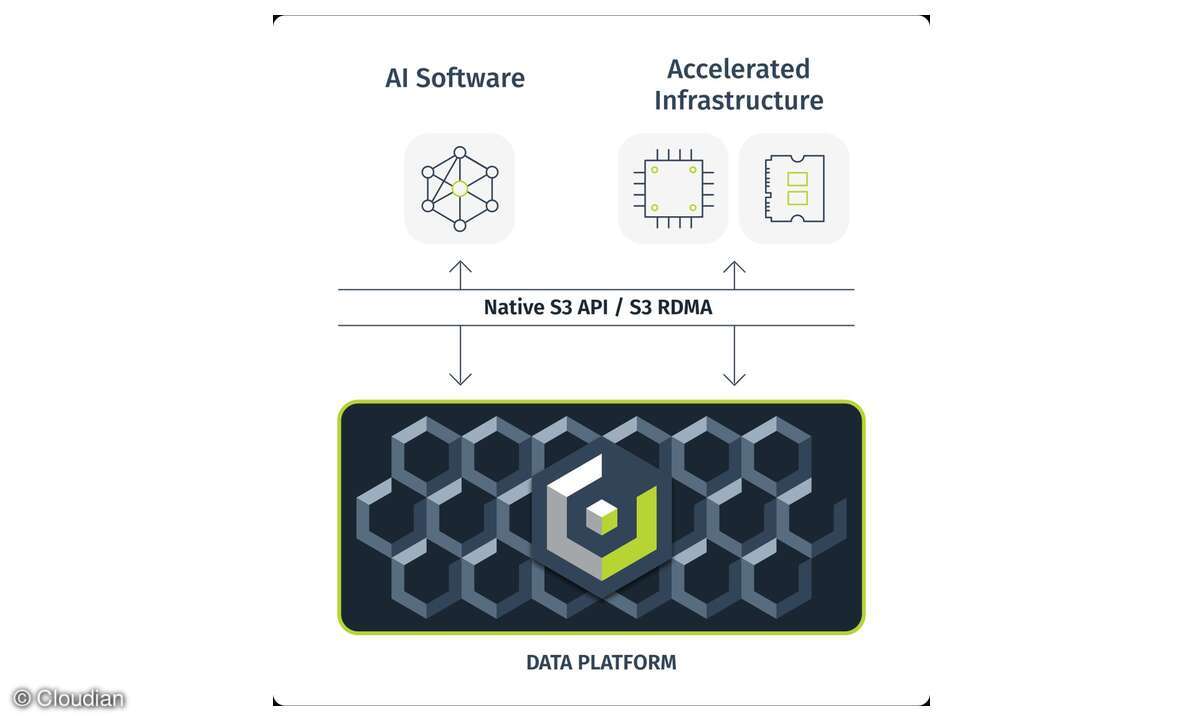

Auf dieser Basis entstand eine eng verzahnte Architektur mit GPUs der Blackwell-Generation, BlueField-DPUs und der vollständigen Nvidia-AI-Enterprise-Software. Eine zentrale Rolle spielt S3-over-RDMA, da es nahezu latenzfreie Datenpfade zwischen Storage, Systemspeicher und GPU ermöglicht. Die Plattform erreicht so bis zu 35 GB/s pro Knoten und hebt Object Storage aus der Rolle der klassischen „Ablage“ in die Liga eines KI-Hochleistungsmediums.

Ein weiterer Baustein der Zusammenarbeit sind die Nvidia-Blueprints. Cloudian hat sie direkt in seine Turnkey-Lösung integriert, sodass Unternehmen nicht erst ein geeignetes LLM auswählen oder komplexe Pipelines entwerfen müssen. Ein RAG-basierter Unternehmens-Chatbot, ein Videoanalyse-Workflow oder klinische Dokumentenprozesse lassen sich damit weitgehend ohne Vorarbeiten produktiv einsetzen. Die Lösung ist erst seit wenigen Wochen verfügbar und verdeutlicht, wie schnell sich der Markt in Richtung schlüsselfertiger KI-Plattformen bewegt.

Datensouveränität als Wachstumsmotor

Europa ist für Cloudian längst zum wichtigsten Markt geworden. Banken, Behörden, Forschungseinrichtungen und Gesundheitsorganisationen suchen zunehmend nach Wegen, ihre Daten lokal zu verarbeiten und gleichzeitig moderne KI-Funktionen sicher bereitzustellen. Graf bringt es im Gespräch offen auf den Punkt: „Die Unberechenbarkeit der amerikanischen Politik ist oft der Hauptgrund.“ Viele Unternehmen hinterfragen, ob sensible Informationen in einer US-Cloud wirklich sicher seien – oder ob morgen eine behördliche Anordnung erfolgen könne.

Das verstärkt die Renaissance der Private Cloud. Organisationen, die mit KI-Workloads zunächst in Hyperscaler-Umgebungen experimentiert haben, holen Petabytes sensibler Daten inzwischen zurück in eigene S3-Infrastrukturen. Bei der schweizerischen PostFinance etwa liegen riesige unstrukturierte Datenbestände seit Jahren im Object Storage und werden nun Schritt für Schritt für KI-Anwendungen genutzt.

Parallel wächst ein neues Segment regionaler Cloud-Provider – sogenannte „Neo-Clouds“ –, die souveräne Alternativen zu US-Hyperscalern schaffen wollen. Für sie bietet Cloudian eine skalierbare S3-Schicht, die mit Nvidia-Technologien kombiniert werden kann, ohne dass Daten den europäischen Rechtsraum verlassen.

Channel im Wandel – und Cloudians Rolle als Brücke

Cloudian setzt im Vertrieb konsequent auf Partner. „Wir sind 100 % Partner-Vertrieb“, betont Graf. In der DACH-Region arbeitet der Hersteller mit Distributoren wie ADN, Arrow und Climb – Letztere besonders stark im KI-Umfeld – sowie Systemhäusern und spezialisierten „Local Heroes“.

Der Channel steht jedoch vor einer strukturellen Veränderung. Viele klassische Infrastruktur-Partner tun sich mit KI noch schwer; ähnlich wie zu Beginn der Cloud-Ära, als neue Stakeholder mit am Tisch saßen und Kompetenzen erst zusammenwachsen mussten. Gleichzeitig treten Beratungsunternehmen aus Prozessautomatisierung und Digitalisierung als neue Player auf, die KI-Projekte treiben, aber wenig Erfahrung mit Hardware-Stacks haben.

Für beide Seiten wird Cloudian zur Brücke, weil der Hersteller nicht nur Technologie, sondern auch Professional Services bereitstellt. Installation, Betrieb und Monitoring übernimmt Cloudian, während Partner sich auf Use Cases, Datenprozesse und Transformation konzentrieren können. Das senkt Einstiegshürden und ermöglicht ein skalierbares KI-Geschäft auch ohne tiefes Infrastruktur-Know-how.

Hinzu kommt die Hardware-Agnostik der HyperScale AI Data Platform: Sie kann als Appliance geliefert werden, lässt sich aber ebenso auf bestehende Serverlandschaften – etwa von Cisco, Dell, HPE oder Lenovo – implementieren. Viele Kunden schätzen die Möglichkeit, vorhandene Investitionen einzubinden, statt neue Inselarchitekturen aufzubauen.

Im Ergebnis entsteht ein Marktbild, in dem Object Storage nicht länger nur Grundlage für Backups oder Archivierung ist, sondern zum strategischen Kern der KI-Infrastruktur. Die nächsten Jahre, so deuten Graf und Uhl an, werden von RAG-Szenarien, hybriden Architekturen und dem Trend geprägt sein, Rechenleistung konsequent zu den Daten zu bringen. Cloudian sieht sich dafür gut aufgestellt: mit einer souveränen, skalierbaren und sofort einsatzfähigen Lösung, die europäische Anforderungen tief in ihrer Architektur verankert.