Nvidia-Chef sieht „iPhone-Moment“ für KI

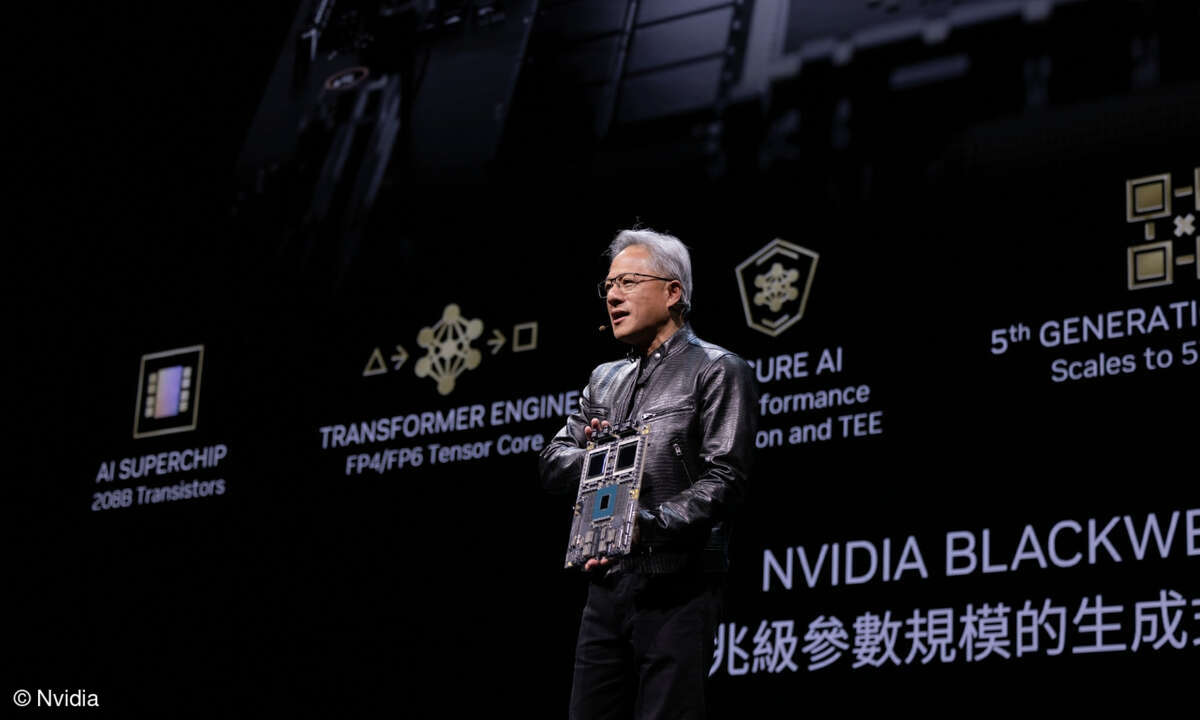

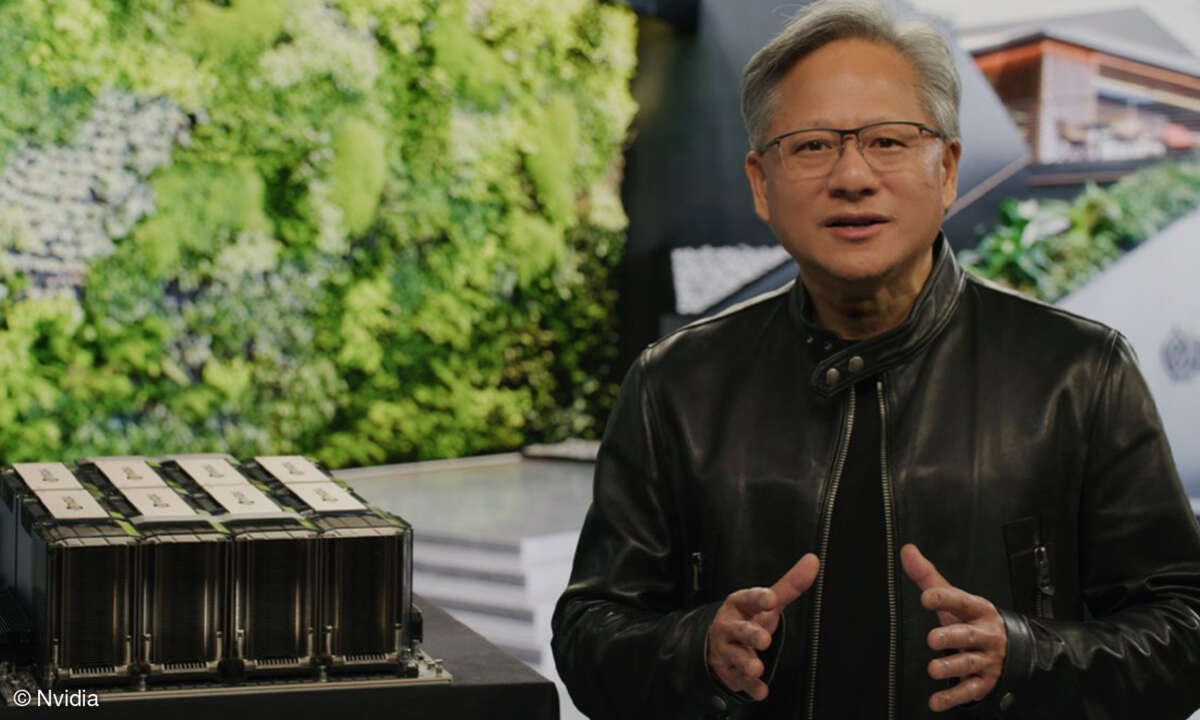

Zur Eröffnung von Nvidias Entwicklerkonferenz GTC kündigte CEO Jensen Huang eine Reihe von Innovationen und neue Partnerschaften rund um das Hype-Thema Künstliche Intelligenz an, darunter KI-Supercomputing-Services aus der Cloud im Mietmodell.

Nvidia-CEO Jensen Huang hat auf der Nvidia GTC eine Reihe von Neuerung rund um KI vorgestellt. In seiner virtuellen Keynote zur Eröffnung der Entwicklerkonferenz kündigte Huang mehrere neue Chips, KI-Supercomputing-Services und Partnerschaften an.

KI werde nahezu jede Branche neu erfinden, prognostizierte der Nvidia-Chef, die Technologie erlebe gerade einen „iPhone-Moment“. ChatGPT sei nur der Anfang, so Huang. Die Energiequelle für mit Warp-Geschwindigkeit beschleunigtes Computing sei KI. Die beeindruckenden Fähigkeiten der generativen KI haben Unternehmen deutlich gemacht, dass sie ihre Produkte und Geschäftsmodelle neu denken müssten.

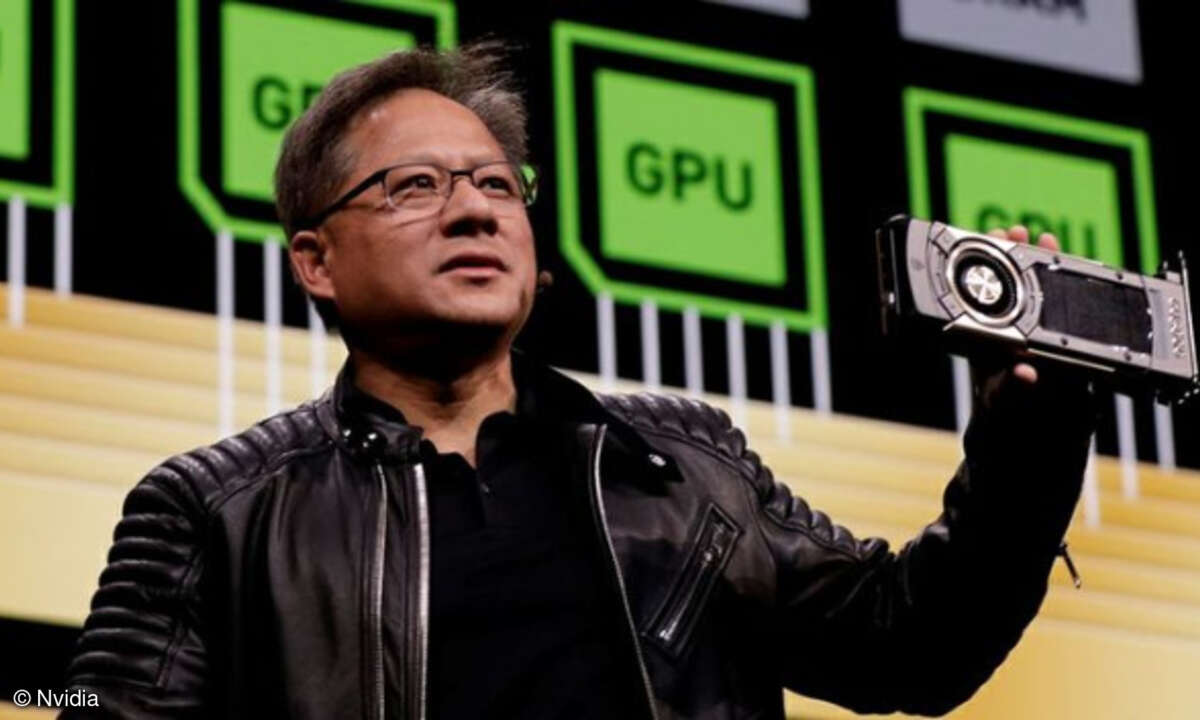

Huang stellte im Laufe seiner Keynote nicht nur eine neue GPU – die „H100 NVL“ – mit Dual-GPU -NVLink vor, die auf Nvidias Hopper-Architektur basiert. Sie verfügt über eine Transformer Engine, die für die Verarbeitung von Modellen wie dem GPT-Modell, das ChatGPT antreibt, entwickelt wurde.

Auch die neueste Version von Nvidias DGX verfügt über acht H100-GPUs, die miteinander verbunden sind und wie eine einzige große GPU arbeiten. Nvidias DGX H100 sei die Blaupause für Kunden, die weltweit KI-Infrastrukturen aufbauen, so Huang.

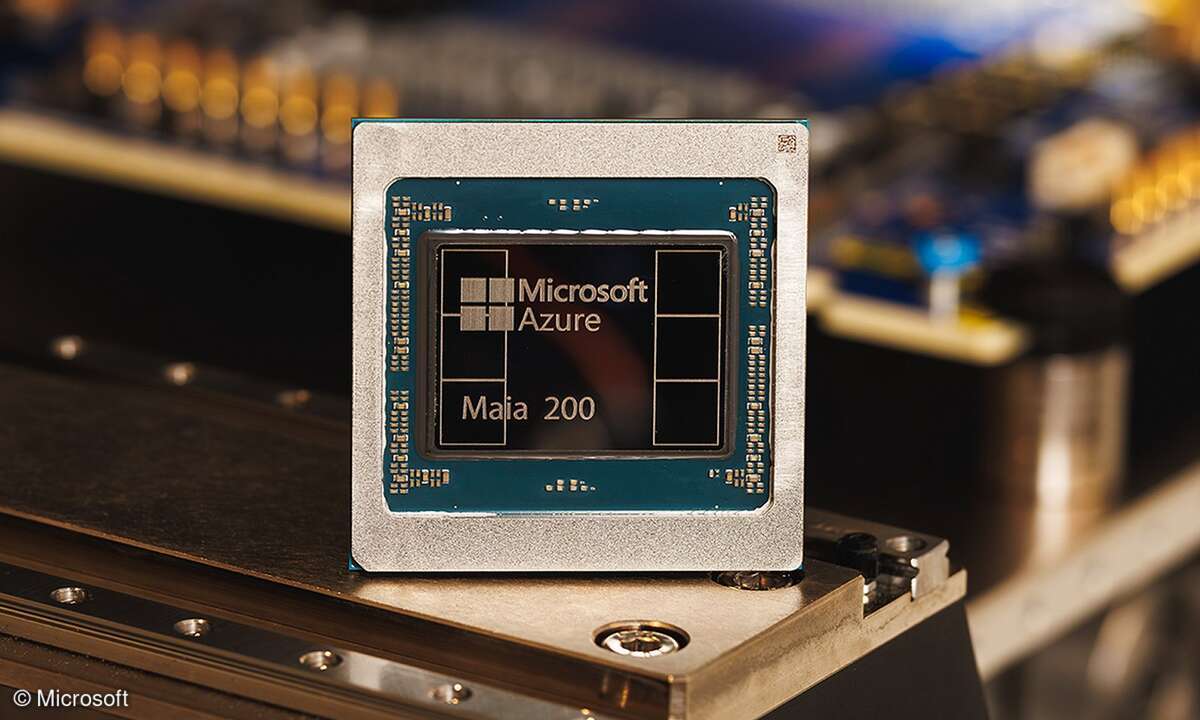

Huang kündigte außerdem eine Reihe von Partnerschaften an. So werden Oracle, Microsoft oder AWS in ihren Datacentern künftig H100-GPUs einsetzen.

Außerdem werden Oracle, Microsoft und Google Nvidias neuen Supercomputing-Service namens „Nvidia DGX Cloud“ hosten, der jedem Unternehmen künftig KI-Supercomputer-Kapazitäten über den Browser ermöglichen soll. Sie können DGX-Cloud-Cluster auf monatlicher Basis mieten und so die Entwicklung großer Trainings-Workloads mit mehreren Knoten schnell und einfach skalieren, ohne auf beschleunigte Rechenressourcen warten zu müssen, verspricht Nvidia.

Als erster bietet Oracle Cloud Infrastructure (OCI) mit seinem OCI-RDMA-Supercluster ein speziell entwickeltes RDMA-Netzwerk, Bare-Metal-Computing und leistungsfähigen Block- und lokalen Speicher, der auf Supercluster von über 32.000 GPUs skaliert werden kann. Microsoft Azure wird voraussichtlich im nächsten Quartal mit dem Hosten von DGX Cloud beginnen, und der Dienst wird bald auf Google Cloud und weitere Anbietern ausgeweitet.

Anbieter zum Thema

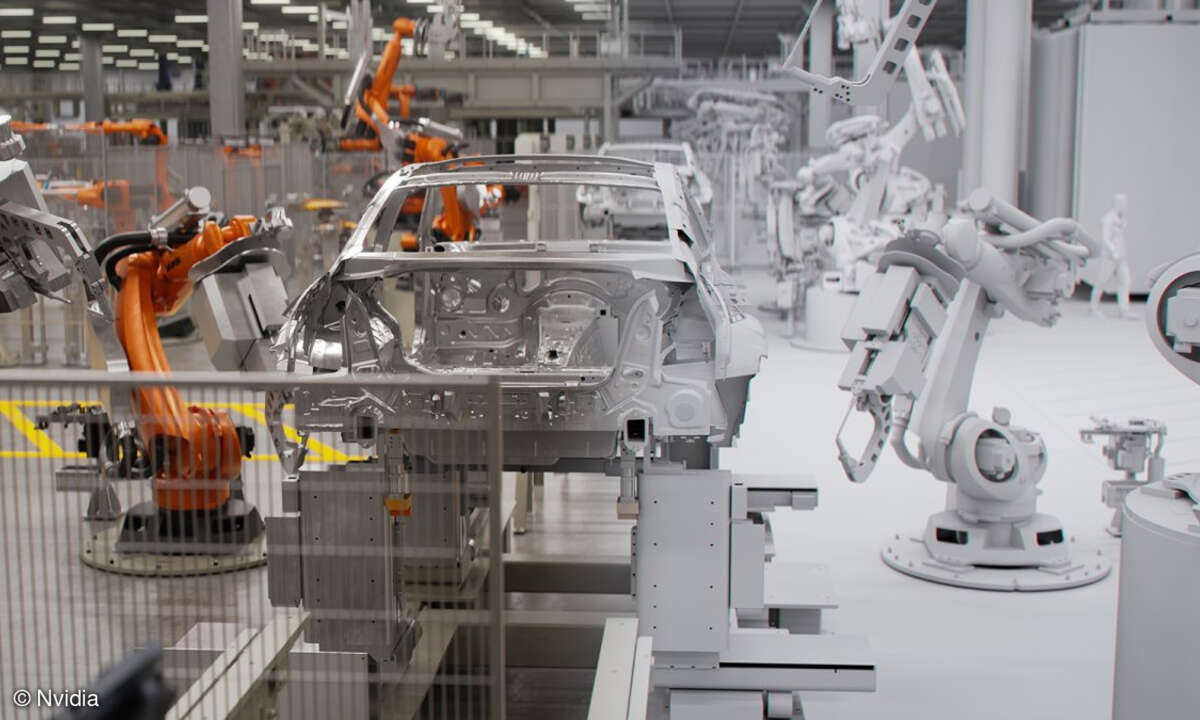

Nvidia kündigte auch eine Partnerschaft mit BMW an, die eine Nutzung von Nvidias Omniverse-Plattform durch BMW vorsieht. Künftig soll BMW im Omniverse Produktionsstätten komplett virtuell planen und auf Basis von KI optimieren können. Das soll unter anderem schnellere Produktionsanläufe und bessere Prozesse ermöglichen.

Auf der GTC demonstrierten BMW und Nvidia die Möglichkeiten des Tools anhand des geplanten EV-Werks im ungarischen Debrecen, das BMW 2025 in Betrieb nehmen will.