Mit Highend-Systemen wettbewerbsfähiger werden

Höhere Leistung bei geringeren Kosten lautet das Ziel vieler Konsolidierungsprojekte in der Unternehmens-IT. Nur eingehende Analysen und eine intelligente, planmäßige Umsetzung in Hard- und Software verspricht wirklich Erfolg.

Konsolidierung bedeutet die Zentralisierung vieler, voneinander unabhängiger Anwendungen auf wenigeren, aber größeren Systemen.

Für Unternehmensberater und Analysten wie Gartner ist die Serverkonsolidierung immer noch einer der wichtigsten Trends in der Informationsverarbeitung. Nach dem Hype in Sachen E-Business und der darauf folgenden rezessiven Wirtschaftslage rückte die Informationstechnologie oft als der treibende Kostenfaktor ins Visier der Unternehmen. Daran hat sich bis heute wenig geändert. Insofern bezwecken die meisten Konsolidierungsprojekte, den finanziellen Aufwand für die Information und Kommunikation zu senken. Neben dem rein ökonomischen Aspekt gibt es für die Unternehmen weitere gute Gründe, die Komplexität ihrer IT-Infrastruktur zu reduzieren: Zum Beispiel die Vereinheitlichung der Kundenprozesse auf Grund des Übergangs zum E-Business sowie die Verbesserung der Reaktionsfähigkeit der Systeme, die heute oft 7 mal 24 Stunden in der Woche zur Verfügung stehen müssen. Welche Motive auch Priorität haben, eine genaue Wirtschaftlichkeitsbetrachtung im Vorfeld der Konsolidierung sowie die Wahl der geeigneten Konsolidierungsplattform für Hard- und Software sind entscheidende Faktoren für den langfristigen Erfolg des Projektes.

Bewertung der Konsolidie-rungsoptionen

Die Senkung der Betriebskosten und eine höhere Leistungsfähigkeit und Verfügbarkeit der eingesetzten Systeme stehen als Ziele, die mit einer Serverkonsolidierung verfolgt werden, nicht im Widerspruch. Idealerweise sollten immer beide Ergebnisse im Rahmen eines solchen Projektes erreicht werden. Aus diesem Grund ist – bevor aktiv Maßnahmen in die Wege geleitet werden – zunächst eine umfassende betriebswirtschaftliche Betrachtung notwendig, die das genaue Potential der Einsparungen ermittelt und in die Konzeption eines konsolidierten Systems eingeht. Zu der Kostenbilanz eines Konsolidierungsprojekts gehören beispielsweise die Beschaffungskosten sowie die Betriebskosten für die Hardware und Software – vom eigenen Personal über Strom bis zu den Gebäudekosten. Weiter müssen eventuelle Ausgaben für extern bezogene Supportleistungen sowie einmalige Aufwendungen für die Umstellung der Systeme, für die Migration der Anwendungen, die Schulung der Mitarbeiter und für den Parallelbetrieb in der Übergangsphase berücksichtigt werden.

Dieser Kostenbilanz sollte eine möglichst genaue und differenzierte Analyse der aktuellen Ausgabensituation gegenüber stehen. Solche Total-Cost-of-Ownership-Kalkulationen klären allerdings nicht, inwieweit alternative Infrastrukuren besser und kostengünstiger die aktuellen geschäftlichen Herausforderungen bewältigen helfen. TCO ist eine Status-Quo-Kostenbetrachtung, die eine Entscheidung für oder gegen Konsolidierung transparent machen und daher als Werkzeug zur Kostenkontrolle und Optimierung von IT-Infrastrukturen verstanden werden kann. Die wichtigsten, allerdings auch nicht ganz unumstrittenen Ergebnisse von TCO-Betrachtungen sind:

- 60 bis 80 Prozent der IuK-Kosten werden nicht durch die Beschaffung von IuK-Mitteln, sondern durch deren Betrieb verursacht. Administration, Management, Softwareentwicklung und Wartung sind die größten Kostenfaktoren.

- Indirekte Kosten, zum Beispiel Geschäftsstörungen durch IuK-Downtimes, sind sehr schwer zu bewerten. Sie sind jedoch auf Mainframe-Plattformen niedriger als auf Unix-Plattformen und dort wieder niedriger als auf Wintel-Plattformen.

- Vielfalt und Komplexität sind Kostentreiber. Je besser eine Plattform konsolidieren kann, um so besser sind die TCO pro Client.

- Die TCO der Wintel-Plattform ist wesentlich höher als die der Unix-Plattform; die TCO der Unix-Plattform ist um rund 30 Prozent höher als die der Mainframe-Plattform. Die Betriebskosten der BS2000/OSD-Plattform sind unter den Mainframe-Varianten am ge-ringsten.

Transparente und für ein Unternehmen relevante TCO-Kostenbetrachtungen entstehen nur durch eine unternehmensindividuelle Kostenerhebung. Sie ist selbst dann wertvoll, wenn keine sofortigen Konsoliderungskonsequenzen gezogen werden: TCO-Berechnungen legen die Kostenzusammenhänge offen, identifizieren die wichtigsten Kostenverursacher und geben dadurch richtungsweisende Impulse für eine zukünftige Beschaffungs-Strategie.

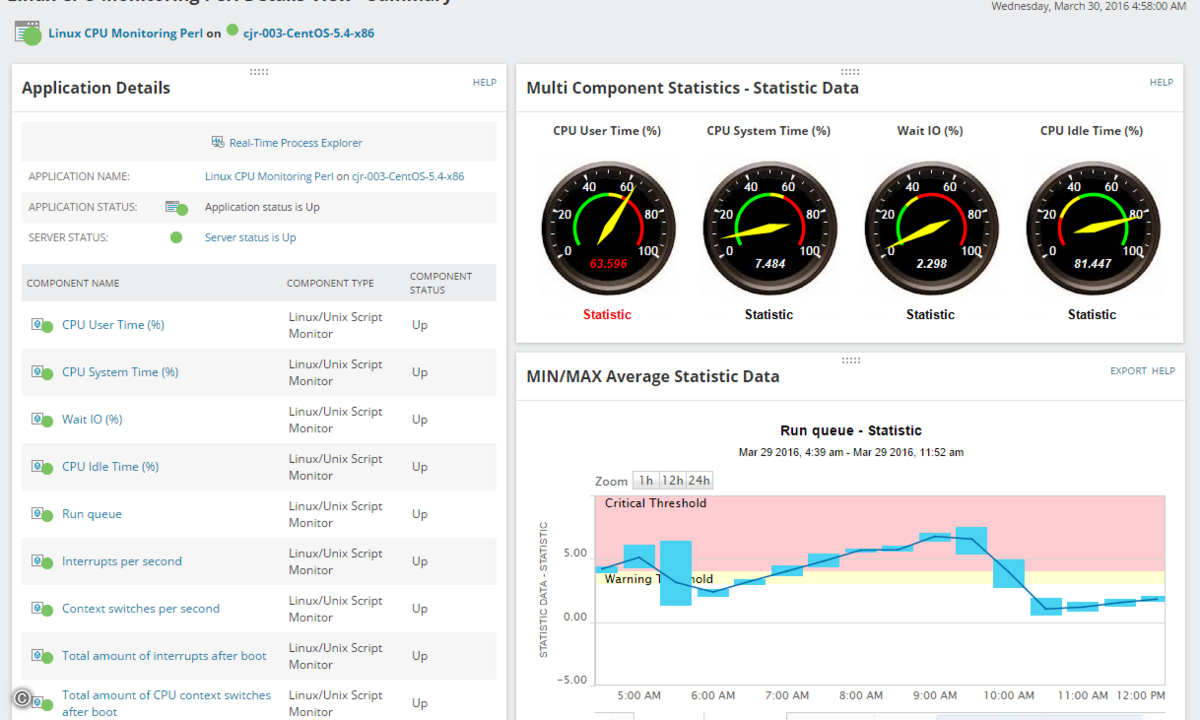

Konsolidierung setzt an vielen Aspekten – wie Speicher, Netzwerk, Anwendungen oder Middleware – in der Unternehmens-IT an. Die Server-Konsolidierung tangiert die meisten dieser Bereiche und ist somit ein entscheidender Baustein. Ihr Ziel ist es, die auf vielen Rechnern verteilten Daten, auf wenigen, aber leistungsfähigeren Rechnern zusammenzuführen. Daten können in diesem Zusammenhang auch Applikationen sein. Konsolidierung bedeutet in diesem Kontext die Zentralisierung vieler, meist voneinander unabhängiger Anwendungen im Unternehmen auf wenigeren, aber größeren Systemen und Servern (Application-Stacking). Die Konsolidierung der Server führt zu einem zentralisierten Datenbestand, einer verringerten Anzahl von Betriebssystemen sowie zu einer Vereinheitlichung der verschiedenen Betriebssystemversionen. Vorhandene Ressourcen in Bezug auf Speicherkapazität und Prozessorleistungen können besser genutzt, das Management und die Überwachung der Systeme werden einfacher und effizienter. Die Mitarbeiter erhalten einen besseren Zugriff auf den Datenbestand und auf vorhandene Kapazitäten.

Vorgehensweisen

Grundlage für die Entscheidung zu einer neuen Konzeption ist zunächst eine umfassende Bestandsanalyse der aktuellen Server, welche die Erfassung aller vorhandenen Kapazitäten, die Ermittlung der Workloads an den einzelnen Servern sowie die Anforderungen an Speicherkapazitäten und Bandbreiten im Netzwerk umfasst. Aus den ermittelten Daten dieses Ist-Zustandes wird die erforderliche Systemleistung mit entsprechenden Leistungsreserven für die Zukunft abgeleitet. Voraussetzung für eine sinnvolle Bestimmung der notwendigen Leistung ist, dass ein Unternehmen für sich klar definiert hat, wie sein IT-Support in Zukunft aussehen soll. Ebenso wichtig für eine Entscheidung ist die Überlegung, welche Änderungen in den bestehenden Geschäftsabläufen sich in den nächsten Jahren abzeichnen werden. Denn eine zu kurzsichtige Konsolidierung kann schnell die Notwendigkeit weiterer Investitionen nach sich ziehen und so das Gegenteil von dem erreichen, wozu sie geplant war – nämlich hohe Kosten verursachen, anstatt sie zu reduzieren.

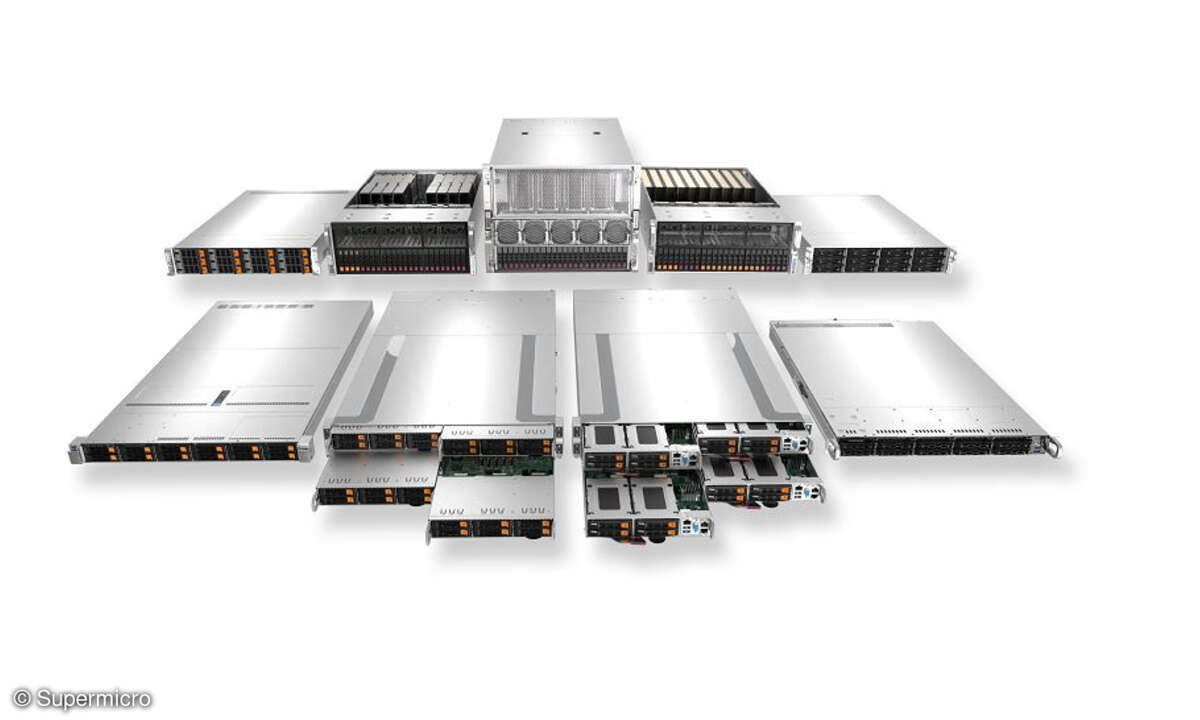

Die Wahl der Plattform

Damit sich die mit der Serverkonsolidierung beschriebenen und beabsichtigten Resultate auch einstellen, ist es notwendig, auf die Wahl einer geeigneten Plattform, also Hard- und Software, besonderen Wert zu legen. Diese sollte sich aus den oben genannte Gründen vor allem dadurch auszeichnen, dass die Server hinsichtlich Performance, Hauptspeicherausbau und Input/Output-Bandbreite in hohem Maße skalierbar sind. Das selbe gilt für die Datenhaltungssysteme und die Netzbandbreiten. Ebenso ist eine hohe Verfügbarkeit der Server, die durch Capacity-on-Demand (CoD) und Online-Replacement (OLR) unterstützt wird, unentbehrlich. Außerdem müssen die Server in der Lage sein, mehrere Systeme der gleichen Plattform zur selben Zeit zum Ablauf zu bringen. Die Realisierung dieser Optionen gelingt am besten mit Servern, die hinsichtlich der Ressourcen Verarbeitungsprozessoren, Hauptspeicher und Input/Output-Bandbreite partitionierbar sind. Die Partitionierung unterteilt Server in mehrere Einheiten, die unabhängig voneinander arbeiten. Sie ermöglicht die Konsolidierung von Anwendungen, ohne die Systemsegmentierung verändern zu müssen; das heißt die Konsolidierung ist hinsichtlich der Aufteilung von Anwendungen auf Systeme transparent. Mittels Partitionierung können mehrere Server, die bisher nur mäßig genutzt, aber mit hohem Aufwand verwaltet wurden, auf einem Server konsolidiert werden. Wenn neue Software entwickelt oder getestet werden soll, kann dies auf einer Partition des Produktivsystems geschehen, ohne dass der Produktivbetrieb in den anderen Partitionen beeinträchtigt wird. Auch die Ressourcenzuteilung lässt sich – je nach Paritionierungskonzept – modifizieren, ohne dass das System neu gebootet werden muss. Bei Mainframe-Installationen zählt die Nutzung der Partitionierung inzwischen zu den Standard-Features, während sie bei Unix- und insbesondere bei Intel-basierenden Systemen noch eher die Ausnahme ist.

Partitionierungskonzepte

Je nach Konzept spricht man von physischer Partionierung, logischer Partitionierung, virtueller Maschine und virtueller Maschine in physischer Partition. Im Falle der physischen Partitionierung teilt ein Systemadministrator Prozessoren, Hauptspeicher, Systemsteuerungen, Input/Output-Anschlüsse sowie Netz- und Peripherieanschlüsse statisch den jeweiligen Systemen zu. Diese Hardware-Partionierung ist besonders stabil, da zwischen den einzelnen Partitionen eine physische Barriere besteht. Der Systemadministrator kann hier vollkommen unabhängige und verschiedene Systemumgebungen definieren und damit komplett unterschiedliche Systeme generieren. Diese sind hardwaremäßig völlig voneinander getrennt und werden jeweils von einer eigenen Betriebssysteminstanz unterstützt. Die Mainframes der SX-Serie von Fujitsu Siemens Computers bieten sogar plattformübergreifende physische Partitionierung; es können gleichzeitig BS2000- und Solaris-Partitionen auf einem Server definiert werden.

Bei der logischen Partitionierung steuert der Administrator innerhalb vorgegebener Architekturgrenzen flexibel die Zuordnung der der Ressourcen wie CPU-Leistung und Hauptspeicher an die jeweiligen Systeme. Die »virtuelle Maschine« realisiert die gegenseitige Isolation der Systeme; das bedeutet, dass Fehler bis hin zu einem Systemausfall die Funktionsfähigkeit der anderen Systeme nicht beeinträchtigen. Die Hypervisor-Software steuert abhängig vom Gesamt-Workload auf dem Server die Zuteilung der Verarbeitungsprozessoren, des Hauptspeichers und der Input/Output-Anschlüsse an die jeweiligen Systeme. Der Vorteil liegt in der im Vergleich zur reinen Hardware-Partitionierung höheren Granularität. Je feiner sich die Serverressourcen auf die einzelnen Einheiten verteilen lassen, desto eher lässt sich sicherstellen, dass wertvolle Ressourcen im Unternehmen hochgradig genutzt werden und somit die in die Konsolidierung gesetzten Ansprüche auch realisiert werden. Die »virtuelle Maschine in physischer Partition« ist ein relativ neues Konzept, das beispielsweise Fujitsu Siemens Computers erstmals in der SX-Serie realisiert hat. Hier wird die physische Partitionierung mit der virtuellen Maschine VM2000 kombiniert: VM2000 läuft innerhalb einer statisch zugewiesenen physischen Partition und verteilt die Partition-Ressourcen dynamisch auf die Systeme.

Konsolidierungsplattform mit Zukunftsgarantie

Aufgrund des guten Workload-Managements mit fast 100 Prozent Systemauslastbarkeit gibt es auf Mainframes hinsichtlich Workload-Verdichtung auf wenigere Systeme und Server heute keinerlei Grenzen. Schon aus diesem Grund sollte man die Highend-Systeme bei der Suche nach einer geeigneten Konsolidierungsplattform immer im Auge haben. Die heutigen Mainframes bieten zudem nicht nur in Sachen Verfügbarkeit und Sicherheit die erforderlichen Eigenschaften für die Flexibilität, die notwendig ist, damit das Konsolidierungskonzept auch langfristig Bestand hat. Fibre-Channel-Anschlüsse erlauben die Integration der Datenhaltung auf dem Mainframe in plattformübergreifende SANs. Offene Software-Suiten wie »openSEAS« von Fujitsu Siemens verbinden geschäftskritische IT-Lösungen mit neuen Anwendungen und erlauben so die Nutzung von Legacy-Anwendungen in neuen E-Business-Umgebungen. Zahlreiche Untersuchungen zeigen, dass der moderne Mainframe die bei weitem niedrigste TCO aller Serverplattformen vorweisen kann. Nach einer Untersuchung von Xephon im vergangenen Jahr betragen die Kosten einer Mainframe-Plattform weniger als 35 Prozent vergleichbarer alternativer Plattformen. Die TCO von Mainframe zu Unix verhalten sich wie 1 zu 2,8 und von Mainframe zu PC-Server wie 1 zu 3,75. Walter Franck, Produktmanager BS2000, Fujitsu Siemens Computers