WANtastische Magie

Bandbreitenmanagement – Die Appliances von vier Herstellern versprechen, die Ressourcen der WAN-Leitung intelligent zu organisieren. So clever, dass eine T1-Leitung sich verhält wie eine 10-MBit/s-Strecke. Die Real-World Labs haben untersucht, ob und in welcher Qualität dieser Zaubertrick gelingt.

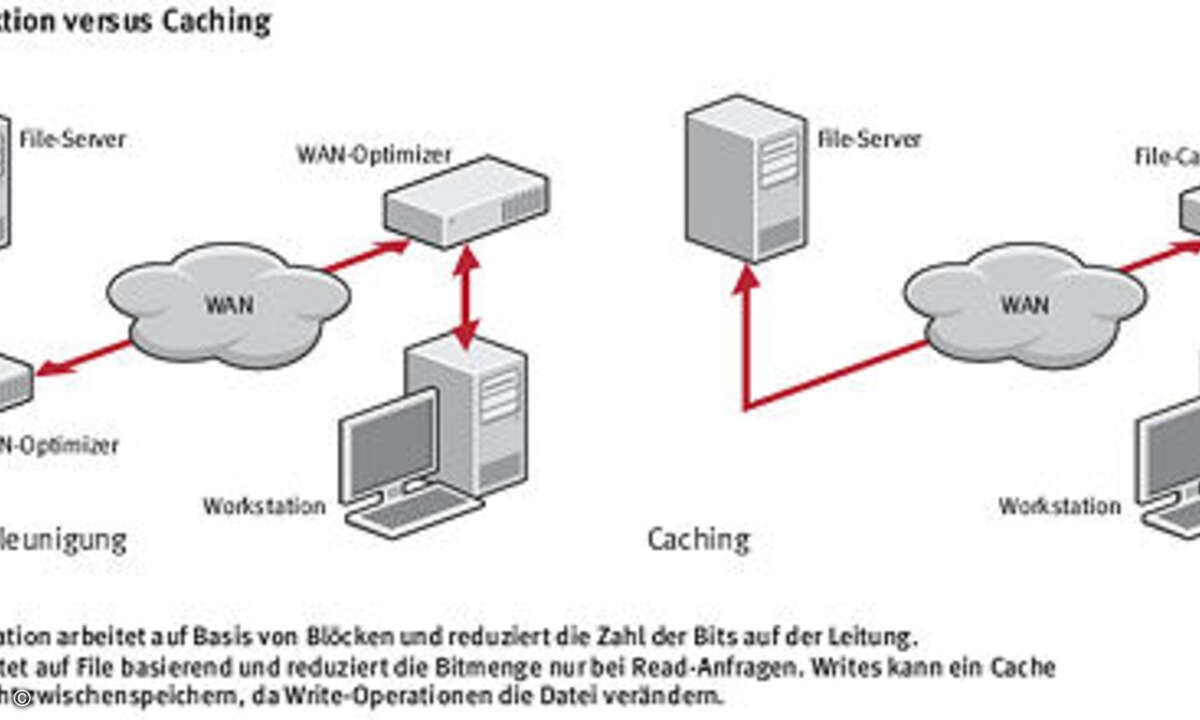

Es klingt wie ein faules Versprechen. Wie kann jemand physisch verfügbare Bandbreite verzehnfachen, ohne an der Leitung zu manipulieren? Die WAN-Optimization-Appliances oder -Beschleuniger werden aber genau mit diesem Argument auf dem Markt platziert. Den Boxen wollen diesen Zauber mit Hilfe mehrerer technischer Handgriffe vollführen. Verfahren, mit denen sie bestimmte Daten erst gar nicht übertragen müssen. Der Trick: Diese Daten sind schon am Zielort. Hauptgrund hierfür ist die so genannte Datenreduktion. Hierbei bauen die Appliances eine große interne Bibliothek auf, in der sie wiederkehrende Datenmuster mit stark geschrumpften Platzhaltern assoziieren. Diese Muster suchen die Boxen nicht auf File-Ebene, sondern direkt in den TCP-Flows. Bei oft wiederkehrenden Filetransfers wird nur das stark komprimierte Ersatzmuster an die Gegenstelle geschickt – anstelle der gesamten Informationen. Die Real-World Labs wollten herausfinden, ob dieses und alle anderen Verfahren der WAN-Bewchleuniger wie Caching oder TCP-Traffic-Shaping in der Praxis halten, was sie versprechen.

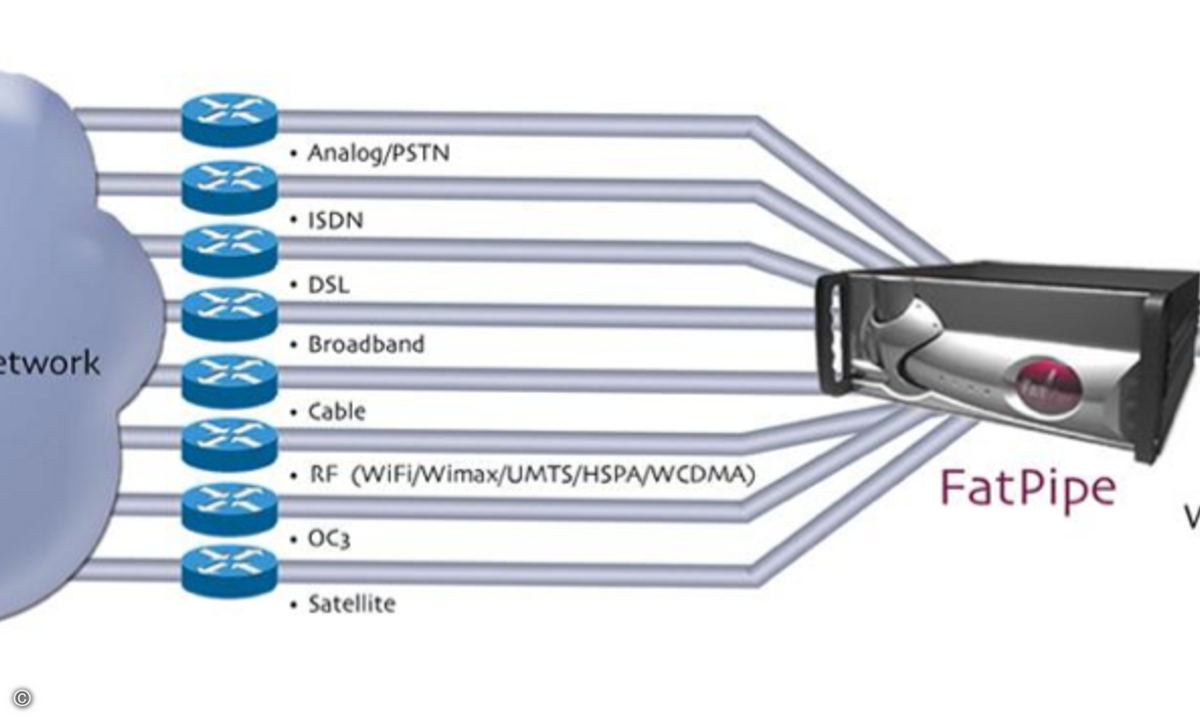

Die Hard- und Software-Hersteller waren gefragt, mit ihren Lösungen überlastete Leitungen eines Unternehmens mit mehreren Außenstellen intelligent zu organisieren. Das Netz bestand konzeptionell aus mehreren Branch-Offices und einer Zentrale, die per T1 oder T3 aneinandergekoppelt waren. Die virtuelle Firma im Test plant, die Leistung ihrer Distributed-Anwendungen zu verbessern und zahlreiche Dienste in einem Rechenzentrum zu konsolidieren. Aus Applikations- und Netzwerksicht sollten die Produkte aber transparent bleiben. Soll heißen, dass der Administrator weder auf Seiten der Desktops und Server, noch der Anwendungen Änderungen vorzunehmen braucht. Außerdem war vorgegeben, dass die Topologie möglichst so bleibt, wie sie ist. Mehr, als die Boxen inline zu stellen und per IP-Adresse einzubinden, war also nicht erlaubt. Außerdem sollten die Appliances zentral verwaltet sein und ihre Aktionen in detaillierten Berichten dokumentieren.

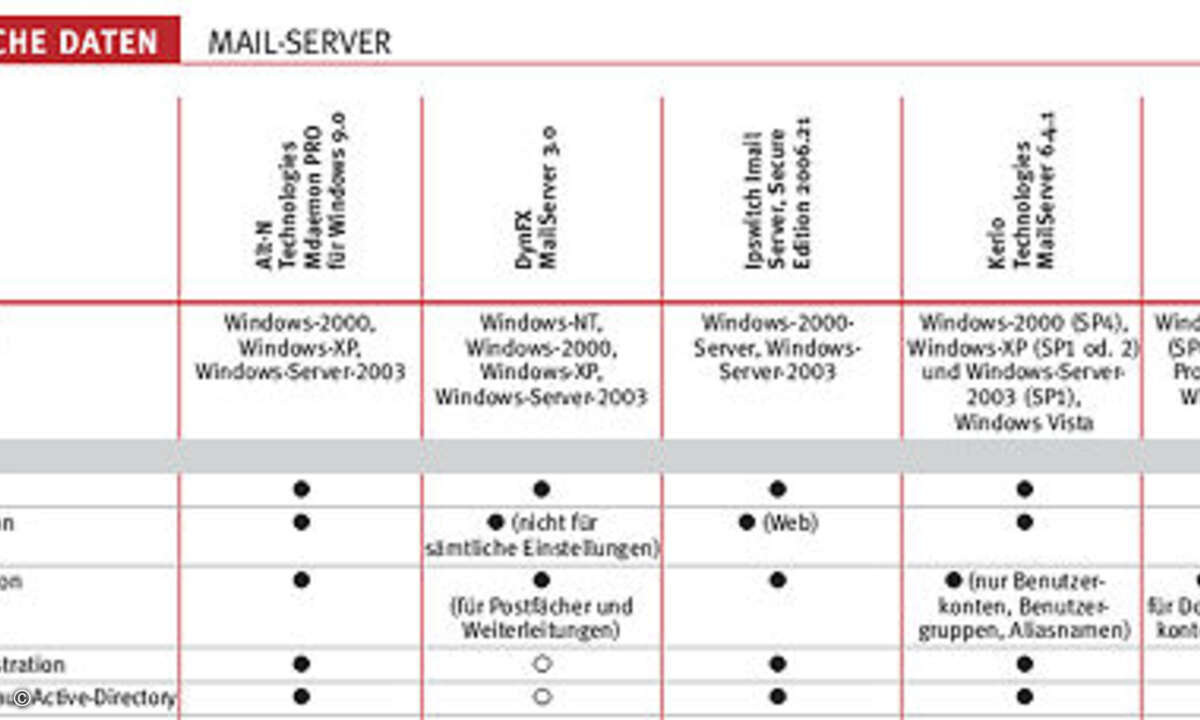

Die Real-World Labs haben insgesamt vier Systeme untersucht: Die »SG Appliance« von Blue Coat Systems, die »Wide Area Application Services« (WAAS) von Cisco, den »WANScaler« von Citrix sowie die »NX Appliance« von Silver Peak Systems. Alle vier haben hervorragende Ergebnisse bei der Beschleunigung erzielt, indem sie mehr Daten über die WAN-Strecke transferierten, als ihre pure Bandbreite hätte verkraften können. Die Boxen haben auch die Verzögerungsfristen bei beschleunigten und vor allen nicht beschleunigten Anwendungen nicht verlängert. Leistungsunterschiede zwischen den Systemen traten aber beim Reporting, der Konfigurationsstärke und dem Troubleshooting auf.

Am Ende hat die SG-Appliance von Blue Coat die Auszeichnung »Referenz« der Network Computing erhalten. Die Box lässt sich detailtief konfigurieren und beherrscht die meisten Protokoll-Proxies. Sie liefert gute Berichte und unterstützt eine Reihe von Sicherheitsfunktionen, unter anderem für SSL.

Die WAAS für die WAE-Appliances von Cisco gewinnen die Auszeichnung »Preis Leistung« der Network Computing. Das zentrale Management der Boxen war das beste im Test. Bei den Reports fällt Cisco dagegen hinter Blue Coat zurück.

Das magische Innenleben

Der Zauber funktioniert, weil die Appliances die Zahl der Bits auf der WAN-Strecke senken. Das geschieht mit Hilfe mehrerer Verfahren. Einmal manipulieren die Boxen die Größe des TCP-Windows auf Empfängerseite. Durch diese im TCP-Standard bereits festgelegte Methode zwingen sie den Sender automatisch, mehr Nutzdaten in jedes übertragene Paket hineinzulegen. Außerdem verhindern die WAN-Appliances mit eigenen lokalen intelligenten Buffern, dass sich die Daten auf der Seite des Empfängers stauen und möglicherweise Pakete verloren gehen. Dies hätte den gegenteiligen Effekt, dass der Sender seine Transferrate und die Größe der Pakete wieder senkt.

Applikationsprotokolle wie Exchange-Mapi oder SMB/Cifs beschleunigen die Appliances auf andere Weise. Sie cachen deren Objekte und wollen so den bremsenden Pingpong-Effekt dieser Dienste abschwächen.

Die größten Leistungsgewinne erreichen die Boxen allerdings mit der Datenreduktion. Das Verfahren ist der Kompression recht ähnlich, verwendet aber viel größere und stark angepasste Dictionaries. Typische Kompressions-Appliances ersetzen einen bestimmten, fixen Datenblock durch einen kleinen Bit-Block, der den größeren repräsentiert. Das Verfahren kann das gesamte Volumen um den Faktor zwei bis vier reduzieren – abhängig vom Dateitypen. Während sich Texte und Bitmap-Images stark eindampfen lassen, zeigt das Verfahren bei Videos oder binären Daten nur wenig Wirkung. Denn Video- und Audioformate setzen sich aus sich kaum wiederholenden Bitströmen zusammen. Schließlich sind die Dictionary-Größen der Kompressionsalgorithmen relativ klein, so dass deren möglicher Effekt von vornherein auf ein Maß beschränkt bleibt.

Anders liegt der Fall bei der Datenreduktion. Hier wird das Dictionary, also die Liste der Ursprungsdaten und ihrer kleinen Stellvertreter, von den Daten des jeweiligen Netzwerks geschaffen. Jedes Netz generiert so seine eigene Bibliothek für die Reduktion. Dieses Wörterbuch mag sich aus Hunderten von MByte oder GByte an Daten zusammensetzen, abhängig von der Dynamik im Verkehrsmuster der Firma.

Die Datenreduktion geht prinzipiell davon aus, dass sich der große Teil der WAN-Daten einer Organisation ständig wiederholt. Denn mehr als eine Person lesen oder schreiben in das gleiche File. Oder ein User liest die Datei, ändert sie ein wenig und schickt dies an die Zentrale zurück. Die Folge: Die leicht modifizierte Datei ist im Prinzip in großen Teilen identisch mit ihrem Vorgänger.

WAN-Beschleuniger beginnen nackt, denn sie wissen nichts über die aktuellen WAN-Daten und haben bisher nichts in ihren Dictionaries eingetragen. Sobald die erste Datei über eine WAN-Strecke verschickt wird, beginnen die Appliances auf beiden Seiten der Verbindung damit, das File zu analysieren. Sie beide kreieren identische Indizes der Bit-Blocks. Beim nächsten Aufruf der Datei wird die Appliance, die dem Quellserver am nächsten ist, die Datei wiedererkennen und statt ihrer nur die Indizes weitergeben. Die Box, die dem Empfänger-Client am nächsten ist, wird die Indizes analysieren und auf dessen Grundlage die ursprüngliche Datei rekonstruieren und zum Ziel schicken.

Mit der Zeit wird die Wirkung der WAN-Beschleuniger immer stärker. Denn je mehr Daten sie übertragen haben, desto mehr Referenzen haben sie in ihrem Dictionary verzeichnet und desto mehr Indizes können sie einsetzen, statt die Ursprungsdatei zu verschicken.

Wer sich hierbei stark an das alte Caching erinnert fühlt, ist auf der falschen Fährte. Caches kopieren die Datei und legen sie als Objekt lokal auf ihren Festplatten ab. Sobald ein Anwender dieses File nachfragt, prüft der Cache, ob sich die Ursprungsversion bis dahin verändert hat. Falls nicht, reicht es die Kopie an den User weiter. Wenn der Empfänger oder ein User vor ihm die Datei aber modifizierte, wird sie komplett neu über das Web geschickt. Lokale Leseoperationen kann Caching wunderbar beschleunigen, Write-Prozesse aber überhaupt nicht.

Das Verfahren Datenreduktion dagegen schickt immer Daten über die Leitung. Aber statt des gesamten Files werden nur repräsentative Datenblöcke ausgetauscht. Falls der Benutzer nun ein ediertes Dokument zu einem Remote-File-Server senden will, werden nur die ursprünglichen Datenblöcke geschickt, die sich tatsächlich verändert haben. Der Rest des Dokuments wird in Form der Indizes weitergeleitet. Die Empfänger-Appliances setzen dann aus den neuen Datenblöcken und den Index-Bits das ursprüngliche Dokument wieder zusammen und schicken es an über das LAN an das Ziel weiter.

Dadurch unterscheiden sich die Boxen in drei Schlüsselkriterien von den Caches. Die Client-Server-Verbindung wird aufrechterhalten. Falls ein User also weder Read- noch Write-Rechte besitzt, darf er auf die Daten nicht zugreifen. Außerdem kann die Datenreduktion wiederkehrende Blöcke in den Daten immer per Index ersetzen, unabhängig vom eigentlichen Dateitypen. Denn das Verfahren konzentriert sich rein auf die Bitströme. Falls beispielsweise das Firmenlogo in HTTP-, E-Mail- und Doc-Dateien das gleiche Bitmuster hat, wird das Verfahren es jeweils über Indizes repräsentieren. Und das zu übertragene Volumen insgesamt verkleinern.

Außerdem werden immer Blöcke und keine Files in den Verzeichnissen abgelegt. Bei einem veränderten File wird also der veränderte Block neu indiziert, während der Block der älteren Version weiter existiert. Wird die Datei auf die alte Version zurückgesetzt, greift wieder der ältere Index, und die Reduktion bleibt völlig funktionstüchtig.

Folgen für das Netz

Viele Verantwortliche nehmen von allen technischen Ansätzen Abstand, die die TCP/UDP/IP-Header verändern oder mit neuen, eigenen Parametern ummanteln. Aus ihrer Sicht müssen Verfahren, die im WAN auf den Verkehr einwirken, die Netzwerkattribute unverändert lassen. Diese Transparenz ist vor allem dann wichtig, wenn Router oder Firewalls im Upstream die Daten anhand von Regeln handhaben, die sich direkt auf die Header-Informationen beziehen. Wenn beispielsweise ein Router am Rand des Netzes Pakete mit Quality-of-Service-Bits markiert, müssen diese Informationen sichtbar bleiben. Das Gleiche gilt für Firewalls, die Zugangsentscheidungen abhängig machen von Sende- und Zieladressen sowie den Port-Nummern. Wer diese Bits mit eigenen IP-Informationen umhüllt oder per NAT verändert, hebelt diese grundlegenden Netzwerk-Konfigurationen aus. Die WAN-Beschleuniger im Test arbeiten als transparente Proxies zwischen Client und Server. Deshalb können sie Protokolle wie Server-Message-Block (SMB) und HTTP analysieren und ihre Leistung verbessern.

Transparenz bedeutet oft, dass weder Clients noch die Server im LAN modifiziert werden müssen. Aber welche Folgen lösen die WAN-Optimizer im WAN aus? Das hängt davon ab, wie sie Verkehr durchreichen. Einige Appliances nehmen durchaus Änderungen an den Daten vor. Die Steelhead-Box von Riverbed führt Network-Adress-Translation (NAT) bei allen Paketen durch, die sie bearbeitet. Die NX-Lösungen von Silver Peak ummanteln die Pakete mit Generic-Routing-Encapsulation-Tunnel-Daten (GRE). Beide Hersteller haben aber Funktionen in ihre Systeme eingebaut, die die IP-Informationen der ursprünglichen Header replizieren. Die Systeme von Blue Coat, Cisco und Citrix beschleunigen die Pakete, ohne sie zu verändern.

Wer Daten bereits priorisiert, sollte dies auch in der Welt des WAN-Optimizings tun. Alle Boxen im Test können QoS-Tags aus Paketen herauslesen und selbst welche setzen. Außerdem beherrschen alle Traffic-Shaping. Boxen, die mehrere Remote-Appliances aggregieren, folgen hier einem Out-of-Band-Ansatz oder setzen auf Policy-based-Routing, um gewissen Paketen Priorität einzuräumen.

Wer Access-Control-Listen (ACL) durchsetzen will, muss dagegen einige Hürden nehmen. Die WAN-Appliances unterstützen diverse Funktionen, mit denen sie Filter abhängig von Sender und Ziel sowie Portdaten scharf schalten können. Die Boxen ersetzen die Firewall aber keineswegs vollwertig. Wer diese Appliances zwischen Firewall und LAN platzieren möchte, sollte dies gut planen. Immerhin können sie ihre Beschleunigungskünste dann auf VPN-Daten anwenden. Denn sie sehen die Pakete noch im Klartext, bevor die Firewall sie per IPsec verfälscht. Unter dem Strich heben die WAN-Beschleuniger existierende Netzwerk-Dienste wie die Priorisierung nicht auf. Ihr Einsatz muss aber durchdacht sein.

Integrationsfragen

Die Systeme im Test binden sich auf vielfältige Weise in das Netz ein, sei es In-band oder Out-of-band. Alle beherrschen Policy-based-Routing sowie das Web-Cache-Communication-Protocol (WCCP). Letzteres wurde ursprünglich entworfen, damit Router standardisiert HTTP-Verkehr an einen Cache umleiten können. Heute wird es dafür genutzt, jegliche Form von TCP-Session umzuleiten. Auf diese Weise kann ein Router sämtliche Pakete an den WAN-Optimizer dirigieren. Oder die Box wird direkt inline platziert.

Bei Rechenzentren oder Aggregationspunkten ist es ratsam, WCCP oder Policy-based-Routing zu verwenden. Fällt nämlich die Appliance aus, hätte dies keine Folgen für das übrige Netz. Es würde nur der beschleunigte Verkehr auf Normalniveau fallen. Bei Außenstellen lohnt sich dagegen die Inline-Variante, weil sie viel einfacher zu installieren ist. Alle Apppliances im Test beherrschen eine Reihe von Failover-Mechanismen. Blue Coat und Cisco unterstützen sogar fortschrittliche Verfahren wie Clustering.

Ausfallphasen

Sämtliche Hersteller im Vergleich mussten erklären, wie ihre Boxen reagieren, sobald ihnen der Strom entzogen wird. Sie haben unisono geantwortet, ihre Systeme leiteten den Verkehr per Bridging trotzdem weiter. Der Test hat belegt, dass dieses Verfahren bei allen funktionierte. Die WAN-Optimizer arbeiten als transparenter Proxy inline im Netz, so dass weder Clients noch Server modifiziert werden müssen. Falls eine der Appliances im WAN-Pfad ausfällt, müssen aber alle von ihnen beschleunigten Sessions neu aufgebaut werden. Der Verantwortliche sollte aber wissen: Jede Session zwischen Client und Server in diesem WAN-Optimization-Bereich setzt sich tatsächlich aus drei Sessions zusammen: eine zwischen Client und dem lokalen WAN-Beschleuniger, eine zwischen dem WAN-Appliance-Paar, und die dritte zwischen dem Remote-WAN-Beschleuniger und dem Ziel. Mit Hilfe der transparenten Proxies können die Boxen alles ab IP aufwärts bearbeiten.

Windows-Clients nutzen recht kleine TCP-Windows, die sich wunderbar im LAN bewährt haben. Auf WAN-Seite dagegen begrenzen sie die Transferleistung. Indem die WAN-Appliances die Verbindungen lokal als Proxy organisieren, können sie die Windows-Größen auf Webseite viel aggressiver und leistungsorientierter aushandeln. Sie quetschen so das letzte Quäntchen Kapazität aus der Leitung heraus.

Die Boxen sind außerdem dazu fähig, einige applikationsspezifische Kunststücke aufzuführen. Wenn ein Microsoft-Client beispielsweise Windows-SMB dazu benutzt, Dateien vom Fileserver herunterzuladen, wird die Leitung mit lautem Protokollgeschwätz gefüllt. Der Server schickt nur 64 KByte zum Client und wartet, bis der den Empfang bestätigt hat. Diese Arbeitsweise bremst die Transferraten gerade auf langen Strecken unerhört stark ab. SMB/Cifs-Proxies bleiben auf LAN-Seite gegenüber dem Senderrechner genauso geschwätzig wie bisher. Auf WAN-Seite aber fassen sie viele der Command- und Control-Pakete zusammen und kürzen so die Roundtrip-Frist spürbar. Außerdem beherrschen diese Proxies auch Read-ahead-/Write-back-Funktionen. Darüber rufen sie bereits die nächsten Datenblöcke ab, obwohl die ursprünglichen Protokolle noch gar nicht so weit fortgeschritten sind. Oder sie importieren die richtigen Teile aus ihren Metadaten-Caches, weil sie bereits die entsprechenden Indizes erhalten haben. Sie arbeiten sozusagen vorausschauend. Die Boxen unterstützen auch die Protokolle Oracle SQLnet, RPC und NFS. Alle diese Dienste lassen sich auf diese Weise beschleunigen.

Nicht richtig inline

Bei der Installationsweise »transparentes inline« darf der Administrator nicht annehmen, dass seine TCP-Sessions ungestört weiterfließen, sobald sich eine Appliance verabschiedet. Und bei der ersten Installation werden die Boxen kaum Effekte bei bereits aufgesetzten TCP-Sessions erzielen. Denn aus Designgründen ist es ihnen schlicht unmöglich, einen TCP-State mitten in der Session zu errechnen. Dies sollte jeder vor allem bei asymmetrischem Routing berücksichtigen. Hierbei nehmen TCP-Streams jeweils unterschiedliche Pfade zum Ziel. Falls ein Optimizer eine solche asymmetrische TCP-Verbindung zu beschleunigen versucht, wird er ACK-Stürme verursachen, weil sowohl der Client als auch die Box die Session fortführen wollen.

Zum Glück sind die meisten TCP-Verbindungen relativ kurz, und diese Situation tritt nur bei Neuinstallationen oder -starts auf. Will der Verantwortliche gleich hohe Effekte erzielen, sollte er alle existierenden TCP-Connections abbrechen, indem er die Server und Clients neu startet. Während der Tests beispielsweise wurden alle existierenden Sessions gestoppt, bevor eine neue Testrunde initiiert wurde. Die NX-Appliance war die Ausnahme. Sie hat ihre Datenreduktionsfunktion auch auf existierende Sessions angewendet.

Die UDP-Frage

Bislang haben sich alle beschriebenen Funktionen auf TCP-Anwendungen bezogen, da die meisten Unternehmenstools hierauf basieren und TCP einige Session-Kontrollfunktionen standardmäßig mitbringt. UDP dagegen, obwohl es von kritischen Diensten wie DNS, VoIP und Streaming-Media genutzt wird, reagiert weitaus weniger effizient auf Beschleunigungs- und Datenreduktionsversuche. So wunderbar es auch wäre: Niemand wird seine User dazu zwingen können, schneller oder weniger zu reden.

Immerhin waren die Boxen von Silver Peak und Blue Coat in der Lage, UDP-Pakete in gewisser Weise zu beschleunigen. Die NX-Appliance von Silver Peak schaut auf die Bits in der Leitung und aktiviert ihre Datenreduktionsfunktionen. Das SG-Gerät von Blue Coat geht noch einen Schritt weiter, indem es sein Verfahren Stream-Splitting auf Video- und Sprachströme anwendet. Die Idee erinnert stark an das Multicast-Prinzip. Falls mehrere User den gleichen Video-Stream anschauen wollen, zieht die Box einen Stream direkt vom Content-Server und kopiert ihn lokal für sämtliche Anwender, die ihn angefragt haben.

Alle anderen Systeme im Test haben diese Daten immerhin so schnell wie möglich weitergeleitet. Damit sie die Qualität zeitkritischer Services wie Voice und Video nicht schmälern.

Knöpfe und Regler

Natürlich könnte jeder die Boxen einfach in das Netz einbauen, sie rudimentär einstellen und erste Resultate erzielen. Das meiste aus den WAN-Leitungen holt aber erst ein Tuning heraus. Dazu gehört unter anderem, die einzelnen Funktionen und Parameter abzustimmen und Bandbreite zu reservieren. Die Datenreduktion allein braucht Pflege und Zeit: Und je exakter die Policies formuliert sind, desto besser wird das Ergebnis sein.

Reine File-Transfer-Protokolle wie FTP, NFS und SMB/Cifs profitieren von allen Beschleunigungsfunktionen, SSH und Telnet aber kaum von der Datenreduktion. Denn bei Telnet sind die Pakete ohnehin klein.

Um ein Gefühl dafür zu bekommen, welche Wirkung die Funktionen entfalten, lässt sich folgende Faustregel heranziehen: Sämtliche Aktivitäten, die Bits auf der Leitung reproduzieren, profitieren stark von Datenreduktion und WAN-Beschleunigung. Alle anderen sind schlechte Kandidaten, können aber aus anderen Funktionen der Appliances ihren Nutzen ziehen.

Bei der SG-Appliance von Blue Coat war es beispielsweise möglich, den Proxies spezifische Protokolle zuzuweisen und festzulegen, welche Beschleunigungsverfahren sie jeweils einsetzen sollten. Auf diese Weise wurde jedes Paket, das die Box erreichte, anhand einer Policy bearbeitet, die sich exakt für dieses Paket eignete. Protokolle wie SSH und Telnet, die kaum von den Funktionen profitieren, wurden einfach durchgeleitet, so dass die Appliance weniger Last hatte. Alle anderen Protokolle wurden per Default-Regel über den Cache geführt.

Zu den generellen Proxy-Einstellungen liefert die SG-Box noch applikationsspezifische Parameter mit. Bei HTTP darf der Verantwortliche beispielsweise konfigurieren, dass Embedded-Objekte aus dem Cache und dem Dictionary vorgeladen werden sollen, um die Roundtrip-Zeit im WAN zu reduzieren.

Das SMB/Cifs-Caching, wie es Cisco und Blue Coat anbieten, unterscheidet sich von der Datenreduktion. Die Boxen beider Hersteller legen aktuelle Objekte wie Dokumente in der Tat lokal in einem eigenen Cache ab. Dadurch sind die Zugriffszeiten auf unveränderte Daten kürzer. Der Proxy von Cisco beispielsweise lässt sich so einstellen, dass er Files direkt aus dem Cache lädt, statt sie per Datenreduktion zu restaurieren. Der Read-only-Zugang lässt sich auf Per-Server aktivieren, sobald der Remote-Link zu ihnen ausfällt. Im Default ist diese Option ausgeschaltet.

Verantwortliche sollten aber recht behutsam und sorgsam mit dieser Funktion hantieren. Denn wenn ihre User einmal die gecachten Files bearbeiten, sind Kollisionen programmiert. Wenn nämlich mehrere User verteilt arbeiten und die gleiche Datei verändern, wer entscheidet dann, welche Änderung die wichtigste ist und demnach Gültigkeit besitzt?

Der Administrator wird diese und andere Fragen beantworten müssen, um das meiste aus der WAN-Beschleunigung zu schöpfen. Am Ende zahlt sich seine Mühe aus, denn die Produktivität seiner User wächst. Ungeachtet dessen, dass der Verantwortliche seinen Carriern und ISPs weniger Geld überweisen muss.

Fazit

Alle WAN-Beschleuniger haben gehalten, was sie versprechen. Sie haben die Antwortfristen verkürzt und die Zahl der Bits auf den Leitungen gesenkt. Die SG-Appliance von Blue Coat konnte sich dank ihrer feinstufigen Konfiguration und den meisten Proxies am Ende durchsetzen. Sie erhält die Auszeichnung »Referenz« der Network Computing.

Cisco erhält für ihre WAAS auf den WAE-Appliances immerhin die Auszeichnung »Preis Leistung« der Network Computing. Diese Systeme ließen sich am besten zentral verwalten, ihre Berichte fallen in puncto Detailgrad aber hinter denen von Blue Coat zurück.

Die Wanscaler-Appliances von Citrix bieten hohe Leistung, lassen sich aber weniger feinstufig an die aktuellen Bedingungen anpassen und sind unter dem Strich weniger flexibel. Sie beherrschen aber Cluster-Funktionen und asymmetrische Transfers – ebenso wie Ciscos WAAS.

Die NX-Appliances von Silver Peak Systems sind für Unternehmen mit hohen Sicherheitsansprüchen geeignet. Sie können den gesamten Verkehr per IPsec codieren und verschlüsseln zudem alle Daten auf ihren lokalen Festplatten.

pm@networkcomputing.de