Zwischen Qualität und Kosten

Runder Tisch: Verkabelung und aktive Komponenten (Teil 2) – Es ist nicht einfach, extrem hohe Frequenzen auf das Kupferkabel zu bringen. Deshalb arbeiten die Hersteller mittlerweile verstärkt an einer simpleren Handhabung ihrer Produkte. So soll der Unterschied zwischen Labor- und Feldeinsatz schwinden. Zweites Ziel: eine intensivere Schulung der Installateure und Planer.

André Gerlach, Sprecher der Bildungsinitiative der Netzwerkindustrie (BdNI), lobt die Maßnahmen der Verkabelungsindustrie, die auf eine Verringerung von Installationsfehlern abzielen. Grauzonen blieben dennoch. »So gehen die Installateure beispielsweise von falschen Biegeradien aus, und sie handhaben den Potenzialausgleich unsachgemäß«, moniert er. Es sei seit der Einführung von dienstneutralen Kommunikationsverkabelungen versäumt worden, Elektroplaner und Installateure hinreichend auszubilden. »Deshalb kann als Endprodukt kein hochwertiges und langfristig tragfähiges Verkabelungssystem dabei herauskommen.«

Manfred Patzke von Patzke Kommunikationssysteme pflichtet ihn bei. Er stellt klar, dass über ein besseres Produktdesign der Hersteller lediglich die Konfektion des Kabels an der Anschlusskomponente »fehlerreduzierend beeinflusst werden kann, nicht aber seine Verlegung«. Aber genau hier registriert er gravierende Mängel, weil bautechnische Maßnahmen nicht hinreichend berücksichtigt werden.

Und an die Verkabelungshersteller in der Runde gewandt: »Auch weil Sie die Verkabelungsanforderungen herunterspielen, werden die Gewerke nicht mehr hinreichend geplant.« Bernd Pfeiffer, Marketing-Communication-Manager bei Tyco Electronics, hält dagegen: »Wir versuchen, den Planern und Installateuren, auch über die Normierung, das Leben so einfach wie möglich zu machen.« Das Problem sei ein anderes: »Heute setzt der Meister wegen des hohen Preis- und Kostendrucks seinen Rotstift an die Verkabelung.« Pfeiffer beklagt Kabelziehtrupps aus Osteuropa, die wesentlicher billiger arbeiteten, ohne Qualität abzuliefern.

»Streng genommen müssten sich auch die osteuropäischen Kabelziehtrupps in Deutschland schulen lassen, mit einem Gütesiegel als Qualitätsnachweis«, fordert Gerlach. »Solange den Kunden die Dämpfung der Kosten wichtiger ist, wird sich aber leider am Status quo wenig ändern«, befürchtet er. Dabei zahlten die Unternehmen mit dieser Einstellung meist kräftig drauf. Oft müssten danach qualifizierte Installateure anrücken, um an allen Ecken und Enden nachzuprüfen und nachzuarbeiten. »Wer vor einigen Jahren den Slogan ,Geiz ist geil‘erfunden hat, gehört heute geprügelt«, beklagt er die hohen Folgeschäden in den Unternehmen.

Die Unternehmen sind die Gelackmeierten

»Qualität hat nun mal ihren Preis«, appelliert Patzke an die Einkäufer in den Unternehmen. Stefan Löffler, Produkt-Marketing-Manager Kommunikations-Messtechnik bei Agilent, sieht mit den höheren Frequenzen auf den Kabeln die Schadensrisiken für die Unternehmen bei einer unsachgemäßen Verlegung wachsen.

»Als Abwehr gegen solche Risiken müssten Produktqualität und hochwertige Dienstleistungen Hand in Hand gehen«, ist er überzeugt. »Deshalb supporten wir nur noch die geschirmte Verkabelung«, ergänzt Thomas Sentko, Technical-Support-Manager für Deutschland und verantwortlich für geschirmte Verkabelungssysteme bei Tyco Electronics. »Wir unterstützen voll EN50174, nicht nur bezüglich der Komponenten- und Leistungsklassen-Definitionen, sondern auch in puncto normkonformer Richtlinien für Planer und Installateure, auch für die abschließende Qualitätskontrolle.«

Auch für Thomas Schramm, Leiter der Abteilung Consulting bei Hirschmann, sind normkonforme Anweisungen und Hilfestellungen für eine hohe Qualität des Verkabelungssystems extrem wichtig. In diesem Zusammenhang bedauert er, dass der Antrag innerhalb der IEEE im November 2005 auf die Low-Cost-Variante 10-Gigabit-SH für Anschlussentfernungen bis zu 30 Metern abgelehnt wurde. Pfeiffer kann mit dieser Ablehnung gut leben. »Was hätte ein solcher Standard für die Büroverkabelung gebracht? Er hätte bestenfalls in kleinen und mittelgroßen Rechenzentren greifen und nur dort zu einer höheren Qualität beitragen können.«

Gerlach fordert die Runde auf, das Thema »Messtechnik« für 10-Gigabit-Ethernet zu beleuchten. »Viele im Installationsfeld wissen überhaupt nicht, was sie messen sollen und welche Auswirkungen die Messergebnisse auf der Seite der aktiven Komponenten haben«, stelle er immer wieder fest. »Und dies, obwohl auch die Messtechnik Teil des Qualitätsplans der EN50174 ist.«

Matthias Wilde, bei Psiber Data zuständig für technischen Vertrieb und Schulung, bestätigt Gerlachs Einschätzung: »Die Planer sind nicht hinreichend konform EN50174 ausgebildet. Für sie ist diese Norm nur Beiwerk, das sie kaum ernst nehmen.« Die Folgen blieben nicht aus. »Die Messgeräte werden nicht hinreichend kalibriert. Es werden die falschen Parameter eingestellt. Die Messstrippen werden nicht oder nur unzulänglich überprüft. Es werden für die Zukunft keine Reserven von mindestens 4 db berücksichtigt, weil auch aus der Geiz-ist-geil-Mentalität heraus an der Anschaffung oder Leihe von 1-Gigahertz-Messgeräten gespart wird.«

Optische Seite bleibt nicht verschont

»Die negativen Auswirkungen schlagen sich auch auf der optischen Seite nieder«, bemerkt Gerlach. »Viele messen an optischen Leitern, aber wenige kennen sich mit LWL (Lichtwellenleiter) und dem dazugehörigen Messszenario selbst nach zehn Jahren Feldeinsatz aus.« »Es gibt in Deutschland auf diesem Feld eine Hand voll gute Fachplaner«, alarmiert Patzke. Der große Rest gehe pauschal nach dem »Xerox-Prinzip« vor: die Ausschreibungstexte und den Vorbeschrieb aus vorhergehenden Ausschreibungen einfach kopieren. Eigentlich, so der Berater, wären die Unternehmen über den beauftragten Planer gefordert, den Installateuren von LWL-Verkabelungen das Gütesiegel abzuverlangen. »Aber die Planer machen es sich ohne Druck durch den Auftraggeber zu einfach«, ergänzt Wilde. »Sie verweisen in der Ausschreibung zwar auf EN50174, ohne jedoch bei der Angebotsprüfung näher darauf einzugehen.« Stattdessen hakten sie lediglich bei den Herstellern aktiver Komponenten nach, ob sie die eine oder andere Geschwindigkeit mit den entsprechenden Parametern unterstützten. Patzke registriert zum Leidwesen der Unternehmen bei den Planern bisher wenig Bereitschaft, an ihrem Wissensstand zu feilen, mit einem Prüfsiegel als Nachweis. »Vor vier Monaten hatten wir zu einem Seminar eingeladen, dass voll auf die Planer ausgerichtet war«, erinnert er sich. »Von den 20 Teilnehmern waren nur zwei Planer.«

Für Pfeiffer von Tyco Electronics steht außer Frage: Auch für den Planungsmissstand im Kupfer- wie im LWL-Bereich sei der selbst auferlegte Sparzwang der Unternehmen die Ursache. »Wir verlieren Projekte an ostasiatische Anbieter, die mit schlechten Kopien unserer Steckverbinder zu Billigpreisen anrücken.« Die schlechte Qualität schlage sich auf die Netzwerk-Performance bis hin zum Totalausfall nieder. »Wenn das Kind in den Brunnen gefallen ist, werden wir gerufen, um zu retten, was noch zu retten ist«, so Pfeiffer. »Und wir werden immer häufiger herbeizitiert.«

Sache der Gewährleistung

»Mit dem Wechsel auf 10 Gig werden wir künftig noch öfters als Feuerwehr anrücken müssen, wenn das absolute Preisdiktat in den Unternehmen nicht fällt«, sieht Wilde die künftige Entwicklung mit einem lachenden und weinenden Auge. »Nu in wenigen dieser Fälle werden wir daran vorbeikommen, die versuchte Neuinstallation komplett zu überarbeiten.«

Moderator Stiel wirft in die Runde, ob nicht einige deutsche Verkabelungshersteller mit Schuld an unreflektierten Unternehmensentscheidungen seien, weil sie nur eine Gewährleistung von zwei Jahren böten, bei Schadensfällen danach, wenn mit höheren Lasten für das Netz die Stunde der Wahrheit komme, die kalte Schulter zeigten.

Sentko stellt für Tyco Electronics heraus: »Von uns bekommen die Kunden eine Gewährleistung von 10, 15, teils sogar von 25 Jahren auf das Verkabelungssystem, wenn nachweislich nur gut ausgebildete Installateure daran gearbeitet haben.« Den Schwarzen Peter macht er eher bei den Anwendern aus. »Würden sie die Mängel monieren, hätten wir heute in Deutschland bei den Installationen keine Qualitätsprobleme.« Zu monieren gebe es nach Sentko mehr als genug. »Lediglich zehn Prozent der Verkabelungsinstallationen werden noch in hoher Qualität ausgeführt«, so seine erschreckende Einschätzung.

Stiel gibt zu bedenken, dass Garantieleistungen für die Kunden, unabhängig von ihrer Laufzeit, mit einer lästigen Herstellerbindung einhergingen. »Wir können nur für unsere Produkte in Kombination mit qualifizierten Installationsleistungen die Hand ins Feuer legen«, kontert Pfeiffer. Auch Daimler-Chrysler würde nicht für einen Schaden haften, wenn der Kunde nachträglich die Felgen eines anderen Herstellers aufgezogen habe. Unabhängig davon, dass Daimler-Chrysler längst nicht mehr selbst die Felgen fertigt, sieht BdNI-Sprecher Gerlach für die Kunden durchaus Perspektiven, auch bei Mix-and-Match-Installationen in den Genuss einer Vollgarantie zu kommen. »Erste Verkabelungshersteller treffen mit Komponentenherstellern so genannte Back-to-Back-Vereinbarungen. Sie schließen eine Garantie für das Gesamtsystem ein.«

»Wie steht es um die Garantieleistungen auf der aktiven Seite?« richtet Moderator Stiel den Blickwinkel der Runde auf die aktiven Komponenten. Danach fragt er ketzerisch: »Wieso braucht es künftig noch Qualitity-of-Services (QoS), wenn Flussprobleme durch 1- und 10-Gigabit-Ethernet-Anschlüsse ohnehin nicht mehr auftreten werden?

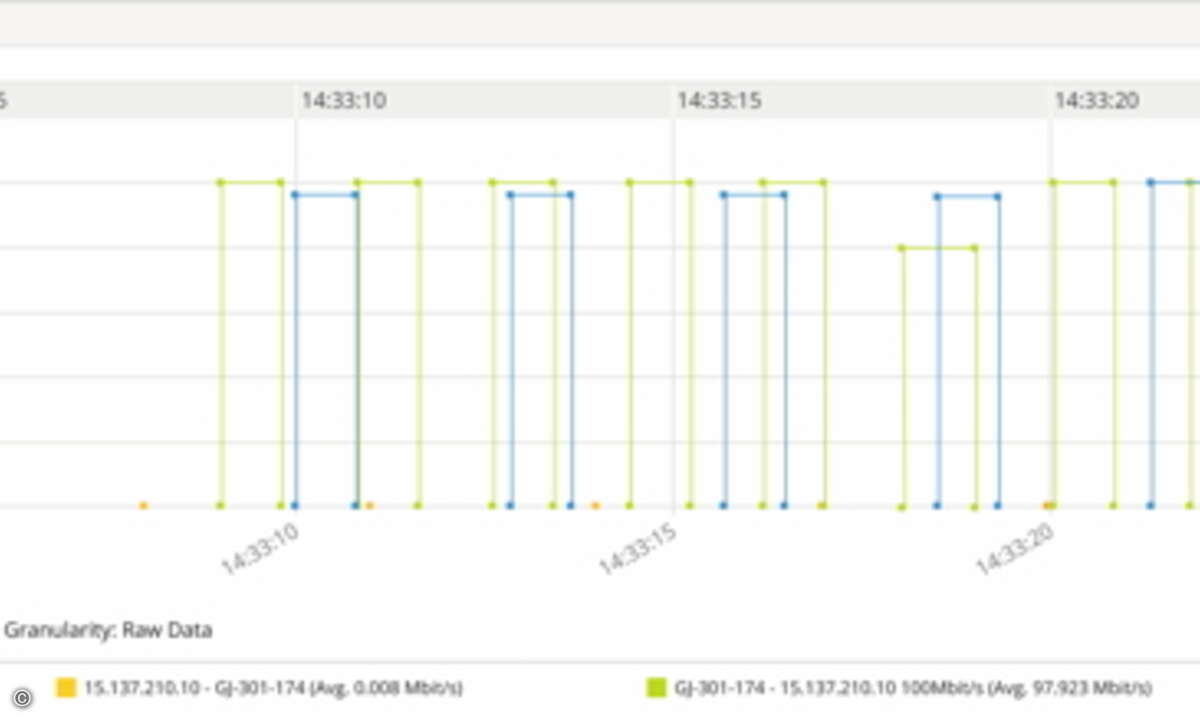

»Eine Garantie können wir nur bieten, wenn durchgehend Cisco-Systeme eingesetzt werden«, antwortet Hies. Und mit Blick auf QoS: »Sie sind auch bei großen Bandbreiten nötig, schon um die Sicherheit der Netzinfrastruktur zu garantieren . Netzwerke benötigen heute mehr denn je eine Ende-zu-Ende-Sicherheitsarchitektur, beispielsweise zusammengesetzt aus Cisco-Komponenten mit integrierter Sicherheit.« So nutze beispielsweise die eigene Technologie Control-Plane-Policing-QoS-Mechanismen, um Angriffe auf die CPUs von Switch- und Router-Systemen abzuwehren. Auch für ihre eigentliche Aufgabe, über QoS den Fluss von verzögerungsempfindlichen Strömen wie Telefonie oder Echtzeit-Videokonferenzen sicherzustellen, gibt er keine Entwarnung: »Mit 10 Gig im Backbone mögen vorerst keine Staus auftreten, aber sie werden, vorangetrieben durch Bursts und Micro-Bursts von Gigabit-Ethernet-PCs und -Servern, ohne QoS kommen«, schätzt er ein. Für die Aufgabe, die einzelnen Ströme zu klassifizieren und mit entsprechenden Latency- und Jitter-Werten über die entsprechende Queue abzuarbeiten, sieht er mehr oder weniger nur noch einen tragfähigen Mechanismus: DiffServ. »Er hat sich im Einsatz bewährt und ist gut skalierbar.«

Von Stiel auf die vergangene Flut an QoS-Mechanismen bei Cisco Systems angesprochen, deutet er auf viele Namen für oft gleiche oder ähnliche Verfahren. Allerdings habe sich auch die QoS-Landschaft konsolidiert, räumt er ein. So habe sich mittlerweile IntServ vom Service-Provider-Markt verabschiedet, und RSVP (Resource-Reservation-Protocol) werde für andere Dienste wie Traffic-Engineering genutzt. Auch Schramm von Hirschmann sieht, trotz des Bandbreitenhammers 10 Gig, QoS weiterhin gefordert. Als Argumente führt er den noch zu hohen Preis für 10-Gigabit/s-Endgeräteanschlüsse und Wireless-LANs als bandbreitenschwache Kommunikationstechnnik an. »Außerdem werden QoS und seine Klassifizierung für IT-Security gebraucht«, verficht er die gleiche Argumentationslinie wie Hies. Auch er rät den Unternehmen zum Einsatz nur eines standardisierten Verfahrens, DiffServ.

Siegfried Mayr, Sales Director für den deutschsprachigen Bereich bei Allot Communications, plädiert dafür, über Deep-Packet-Inspection (DPI) tiefer in die Pakete hineinzugehen. »Um die Flüsse im Netzwerk auf Dauer aufrechtzuerhalten, muss, ausgehend von den Anwendungen, für jedes Paket entschieden werden, mit welcher Priorität und mit welchen Sicherheitsfunktionen es zu behandeln ist.« Dazu seien für jedes Netzwerk individuell Regeln notwendig, um sämtliche Ströme je nach Anwendungsanforderungen zu steuern. Auf den Einwurf, was die anwendungsbezogene Intelligenz von DPI jenseits der WAN-Schnittstellen bringe, verweist Mayr darauf, dass auch in den LAN-/WAN-Knoten die Anwendungen identifiziert werden könnten. »Auf diese Weise kann die Verbindungsbandbreite der letzten Meile effizienter ausgeschöpft werden.« Tiefer ins WAN reiche die Wirkung von DPI nur im Zusammenspiel mit »TOS-enabled« (Type of Service) oder MPLS-Router-Netzwerken, allerdings nur auf Netzwerkebene, schränkt er ein.

Hies von Cisco Systems qualifiziert das Service-Routing auf Anwendungsebene mit tiefem Einblick in die Pakete »als sehr komplex. Anwendungsgebiet dafür wird mehr der Edge, weniger der Core sein«, meint er. Er verweist für DiffServ auf Netzwerkebene auf Übersetzungsverfahren zwischen Provider- und Kundennetz, ohne näher auf sie einzugehen. »Natürlich muss das Unternehmen den Provider genau darüber unterrichten, welche Bandbreiten und Sicherheitsmechanismen er den einzelnen Klassen einräumen soll, damit der diese Anforderungen in seinem QoS-Konzept abbilden kann«, macht Hies indirekt deutlich, dass die Praxis selbst von einer dynamischen Übernahme von QoS- und Sicherheitsparametern auf Netzwerkebene durch den Provider noch weit entfernt ist.

Verfügbarkeit kostet Geld

Stiel lenkt die Aufmerksamkeit der Gesprächsrunde auf den Aspekt »Verfügbarkeit«. Immerhin müssten die Unternehmen im Zeitalter konvergenter Netze kräftig an Redundanz zulegen, um für Echtzeitsprache und -video annähernd das Verfügbarkeitsniveau von ISDN zu erreichen.

Hies spricht in diesem Zusammenhang von vielen Vorkehrungen in den und rund um die aktiven Kompontenen: Redundanz der Netzteile, der Stromversorgungen, der Hauptprozessoren, Verbindungsredundanz, die vor allem im Backbone-Bereich mit redundanten Routern beziehungsweise Switch-Systemen einhergehen, dazu die Redundanz im Server-Bereich, insbesondere in Form redundanter Server-Verbindungen. »Die Mechanismen für hohe Verfügbarkeit bei den aktiven Komponenten allein genügt nicht. Dazu gehört auch die entsprechende Managementkultur, repräsentiert durch ein modernes Change-, Fault- und Configuration-Management«, fordert Hies von den Entscheidern. Die Gesamtkonstruktion sei vielleicht komplex, aber notwendig. »Denn hohe Verfügbarkeit muss in Zeiten der Konvergenz von Sprache, Daten und Video nicht nur als Technologie eingekauft, sondern auch in Prozessen gelebt werden«, so sein Credo.

Für Löffler von Agilent sind diese Ausführungen eine Steilvorlage, parallel auf das Management der passiven Infrastruktur aufmerksam zu machen. »Denn was nutzen QoS und die verschiedenen Verfügbarkeitsvorkehrungen, wenn irrtümlicherweise ein Patch-Kabel nicht gesteckt oder gezogen wurde«, fragt er. In den USA, in England und Osteuropa werde das Add-, Move- and Change-Management der passiven Seite, angesiedelt beim Helpdesk, bereits als Teil der Gesamtlösung gesehen, versucht er die Unternehmen hierzulande aufzurütteln.

hs@networkcomputing.de