Anwendungen: Virtualisieren oder in die Cloud verschieben?

Auch wenn die großen Cloud-Anbieter gerne das Image von perfekten Plattformen für alle Arten von Anwendungen suggerieren möchten: Noch steckt Cloud-Computing in den Kinderschuhen. Trotzdem erwägen viele CIOs die Stufe der Virtualisierung zu überspringen und gleich auf interne und externe Cloud-Plattformen umzusteigen.

Cloud-Computing ist in aller Munde. Die Werbe- und PR-Trommeln von IBM, Microsoft, HP, Sun,

Salesforce, Amazon und Google laufen auf Hochtouren und versprechen den IT- und Business-Chefs

genau das, was diese sich schon immer erträumt haben: Alle Probleme werden ausgelagert, nur die

Nutzungsvorteile verbleiben in den eigenen Räumen. Oder anders gesagt: Nur noch ernten – ohne säen

zu müssen.

Doch die Realität sieht gegenwärtig noch ganz anders aus: "Die Plattformen für Cloud-Computing

stecken bislang in den Kinderschuhen und benötigen noch mindestens sechs bis sieben Jahre, bis sie

ausgereift sind", meint beispielsweise Gartners Vice President Mark Driver.

Weitere Infos zum Thema:

Dass die Cloud-Nutzung noch in der Anfangsphase steckt, erkennt man auch an den zurückhaltenden

Äußerungen und Vorsichtsmaßnahmen der Großunternehmen. "Wir experimentieren noch damit; es ist eine

steile Lernkurve", meint Tim Stanley, CIO bei der Hotel & Casino Kette Harrah?s, die immer mehr

Kundendaten und Anwendungen auf die Force-Plattform von Salesforce verlagert. Auch der

Salesforce-Vorzeigekunde, die Citibank in New York, will sich noch nicht ganz in die Abhängigkeit

der Salesforce-Wolke begeben. Zum einen sind bislang nur zeitunkritische Backoffice-Anwendungen

ausgelagert, zum anderen erfolgt das Hosting in einer Form, die eine kurzfristige Rückkehr zur

In-House-Lösung ermöglicht, sollte es einmal mit der Zuverlässigkeit der IT-Wolke zu sehr

hapern.

Zwar wollen die Mega-Cloud-Provider, wie Microsoft, Salesforce, Amazon und Google das Gegenteil

suggerieren, doch selbst sie können den Markt nicht vollends abdecken – und schon gar nicht alle

Sicherheitsbedenken ausräumen.

"Das Potenzial der Cloud-Nutzung, sowie die vielen damit verbundenen Probleme sind ganz breit

gefächert – selbst die großen Anbieter können das unmöglich alles alleine adressieren", sagt Sergej

Beloussov, CEO von Parallels, einem weltweiten Anbieter von Infrastruktursoftware für

Cloud-Service-Provider (CSP). Seiner Einschätzung nach bietet sich der Einstieg in ein

Cloud-Angebot vor allem bei den bisherigen Internet-Service-Providern (ISVs) an, die damit

wesentlich mehr Umsatz pro Kunde generieren und gleichzeitig ihre Infrastruktur besser ausnutzen

können. Laut Beloussov können es auch die kleineren ISVs durchaus mit ihren großen und allseits

bekannten Konkurrenten aufnehmen. "Wichtig ist vor allem, dass die ISVs bei einer Ausweitung ihres

Angebots sich auf erprobte Standardsoftware stützen und auf keinen Fall versuchen, das Rad neu zu

erfinden", so sein Rat. Damit meint er beispielsweise die Entwicklung einer Abrechnungssoftware für

eine On-Demand-Anwendung. Davon gibt es bereits eine Vielzahl erprobter Lösungen im Markt,

inklusive der Parallels-Software Plesk Billing 6.0.

Gartners Driver sieht außer den ISVs noch eine andere wichtige Anbietergruppe am Cloud-Horizont

aufziehen: "Für die IT-Chefs sind gegenwärtig alle Tools von Bedeutung, die eine schnelle

Anwendungs-Entwicklung erlauben und mit denen sie den Fachbereichen in kürzester Zeit Ergebnisse

liefern können. Von Vorteil sind deshalb alle Anbieter die ein spezielles Branchen-Know-how

mitbringen", so Driver. Diese neue Cloud-Anbietergruppe kommt zumeist aus dem Channel und versucht

jetzt mit gehosteten Lösungen den Umsatzrückgang bei den Lizenzerlösen aufzufangen.

Doch nicht nur Unternehmen mit vertikalem Spezialwissen drängen in das Cloud-Angebot. Auch

systemorientierte Querschnittsanbieter haben sehr gute Chancen. Hierzu gehören unter anderen die

beiden Storage-Provider Parascale und Nirvanix; der Startup Kaavo, der an einer herstellerneutralen

"Middleware on Demand" bastelt; außerdem die von ehemaligen Web-Methods-Managern gegründete Appirio

sowie der System-Management-Spezialist Elastra. Letzterer ist genau auf dem Gebiet aktiv, das viele

IT-Chefs derzeit besonders beschäftigt: "Soll ich statt einer weiteren Virtualisierung nicht lieber

gleich alle Anwendungen in eine eigene, so genannte private, Cloud verschieben?"

In der Tat gehen viele Experten davon aus, dass die gegenwärtige Virtualisierungswelle in den

Rechenzentren nur eine Übergangsphase darstellt. "In fünf bis zehn Jahren wird ein großer Teil der

Unternehmen die gesamte IT-Infrastruktur in die Cloud verschoben haben", meint beispielsweise Chris

Barbin, CEO bei Appirio, der zuvor Senior Vice President für Global Customer Service bei

Web-Methods war. Sein 100-Mitarbeiter starker Startup hat sich auf die Umstellung von

In-House-Lösungen auf Cloud-Services spezialisiert. "Mit unserer Unterstützung können unsere Kunden

die immer komplexer werdenden Probleme bei der Virtualisierung überspringen und sich wesentlich

stärker auf die Nutzung und die Entwicklung von Anwendungen konzentrieren", lautet sein

Versprechen.

In der Mitte zwischen einer In-House-Virtualisierung und einem vollständigen Auslagern sind die

privaten Clouds. Diese stellt die IT-Abteilung bereit; sie verhalten sich genauso wie eine externe

(öffentliche) Cloud, ohne dass jedoch die Daten und Programme die eigene Infrastruktur verlassen

müssen. Das heißt, es bleibt alles geschützt hinter der Firewall. Maximum-ASP ist ein Anbieter

solcher Technologien. Deren IT-Infrastruktur setzt zunächst auf Microsofts Hyper-V auf und

integriert Citrix-Applikationen, SAN-Storage, Backups sowie Clustering für hochverfügbare

Anwendungen. Damit kann eine leistungsstarke interne Cloud angelegt werden, die wie ein einziger

virtueller Mega-Server gemanagt wird.

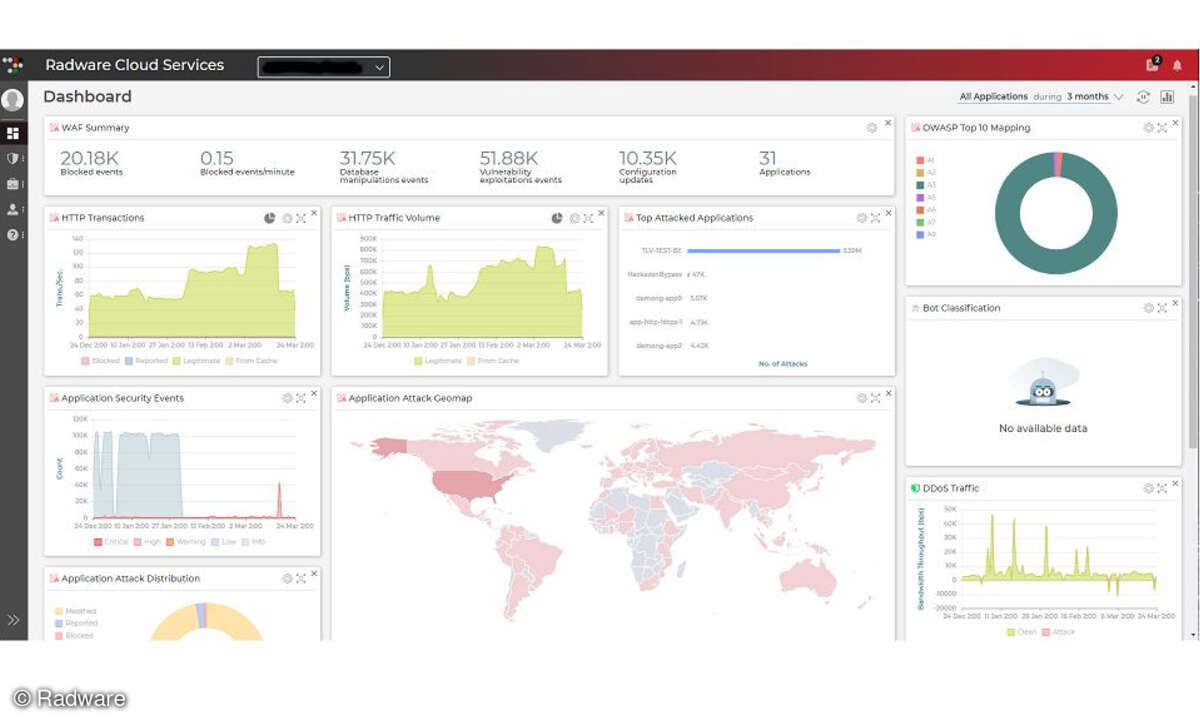

Bei den vielen Problemen, die dem Cloud-Computing noch anhaften, stehen die Bereiche Sicherheit

und Zuverlässigkeit an oberster Stelle. Dies betrifft nicht nur die übliche Anfälligkeit der

IT-Systeme gegenüber Datenverlust und Datendiebstahl, sondern vor allem Vorkehrungen zum

Desaster-Recovery. Es reicht nicht aus, zu meinen, dass eine ausgelagerte IT bei der Zerstörung des

eigenen Rechenzentrums verschont bleibt, sondern es muss darüber hinaus vertraglich geregelt sein,

dass auch der Cloud-Provider Daten und Anwendungen in einem räumlich weit entfernten Rechenzentrum

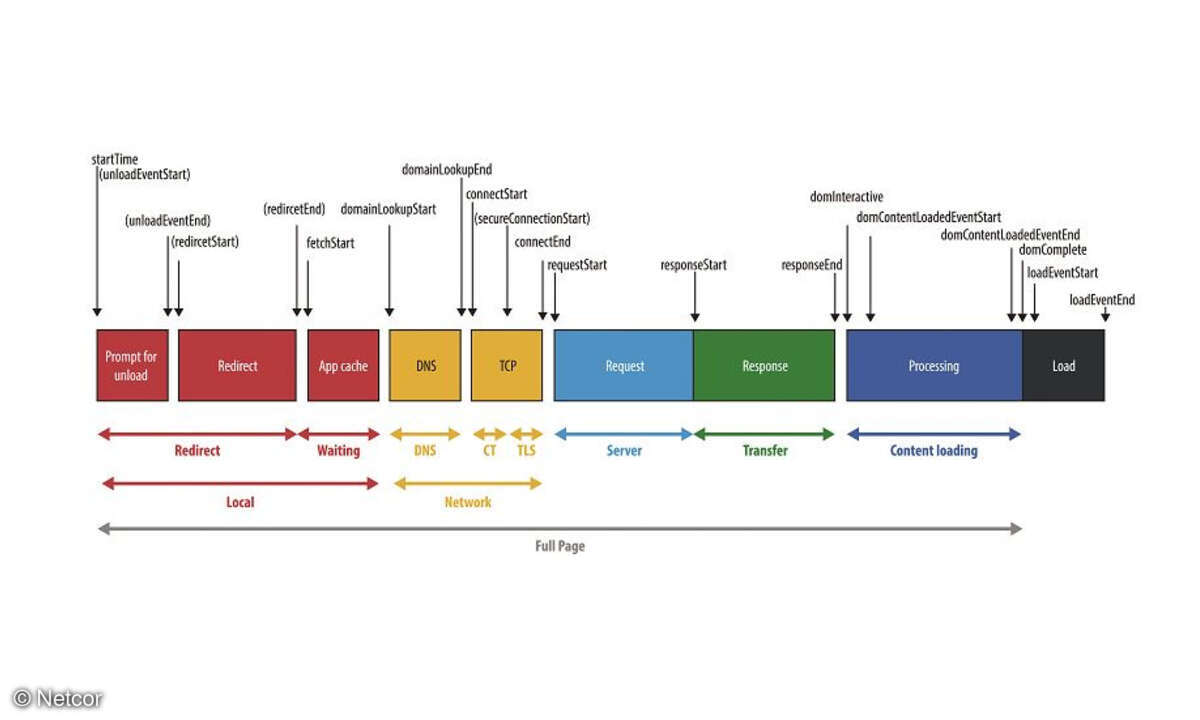

spiegelt. Bei der Zuverlässigkeit der Cloud-Lösungen ist vor allem die Netzübertragung ein Problem.

Der Cloud-Provider kann kein Service-Level-Agreement (SLA) eingehen, da er keinen Einfluss auf den

ISV des Kunden hat. Nur Großkunden mit einem entsprechenden SLA mit einem Netz-Provider können hier

sicher sein, dass die Verfügbarkeit ausreichend abgesichert ist. Für die kleinen und mittleren

Unternehmen gibt es vorläufig keine befriedigende Lösung für dieses Problem. Zur Lösung wird

derzeit an zwei Fronten gearbeitet: Erstens, neue Protokolle sollen die Übertragung beschleunigen,

sodass Netzschwächen weniger Auswirkungen auf die Performance haben. Zweitens: Verschiedene

Provider unterstützen die Anstrengungen der großen US-Telekommunikationsunternehmen, die

Internet-Neutralität abzuschaffen. Dann könnte ein CSP einen Prime-Service ordern, bei dem der

TK-Provider dem CSP einen Service-Level für das Durchreichen der Daten garantiert. Diese Garantie

kann der CSP dann an seine Kunden weiter reichen.

Harald Weiss/dp