Hybride Cloud-Architekturen als Basis für KI

Die Integration von Künstlicher Intelligenz in komplexe Hybrid-Architekturen ist kein Selbstläufer. Auf welche technischen, organisatorischen und strategischen Herausforderungen Unternehmen vorbereitet sein sollten.

Künstliche Intelligenz (KI) wird zunehmend zum zentralen Treiber für Innovation in Unternehmen. Laut dem Gartner-Bericht „Forecast Analysis: Artificial Intelligence Software, 2023–2027“ soll der weltweite Markt für KI-Software bis 2027 auf fast 300 Milliarden US-Dollar anwachsen, mit einem jährlichen Wachstum von rund 19 Prozent. Besonders stark steigen die Investitionen in generative KI, deren Anteil am gesamten KI-Softwaremarkt von acht Prozent im Jahr 2023 auf voraussichtlich 35 Prozent im Jahr 2027 wächst. Parallel dazu boomt der Markt für Public-Cloud-Dienste: Bis 2028 sollen Unternehmen weltweit mehr als 1,26 Billionen US-Dollar in Cloud-Infrastruktur und -Anwendungen investieren. Vor diesem Hintergrund werden hybride Cloud-Architekturen – Kombinationen aus lokalen Rechenzentren, Edge-Computing und Public Cloud – zur Grundlage erfolgreicher KI-Projekte.

Diese Dynamik zeigt, dass Unternehmen nicht nur in KI investieren, sondern auch ihre Cloud-Architekturen anpassen müssen, um das Potenzial von KI effizient zu nutzen. Gerade hybride Cloud-Lösungen bieten die Möglichkeit, sensible Daten geschützt zu halten, Rechenleistung flexibel einzusetzen und gleichzeitig innovative KI-Anwendungen zu betreiben. Doch die Integration von KI in solche komplexen Infrastrukturen ist kein Selbstläufer: Sie stellt Unternehmen vor technische, organisatorische und strategische Herausforderungen – von der Datenintegration über den Aufbau geeigneter MLOps-Strukturen bis hin zur digitalen Souveränität.

Technische und organisatorische Herausforderungen

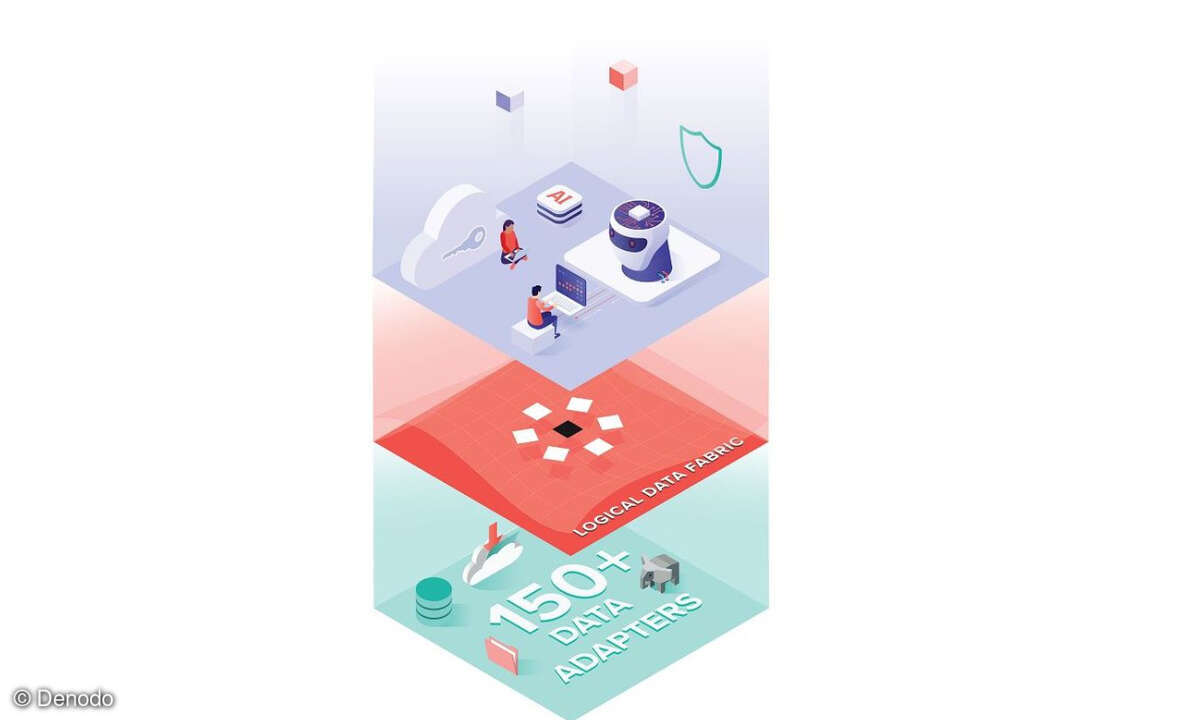

Die Umsetzung von KI in hybriden Cloud-Umgebungen ist komplex. KI-Modelle benötigen qualitativ hochwertige, konsistente Daten. In der Praxis liegen diese oft verteilt in On-Premises-Systemen, Edge-Geräten oder verschiedenen Cloud-Diensten. Die Harmonisierung und sichere Bereitstellung dieser Daten erfordert robuste Datenpipelines, die Qualität, Integrität und Datenschutz kontinuierlich überwachen. Unvollständige oder schlecht strukturierte Daten gefährden sonst den Erfolg jeder KI-Anwendung.

Neben der Datenintegration ist auch die technische Infrastruktur entscheidend. Viele Unternehmen nutzen unterschiedliche Datenbanken, ERP-Systeme oder Sensorik in der Produktion. Diese Systeme müssen zusammengeführt und standardisiert werden, um KI-Modelle zuverlässig trainieren zu können. Containerisierung und Kubernetes helfen, Anwendungen portabel und skalierbar zu betreiben.

Automatisierte MLOps-Pipelines steuern den gesamten Lebenszyklus von KI-Modellen: Sie sorgen dafür, dass Daten importiert, Modelle trainiert, validiert und produktiv ausgerollt werden. Gleichzeitig überwachen diese Pipelines die Qualität und Performance der Modelle und steuern kontinuierliches Nachtraining oder Rückroll-Mechanismen im Fehlerfall. So können Unternehmen sicherstellen, dass KI-Anwendungen zuverlässig, reproduzierbar und compliant laufen. Governance spielt dabei eine zentrale Rolle: Wer hat Zugriff auf welche Daten? Wo liegen diese? Wie werden Backup- und Exit-Strategien umgesetzt?

Auch organisatorisch sind die Herausforderungen groß. Fachkräfte mit Erfahrung in MLOps, Data Engineering und Cloud Automation sind insbesondere in KMU rar. Klare Verantwortlichkeiten, die Einbindung von Fachbereichen und Management sowie externe Beratung erhöhen die Erfolgschancen erheblich. Unternehmen sollten Projekte in überschaubare Use Cases herunterbrechen und messbare KPIs definieren. Eine strategische Priorisierung hilft, Ressourcen gezielt einzusetzen und digitale Souveränität zu wahren.

Ein weiteres Risiko ist der Lock-in-Effekt großer Cloud-Anbieter. Daten und trainierte Modelle sind oft an proprietäre Formate gebunden, ein späterer Plattformwechsel wird dadurch erschwert. Unternehmen müssen daher von Anfang an Portabilität und Exit-Strategien berücksichtigen, um langfristige Flexibilität zu sichern.

Praxisbeispiele und Erfolgsfaktoren

Hybride KI-Lösungen haben sich in unterschiedlichen Branchen bewährt. In Produktionsunternehmen unterstützt KI die generative Produktentwicklung, indem Kundenfeedback, Markttrends und Produktionsdaten analysiert werden. Sensible Informationen bleiben dabei lokal, während die Modelle in der Cloud trainiert werden. So entstehen neue Produktideen datenschutzkonform und effizient. Im Healthcare-Bereich ermöglichen hybride KI-Systeme beispielsweise, Patientendaten lokal zu verarbeiten, während komplexe Trainings- und Analyseaufgaben cloudbasiert durchgeführt werden. Dies vereint den Schutz sensibler Daten mit der Nutzung leistungsfähiger KI-Algorithmen. Auch im (Textil-)Großhandel zeigen sich Vorteile: KI optimiert Lagerbestände, analysiert Nachfrageschwankungen und unterstützt automatisierte Bestellprozesse.

Ein weiterer Bereich, in dem hybride KI-Lösungen Nutzen stiften, ist der Kundensupport. KI-Assistenten analysieren Anfragen, klassifizieren sie, priorisieren Tickets und beantworten wiederkehrende Fragen automatisiert. Die hybriden Architekturen erlauben, dass solche Assistenten entweder lokal oder in der Cloud betrieben werden, je nach Anforderungen an Datenschutz und Compliance.

Diese Beispiele verdeutlichen, dass hybride Lösungen Flexibilität, Sicherheit und Innovationsfähigkeit miteinander verbinden können. Technisch bewährt haben sich hierbei die Containerisierung von Anwendungen und der Einsatz von Kubernetes, um Portabilität und Skalierbarkeit zu gewährleisten. Governance und Sicherheit müssen von Anfang an implementiert werden, mit klaren Rollen, Berechtigungen und Backup-Strategien. Besonders entscheidend ist, dass Unternehmen ihre Projekte auf wenige, gut messbare Use Cases fokussieren, um schnelle Erfolge zu erzielen und Ressourcen effizient einzusetzen.

Digitale Souveränität, Effizienz und Trends

Digitale Souveränität gewinnt zunehmend an Bedeutung. Unternehmen wollen die Kontrolle über ihre Daten behalten, besonders in regulierten Branchen. Europäische oder souveräne Cloud-Lösungen ermöglichen, dass sensible Daten lokal verbleiben, während rechenintensive Prozesse in der Public Cloud ausgeführt werden. So lassen sich Innovationsfähigkeit, Compliance und Risikominimierung miteinander vereinbaren.

Auch Energieeffizienz spielt eine Rolle. KI-Training ist sehr rechenintensiv, und hybride Architekturen ermöglichen es, Workloads dynamisch zwischen On-Premises-Systemen und der Cloud zu verschieben, um den Energieverbrauch zu optimieren. Der Einsatz spezialisierter Hardware wie GPUs sowie Container-Orchestrierung kann die Rechenlast effizient verteilen. Zudem verringert die Nutzung von Rechenzentren mit grünem Strom den ökologischen Fußabdruck.

Für die kommenden Jahre zeichnen sich klare Trends ab: KI wird stärker in hybride Architekturen integriert, AI Ops und MLOps automatisieren Abläufe, optimieren Betrieb und Ressourcenverbrauch und steuern Nachtrainings effizient. Edge- und Cloud-KI wachsen enger zusammen, sodass Trainingsprozesse zentral stattfinden, Entscheidungen jedoch in Echtzeit an den Endpunkten getroffen werden können.

Daniela Englbrecht ist Senior Consultant Multicloud Management bei Cancom