IT wird selbstständig

Autonomes Computing – Vor fünf Jahren veröffentlichte Dr. Paul Horn, Leiter der Forschungsabteilung bei IBM, das viel beachtete »Autonomic Computing Manifest«, laut dem IT-Systeme in der Lage sein sollten, sich selbst zu überwachen und zu verwalten, anstatt ständig von Administratoren überwacht werden zu müssen. Es stellt sich die Frage, ob die Branche seitdem in dieser Richtung Fortschritte gemacht hat.

Die IT-Infrastruktur in vielen Unternehmen nähert sich dem Punkt, an dem die Systeme dem reibungslosen Geschäftsablauf eher schaden als nützen und selbst die Wartung zum Albtraum wird. Die Integration immer komplexerer serviceorientierter Architekturen (SOA) und Anwendungen wie Voice-over-IP ist in den meisten Unternehmen längst die Norm. Deshalb muss die IT jetzt ausbaden, dass nach und nach zu viele Anwendungen installiert wurden – zumeist mit selbst gefertigten und undokumentierten Skripts. Das Ergebnis: unstrukturierte Verfahren, ein aufgeblasener Kostenapparat und eine unflexible Service-Delivery-Infrastruktur, die nicht gerade dazu beiträgt, die Kundenbindung zu verbessern.

Doch was wurde aus Paul Horns großer Vision vom Autonomen Computing (AC)? – Es sieht so aus, als wäre die IT-Branche in den letzten Jahren hauptsächlich mit Lippenbekenntnissen in Sachen Automation beschäftigt gewesen und hätte eher versucht, einzelne, kleine Probleme in den Griff zu bekommen, anstatt den steinigen Weg zu gehen, der nötig ist, um wirklich selbstheilende Systeme zu erschaffen.

Sollten die Unternehmen gewillt sein, den eingeschlagenen Kurs zu ändern, besteht Grund zur Hoffnung. Neben IBM haben auch CA,

HP, Microsoft und eine Reihe kleinerer Anbieter die Lösung der Automatisierungsfrage in Angriff genommen. Aber damit es mit AC auch in jedem Unternehmen klappt, müssen die Verantwortlichen zuerst folgende Punkte wirklich verstehen:

- Ihre IT-Infrastruktur,

- die Geschäftsziele ihres Unternehmens,

- die technischen Erfordernisse sowie

- die bereits existierenden Prozesse und Workflows.

Sich selbst zu kennen, verhilft Unternehmen zu enormen Kosteneinsparungen.

Natürlich kann man nicht ausschließlich die IT-Abteilungen dafür verantwortlich machen, dass sie zur »Feuerwehr« wurden, die erst dann eingreift, wenn es bereits brennt. Die zunehmenden Anforderungen, die auf die Unternehmen zukommen, zehren logischerweise an den Budgets und an den technischen Möglichkeiten. Das betrifft übrigens Betriebe jeder Größenordnung. Zwar ist es nichts Neues, dass die Komplexität ständig ansteigt, aber die Geschwindigkeit, mit der es geschieht, hat in der letzten Zeit deutlich zugenommen. Dadurch wurde die Vorgehensweise, Prozesse manuell zu programmieren und einzupflegen, immer arbeitsaufwändiger und unpraktischer – oftmals wirkt sie wie eine anachronistische Selbsterhaltungsmaßnahme, eine Rechtfertigung der Existenz der IT-Abteilung.

Dabei ist die Zeit nicht auf IT-Seite: Kritische Dienste sind von einer funktionierenden Infrastruktur abhängig, was dazu führt, dass Ausfallzeiten in immer geringerem Maße geduldet werden können. Einige Unternehmen reagieren darauf, indem sie versuchen, ihr Prozess- und Servicemanagement zu verbessern, was sich am gesteigerten Interesse an ITIL (»IT Infrastructure Library«) zeigt. Hersteller nutzen das ITIL-Framework zur Entwicklung von automatisierten Prozessen, die das menschliche Eingreifen im Störfall-Management deutlich reduzieren sollen. Doch ITIL ist nur ein Teil der Lösung.

Die geeigneten Werkzeuge

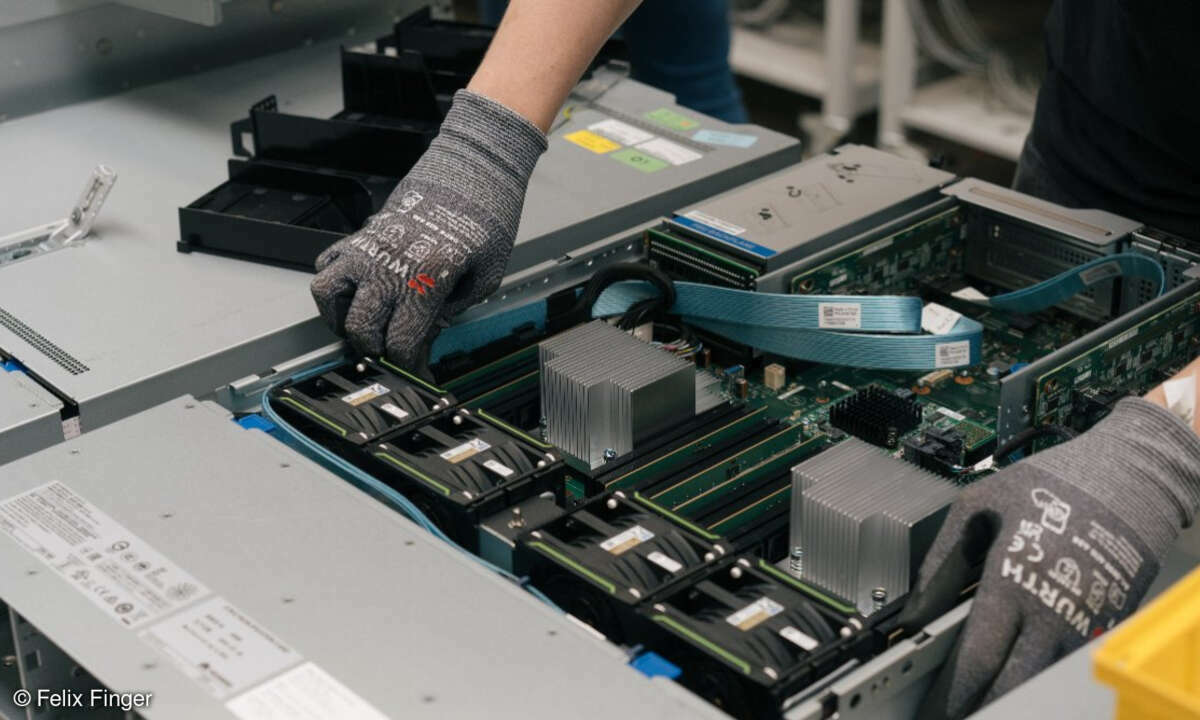

Die meisten Anbieter, die auf dem Markt für AC Fuß fassen wollen, haben große, extrem von der Technologie abhängige Betriebe im Auge, die sich im Normalfall irgendwo zwischen »Reaktiv« und »Initiativ« befinden. Diese Unternehmen haben bereits einiges in Netzwerk- und Anwendungsmanagement-Tools investiert, aber die IT-Abteilungen verlassen sich im Störfall, bei der Konfiguration und bei der Integration von Neuanschaffungen noch immer sehr stark auf Handarbeit.

Noch schlimmer ist, dass es oftmals Minuten oder sogar Stunden dauert, um festzustellen, inwiefern sich eine Veränderung auf den Kunden auswirkt, oder in welcher Reihenfolge Aufgaben nach den SLA oder den Anforderungen des Geschäfts abzuarbeiten sind. Für solche Unternehmen klingt AC eher nach Science-Fiction als nach etwas, das sie implementieren könnten.

Das stimmt aber nicht. Speziell zur Problemlösung hat IBM das »Autonomic Computing Toolkit« entwickelt, außerdem ist man dabei, die komplette Produktpalette mit Möglichkeiten zur Automation auszustatten. CA und HP sind IBM dicht auf den Fersen. HPs »Adaptive Enterprise« errichtet IT-Infrastrukturen, die sich schneller, flexibler und kosteneffizienter an Änderungen der Geschäftsanforderungen anpassen, als es heutige IT-Systeme erlauben. Dabei liegt das Hauptaugenmerk auf der Integration von Web-Services und der Interaktion mit anderen, im Unternehmen verteilten HP-Produkten. Das »Unicenter Enterprise Job Management« von CA ermöglicht es, vorhandene IT-Ressourcen voll auszuschöpfen und dabei effizient auf laufende Veränderungen im Geschäftsumfeld einzugehen. Microsoft Dynamics – eine ganze Reihe von Unternehmensanwendungen – erleichtert Unternehmen die Entscheidungsfindung basierend auf Systemdaten.

Für Firmen, denen diese Lösungen im Moment noch als zu mächtig erscheinen, haben sich in den letzten beiden Jahren neue Möglichkeiten eröffnet. Kleinere Anbieter sind mit Lösungen auf den Markt gekommen, die sich speziell an KMU wenden. Produkte von iConclude, Opalis und Realops bieten viele Funktionen zur Problembeseitigung und zur Optimierung von Netzwerk- und Sicherheitsmanagement.

Alle der vorgestellten großen Lösungen haben eines gemeinsam: Sie schaffen ein nahtloses, integriertes IT-Umfeld, um Daten problemlos unternehmensweit austauschen zu können. Auch die kleineren Anwendungen ähneln sich einander sehr. Sie dienen der Problembeseitigung, deshalb sitzen sie für gewöhnlich zwischen der Monitoring-Software und der Infrastruktur. Sie bauen alle auf bereits angeschafften Monitoring-Tools und Service-Desk-Anwendungen auf. Deshalb sind sie für Unternehmen der Stufe »Reaktiv« auch nicht besonders hilfreich.

Verbesserte Planungssicherheit

Nachdem die IT-Abteilung den gewünschten Workflow definiert hat, führen die Anwendungen die Verfahren für die diversen Ereignisse durch. Die IT wird dann entweder automatisch oder durch einen optisch geleiteten Prozess alarmiert. Die Verfahren beinhalten eine Alarm-Eingangsbestätigung, das Ausstellen von Fehlerberichten, die Durchführung spezieller, vordefinierter Routineüberprüfungen, Reparaturmaßnahmen und eventuell Abschlussberichte und System-Klar-Meldungen.

Korrekt eingerichtet sparen diese Anwendungen Kosten für das Wartungspersonal, reduzieren die Fehlerhäufigkeit und beschleunigen die Prozessabläufe. Noch wichtiger aber ist: Sie verbessern die Weitsicht und die Planungssicherheit des gesamten Unternehmens. Beispielsweise erhalten Führungskräfte mit einem vollständig benutzerdefinierten Dashboard einen transparenten Echtzeit-Zugang zu den IT-Dienstleistungen. Dies versorgt sie mit einem breiten Spektrum an Informationen und bietet ihnen Einblick in den Zustand der IT. Und da Dashboards intuitiv und interaktiv sind, können die Führungskräfte leicht und schnell zu den notwendigen Informationen aus der Analyse der Grundursachen und Auswirkungen vordringen.

In den kommenden Jahren ist ein enormer Innovations- und Konsolidierungsschub auf dem AC-Sektor zu erwarten, denn die großen, an Automation interessierten Softwarefirmen, schicken sich an, die innovativen, kleineren Firmen aufzukaufen. Eines ist nämlich sicher: Automation wird zu einem bestimmenden Thema in der gesamten Industrie werden. Die Vision ist tief fundiert und wenn sie in die Praxis umgesetzt wird, hat sie dramatische Auswirkungen auf IT-Abteilungen und gesamte Unternehmen. Schließlich führt sie dazu, dass sich Mitarbeiter wieder auf ihr jeweiliges Aufgabengebiet konzentrieren können, anstatt sich um die wachsenden Kosten kümmern zu müssen, die durch die steigende Komplexität der Systeme entstehen.

Es ist gut und schön, arbeitsintensive Prozesse zu automatisieren, aber die Unternehmen werden keinen wirklichen und langfristigen Nutzen erzielen, wenn dahinter ineffiziente oder überhaupt nicht funktionierende Service-Abläufe liegen. Eine erfolgreiche Automationsstrategie umfasst nicht nur die technischen Aspekte der Infrastruktur, sondern auch die operativen Abläufe, die befolgt werden müssen, insbesondere bei Hardwareaustausch, neuen Konfigurationen und Störfällen. In den Unternehmen müssen diese Abläufe und Workflows mit der Automation in Einklang gebracht werden. Um das zu verwirklichen, ist es unbedingt nötig, dass die IT-Abteilung ein Verständnis für das Geschäft als Ganzes und seine Erfordernisse entwickelt.

Für die Auswahl der passenden Software kann die Beantwortung der folgenden Fragen hilfreich sein:

- Ist mein Unternehmen dafür schon bereit? Haben wir die zugrundeliegenden Applikationen um unsere Prozesse zu automatisieren, oder gibt es noch Lücken, die wir zuerst schließen sollten, zum Beispiel im Performance- oder Konfigurationsmanagement? Diese Frage sollte zuerst im Mittelpunkt stehen, bevor die plattformübergreifenden Integration und die Problemlösung in den Fokus rücken.

- Was für ein Interface bietet die Software? Die IT-Mitarbeiter sollen keine komplizierte Programmiersprache lernen müssen, um Prozesse entwickeln oder ändern zu können. Wenn die Bedienoberfläche keine einfache Möglichkeit bietet, um Workflows zu erstellen und zu modifizieren, wird zwangsläufig die Produktivität darunter leiden.

- Welche vorgefertigten Anschlüsse für die Anwendungen gibt es? Hilfreich ist eine Checkliste mit sämtlichen Anwendungen, die miteinander kommunizieren müssen. Wichtig ist auch, dass die neue Komponente über vorgefertigte Anschlüsse verfügt. Sollte ein Anschluss nicht verfügbar sein, besteht die Möglichkeit, dass der Anbieter sie entwickelt.

- Besteht die notwendige Kontrolle über sämtliche Anwendungen, die angeschlossen werden sollen? Oft genug haben sich Unternehmen zu einer Ansammlung verteilter Silos entwickelt. Was passiert, wenn die Abteilung, die die Service-Desk-Anwendung kontrolliert, einen Anschluss an die Automationssoftware verweigert?

- Ist die Automationssoftware skalierbar? Der Anbieter sollte demonstrieren, inwieweit das Produkt sowohl das Volumen, als auch die Prozesse betreffend, anpassungsfähig ist. Lässt es sich mit einer Vielzahl verschiedener Anwendungen verbinden? Falls die Daten in einem dezentralen Datencenter gehalten werden, kommt die Software mit mehreren Centern und dezentralen Anwendungen zurecht?

- Sind viele vorgefertigte Abläufe zur Problemlösung inbegriffen? Das ist zwar für den Anfang sehr gut, doch wie aufwändig ist es, diese Prozesse an die speziellen Bedürfnisse anzupassen? In welchem Umfang bietet der Hersteller Support für den Fall der nachträglichen Anpassung?

- Besteht die Automation schon im Haus, ohne dass die Verantwortlichen dies wissen? Mittlerweile verfügen viele Anwendungen für das Netzwerkmanagement über Workflow-Engines mit vorgefertigten Anschlüssen. Statt in neue Software zu investieren, können Unternehmen eventuell ein bereits vorhandenes Produkt erweitern und so ihren eigenen Workflow entwickeln. Sie werden die Ergebnisse sofort bemerken.

Im Endeffekt kommt es darauf an, dass IT-Entscheider darauf achten müssen, nicht noch weiter in den Sumpf zu geraten. Sie sollten sich vor Augen führen, dass das Ziel der Automatisierung ist, die Komplexität zu reduzieren und nicht, sie zu vergrößern, indem ihre Mannschaft neue Programmiersprachen und die Bedienung komplizierter Geräte lernen muss oder indem zu Routineaufgaben neue, mühsame Schritte hinzugefügt werden.

info@hermannbreuer.com