Planvoll zum optimierten Prozess

Virtualisierung gilt zurecht als Schlüsseltechnik zur Flexibilisierung der Architektur in Rechenzentren sowie zu nachhaltiger Senkung der Kosten und des Energieverbrauchs. Wie die Erfahrung aus Kundenprojekten zeigt, gehen mit enormen Chancen allerdings auch beträchtliche Risiken einher. Wenn ein Unternehmen Virtualisierung isoliert betrachtet oder als rein technische Herausforderung missversteht, drohen negative Effekte die Kosten- und Flexibilitätsvorteile zu beeinträchtigen oder vollständig zu kompensieren.

Der Erfolg der Servervirtualisierung hängt entscheidend vom richtigen Vorgehen ab. Notwendig ist

vor allem, die vorhandene Architektur einschließlich der Betriebskonzepte im Lichte der

Geschäftsprozesse eingehend zu analysieren und aus den gewonnenen Erkenntnissen eine individuelle

Virtualisierungsstrategie abzuleiten.

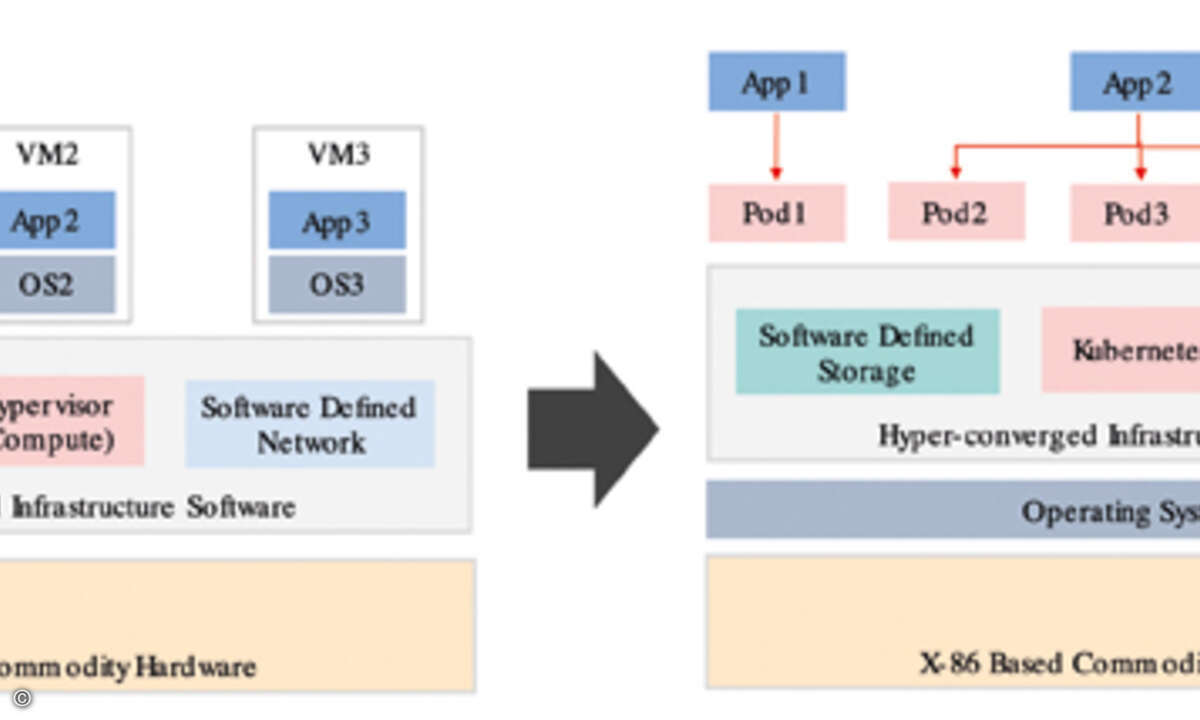

Zahlreiche Virtualisierungs-Tools am Markt erhältlich

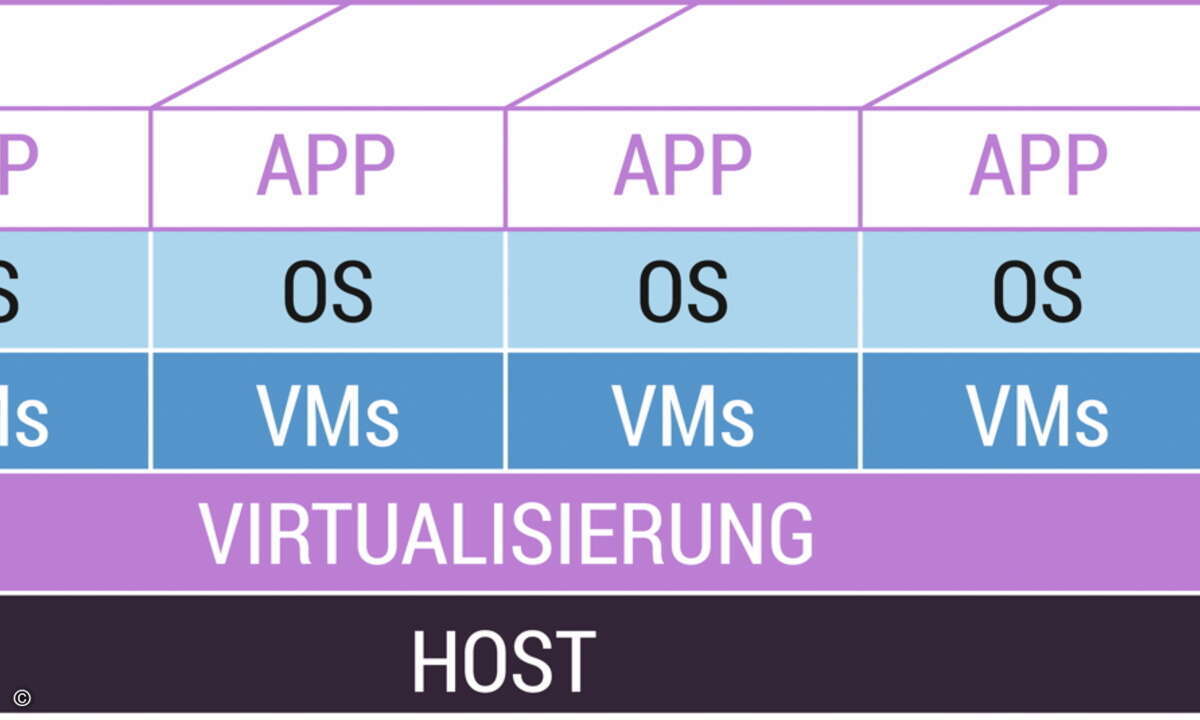

An erprobten Tools zur Servervirtualisierung für unterschiedlichste Architekturvoraussetzungen

und Anwendungsszenarien herrscht längst kein Mangel mehr. Allen Lösungen gemeinsam ist die

Entkopplung der Applikationsschicht von der physischen Serverinfrastruktur. Dieser logische

Abstraktionsschritt ermöglicht den Rechenzentren die Konsolidierung ganzer Serverfarmen auf wenigen

Systeme.

Moderne Mehrkernprozessorsysteme können pro Core dann durchaus acht bis zwölf Server ersetzen –

wobei diese Zahl im Einzelfall stark vom konkreten Einsatzgebiet abhängig ist: Bei Webservern zum

Beispiel liegt sie meist um ein Vielfaches höher; bei Datenbankservern dagegen deutlich niedriger,

oft nur bei fünf und darunter.

Generell gilt: Je größer der Konsolidierungsfaktor, desto größer sind die potenziellen

Kosteneinsparungen und damit auch der Anreiz für Rechenzentren, die Servervirtualisierung in

Angriff zu nehmen. Weder Implementierung noch Betrieb vieler am Markt verfügbarer Lösungen werfen

heute unüberwindliche Hürden auf – und genau darin liegt eine nicht zu unterschätzende Gefahr:

Erscheint die Technik einfach und bringt sie schnell sichtbare Vorteile, zum Beispiel signifikant

verringerte Energie- und Administrationskosten, so ist die Verlockung groß, langfristige

Implikationen außer Acht zu lassen.

Später jedoch müssen kurzfristig erzielte Effekte unter Umständen doppelt und dreifach

zurückgezahlt werden. Einem Kunden von Computacenter "gelang" es zum Beispiel, allein durch die

Virtualisierung seiner Windows-Systeme innerhalb nur einer Woche rund 280 Server freizusetzen – ein

allerdings nur scheinbarer Erfolg. Denn anderthalb Jahre später liefen die ausrangierten Rechner

fast ohne Ausnahme wieder in der Test- und Produktionsumgebung. Zweifellos ist dies ein

Extrembeispiel – aber eines, das zeigt, wie Ziele verfehlt werden, wenn es keine definierten

Vorgaben und keine fundierte Migrationsstrategie gibt.

Virtualisierung braucht einen klaren Fahrplan

Am Beginn jedes Projekts sollte daher eine genaue Analyse der vorhandenen Serverinfrastruktur

stehen. Relevant sind in diesem Kontext auch alle unterstützten Geschäftsprozesse und eingespielten

Betriebskonzepte.

Zwei Hauptfragen sind im Anschluss zu klären: Erstens wo und in welchem Ausmaß ist welche Art

von Servervirtualisierung möglich und sinnvoll? Und zweitens, welche Ziele sollen damit konkret

umgesetzt werden?

Zur Beantwortung der ersten Frage sind im Wesentlichen vier Auslastungsparameter zu betrachten:

CPU, Hauptspeicher, I/O zu Speichersystemen und die Netzwerk-Links. Bei einer 80-prozentigen

CPU-Auslastung würde die Virtualisierung als reine Konsolidierungsmaßnahme zur Kostenersparnis den

Aufwand für Implementierung und Umstellung kaum rechtfertigen.

Will ein Unternehmen jedoch – und hier kommt die zweite Frage nach den konkreten Zielen ins

Spiel – den Hardwareaustausch während des laufenden Anwendungsbetriebs ermöglichen und dadurch eine

höhere Flexibilität erreichen, dann kann Virtualisierung trotz guter CPU-Auslastung sinnvoll und

sogar notwendig sein.

Auch für die Anzahl virtueller Serverinstanzen lässt sich keine pauschale Empfehlung geben: Hier

gelten vereinbarte Servicegarantien (Service Level Agreements, SLAs) als Randbedingung für die

Optimierung der Balance zwischen effektiver Ressourcennutzung und der erforderlichen Verfügbarkeit

für die in Rede stehenden Anwendungen.

So bieten zum Beispiel zwei Instanzen, also eine vollständige Redundanz, zwar hohe

Verfügbarkeit, der Auslastungsgrad von lediglich 50 Prozent aber dürfte viele IT-Verantwortliche

unbefriedigt lassen. Mit wachsender Instanzenzahl verbessert sich das Verhältnis zugunsten der

Auslastung – wobei es im Kontext der Verfügbarkeit zudem auf den möglichst schnellen Wiederanlauf

der virtualisierten Applikationen ankommt.

Blick über den Tellerrand ist gefordert

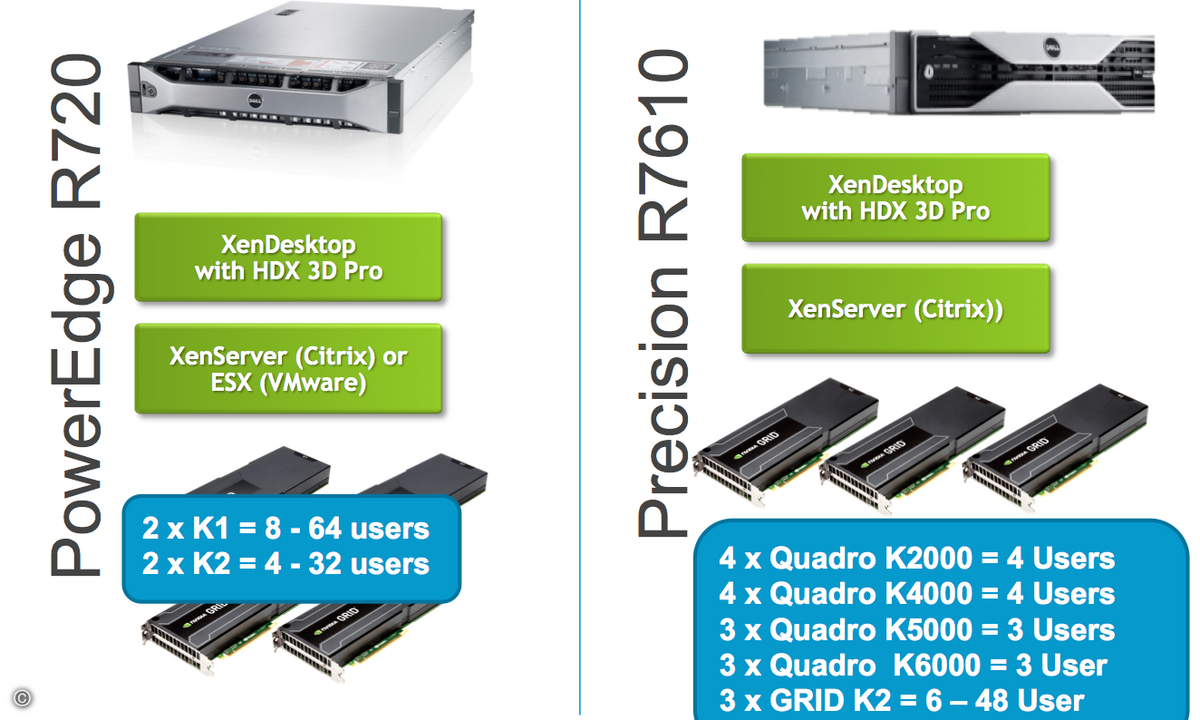

Zu beachten ist, dass Virtualisierung nicht ohne Verluste ist: Auch bei hardwarenaher

Implementierung bleibt die Virtualisierungsschicht bis dato eine zwischengeschaltete Ebene und

bremst die Applikations-Performance je nach Lösung um fünf bis 15 Prozent. Dies mag für Web- und

E-Mail-Server von geringerer Bedeutung sein, für SAP-Anwendungen indessen kann Performance-Verlust

projektkritisch sein. Denn hier steht die Akzeptanz der Nutzer direkt auf dem Spiel.

Eines der zugkräftigsten Argumente für die Servervirtualisierung ist die Vereinfachung der

Gesamtarchitektur im Rechenzentrum. Nur stellt sich dieser Effekt eben keineswegs von allein ein.

Bei der Planung gilt es, sämtliche Umgebungsprozesse einzubeziehen, allen voran das

Backup-/Recovery- beziehungsweise Disaster-Recovery-Regime: Wurden Daten vor der Virtualisierung

beispielsweise applikationsbezogen gesichert, sprach das Verfahren naturgemäß physische Geräte an –

die nach vollzogener Virtualisierung aber keinen festen Bezug mehr zur betroffenen Applikation

haben.

Verallgemeinernd lässt sich sagen: Servervirtualisierung erfordert umfassende Prozessanpassungen

bei der Datensicherung, dem Monitoring, der Steuerung und im organisatorischen Bereich.

Insbesondere ist es erforderlich, starre Genehmigungsprozeduren soweit zu flexibilisieren, dass sie

mit dem gestiegenen Implementierungstempo der virtualisierten Serverumgebung Schritt halten können.

Sonst droht – wie in obigem Beispiel – Wildwuchs, und die Komplexität wächst, statt abzunehmen.

Neu zu durchdenken ist nicht zuletzt auch die Leistungsverrechnung gegenüber den internen und

externen Kunden des Rechenzentrums. War die Preisbildung bisher maschinenorientiert, zum Beispiel

an anteiliger CPU-Nutzung ausgerichtet, muss der RZ-Betreiber oder Service-Provider hier neue,

sozusagen virtualisierte Abrechnungsmodelle finden.

Virtualisierung bietet auch Chance zur Prozessoptimierung

Generell bietet Servervirtualisierung eine gute Gelegenheit, nicht nur die Rechnerarchitektur,

sondern das Prozessgefüge insgesamt einer Generalrevision zu unterziehen. Selbst wenn die

IT-Abteilung dabei Anwendungen identifiziert, die sich nicht für eine Virtualisierung eignen, zum

Beispiel hardwarenahe Faxserver, so zeigt die Durchleuchtung des Ist-Zustands doch meist für sich

schon erhebliches Optimierungspotenzial auf.

Schließlich stellt sich noch die Frage, ob eine Anwendung eins zu eins virtualisiert werden

soll, oder ob im Zuge der Virtualisierung eine Versionsaktualisierung angeraten ist. Viele

Unternehmen nutzen Imaging, um alte Warenwirtschaftssysteme, die längst im Ruhestand sind, im neuen

Umfeld zu konservieren – ohne die veraltete Hardware weiterbetreiben zu müssen. Denn reine

Datenarchivierung genügt für manche Aufbewahrungspflichten nicht. Man braucht die alte Software, um

die archivierten Informationen wieder zu Tage zu fördern.

Fazit: Virtualisierung erfordert klare Projektplanung

Der Weg in Richtung Servervirtualisierung beginnt mit einer detaillierten Bestandsaufnahme der

Infrastruktur und ihres Betriebskonzepts. Zunächst geht es nicht um neue Techniken und schon gar

nicht um bestimmte Lösungen, sondern um Geschäftsprozesse.

Denn diese Geschäftsprozesse geben den Maßstab für eine klare Zieldefinition vor. Bei der

Projektplanung sind dabei neben der Serverinfrastruktur selbst auch alle angrenzenden Bereiche

relevant, darunter Backup und Disaster Recovery, die Leistungsverrechnung sowie

Genehmigungsverfahren. Nur dies ermöglicht eine realistische Abschätzung von TCO (Total Cost of

Ownership, also Gesamtbetriebskosten) und ROI (Return on Investment, also Investitionsrendite). Und

nur so bringt Servervirtualisierung die erhofften Effekte: mehr Flexibilität im Wettbewerb, höhere

Verfügbarkeit und nachhaltig sinkende Kosten.