Vier Anforderungen an Storage für unstrukturierte Daten

Immer mehr Daten werden immer schneller generiert. Dabei ist ein großer Teil der Daten unstrukturiert. Dell Technologies erläutert, welche vier Anforderungen Storage-Systeme erfüllen sollen, um mit den wachsenden Mengen unstrukturierter Daten zurechtzukommen.

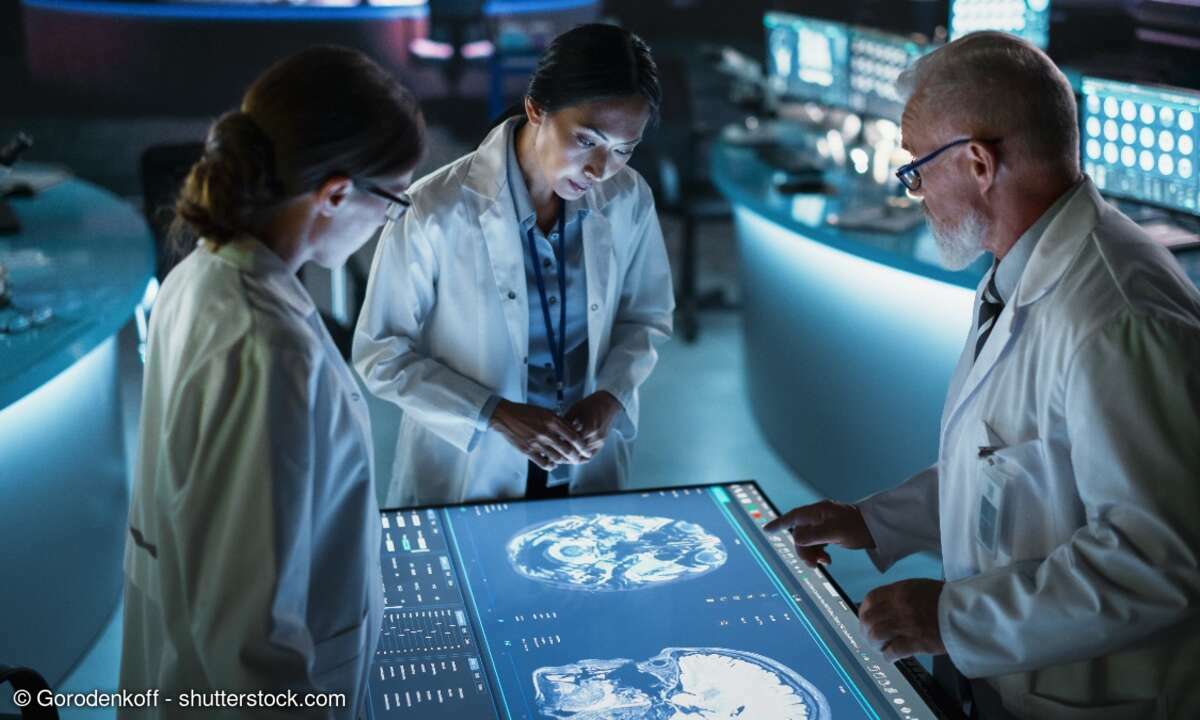

Unstrukturierte Daten sind Informationen, die sich nicht in Tabellen oder Datenbanken pressen lassen – seien es Daten von Sensoren aus der vernetzten Produktion oder hochaufgelöste Bilder und Videos aus der Medizin und Videoüberwachung. Aber auch Forschungsdaten, E-Mails, Audio-Files und die vielen Dokumente, die Büroangestellte in ihrem digitalen Arbeitsalltag erstellen, zählen dazu. Die Menge solcher Daten wächst rasant, und zwar viel schneller als die der strukturierten Daten, wodurch die Anforderungen an file- und objektbasierte Storage-Systeme stetig steigen. Zu diesen Anforderungen zählen:

- Hohe Skalierbarkeit: Einzelne Storage-Systeme sind für die große Flut an unstrukturierten Daten, die Unternehmen auffangen und speichern müssen, in der Regel ungeeignet. Schließlich sollen alle Informationen zumeist in einem Data Lake zusammengeführt werden, um durch Analysen Erkenntnisse aus ihnen zu ziehen, die bei der Automatisierung von Prozessen oder der Entwicklung neuer Produkte, Services und Geschäftsmodelle helfen. Dabei handelt es sich schnell um Arbeit im Petabyte-Bereich, sodass die Storage-Systeme und -Plattformen sich gut skalieren lassen müssen. Sind die Daten über mehrere Einzelsysteme verteilt, fällt es Unternehmen schwerer, Zusammenhänge zu erkennen und tatsächlich einen Nutzen aus ihnen zu ziehen.

- Hohe Performance: Durch die aktive Arbeit mit Informationen steigen die Performance-Anforderungen an die Storage-Systeme. Sie müssen große Datenmengen schnell bereitstellen – oft mit sehr niedriger Latenz. Vor allem bei Echtzeitanalysen sind die garantiert kurzen Antwortzeiten entscheidend, weil schon kleinste Verzögerungen beispielsweise eine Fertigung aus dem Tritt bringen und zu Produktionsausfällen führen können. Aber auch nicht zeitkritische Analysen haben oft überraschend hohe Performance-Anforderungen, weil die Datenmengen so umfangreich sind und das Laden mehrerer Gigabyte keine langen Wartezeiten verursachen soll. Manche Storage-Systeme setzen deshalb oft auf einen Mix aus Flash-Speichern und Festplatten, um jede Anwendung mit der gewünschten Performance zu bedienen und zugleich eine hohe Kosteneffizienz zu erreichen.

- Breite Protokollunterstützung: Offene Schnittstellen und eine breite Protokollunterstützung über SMB und NFS hinaus erleichtern es, Informationen aus mehreren Quellen in einem Data Lake zu vereinen und für verschiedene Anwendungen bereitzustellen. Unterstützen Storage-Systeme die spezifischen Protokolle nicht, nach denen eine Anwendung verlangt, ist es notwendig, die Daten auf anderen Systemen vorzuhalten, was die Speicherkosten und den Administrationsaufwand erhöht. Zudem kann die redundante Datenhaltung schnell zu einem inkonsistenten Datenbestand führen. Mit Storage-Systemen, die Protokolle und Schnittstellen für viele Anwendungsfälle unterstützen, bleiben Unternehmen flexibel und tun sich auch mit der Cloud-Anbindung leicht. So können sie Informationen bei spezialisierten Cloud-Services auswerten, außer Haus sichern oder bei begrenzten On-Premises-Kapazitäten auslagern.

- Intelligenz: Storage-Systeme sollten keine simplen Datenlager sein, sondern benötigen Intelligenz, um die Nutzung der Daten zu analysieren und sie vorausschauend auf die Speicherklassen zu verschieben, die die Anforderungen des jeweiligen Anwendungsfalls am besten erfüllen. Darüber hinaus verteilen smarte Funktionen die Daten über die Nodes in einem Cluster und helfen, Kapazitäts- und Leistungsengpässe frühzeitig zu erkennen und zu beseitigen. Sie überwachen alle Komponenten in den Storage-Systemen und warnen, wenn beispielsweise ein Laufwerk auszufallen droht, sodass Unternehmen es rechtzeitig austauschen und Downtimes verhindern können.

„Rund 80 Prozent aller Daten sind inzwischen unstrukturiert – Tendenz steigend. Mit ein paar File-Servern können Unternehmen diese Flut nicht auffangen und sinnvoll nutzen“, sagt Dennis Scheutzel, Director Germany Unstructured Data Solutions and Analytics bei Dell Technologies. „Sie benötigen moderne Speichersysteme, die mit den steigenden Datenmengen mitwachsen, Daten nicht in Silos einsperren und die hohen Performance-Anforderungen von KI- und Analytics-Anwendungen erfüllen.“