Zurück zum Zentrum

Auf den PCs der Unternehmen hat sich über die Jahre ein Software-Wildwuchs ausgebreitet. Die Virtualisierung der Clients hilft, diesen nicht nur einzudämmen, sondern nachhaltig zu stutzen. Darüber hinaus sind den Unternehmen, gerade in der Wirtschaftskrise, die per Client-Virtualisierung realisierbaren Kosteneinsparungen hoch willkommen.

Die Studie »Ökologischer Vergleich der Klimarelevanz von PCs und Thin Client-Arbeitsplatzgeräten 2008« des Fraunhofer Instituts für Umwelt-, Sicherheit- und Energietechnik bringt die Kosteneinsparungen auf den Punkt. Mit Programmen überladene PCs, umständlich von der Zentrale aus gemanagt, kosten im Schnitt und Jahr 2400 Euro. Für virtualisierte Thin-Clients, deren ausgesuchte Programme zentral auf einem Server gehalten werden, fallen hingegen nur rund 1700 Euro pro Jahr an. Für die Beispielrechnung hat das Institut eine Installation mit 175 Clients herangezogen. Als Kostenfaktoren wurden die Beschaffung, der Betrieb und die Entsorgung bemessen. Die mit dem Software-Wildwuchs auf den Fat-Clients einhergehenden Handlings-, Verfügbarkeits- und Sicherheitsrisiken mit ihren Ausfall- und Kostenfolgen blieben bei dieser Studie unberücksichtigt.

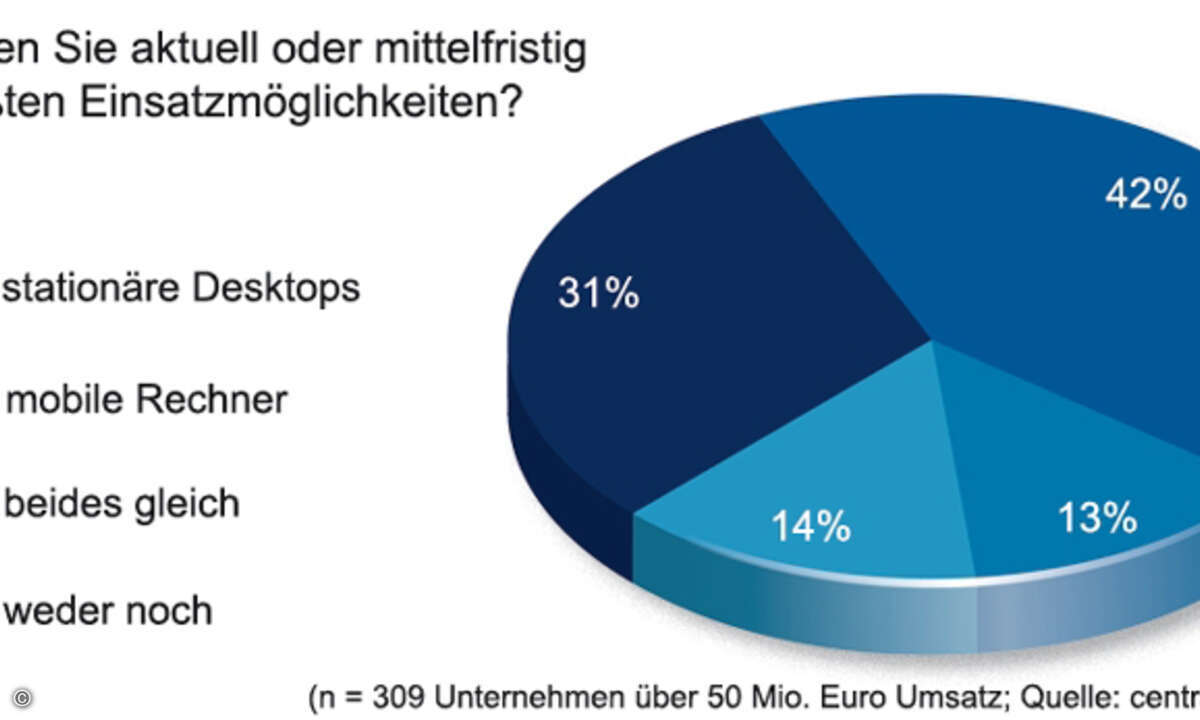

So wundert es nicht, dass mittlerweile Markt- und Technologiekenner nicht etwa der Server- und Speicher-Virtualisierung, sondern der Client-Virtualisierung in den Unternehmen die größten Chancen einräumen. Die Krisenstimmung in den Unternehmen, hervorgerufen durch widrige Marktrahmenbedingungen und -aussichten, spielt die Verlagerung der Desktops in Form virtueller Maschinen auf den Servern zusätzlich in die Hände. So entsteht eine Virtuelle-Desktop-Infrastruktur (VDI). Sie ist für die Unternehmen erheblich leichter und kostensparender als eine Infrastruktur mit abgesetzten, sperrigen Fat-Clients zu handhaben. Über eine solche VDI werden das PC-Betriebssystem und die PC-Hardware entkoppelt. Besonders lohnend ist die VDI, wenn die Neuanschaffung von PCs ansteht.

Diese Investitionen kann sich das Unternehmen sparen. Denn mit der Zentralisierung von Betriebssystemen und Programmen können die »alten« Geräte problemlos weiter Dienst tun.

Um die hochgesteckten Ziele zu erreichen sollte das Unternehmen bei der Auswahl der geeigneten Client-Virtualisierungslösung einige Regeln beherzigen. Um die Hardware-, Software-, Rechenzentrums- und Verwaltungsressourcen hocheffizient ausschöpfen zu können, sollte das System isolierte Container auf einer physischen Server- und Betriebssysteminstanz erstellen. Es muss außerdem die nativen Hard- und Software-Treiber uneingeschränkt nutzen können. Als Betriebssystem-Versionen sollten nicht nur Windows, sondern auch Linux unter einheitlicher Administrationsoberfläche unterstützt werden.

Zu den unterstützten Hardware-Plattformen sollten demzufolge Itanium, x86, x64, EM64T und AMD64 zählen.

Die Verteilung von Betriebssystem-Code und -Ressourcen, aber auch die Aktualisierung und Wartung, sollten über virtuelle Umgebungen hinweg möglich sein. Eine Client-eigene Betriebssysteminstanz mit Links und Caches muss die schnelle Bereitstellung virtueller Umgebungen und anderer Operationen sicherstellen. Gemeint sind Operationen wie Erstellung, Neustart, Update, Anpassung, Datensicherung/-Wiederherstellung, Migration und Klonen. Diese Operationen sollten zudem parallel ausführbar sein. Nicht nur das Client-Betriebssystem, sondern auch die Client-Applikationen sollten als separate Instanzen auf dem Server einsetzbar sein. Sehr detaillierte Ressourcen-Parameter virtueller Umgebungen müssen in annähernd Echtzeit änderbar sein. Ganz wichtig, auch für die Zukunft: Die integrierten Verwaltungs-Tools sollten mit Standard-Integrationstechniken wie SOAP, XML-RPC, CLI und SNMP-APIs sowie SDK, LDAP aufwarten. Ebenfalls sehr wichtig für Live-Einsätze in Großunternehmen mit Tausenden virtueller Clients auf Hunderten physikalischer Server: Das Virtualisierungsprodukt der Wahl muss »mitspielen«. Das gilt für das gesamte Operations-Spektrum, einschließlich Konvertierung, Bereitstellung, Überwachung, Datensicherung, Wiederherstellung, Analyse, Trouble-Shooting, Reparatur, Datenmigrationen und Selbstverwaltung.

Die Entscheider können den Zugewinn an Datensicherheit, der mit der Auswahl der richtigen VDI-Lösung einhergeht, nicht hoch genug einschätzen. Über diese Infrastruktur werden lediglich die Tastatur- und Mausbefehle sowie die Bildschirminformationen übertragen. Geschäftskritische Daten können somit während der Übertragung und auf den Clients weder von internen noch von externen Angreifern abgegriffen, manipuliert oder zerstört werden. Der einzige Unsicherheitsfaktor, der bleibt, ist der Administrator in der Zentrale.

Seine Zugriffe auf Konfigurationen und gespeicherte Informationen sollten dementsprechend intelligent über Profile gesteuert, außerdem lückenlos überwacht, protokolliert und ausgewertet werden.

Dirk Martin ist geschäftsführender

Gesellschafter von PMCS

in Bad Camberg.