DeepSeek: Sicherheitsbedenken bei wachsender KI-Nutzung

Mit dem rasant wachsenden Einsatz von generativer KI wie DeepSeek sehen sich Unternehmen und Behörden neuen Risiken gegenübergestellt. Datenschutzverletzungen, unklare Governance und potenzielle Bedrohungsszenarien durch missbräuchliche Nutzung stehen dabei im Fokus aktueller Diskussionen.

Das chinesische KI-Startup DeepSeek hat die App-Charts im Sturm erobert. Seit Verfügbarkeit der App am 20. Januar verzeichnet diese allein in Googles Playstore mehr als 10 Millionen Downloads. Die App und ihre Herkunft werfen zahlreiche Fragen auf, beispielsweise nach dem Umfang, in dem die App Daten sammelt und die Betreiber diese missbrauchen. Wie bekannt wurde, wollen auch deutsche Datenschutzbehörden DeepSeek überprüfen. Laut dem rheinland-pfälzischen Datenbeauftragte Dieter Kugelmann scheint es „bei DeepSeek datenschutzrechtlich an so ziemlich allem zu fehlen.“ Das Bundesamt für Sicherheit in der Informationstechnik (BSI) hat hingegen zu DeepSeek noch keine abschließende Sicherheitsbewertung getroffen, wenngleich es betont, dass Chats mit der KI nicht als privat angesehen werden sollten. Demgegenüber hat die italienische Datenschutzbehörde gegen DeepSeeks Betreiberfirmen ein wirksames Datennutzungsverbot ausgesprochen. Die Behörde hat außerdem Ermittlungen aufgenommen.

Auch das Thema Cybersicherheit wird durch den vielfachen Einsatz von DeepSeek berührt. Für Unternehmen stellen sich Fragen rund um Datenschutz, Ethik, nationale Sicherheit und Datenlecks. Diese Fragen müssen in der Geschwindigkeit beantwortet werden, in der sich die KI-Technologie weiterentwickelt und verstärkt eingesetzt wird.

Unternehmen und Behörden in Deutschland befassen sich auf politischer und regulatorischer Ebene verstärkt mit KI, um sicherzustellen, dass GenAI und LLMs sicher eingesetzt werden können. Bereits im vergangenen Jahr hat die EU mit dem AI Act (Verordnung (EU) 2024/1689) den weltweit ersten umfassenden Rechtsrahmen für KI geschaffen. Ziel dieser Vorschriften ist es, eine vertrauenswürdige KI in Europa zu fördern. Die Verordnung ist am 1. August 2024 in Kraft getreten und wird zwei Jahre später, am 2. August 2026, mit einigen Ausnahmen vollständig anwendbar sein.

Anbieter zum Thema

In der Zwischenzeit wird von den Security-Teams der Unternehmen erwartet, dass sie ihre eigenen Sicherheitsvorkehrungen treffen. Für die Unternehmen ist KI zweifelsohne eine Herausforderung. So wurde GenAI im „Voice of the CISO Report 2024“ von Proofpoint als das am schnellsten wachsende Problemfeld identifiziert. In Deutschland sehen 54 Prozent der CISOs ChatGPT und andere GenAI-Tools als das größte technologische Risiko für ihr Unternehmen.

Die zunehmende Interaktion zwischen Mitarbeitern und GenAI, LLMs und anderen fortschrittlichen Anwendungen erfordert eine flexible, auf den Menschen ausgerichtete und hochgradig maßgeschneiderte Cybersicherheitsreaktion. Leider stellen die meisten Anwender, die Produktivitätssteigerungen mit Hilfe von GenAI-Tools anstreben, Geschäfts- und Cyberrisiken hinten an. Dabei erfordern diese von den Unternehmen eine Umstellung von alten inhaltszentrierten DLP-Produkten (Data Loss Prevention) auf verhaltens- und menschenzentrierte Plattformen, die Unternehmen vor unvorsichtigen, böswilligen und kompromittierten Nutzern auf allen Kommunikationskanälen und Plattformen wie E-Mail, Endgeräten und Cloud schützen können.

KI am Arbeitsplatz: die Risiken

Datenschutz

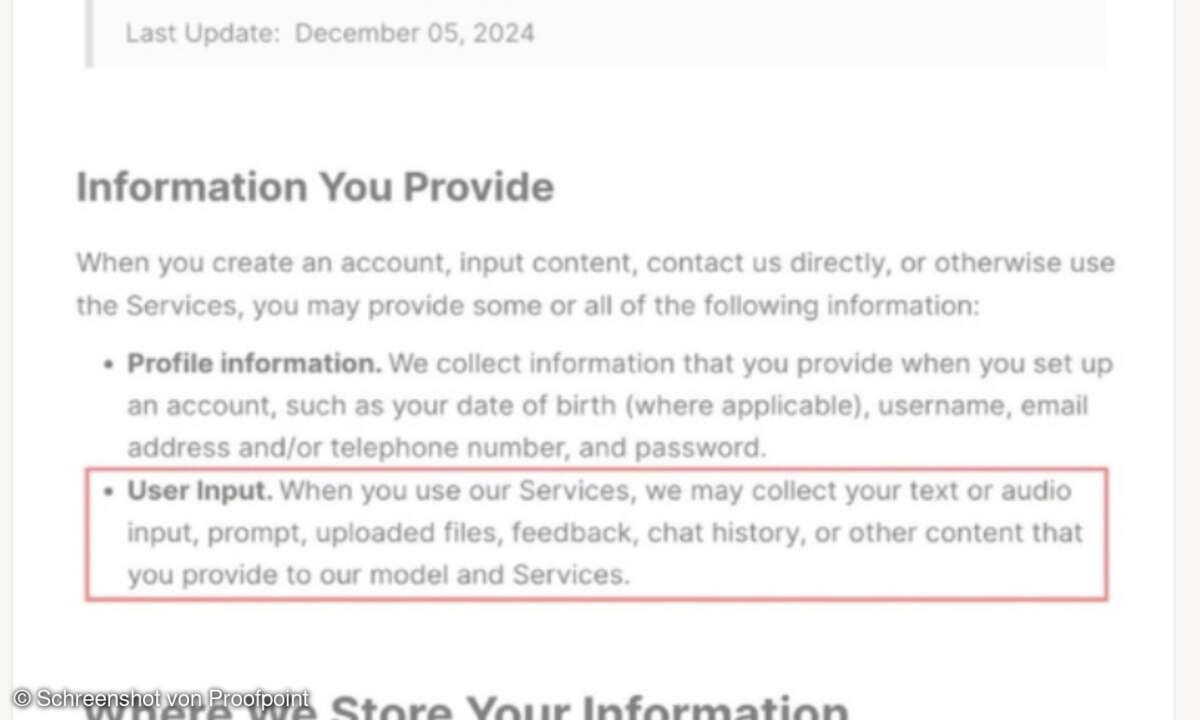

Der mit Abstand besorgniserregendste Bereich beim Einsatz von KI am Arbeitsplatz ist der Datenschutz und der Schutz der Privatsphäre, insbesondere wenn es um LLMs geht. Tools wie DeepSeek und ChatGPT erfordern die Eingabe von Daten durch den Benutzer. Dabei kann es sich um eine Frage oder eine Aufforderung handeln, die dann als Rohdaten verarbeitet werden. Das Sprachmodell analysiert diese Daten mithilfe von Techniken wie Natural Language Processing (NLP) und semantischer Analyse, bevor es eine geeignete Antwort liefert.

Da es den Benutzern freisteht, Text in die DeepSeek-Eingabemaske zu kopieren, und Prompt Splitter sogar noch größere Eingaben ermöglichen, ist das Potenzial für Datenverlust, Missbrauch und Offenlegung von Geheimnisssen enorm. Beispielsweise können Mitarbeiter eine E-Mail, die sie gerade verfassen und die für einen internen oder externen Empfänger bestimmt ist, kopieren und vor dem Versenden den Entwurf der E-Mail in GenAI-Tools kopieren, um deren Struktur, Grammatik und Tonfall zu verbessern. Wenn der Inhalt der E-Mail sensible Informationen wie personenbezogene Daten oder Finanzdaten des Unternehmens enthält, stellt dies ein großes Risiko dar. Bedenkt man zudem, dass Studenten diese Methoden und Werkzeuge heute schon täglich nutzen, werden diese irgendwann in den Unternehmen tätigen Arbeitskräfte die Risiken sowohl für den privaten als auch für den öffentlichen Sektor noch verstärken.

Governance und Regulierung

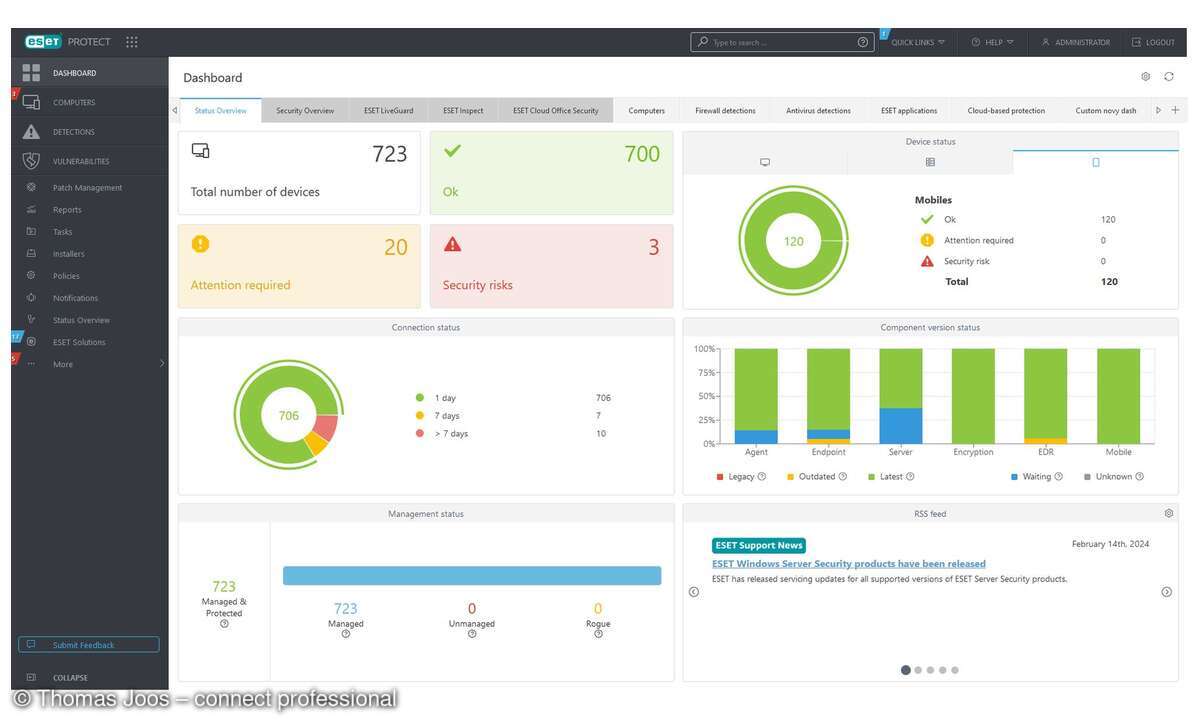

Derzeit wissen viele deutsche Organisationen nicht, wer in welchem Umfang GenAI-Technologien einsetzt. Dies macht es unmöglich, die Dateneingabe zu überwachen oder Richtlinien für ihre Verwendung festzulegen.

Dadurch erhöht sich nicht nur das Risiko von Datenverlusten, sondern es lässt die Unternehmen auch im Unklaren darüber, ob sie die KI-Vorschriften und Datenschutzgesetze einhalten. Die Europäische Union beschäftigt sich bereits seit längerem mit der Frage, inwieweit KI-Anwendungen wie ChatGPT und deren Entwicklerfirmen möglicherweise datenschutzrechtliche Bestimmungen verletzen. Mit einer Stellungnahme hat der Europäische Datenschutzausschuss im Dezember 2024 nun die Grundlage geschaffen, KI-Systeme im Einzelfall auf ihre Datenschutzkonformität zu überprüfen.

Doch nicht nur die Dateneingabe gibt Anlass zur Sorge. Auch der Output von GenAI ist potenziell problematisch. Wenn Mitarbeiter LLMs und andere KI-Tools verwenden, um Code oder Inhalte zu generieren, ist es unglaublich schwierig sicherzustellen, dass die Ergebnisse frei von Plagiaten, Schwachstellen und Ungenauigkeiten sind.

Bedrohungsvektoren

Leider kommt das enorme Potenzial der KI zur Effizienzsteigerung nicht nur wohlmeinenden Mitarbeitern zugute. Mithilfe von NLP- und LLM-Modellen können Cyberkriminelle ihre Angriffe mittels riesiger Datensätze wie Social-Media-Feeds und Chat-Protokollen trainieren, um die Personalisierung ihrer Angriffe auf die Spitze zu treiben und noch überzeugendere Köder zu entwickeln.

Solche Tools helfen Cyberkriminellen auch dabei, Indizien für ihren Betrugsversuch zu vermeiden, zum Beispiel falsche Übersetzungen oder Rechtschreib- und Grammatikfehler. Die Tatsache, dass viele Plattformen frei verfügbar sind, lässt auch traditionelle Hemmnisse wie fehlendes Kapital bzw. mangelnde Fähigkeiten obsolet werden. In der Folge kann jeder mit grundlegenden Computerkenntnissen und bösen Absichten einen ausgeklügelten Cyberangriff starten. Die Entwicklungen in diesem Bereich sind so bedeutsam, dass 61 Prozent der deutschen CISOs, die für den Voice of the CISO Report 2024 von Proofpoint befragt wurden, GenAI als Risiko für ihre Organisation bezeichneten.

Im Oktober 2024 bestätigte OpenAI, dass es mehr als 20 „betrügerische Operationen und Netzwerke auf der ganzen Welt“ verhindert habe, nachdem Proofpoint die ersten Anzeichen solcher Aktivitäten gemeldet hatte. Damit wurde erstmals offiziell bestätigt, dass gängige KI-Tools zur Verbesserung offensiver Cyberoperationen eingesetzt werden können.

Ein menschliches Problem braucht menschliche Lösungen

Wie die meisten großen technologischen Fortschritte ist auch die KI ein zweischneidiges Schwert. Während sie neue Risiken mit sich bringt und Cyberkriminellen bei ihren Kampagnen dient, verbessert sie auch die Fähigkeit, Abwehrmaßnahmen zu stärken und Angriffe zu vereiteln. Auch wenn neue Technologien den Bereich Datenverlust im Security-Umfeld verändern, bleiben Mitarbeiterinnen und Mitarbeiter der Dreh- und Angelpunkt. Es beginnt immer mit dem Wer, Warum und Wie.

Je besser Unternehmen verstehen, welche Nutzer mit KI interagieren, warum sie dies tun und wie sie die Technologie nutzen, desto einfacher können sie potenzielle Risiken minimieren. Ohne Kontext ist es nicht möglich, die Absicht zu erkennen und Beweise für Vorfälle und böswillige Insider zu sammeln. Wer sich mit letzterem auseinandersetzen muss, sollte über unwiderlegbare Beweise verfügen.

Unternehmen müssen einen mehrspurigen und mehrschichtigen Ansatz verfolgen, der Threat Intelligence, verhaltensbasierte KI, Erkennungstechnologien und semantische KI kombiniert, um fortschrittliche Bedrohungen und Datenverluste zu blockieren, zu erkennen und darauf zu reagieren. Dieser ganzheitliche Ansatz, bei dem der Mensch im Mittelpunkt steht, warnt vor Verhaltensweisen, die von herkömmlichen, rein inhaltsbasierten Systemen normalerweise nicht erkannt werden.

Schließlich sind Tools zwar wichtig, aber ohne die Sensibilisierung der Anwender und eine Änderung ihres Verhaltens sind sie wenig hilfreich. Es ist von entscheidender Bedeutung, dass die DLP-Richtlinien (Data Loss Prevention) von Unternehmen KI-Risiken berücksichtigen, klare Parameter für ihren Einsatz festlegen und regelmäßige Sicherheitsschulungen beinhalten, die auf die Schwachstellen, Rollen und Kompetenzen der Mitarbeiterinnen und Mitarbeiter zugeschnitten sind. Denn selbst die technologisch fortschrittlichsten Cyberrisiken der Welt können gegen geschulte, sicherheitsbewusste Mitarbeiter nicht bestehen.

Miro Mitrovic ist Area Vice President DACH bei Proofpoint.