KI-Security im Härtetest: Warum Unternehmen umdenken müssen

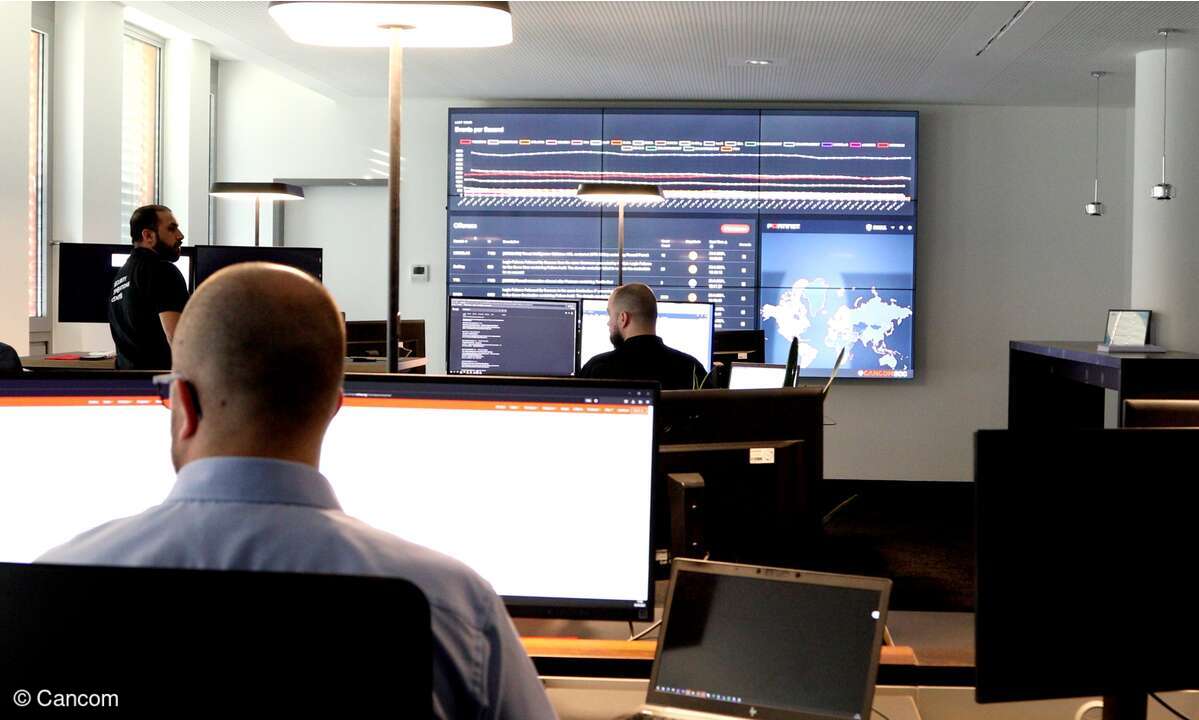

KI-Modelle sind fester Bestandteil moderner IT und ein attraktives Ziel für Angreifer. Warum Prompt Injection, Data Leakage und Shadow AI reale Risiken sind, weshalb klassische Security versagt und was Unternehmen jetzt tun müssen. Im Gespräch mit Cancoms RedTeam-Leader Joren Afman.

Large Language Models, Copiloten und proprietäre KI-Systeme werden in Unternehmen immer tiefer in Geschäftsprozesse integriert – häufig mit direktem Zugriff auf interne Dokumente, E-Mails oder Wissensdatenbanken. Genau darin sieht Joren Afman, Teamlead im Cancom RedTeam, eine zentrale Gefahr: „Viele Kunden haben LLMs wie OpenAI oder Microsoft Copilot direkt mit ihren internen Daten verbunden. Unsere Aufgabe ist es dann zu testen, ob wir Informationen herausziehen oder das Modell manipulieren können.“

Anbieter zum Thema

KI-Systeme unterscheiden sich dabei grundlegend von klassischen IT-Anwendungen. Sie sind nicht deterministisch, das heißt sie liefern bei gleichen Eingaben nicht dieselben Ausgabedaten, reagieren auf Sprache, Kontext und Logik – und eröffnen damit neue Angriffsflächen. Besonders häufig begegnen Red Teams aktuell Prompt Injections, Jailbreaking, Data Leakage, Model Extraction und Model Poisoning. Beim gezielten „Vergiften“ von Modellen werden falsche Informationen eingespeist, um Entscheidungen oder Ausgaben zu verfälschen; mit potenziell erheblichen Folgen für Unternehmen.

Angriffe sind oft leichter und eine Frage der Zeit

Eine zentrale Erkenntnis aus der Red-Team-Praxis: Absolute Sicherheit gibt es nicht. „Es ist nicht immer einfach, aber gewöhnlich ist es einfach – wir schaffen es immer“, sagt Afman offen. Selbst moderne Schutzmechanismen wie Guardrails oder LLM-Firewalls lassen sich umgehen, etwa durch Sprachwechsel, Zeichenersetzungen oder minimale Anpassungen von Prompts.

Entscheidend ist dabei weniger die technische Raffinesse als der Faktor Zeit. Haben Angreifer mehrere Tage oder Wochen zur Verfügung, steigt die Erfolgswahrscheinlichkeit drastisch. Besonders in APT-Szenarien oder bei staatlich geprägten Akteuren wird KI damit zu einem realistischen Einfallstor.

KI-Security erfordert ein neues Mindset

Während klassische Penetrationstests oft auf automatisierten Scans und bekannten Exploits basieren, ist KI-Red-Teaming grundlegend anders. „Wir müssen mit der KI reden, wir müssen sie überzeugen“, erklärt Afman. Es gehe darum herauszufinden, was ein Modell sagen darf und wie es dazu gebracht werden kann, genau diese Grenzen zu überschreiten.

Dieser dialogische, fast psychologische Ansatz verlangt von Security-Teams ein Umdenken. Sicherheitslücken entstehen nicht nur im Code, sondern auch in Trainingsdaten, System Prompts und der Art, wie KI in Prozesse eingebettet ist. „Es war auch für uns schwer, unser Mindset zu ändern“, räumt Afman ein.

Fehlende Security by Design und Supply-Chain-Risiken

In vielen Unternehmen ist KI-Security bislang kein integraler Bestandteil der Entwicklung. Funktionalität und Features stehen im Vordergrund, Absicherung folgt oft erst nach einem Vorfall. „Erst wird etwas gebaut, dann gibt es ein Problem. Das ist die Chicken-and-Egg-Problematik“, so Afman.

Besonders kritisch sind dabei Supply-Chain-Risiken. Trainingsdaten stammen häufig aus externen Quellen oder werden über mehrere Stationen verarbeitet. Werden sie manipuliert oder absichtlich verfälscht, kann das gesamte Modell kompromittiert werden – lange bevor es produktiv eingesetzt wird. KI-Security beginnt damit nicht beim Betrieb, sondern bereits bei der Datenherkunft.

Cloud, On-Prem und das Problem Shadow AI

Auch die Infrastruktur spielt eine entscheidende Rolle. Afman bezieht hier klar Position:

„Lokal ist immer lokal. Das ist das Sicherste.“

Modelle ohne Internetanbindung minimieren Abfluss- und Compliance-Risiken deutlich. Public-Cloud-Lösungen hingegen bringen zusätzliche regulatorische und technische Komplexität mit sich – insbesondere bei internationalen Anbietern.

Gleichzeitig kämpfen Unternehmen mit einem organisatorischen Problem: Shadow AI. Mitarbeitende nutzen KI-Tools außerhalb freigegebener Prozesse, unabhängig von Policies oder Sicherheitsvorgaben. „Der Mitarbeiter macht, was er macht“, sagt Afman nüchtern. Damit wird KI-Security auch zu einer Frage von Governance, Awareness und Unternehmenskultur.

Red Teaming: Der Realitätstest für KI-Sicherheit

Genau hier setzt Red Teaming an. Ziel ist es, reale Angriffe zu simulieren, Schwachstellen sichtbar zu machen und Unternehmen zu zeigen, was tatsächlich möglich ist. „Wir machen so viel wie möglich ‚kaputt ‘ oder klauen etwas – und erklären dann genau, wie wir das geschafft haben.“ Standardlösungen gebe es kaum, da jedes KI-System anders sei. Stattdessen liefern Red Teams individuelle Empfehlungen und helfen Unternehmen somit, Vertrauen in den sicheren Einsatz von KI aufzubauen.

Regulatorische Vorgaben wie der EU AI Act oder NIS2 erhöhen zwar den Druck, sind aber für viele Unternehmen laut Afman noch schwer greifbar. KI sei für viele – auch für Regulierer – weiterhin eine Blackbox. Langfristig rechnet er mit neuen Rollenbildern wie AI Security Engineer oder Model Red Teamer. Gleichzeitig mahnt er zur Vorsicht im Alltag: KI sei kein magisches System, sondern fehleranfällig. „Wenn man persönliche Dinge in eine KI eingibt, gibt es immer die Chance, dass etwas leakt. Aber mit klaren Sicherheitskonzepten, Zero-Trust-Ansätzen und geschulten Mitarbeitenden lässt sich das Risiko beherrschbar machen. Unternehmen sollten KI deshalb strukturiert und verantwortungsvoll einführen, klare Leitplanken und Governance definieren.“