Grüne Technik spart Kosten

Grüne Technik spart Kosten Rechenzentren müssen umweltfreundlicher, vor allem sparsamer im Stromverbrauch werden. Denn hohe Energiekosten können sonst Rentabilitätsbetrachtungen zunichte machen.

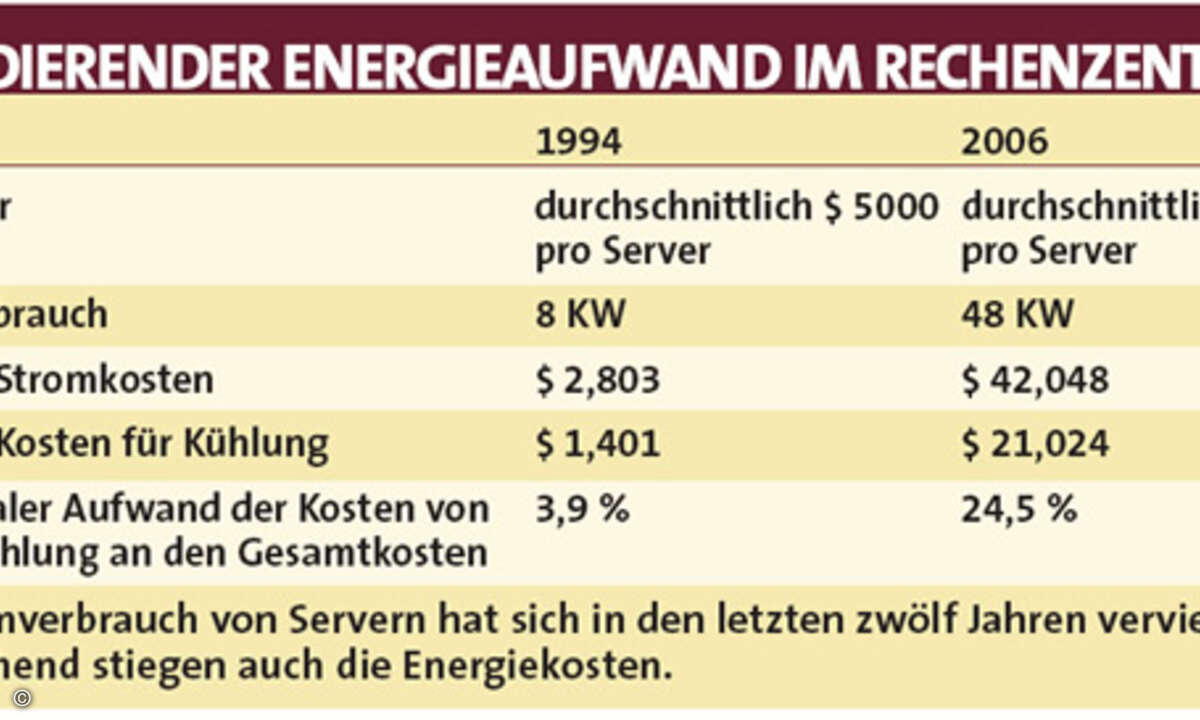

Grüne, sprich vor allem im Energieverbrauch sparsame IT, sollte angesichts steigender Energiepreise ein Thema für jeden CEO sein, stellte kürzlich eine Studie von Datamonitor fest. Mit etwas Phantasie wären für Rechenzentrumsbetreiber dabei völlig neue Wege möglich: Sie könnten etwa auf den Gedanken kommen, mit der Abwärme der Rechenanlagen die Heizanlage zu ersetzen. Unsinnig ist dieser Gedanke ganz und gar nicht. Denn was als Moore’sches Gesetz im Kleinen gilt, schlägt sich im Rechenzentrum im Großen nieder: Die Kapazitäten verdoppeln sich regelmäßig alle ein bis zwei Jahre. Immer schnellere Prozessoren treiben immer leistungsstärkere Server an und Storage-Systeme bewältigen immer größere Datenmengen. Zwar deutet sich bei den Taktraten mittlerweile ein Umdenken an: Sie sinken, dafür koppelt man mehrere Prozessoren. Doch am insgesamt eher steigenden Energiebedarf dürfte auch das nichts ändern, denn immer mehr Rechenpower wird gebraucht. Um das Rechenzentrum am Laufen zu halten, benötigt man große Mengen an Energie. Was bisher für die Betreiber zählte, war dabei in erster Linie die Leistung, während der dafür nötige Energieaufwand vernachlässigt wurde. Doch hier vollzieht sich langsam aber sicher ein Trendwechsel – die aufgewendete Energie wird zunehmend im Verhältnis zur Anwendungsleistung betrachtet. Das Schlagwort lautet Energieeffizienz und ist die erste Grundvoraussetzung für ein umweltfreundliches Rechenzentrum. Es geht allerdings nicht darum, Leistung zu drosseln und zu sparen, sondern darum, mit Hilfe innovativer Technologien das existierende Potenzial maximal auszuschöpfen und möglichst wenig Energie verpuffen zu lassen. Der angenehme Nebeneffekt: sinkende Kosten. Um aufzudecken, wo die wahren Energiesünder stecken, müssen die verschiedenen Komponenten des Rechenzentrums im Zusammenhang betrachtet werden. Ein wichtiger Faktor ist die Infrastruktur. Einen großen Teil der Energie verbraucht die Kühlung. Wird aus dem Freien kühle Außenluft zugeführt, können gegenüber anderen Methoden Einsparungen von bis zu 30 Prozent erzielt werden. Natürlich muss eine komplexe Regelung dafür sorgen, dass Temperatur, Luftfeuchtigkeit und Staubfilterung auch bei schwankenden Außenbedingungen stimmen. Da die Abwärme im Rechenzentrum durch die Konzentration von immer mehr Prozessoren auf weniger Fläche zunimmt, ist die Kühlung gerade langfristig gesehen ein wichtiger Aspekt. Bei der Planung des Rechenzentrums sollte daher auch die räumliche Dimensionierung im Auge behalten werden. Mit Hinblick auf einen möglichen Ausbau des Rechenzentrums werden die Kühlungssysteme oft zu groß angelegt und verschwenden so unnötige Ressourcen. Außerdem sind die Kühlanlagen oft auf eine maximale Auslastung des Rechenzentrums ausgerichtet. Die tritt aber nur selten auf. Hier helfen vorausschauende Planung, flexibel erweiterbare Bestandteile, die »on Demand« hinzugefügt werden können, und skalierbare Lösungen.

Energiefresser auf Mikroebene

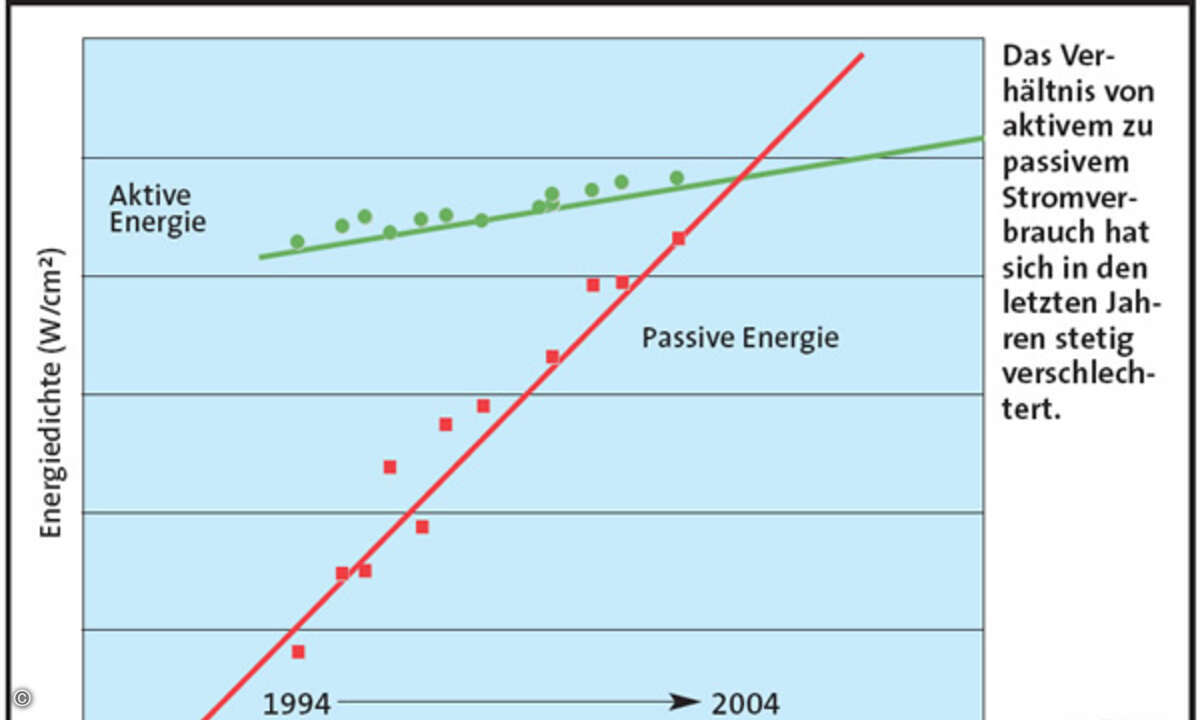

In den Servern im Rechenzentrum verbrauchen Prozessoren, Speicher und Festplatten am meisten Energie. Chips nutzen aktive Energie für das eigentliche Rechnen, wobei der Verbrauch mit höheren Taktraten stark ansteigt. Ein Problem sind vor allem Leckströme. Ihre Ursache sind immer höhere Transistordichten – kleinere Strukturbreiten und höhere Taktfrequenzen führen wegen der technischen Prinzipien der CMOS-Technologie zu größeren Leckströmen. Um dieses Energie-Leck zu stopfen, muss man direkt an der Halbleiterebene ansetzen. Hier haben Entwicklungen wie beispielsweise »Strained Silicon« oder »Silicon-on-Insulator« die Situation verbessert. Alternativ sucht die Forschung auch nach Möglichkeiten, die ungenutzte Energie nutzbar zu machen. Mit Hilfe solcher Lösungen könnten immense Mengen an Energie und damit auch Kosten eingespart werden. Gerade auf Prozessorebene gibt es eklatante Unterschiede im Stromverbrauch. Problematisch bei der Steigerung der Taktfrequenz ist die damit zunehmende Wärmeabgabe. Technologien wie Multicore erzeugen im Vergleich zu Single-Core-Prozessoren bei ähnlicher Rechenleistung weniger Abwärme. Außerdem kann man, wie oben bereits erwähnt, die Taktung des einzelnen Prozessors verringern und dafür mehrere Prozessoren parallel laufen lassen. Die Auslastung wird so auf verschiedene Prozessoreinheiten verteilt, was die Rechenleistung insgesamt extrem steigert. Diese Lösung findet sich vor allem im Supercomputing-Bereich.

Sparen mit Blades?

Blade-Server stellen Rechenzentrumsbetreiber vor neue Herausforderungen. Ihr Nutzen liegt vor allem in der kompakten Bauweise, die die Konzentration der Rechenkraft auf engstem Raum erlaubt. Zudem verbraucht das Gesamtsystem mit Chassis weniger Strom, da Infrastrukturkomponenten wie Switches, Adapter und Ventilatoren von allen Blades gemeinsam genutzt, aber nur einmal mit Energie versorgt werden. Allerdings verursacht die hohe Prozessordichte im Blade-Chassis extrem viel Abwärme pro Quadratmeter Fläche. Darauf ist die Klimatechnik vieler Rechenzentren nicht eingestellt. Spezielle Kühllösungen wie wassergekühlte Blechtüren an der Rückseite der Racks oder Ventilatoren sind nötig, um dieses Problem zu lösen. Ausschlaggebend für die Effizienz der gesamten Server-Landschaft ist die effektive Auslastung. Dies gilt für alle Server-Typen. Ein Weg dazu ist, Kapazitäten je nach Bedarf hinzu- und abzuschalten. Skalierbarkeit kann unter anderem durch Power-Management erzielt werden. Diese Technologie erlaubt ein dynamisches Ab- und Anschalten diverser Systeme und Komponenten, angefangen bei den Web- und Applikationsservern bis hin zu einzelnen Prozessorbereichen, wenn diese nicht benötigt werden. Diese Technologie wird jedoch von den Unternehmen aus Sorge um die Zuverlässigkeit, Stabilität und Sicherheit des Rechenzentrums nur wenig nachgefragt. Wegen der steigenden Energiekosten ist hier zukünftig aber mehr Nachfrage zu erwarten.

Bessere Auslastung durch Virtualisierung

Dasselbe Ziel wird aber auch durch Virtualisierung von Hard- und Software angestrebt: Verschiedene Betriebssysteme und Applikationen laufen parallel auf einem einzigen Server und damit steigt die Auslastung. So lassen sich im Idealfall zwei Drittel bis vier Fünftel der verbrauchten Leistung einsparen. Die gleichen Aussagen wie für Server gelten auch für Speichersysteme. Sie werden in Zukunft wichtiger, da die Datenmengen nach wie vor stark wachsen. Um eine optimale Lösung für das Rechenzentrum als Ganzes zu finden, müssen alle seine Komponenten ganzheitlich betrachtet werden. Hierfür gibt es spezielle Management-Werkzeuge. Sie optimieren Energieverbrauch, Verwaltung und Kühlung im Rechenzentrum. Tools wie Cool Blue von IBM wenden das Virtualisierungskonzept auf das Energiemanagement an. Das verbessert den Betrieb nicht voll ausgelasteter Systeme und senkt den Energiebedarf um bis zu 40 Prozent. Insgesamt muss die Industrie auch wegen der von der Politik formulierten CO2-Einsparziele dringend weitere Konzepte zur Energieeinsparung entwickeln. Relativen Erfolgen auf einigen Gebieten, etwa der Entsorgung und Wiederverwertung, stehen große Defizite auf anderen gegenüber. Es besteht nach wie vor großer Handlungsbedarf. Anwender müssen davon überzeugt werden, dass es auch aus Unternehmensperspektive sinnvoll ist, Rechenzentren umweltfreundlich zu gestalten. Der Trend weist in Richtung zentral verwalteter Rechenzentren mit besserer Benutzerführung. Gewiss werden jedoch einige Ansätze, die wir heute schon kennen, weiterentwickelt und in neuen Feldern eingesetzt werden. Ein Beispiel dafür ist die Virtualisierung. Die Möglichkeiten für ein »grünes Rechenzentrum« sind jedenfalls vielfältig und schonen am Ende nicht nur die Umwelt sondern auch den Geldbeutel.

Silvio Weeren ist Unternehmensbeauftragter umweltfreundliche Produkte bei IBM Deutschland.