Kostentreiber beseitigen

Rechenzentrumstechnik – Für die Betreiber von Rechenzentren gibt es einige Instrumente, mit denen sich die Gesamtbetriebskosten reduzieren lassen, ohne den Verfügbarkeitsgrad zu beschränken. Das gilt vor allem in den Bereichen Kühlung, Energie, Wartung und Personal.

Für den Betrieb eines effizienten Rechenzentrums gibt es eine einfache Formel: Investitionskosten plus Betriebskosten plus Service- und Overheadkosten, also die Verfügbarkeitskosten, dividiert durch die Ausfallkosten müssen unter optimalen wirtschaftlichen Bedingungen bei einer hundertprozentigen Verfügbarkeit gleich eins sein. Das bedeutet: Die Verfügbarkeitskosten müssen den Ausfallkosten entsprechen. Dabei stehen die Investitionskosten in Abhängigkeit zum Verfügbarkeitsanspruch. Je höher also der Verfügbarkeitsanspruch, desto höher auch die Investitionskosten.

Gleiches gilt für die Servicekosten, deren Höhe von den vereinbarten Service-Level-Agreements abhängt. Auch hier gilt je umfassender die vereinbarten Leistungen, um so höher die Kosten. Die Betriebskosten wiederum hängen unter anderem vom Alter des Rechenzentrums ab. Die Betriebskosten älterer Rechenzentren mit einer in der Regel veralteten Technik sind höher als die jüngerer Rechenzentren mit modernerer Technologie. Das gilt vor allem für die Energie- und Klimatisierungskosten, die einen immer größeren Teil der Betriebskosten ausmachen. Wenn die Verfügbarkeitskosten die Ausfallkosten übertreffen, kann nicht von einem effizienten Rechenzentrum gesprochen werden. Umgekehrt erfordern höhere Ausfallkosten einen höheren Aufwand, also höhere Verfügbarkeitskosten. Angestrebt wird ein ausgewogenes Kostenverhältnis.

Zentrale Standortfragen

In der Kostendiskussion sind zunächst die Bau- und Anbindungskosten zu berücksichtigen. Eine maßgebliche Rolle spielt dabei die Standortfrage: Folgende Fragen stellen sich bei der Auswahl eines geeigneten Standorts: Was kostet der Erwerb von Grund und Boden? Wie sieht es mit Glasfasernetzen aus und wie hoch sind die Anbindungskosten an das Backbone? Kein Wunder, dass die meisten Rechenzentren in Deutschland in Städten wie München, Nürnberg, Frankfurt, Düsseldorf, Hamburg, Berlin, Hannover, Leipzig, Köln oder Karlsruhe liegen, die Knotenpunkte im Glasfasernetz darstellen. Weitere zentrale Fragen sind: Wie hoch sind die Energiepreise? Wie hoch sind die Personal- und Lohnnebenkosten? Wie stark sind die Arbeitnehmerverbände? Wie hoch sind die Versicherungskosten zum Beispiel für Haftpflicht- oder Gebäudeversicherungen? Welchen Schutz bietet der Standort gegen Umwelteinflüsse? Besteht zum Beispiel die Gefahr von Stürmen, Tornados oder von Fluten? Auch die Steuerfrage spielt eine entscheidende Rolle. Hierbei ist nicht nur die Höhe zum Beispiel der Gewerbesteuer entscheidend, sondern auch die Frage nach Subventionen und Zuschüssen, deren Höhe von Land zu Land, von Region zu Region stark variieren kann. Ebenfalls wichtig ist die Frage nach dem bürokratischen Aufwand, der betrieben werden muss. Dies betrifft vor allem die Bewilligungsverfahren.

Energie- und Wartungskosten an der Spitze

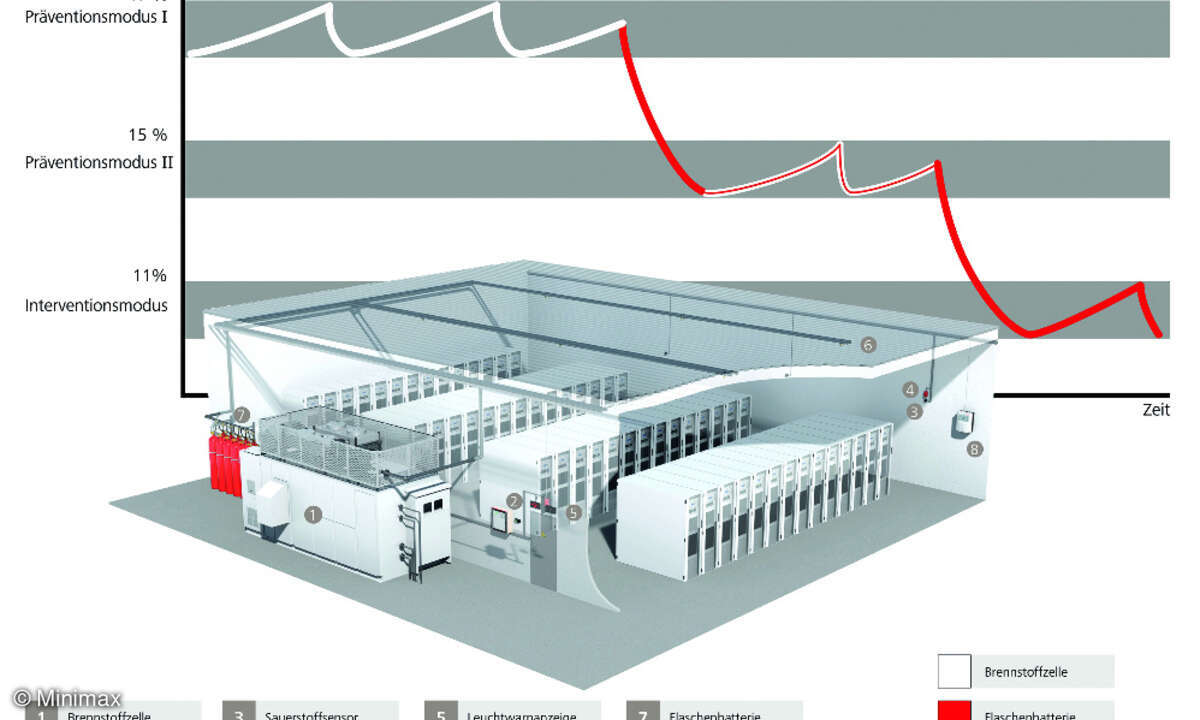

Die Faktoren Energie, Wartung und in geringerem Ausmaß Personal machen das Gros der TCO aus und bilden damit die eigentlichen Stellschrauben, an denen gedreht werden muss, um deutliche Kostensenkungen zu erreichen. Die größten Kostenreduktionen lassen sich im Energiebereich erzielen, der in die Blöcke Kühlung, IT-Power und AC-Verteilung aufgegliedert ist. Empfehlenswert ist auf jeden Fall eine kritische Prüfung aller Komponenten und Applikationen. Gibt es zum Beispiel Applikationen, die nur einmal im Monat benötigt werden und die sich abschalten oder in den Standby-Modus versetzen lassen?

Eine weitere Möglichkeit bietet die Virtualisierung der IT, die zu einer höheren Auslastung der Server führt. Lief früher zum Beispiel pro Server eine Applikation, so bewältigen die heutigen Blade-Server problemlos mehrere Applikationen. Die Folge: Nicht nur eine Reduzierung der Hardware und des Platzbedarfs, sondern auch Einflussnahme auf die entsprechende Energieaufnahme und -abgabe. Zusammenschlüsse wie das sogenannte »Green Grid-Konsortium«, zu dessen Gründungsmitgliedern Unternehmen wie Hewlett-Packard, IBM oder Sun zählen, haben sich die Reduzierung der Faktoren Kühlung und IT-Power in Rechenzentren auf ihre Fahnen geschrieben.

Um die Energieeffizienz zu verbessern, setzt das Konsortium unter anderem auf Servernetzteile mit einem höheren Wirkungsgrad. Ausgewogene Power-Distribution bis ins Rack lautet die Zauberformel, um Schieflagen durch extreme Belastungen einer Phase bei gleichzeitigem Leerlauf der anderen Phasen zu vermeiden. Intelligente Steuerungen über SNMP-Kommunikationsprotokolle sorgen ebenfalls für niedrige Energiekosten. Durch die Intelligenz auf der Klimaseite wird das Problem der Hysteresen in Folge der Temperaturmessung umgangen. An Stelle der Temperaturmessung wird die Leistungsaufnahme im Gerät gemessen. Per SMNP wird die nach gelagerte Technik auf der Infrastrukturebene informiert, dass die Systeme weniger Energie benötigen, so dass beispielsweise USV-Systeme herunter gefahren werden können oder der Kompressorbetrieb in eine Freikühlung umgewandelt werden kann.

Nutzung der Freikühlung

Eine genau geplante Raumklimatisierung ist wichtig und ermöglicht ein bedarfsorientiertes Arbeiten. Sie bedeutet geringere Druckverluste im Register, niedrigere Lüfterdrehzahlen und eine verminderte Stromaufnahme. Mittels freier Kühlung lässt sich eine erhebliche Menge an Energie einsparen. So beträgt der Energiebedarf von Freikühlgeräten mit Trommelventilatoren 67 Prozent des Energiebedarfs von luftgekühlten Klimageräten. Der von Freikühlgeräten mit freilaufenden Rädern benötigt 59 Prozent und der von Freikühlgeräten mit EC-Lüftern und drehzahlgeregelten Pumpen sogar nur 45 Prozent. Beispielrechnungen zeigen, dass Freikühlgeräte mit drehzahlgeregelten Pumpen gegenüber luftgekühlten Klimageräten kürzere Amortisationszeiten aufweisen. Die Energieeffizienz eines Rechenzentrums lässt sich auch durch so genannte Blanking-Plates steigern. Diese Blanking-Plates, die für eine gezielte Zuführung kalter Luft in den Racks sorgen, verhindern Luftkurzschlüsse, bei denen durch Luftvermischung Energie vernichtet wird.

Verbesserte Fehlerdiagnose

Es stellt sich die Frage, welche Instrumente zur Verfügung stehen, um Kostensenkungen bei der Wartung zu erzielen. Wie lassen sich Fehlerquellen beseitigen und Diagnosemöglichkeiten bei Störfällen verbessern? Fehleinsätze, fehlerhafte Diagnosen mit erneuten Ausfällen und eine schlecht organisierte Ersatzteilbevorratung führen zu höheren Wartungskosten. Instrumente zur Kostensenkung sind hier die standortunabhängige Überwachung der Rechenzentren durch Standardprodukte, die eine schnelle Fehleranalyse erlauben, die effizientere Einbindung von Dienstleistern und die Vermeidung von unnötigen Serviceeinsätzen. An Stelle der früher eingesetzten Störungskontakte, die keinen Aufschluss über die Art der Störung gaben, bieten neuere Lösungen eine schnelle Fehlerdiagnose per Dial-in-Verfahren oder hausinterner VPN-Netze: Die möglicherweise weit entfernt arbeitenden Service-Mitarbeiter wählen sich auf ihren Rechnern in das Rechenzentrum ein und erkennen, um welche Art von Störung es sich handelt. Sie erkennen damit, ob die Störungsbeseitigung sofort erfolgen muss oder ob sie später agieren können. Die Vorteile dieser Art des Monitorings liegen auf der Hand: Verzicht auf Nachtzuschläge, Entlastung des Personals, Abschluss von Service-Level-Agreements mit kostengünstigeren Entstörzeiten und eine bessere Ersatzteilbevorratung, die nicht erst im Unternehmen vor Ort erfolgt. Eine gute Möglichkeit, Wartungs- und Fixkosten zu reduzieren.

Ralf Dahmer,

Geschäftsführer Litcos