Zukunft des Desktops oder nur ein Hype?

Die Desktop-Virtualisierung hat in den vergangenen Monaten zunehmend von sich reden gemacht. In Anbetracht mancher Probleme stellt sich aber die Frage, ob sie wirklich die Lösung für die Bereitstellung von Clients ist oder doch eher ein überschätzter Hype.

Die Wahrheit liegt, soviel vorab, irgendwo in der Mitte. Die heute verfügbaren Ansätze für die

Desktop-Virtualisierung lassen noch einiges an Wünschen offen. Häufig muss man zum Schluss kommen,

dass bewährte Ansätze wie per CLM (Client-Lifecycle-Management) verwaltete lokale Desktops oder

Terminal-Server-Szenarien besser geeignet sind als die Desktop-Virtualisierung. Dennoch wird diese

ihren Platz in IT-Strategien finden und auf Dauer an Gewicht gewinnen.

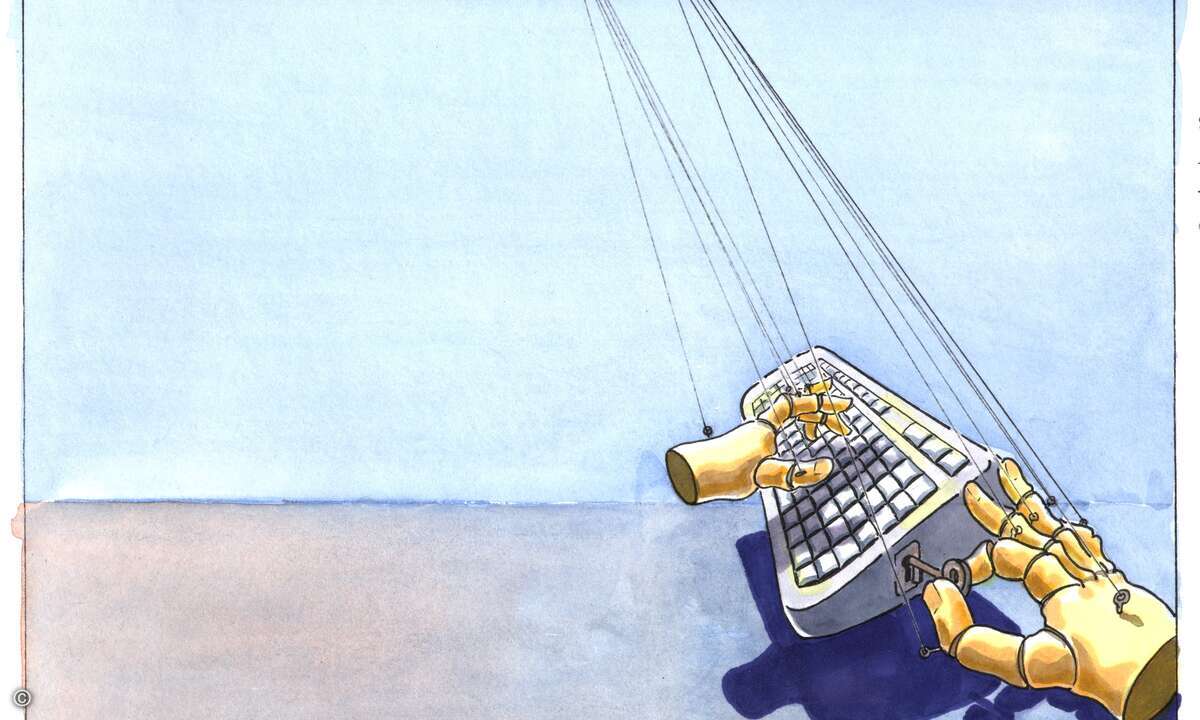

Die Grundidee der Desktop-Virtualisierung ist, dass die Arbeitsumgebungen (Desktops) der

Endbenutzer nicht mehr an bestimmte Systeme gebunden sind, sondern als virtualisierte Systeme

zentral verwaltet und bereitgestellt werden. Der typische Ansatz (Hosted Virtual Desktops, HVDs)

ist dabei, dass auf einem Server virtuelle Maschinen (VMs) für die Clients parallel laufen und der

Zugriff auf diese über Fernzugriffsprotokolle wie RDP (Remote Desktop Protocol) oder Citrix? ICA

(Independent Computing Architecture) erfolgt. Dieser Fernzugriff ist aber nicht zwingend. Es finden

sich auch erste Szenarien, bei denen die vollständigen virtuellen Umgebungen auf den Client

gesendet und dort ausgeführt werden.

Die Herausforderungen bei einem solchen Konzept sind offensichtlich: Die Ausführung vieler

paralleler virtueller Maschinen ist lastintensiv. Images für virtuelle Desktops benötigen viel

Speicherplatz. Der Zugriff über Remote-Protokolle ist vor allem bei grafisch anspruchsvollen

Anwendungen komplex. Desktops mit benutzerspezifischen Anpassungen müssen erstellt und verwaltet

werden. Für mobile Benutzer ohne permanente Netzwerkverbindung funktioniert der Weg über RDP oder

ICA nicht.

Dem stehen auch Vorteile gegenüber. Die Lebenszyklen von Client-Hardware werden verlängert, die

Arbeitsumgebung kann von einem System aus verwaltet werden, das Management von Hardware und

Anwendungen wird weitgehend zentralisiert, die Verfügbarkeit wird potenziell erhöht.

Lösungsansätze und Grenzen

Die Anbieter von Desktop-Virtualisierungslösungen bemühen sich intensiv, die genannten

Herausforderungen anzugehen. Um den benötigten Speicherbedarf für die virtuellen Images zu

reduzieren, setzt beispielsweise VMware auf Master-Images, die geklont werden. Citrix geht ähnlich

vor, fokussiert aber auf eine Splittung in Image-Teile. Dennoch darf man die Storage-Anforderungen

nicht unterschätzen, die zudem umso höher sind, je individueller HVDs pro Benutzer anpassbar

sind.

Ähnliches gilt für die Lastanforderungen bei der Ausführung der virtuellen Desktops. Nicht zu

unterschätzen ist auch die Herausforderung, einen Desktop unverzüglich zur Verfügung zu stellen,

also lange Boot-, Lade- und Wiederherstellungsvorgänge zu vermeiden.

Um die Einschränkungen von Remote-Desktop-Protokollen beispielsweise beim Drucken oder bei

grafisch anspruchsvolleren Anwendungen wie Video-Streams zu beheben, arbeiten die Anbieter an neuen

Lösungen – genauer: an Workarounds, da es letztlich immer der Versuch ist, systemimmanente

Schwächen zu umgehen. Dennoch geht es hier voran, wobei manche der Probleme schon mit

Terminal-Servern aufgetreten sind.

Die meisten dieser Probleme entfallen, wenn der virtuelle Desktop auf den Client geliefert wird,

also dort ein Hypervisor oder eine andere Virtualisierungstechnik läuft. Damit verschiebt sich die

Problematik aber, denn ein solches Konzept erfordert hohe Bandbreiten hin zum Client sowie

effiziente Ansätze für die Synchronisation zwischen lokalen und zentralen Images.

Bei der individuellen Anpassung von Desktops steht man ebenfalls noch vor mancher

Herausforderung. HVD-Konzepte sind derzeit darauf ausgelegt, eine kleine Zahl weitgehend

identischer Desktops bereitzustellen. Für Anpassungen sollte man sich im Wesentlichen auf

Grundfunktionen des Systems beschränken, wie sie über die Benutzerprofile und Gruppenrichtlinien

von Windows umgesetzt und gesteuert werden können.

Falls Benutzer spezielle Anwendungen benötigen, ist die Integration mit der

Anwendungsvirtualisierung naheliegend. Damit lassen sich Anwendungen gezielt virtualisiert in einer

abgeschotteten Ausführungsumgebung bereitstellen. Dies erlaubt Anpassungen, ohne die Images der

virtuellen Desktops selbst zu modifizieren.

Management-Herausforderungen

Der Nachteil einer solchen Kombination: Man hat es gleich mit zwei Virtualisierungsansätzen zu

tun. Dennoch braucht man Lösungsansätze für das Customizing virtueller Umgebungen. Soweit ein

einzelner virtueller Desktop einem Benutzer persistent zugeordnet ist, ist das einfacher zu lösen.

In diesem Fall kann man grundsätzlich auch mit bewährten CLM-Ansätzen arbeiten, allerdings um den

Preis des Verzichts auf einen der am häufigsten ins Feld geführten Vorteile der

Desktop-Virtualisierung, den Verzicht auf eben solche CLM-Lösungen.

Interessanterweise ist das Image-Management bei den heute verfügbaren Lösungen noch wenig

ausgereift. In den meisten Fällen kann man fertige Images (VMs) verwalten, aber nicht differenziert

in die Inhalte der Images eingreifen. Im Vergleich mit dem etwas anders gelagerten Image-Management

von Windows Vista ist dies aber zu wenig, weil es die Erstellung und Verwaltung unterschiedlicher

Images erschwert.

Das Management ist ohnehin die große Herausforderung. Dabei geht es nicht nur um die Verwaltung

von Images und individuellen Anpassungen, sondern um die zwingend erforderliche komplexe

Server-Infrastruktur, gegebenenfalls ergänzt durch eine Infrastruktur für die

Anwendungsvirtualisierung.

Dahinter steht eine ebenfalls anspruchsvolle Storage-Landschaft. Microsoft spricht bezüglich

seiner VDI (Virtual Desktop Infrastructure) auf der Website ganz offen davon, dies sei "nicht die

am einfachsten zu installierende Technik"– das gilt für die anderen Anbieter analog.

Eine Virtual-Desktop-Umgebung erfordert eine gründliche Planung und den Aufbau einer

Server-Infrastruktur. Eine integrierte Installation oder Administration solcher Umgebungen ist noch

weit entfernt: Man muss immer mehrere komplexe Systeme einrichten und verwalten. Dies wird sich mit

zunehmender Verbreitung und wachsendem Reifegrad sicher ändern – noch ist die

Desktop-Virtualisierung aber eine vergleichsweise junge Technik.

Ihr Einsatzbereich liegt derzeit vor allem bei standardisierten Desktops ohne oder mit minimalen

individuellen Anpassungen und mit geringen Anforderungen an die Audio- und Videofunktionalität der

genutzten Anwendungen. Dies ist aber auch der Bereich, in dem man schon seit Jahren mit

Terminal-Services arbeitet. Insofern muss die erste Frage immer sein, ob man mit der

Desktop-Virtualisierung wirklich so viele Vorteile erzielt. Denn gerade der Vorteil der

Individualisierung ist heute nur eingeschränkt nutzbar.

Dies wird sich im Laufe der Zeit ändern: mit Verbesserungen im Image-Management, besseren Tools

für das Management individualisierter Umgebungen und für das Management der virtualisierten

Desktop-Infrastrukturen selbst sowie effizienten Konzepten für das Deployment der Desktops auch auf

die Client-Systeme zur lokalen Ausführung. Auch dann wird man aber genau überlegen müssen, ob nicht

ein klassischer Ansatz von lokalen Clients mit einem guten CLM der effizientere Ansatz ist – umso

mehr, als der Administrator an solchen Tools für das Management individualisierter Umgebungen auch

nicht vorbeikommen wird, wenn er virtuelle Desktops zentralisiert verwalten und individuell

anpassen will.

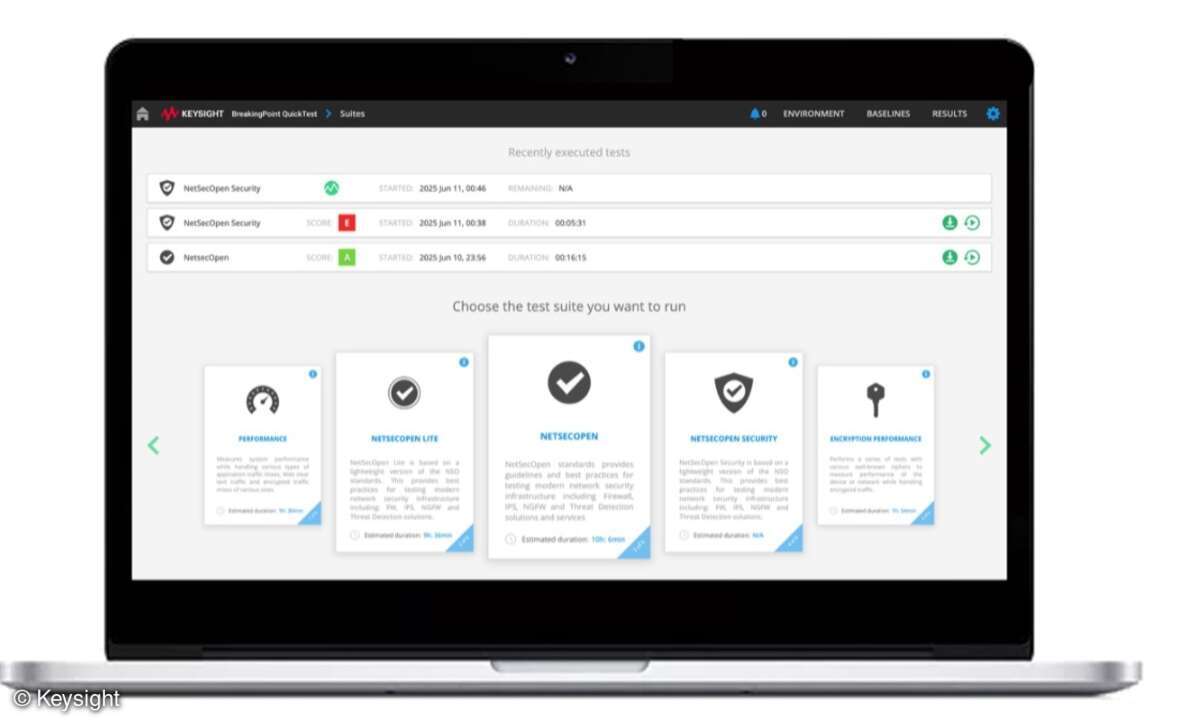

Im Markt für Desktop-Virtualisierung gibt es eine ganze Reihe von Anbietern. Wenn man die Liste

der Anbieter näher analysiert, reduziert sich die Zahl der Konzepte aber schnell. Dies ist wenig

überraschend, ist doch die Zahl der Anbieter von Virtualisierungstechniken eng begrenzt. Insofern

gibt es einige Basistechniken und darauf aufsetzende Management-Lösungen – und in letzterem Bereich

versuchen sich immer mehr Hersteller zu positionieren.

VMware und Citrix, aber auch Microsoft, Sun oder – vor allem über Partner – Parallels zählen zu

den Herstellern, die über eigene Virtualisierungstechnik verfügen. Andere Anbieter wie Quest oder

2X Software fokussieren dagegen auf Management-Infrastrukturen, bei denen sich

Virtualisierungstechniken unterschiedlicher Hersteller nutzen lassen. Vorteile werden dabei auf

Dauer die Anbieter haben, die leistungsfähige Management-Lösungen für alle Aspekte der

Virtualisierung bis hin zu einer Integration mit der Anwendungsvirtualisierung und CLM-Lösungen

bieten können.

Noch gibt es einige dicke Fragezeichen hinter dem jungen Konzept der Desktop-Virtualisierung. Es

ist eine interessante und wichtige Option in einer Gesamtstrategie für das Desktop-Management, aber

sicher nicht die Lösung aller Probleme. Daher muss man genau analysieren, welchen Mix aus

Virtualisierungs-, Bereitstellungs- und Managementtechniken man heute und in Zukunft nutzen möchte,

um möglichst effiziente Lösungen zu erhalten.