Keine Angst vor KI-Halluzinationen

Mit der Verbreitung von KI in der Cybersicherheit machen sich Unternehmen zunehmend Sorgen: Können KI-Halluzinationen zum Super-GAU führen? Ontinue, der Experte für Managed Extended Detection and Response (MXDR), sagt nein – vorausgesetzt, ein Security Operations Center mit KI-Expertise überwacht die Cybersecurity.

Um KI-Halluzinationen zu erkennen und zu verhindern, benötigen IT-Teams Fachkenntnis aus zwei Welten, die eigentlich kaum etwas gemein haben: der Cybersicherheit und der Künstlichen Intelligenz. Die wenigsten Unternehmen sind in der Lage, solch hochspezialisierte Teams vorzuhalten. Warum es deshalb Sinn ergibt, externe Security Operations Centers (SOCs) von MXDR-Spezialisten zu beauftragen, erklärten Fachleute von Ontinue vor Kurzem in einem Statement.

SOCs durchblicken KI-Halluzinationen mit deutlich höherer Trefferquote

Halluzinationen von generativer oder agentenbasierender KI kommen vor, wenn ein Large Language Model (LLM) auf einer falschen oder nicht relevanten Datengrundlage basiert. Bestenfalls verzögern sie lediglich die Behebung von Sicherheitsvorfällen.

Halluzinationen können allerdings auch False Negatives verursachen, also Entwarnung bei einem ernsthaften Security Incident geben. Dann verursachen sie nicht nur immensen Aufwand und Kosten, sondern kompromittieren schlimmstenfalls die gesamte IT eines Unternehmens.

Ein typisches Beispiel für eine halluzinierende KI ist etwa, dass sie eine veraltete IP-Adresse aus den Trainingsdaten zieht und sie ausgibt, statt die IP auszugeben, die mit einem aktuellen Sicherheitsvorfall in Verbindung steht. Ein weiteres untrügliches Signal für eine Halluzination sind Platzhalter oder abweichende Daten in Antworten, bei denen Analysten konkrete Werte erwarten.

In einem solchen Fall bedarf es speziell geschulter KI- und Cybersecurity-Experten, um Halluzinationen sicher zu erkennen, und dann greift auch die Stärke externer MXDR-Anbieter: Die Erfahrung ihrer Analysten im SOC fußt nicht nur auf den Daten eines einzigen Unternehmens, sondern schöpft aus einer Vielzahl verwalteter Sicherheitsarchitekturen. Dies ist hausinternen IT-Teams nicht möglich, macht aber den ausschlaggebenden Unterschied bei der Erkennung und Beseitigung von Halluzinationen.

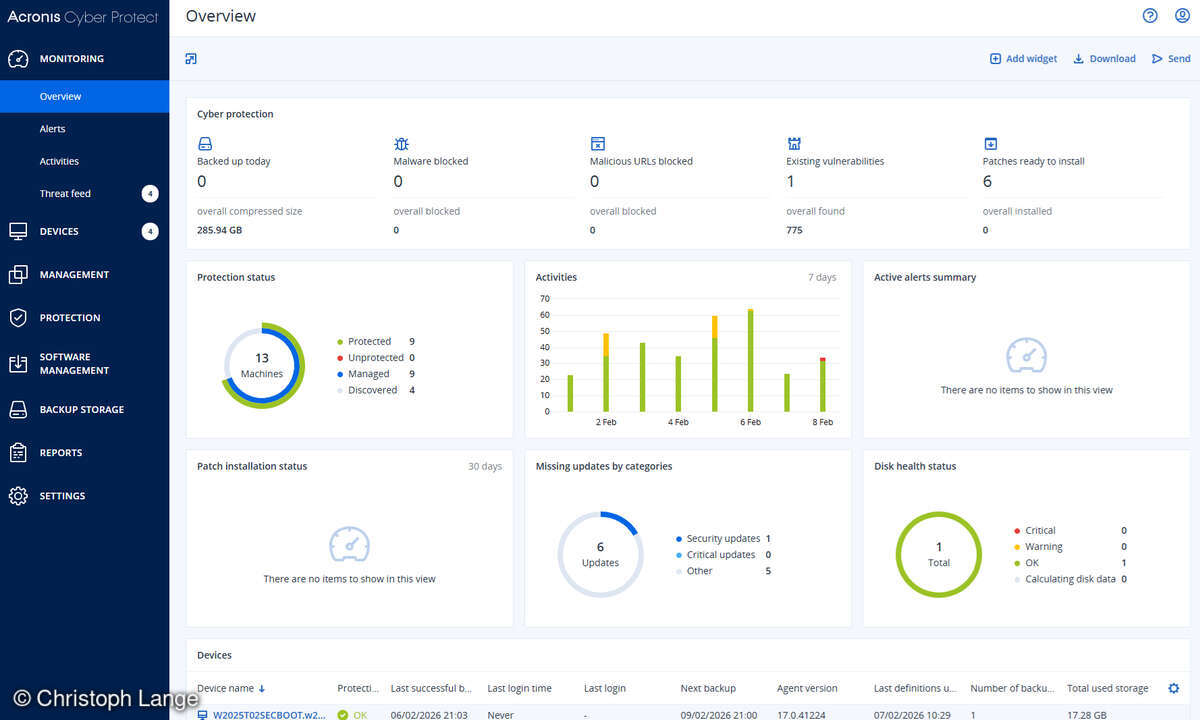

KI-basierende Cybersecurity-Plattformen von SOCs halluzinieren seltener

Um das Vorkommen von Halluzinationen zu reduzieren, füttern MXDR-Dienstleister LLMs dazu ausschließlich mit relevanten Daten, die für die Erkennung, Bearbeitung und Lösung von Sicherheitsvorfällen nötig sind. In manche Plattformen fließen zudem anonymisiert Informationen aus sämtlichen Security Incidents, die bei den unterschiedlichen Unternehmen jemals vorgekommen sind. Weiterhin trainiert jeder manuelle Handgriff der Expertinnen und Experten die KI zu einem hochwertigen, digitalen Cybersecurity-Analysten, dessen Fehlerquote bald deutlich unter der eines menschlichen Kollegen liegt.

SOCs legen im Zweifel selbst Hand an

Trotz der hohen Erfolgsquote von KI-Plattformen und Agentic-AI-Anwendungen von MXDR-Anbietern, ist und bleibt die KI nicht unfehlbar. Deshalb ist ein „Human in the Loop“-Ansatz, bei dem menschliche Cybersecurity-Analysten stets über die Maßnahmen der KI informiert werden, unabdingbar.

Er garantiert zudem, dass die KI-Anwendung, sollte sie nicht weiterkommen, weil ihr Informationen oder Berechtigungen fehlen, automatisch einen menschlichen Analysten benachrichtigt, um sich das Problem anzusehen. Gerade Agentic AI, also autonom agierende KI-Systeme, müssen aus diesem Grund so eingestellt sein, dass sie bei tiefgreifenden Entscheidungen menschliche Expertinnen und Experten zu Rate ziehen.

Doch der „Human in the Loop“-Ansatz ist nur dann sinnvoll, wenn die benachrichtigten Cybersecurity-Experten das Problem überhaupt erst erkennen und auch lösen können. Genau an dieser Stelle kommt ein MXDR-Anbieter mit seinen SOCs wie gerufen, denn deren Fachpersonal erkennt im besten Fall auf Anhieb, wo und wie die KI gescheitert ist, löst den Fall und trainiert die KI auf diese Weise direkt wieder, sodass beim nächsten Mal kein menschliches Eingreifen mehr nötig ist.

„KI-Halluzinationen sind der Grund, warum viele Unternehmen zu Recht Angst vor deren Einsatz haben und weshalb generative KI und Agentic AI in der Cybersecurity nur von hochspezialisiertem Fachpersonal betreut und genutzt werden sollte“, warnt Theus Hossmann, Chief Technology Officer bei Ontinue.

„Künstliche Intelligenz ist durchaus in der Lage, Security Operations Centers und deren Personal viel Arbeit abzunehmen. Aber sie hat eben auch ein großes Schadens- und Kostenpotenzial, wenn sie nicht von absoluten Profis bedient und genutzt wird. Für viele Unternehmen sprengt schon der Aufbau eines SOC den finanziellen Rahmen, daher ist der unbedarfte Einsatz KI-basierender Cybersecurity-Plattformen zwar verlockend, aber ein Spiel mit dem Feuer.“