Wie Hacker defensive KI-Methoden austricksen

Dass KI nicht wirklich intelligent ist, zeigt sich auch in der Cybersicherheit. Wie Hacker die lernenden Algorithmen defensiver KI-Methoden umgehen und manipulieren, um unbehelligt in vermeintlich geschützte Unternehmensnetzwerke einzudringen.

Die vollmundigen Marketingaussagen einiger IT-Sicherheitsfirmen erwecken den Eindruck, dass Künstliche Intelligenz die Antwort auf alle aktuellen und zukünftigen Herausforderungen der Cybersicherheit ist. So sollen integrierte KI-Funktionen automatisch ungewöhnliches Verhalten erkennen, analysieren und verdächtige Vorgänge sofort stoppen. Problem erkannt, Problem gebannt? Leider nein.

Cybersecurity-Experten mahnen zur Vorsicht und davor, die Fähigkeiten der Technologie zu überschätzen. Denn ein genauerer Blick auf aktuelle KI-basierte Funktionen und Dienste zeigt, dass es zwar vielversprechende Lösungen gibt, diese aber mehr versprechen, als sie halten können.

Anbieter zum Thema

Trügerische Sicherheit

Es besteht kein Zweifel, dass KI die Zukunft maßgeblich beeinflussen und verändern wird. Dennoch steht die Menschheit erst am Anfang der Entwicklung, vergleichbar mit der Entwicklung des Schwarz-Weiß-Fernsehens hin zum drahtlosen 4K-Streaming. Es scheint daher ratsam, zunächst die Grenzen der Anwendbarkeit auszuloten, bevor wir uns voll und ganz auf sie verlassen. Denn angesichts ihrer hohen Leistungsfähigkeit neigen wir dazu, der KI-Technologie Kompetenzen zuzuschreiben, die sie in Wahrheit nicht hat, und uns so in trügerische Sicherheit zu wägen. Da der KI Verantwortungsbewusstsein und echtes Urteilsvermögen fehlen, relativiert sich das Nutzenpotenzial. Das gilt umso mehr für sensible Anwendungsbereichen wie der Cybersicherheit, bei der Fehleinschätzungen gravierende Folgen haben können.

KI nicht wirklich intelligent

Wie die mehr oder weniger amüsanten Ergebnisse halluzinierender Sprachmodelle wie ChatGPT täglich beweisen, ist das, was gemeinhin als künstliche Intelligenz bezeichnet wird, nicht intelligent im menschlichen Sinne. LLMs verstehen die Welt nicht, sie simulieren lediglich sprachlich kohärente Antworten auf der Basis statistischer Muster. Ähnlich verhält es sich bei der Cyberabwehr: KI-basierte Erkennungsalgorithmen lernen nicht aktiv oder gezielt, sondern werden passiv durch die Verarbeitung sehr großer Datenmengen trainiert. Je mehr Material ein Modell sieht, desto besser kann es Zusammenhänge imitieren. Da am Ende immer ein echtes Verständnis fehlt, kann KI letztlich auch gefährlich werden – entweder weil sie halluziniert, also falsche Schlüsse zieht, oder weil sie undifferenziert nach gelernten Mustern Entscheidungen trifft.

Cyberkriminelle wappnen sich

Ob staatlich gefördert, kommerziell motiviert oder Hacktivist: Angreifer aller Couleur diskutieren in geschlossenen und versteckten Internetforen eifrig darüber, wie KI ihre Arbeit erschwert und wie sie die neue Technologie nutzen können, um leichter in Unternehmensnetzwerke einzudringen, Systeme zu korrumpieren und Software zu manipulieren. Aber das ist nur die Spitze des Eisbergs. Es gibt bereits Hinweise darauf, dass Hacker sogar KI-gestützte Endpunktlösungen ausnutzen. Dies ist möglich, wenn die zugrunde liegenden maschinellen Lernmodelle so geändert werden, dass bösartige Aktivitäten als normal eingestuft werden.

6 Hackertricks gegen Defensive KI

Die folgenden sechs Beispiele, wie Angreifer KI-Funktionen austricksen, wurden von IT-Sicherheitsexperten bei Secuinfra zusammengestellt. Die Beispiele sind nicht theoretischer Natur, sondern stammen aus Quellen im Dark Web, also nicht-indizierten Teilen des Internets, in denen Hacker und Cyberkriminelle ihre Erfahrungen austauschen.

1. Bösartiges KI-Training (Vergiftungsangriff)

Bei dieser Methode trainieren Cyberkriminelle KI-Systeme darauf, bösartiges Verhalten als normal zu bewerten. Hintergrund: KI-gestützte EDR- und XDR-Systeme (Endpoint beziehungsweise eXtended Detection and Response) lernen anhand von Trainingsdatensätzen, zwischen normalem und bösartigem Verhalten zu unterscheiden. Gelingt es Hackern nun, bösartige Aktivitäten als normal zu deklarieren und entsprechende Trainingsdaten in ausreichender Menge einzuspeisen, gewöhnt sich die KI mit der Zeit daran und stuft die Aktivität als normal ein.

Ein Beispiel: Ein Hacker führt wiederholt unauffällige Erkundungsaktivitäten (zum Beispiel Netzwerk-Scans) in einer Art und Weise durch, die administrativen Aufgaben ähnelt. Die KI beginnt, diese Scans als legitim anzusehen, auch wenn der Umfang oder die Häufigkeit später zunimmt.

2. Ausweichende Angriffe

Bei dieser Methode imitieren die Angreifer legitimes Verhalten. Sie passen ihr Verhalten an, um nicht entdeckt zu werden, indem sie Techniken wie Living-off-the-Land (LotL) oder polymorphe Malware einsetzen. Im ersten Fall verwenden sie für ihre Angriffe legitime Tools wie PowerShell oder WMI, was wie ein normaler Vorgang aussieht. Beispielsweise kann die Verschlüsselung von Daten in kleinen Batches wie ein legitimer Backup-Prozess aussehen und die KI dazu verleiten, die Ransomware-Aktivitäten als harmlos einzustufen.

3. Aktualisierungsangriff

KI-Systeme müssen regelmäßig aktualisiert werden, um sich an neue Umgebungen anzupassen. Dieser Umstand kann auch von Angreifern ausgenutzt werden, um ihre Wirkung zu beeinträchtigen. Wird das Modell gezielt mit falschen Daten gefüttert, bewertet es die sorgfältig ausgearbeiteten Aktivitäten des Hackers in seinem Bezugsrahmen allmählich als normales Verhalten.

Beispiel: Ein Hacker lädt wiederholt verschlüsselte Dateien auf einen Cloud-Speicher hoch. Das System hält dies zunächst für verdächtig, lernt aber mit der Zeit, dass dies ein normales Verhalten ist.

4. Rauschangriffe

Ein weiterer Trick, um KI-basierte Erkennungssysteme zu überlisten, besteht darin, EDR- oder XDR-Systeme mit unbedeutenden Daten oder Ereignissen zu überfluten. Das künstlich erzeugte Rauschen kann die KI überlasten, so dass sie bösartige Aktivitäten falsch klassifiziert oder übersieht. Beispielsweise können Angreifer in einer Sandbox-Umgebung harmlose Warnungen oder Anomalien erzeugen, um die KI für echte Bedrohungen unempfindlich zu machen und bösartige Signale im Rauschen zu verbergen.

5. Umgehung der Verhaltensanalyse

Eine häufige Aufgabe KI-gestützter Systeme ist die Überwachung des Benutzer- und Systemverhaltens zur Erkennung von Anomalien. Durch die Analyse spezifischer Alarmauslöser (zum Beispiel Dateizugriffsmuster oder CPU-Auslastung) können Angreifer lernen, knapp unter dem digitalen Radar zu operieren, ohne einen Alarm auszulösen. Dies gelingt zum Beispiel, wenn sie das normale Verhalten der Mitarbeiter nachahmen und nur in geringem Umfang auf sensible Dateien zugreifen, statt durch große Datenextraktionen aufzufallen.

6. Datenvergiftung vor der Implementierung

Einige fortgeschrittene Angreifer versuchen sogar, die Entwicklung von EDR- oder XDR-Systemen zu ihren Gunsten zu beeinflussen, indem sie über kompromittierte Lieferketten oder Open-Source-Modelle gefälschte Daten in den Trainingssatz einspeisen. Auf diese Weise lernt das System noch vor der Implementierung, bestimmte Arten von Malware als harmlos einzustufen, was spätere Angriffe erleichtert.

Fazit

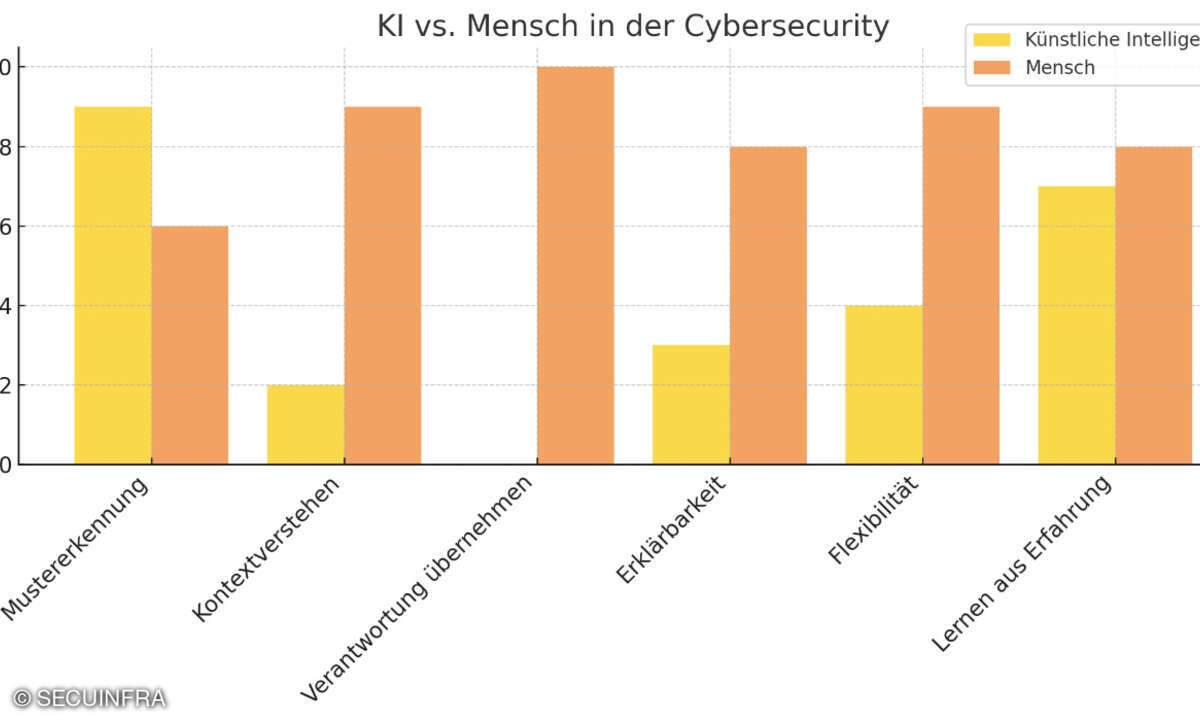

Im Bereich der Cyberabwehr verspricht die KI aktuell mehr, als sie zu leisten vermag. Zwar verfügen KI-gestützte Erkennungssysteme über beeindruckende Analysefähigkeiten, doch ihr Nutzen beschränkt sich jedoch meist darauf, die Arbeit der menschlichen Analysten zu unterstützen. Denn ohne Verständnis für ihr Handeln ist künstliche Intelligenz anfällig für Fehleinschätzungen und gezielte Täuschungsmanöver. Durch gezieltes Ausnutzen ihrer Schwächen gelingt es Angreifern, defensive KI-Methoden zu manipulieren, zu überlisten oder durch gezielte Datenvergiftung zu unterwandern. Vor diesem Hintergrund erfordert eine verlässliche Bewertung mehr denn je menschliche Kompetenz und Erfahrung – nicht als Ersatz, sondern als unverzichtbares Korrektiv im Zusammenspiel mit der Maschine.