Von Network Attached Storage zu hybriden Szenarien

Ein Blick auf die Geschichte der Anwendungsbereitstellung zeigt, wie sich die Anforderungen und Möglichkeiten mit der Zeit verändert haben. Doch es erwachsen daraus sowohl Herausforderungen als auch Chancen.

Die Anfänge

Vor den 1990er-Jahren wurden die meisten Desktop-Anwendungen lokal auf Nutzergeräten installiert. Sie liefen direkt auf dem Endgerät und hatten Zugriff auf alle lokalen Ressourcen. Für den schnellen Zugriff auf geteilte Daten, wurde auf Network Attached Storage (NAS) gesetzt. Die größte Herausforderung dabei? Wartung und Leistung.

IT-Mitarbeitende mussten große Entfernungen zwischen verschiedenen Standorten zurücklegen, um jedes Gerät vor Ort zu aktualisieren und zu warten. Und obwohl das Internet immer beliebter wurde, konnte es mit dem lokalen Netzwerk, das damals beeindruckende 10 Mbit/s liefern konnte, noch nicht mithalten. Anwendungen, die für nahezu sofortigen Datenzugriff entwickelt wurden, funktionierten über langsame oder remote Verbindungen einfach nicht richtig.

Erste Innovationen

Ende des zwanzigsten Jahrhunderts erkannten einige ehemalige IBM-Ingenieure eine Chance und ergriffen sie: Sie gründeten das Unternehmen Citrix. Ihr Produkt ermöglichte es, Anwendungen nahe an den Daten zu halten und zentral zu verwalten. Den Nutzern wurden lediglich Bilder des sich verändernden Bildschirms übermittelt. Im Gegenzug empfing die Anwendung Mausbewegungen und Tastatureingaben. So gelang es dem Unternehmen, mehr als einen Nutzer auf einer einzigen Instanz eines (Server-)Betriebssystems unterzubringen.

So wurde auch deutlich weniger Netzwerkverkehr erzeugt. Das bedeutete, dass sogar mehrere Personen gleichzeitig und über viel langsamere Verbindungen auf die Anwendung zugreifen konnten. Ganz ohne Engpässe im Netzwerk.

Dieser Ansatz des „Application Remoting“ bot insbesondere im Hinblick auf Datensicherheit und IT-Betriebsmanagement Vorteile, da Anwendungen und Daten an einem Ort bleiben konnten. Große Organisationen erzielten so erhebliche Kosteneinsparungen. Dies ermöglichte dem Markt für Server-Based Computing einen Aufschwung.

Die Phase der “Next Big Things”

Wie in jedem boomenden Markt, traten mit der Zeit neue Akteure auf den Plan. 1997 lizenzierte Microsoft die Technologie von Citrix und entwickelte die erste „Terminal Server“-Edition auf Basis von Windows NT 4. Dadurch wurde dieser Ansatz direkt im Betriebssystem angeboten.

VMware führte 2006 die Virtual Desktop Infrastructure (VDI) ein. Bei dieser Lösung erhielt jeder Nutzer einen eigenen virtuellen Desktop, anstatt sich ein Betriebssystem zu teilen. VDI erforderte zwar mehr Infrastruktur, löste aber Leistungsprobleme, die durch „laute Nachbarn“ in Multi-User-Systemen verursacht wurden.

Im selben Zeitraum durchlief die Branche eine experimentelle Phase voller „Next Big Things“ (NBTs). Jede neue Technologie versprach, alle bisherigen Lösungen zu ersetzen und viele Unternehmen versuchten, alles auf eines dieser neuen Bereitstellungsmodelle umzustellen. Einige dieser „Experimente“ hinterließen bleibende Spuren und werden sogar heute noch für bestimmte Anwendungen genutzt.

Diese Technologien haben die Entwicklung interaktiver, plattform-übergreifender und multimedialer Anwendungen vorangetrieben und waren wichtige Wegbereiter für moderne Web- und App-Technologien. Allerdings brachten sie auch einige Nachteile mit sich, wie die Anbieterbindung, die Abhängigkeit von Plugins, eine schlechte mobile Unterstützung sowie ein zu hoher Ressourcenverbrauch für die typischen Systeme.

Der Aufstieg von SaaS

In den späten 1990er und frühen 2000er Jahren entstand ein neues Modell, das durch das massive Wachstum der Internetnutzung und die weitverbreitete Einführung von Webbrowsern angetrieben wurde: Software as a Service (SaaS).

Unternehmen wie Salesforce setzten mit ihrem „No Software“-Mantra voll auf browserbasierte Anwendungen. Als Amazon Web Services (AWS) und andere Cloud-Anbieter in den Markt eintraten, erleichterten sie es Softwareunternehmen, von kleinen Umgebungen auf ein globales Bereitstellungsmodell zu skalieren. Seitdem hat das Wachstum von SaaS-Diensten rasant zugenommen, sodass viele Softwareanbieter mittlerweile ausschließlich SaaS-basierte Services anbieten.

Zurück auf den Boden der Tatsachen

Der Hype um SaaS führte dazu, dass viele Organisationen versuchten, sämtliche Arbeitslasten in die Cloud zu verlagern – trotz finanzieller und technischer Hürden. „Cloud-first“ wurde zum Schlagwort und viele Unternehmen machten die gleichen Fehler wie zuvor: Im Bestreben möglichst innovativ zu sein, gaben sie ihre Datenhoheit auf und verloren mit der Rückkehr zur Anbieterbindung die Übersicht über Ausstiegsstrategien.

Zudem kam Unsicherheit hinsichtlich der Performance dieser Lösungen auf: Viele Nutzer machten vermeintlich langsame Browser für träge Anwendungen verantwortlich, ohne zu wissen, dass jeder Tab im Grunde eine eigene Anwendung war und entsprechend Ressourcen beanspruchte.

Darüber hinaus verbreiteten sich Sicherheitsmythen. Viele hielten browserbasierte Anwendungen für sicherer, obwohl manche Anbieter lediglich bestehende Clients in eine Webhülle packten und die gleichen Daten wie zuvor übermittelten – nur eben über einen Browser-Tab.

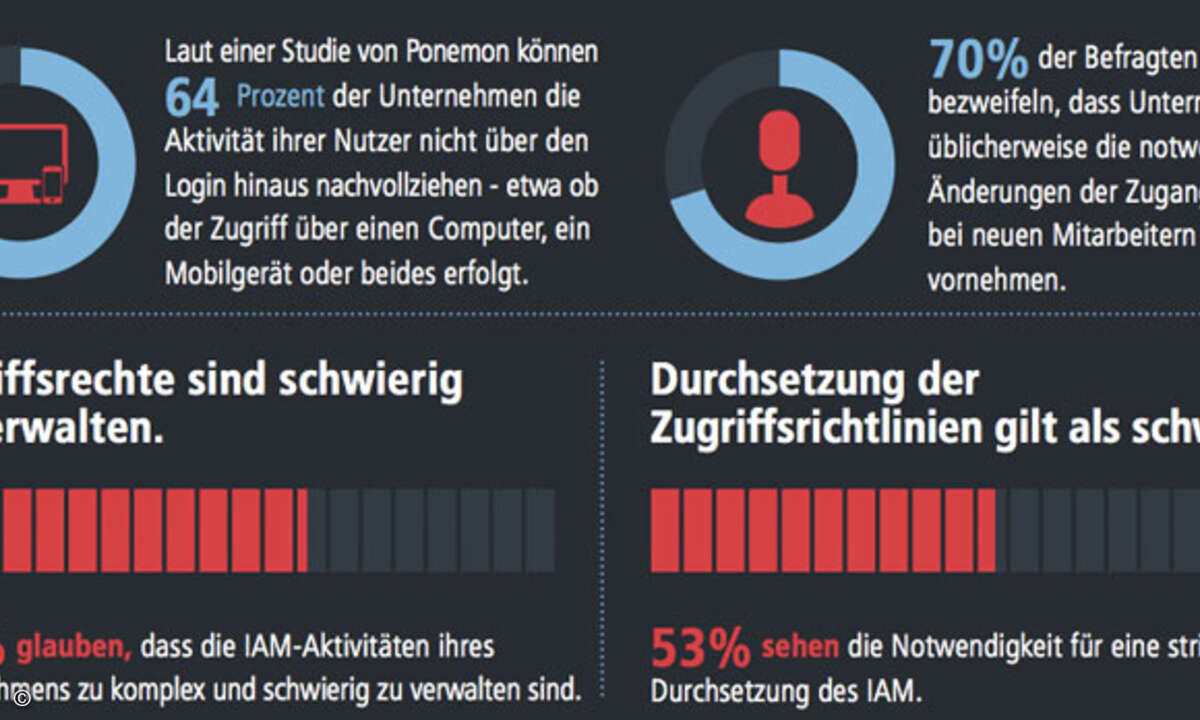

Außerdem musste die Kontrolle über Daten und Zugriffe, wie sie bei klassischen Lösungen durch Server-Based Computing und VDI etabliert war, für SaaS neu gedacht werden.

Anbruch einer neuen Realität

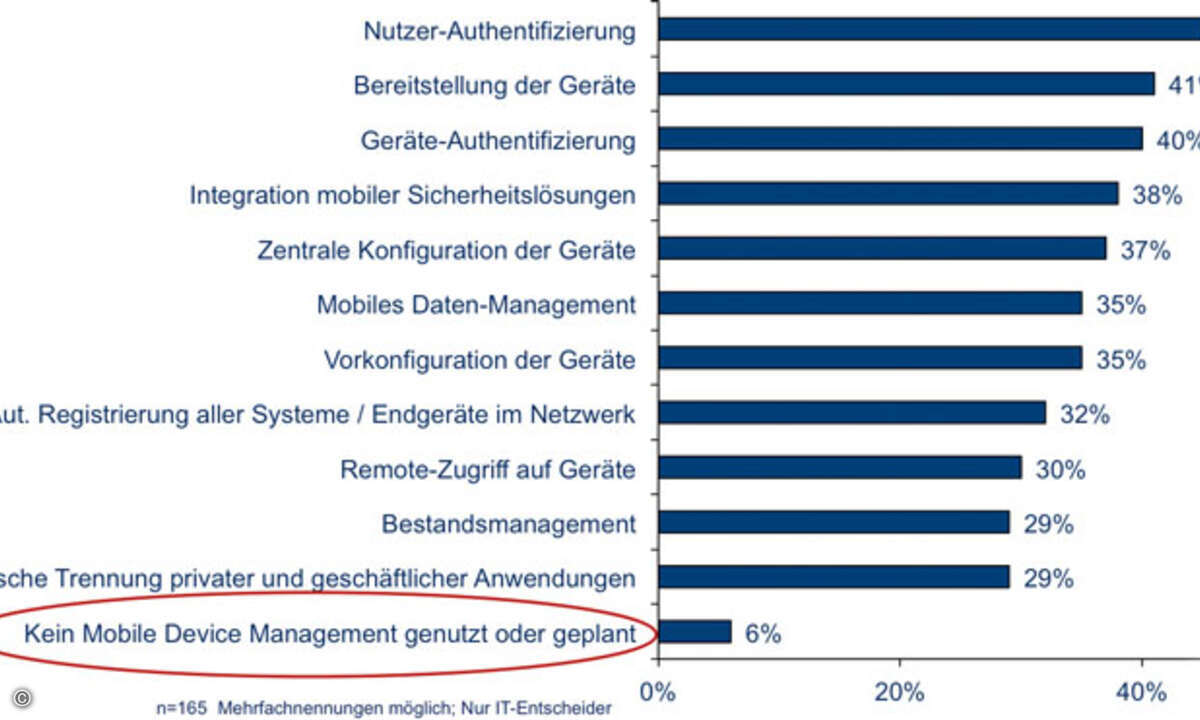

Die Anwendungsbereitstellung entwickelt sich stetig weiter. Eine aktuelle Studie von Parallels zeigt, dass 2025 mehr Unternehmen als jemals zuvor auf Cloud-Lösungen setzen. Weitere aktuelle Trends sind etwa der Einsatz von Containern und Microservices, sowie die Integration von KI in Geschäftsprozesse. Auch Edge Computing gewinnt an Bedeutung, was die Datenverarbeitung näher an den Endnutzer bringt, um Latenzzeiten zu reduzieren und die Performance zu steigern. Gleichzeitig rücken Themen wie Zero Trust Security, Automatisierung und Self-Service-Portale immer stärker in den Fokus der IT-Strategien.

Für Unternehmen bedeutet das: Die Vielfalt an Bereitstellungsmodellen wird weiter zunehmen. Die bisherigen Entwicklungen haben aber auch gezeigt, dass es eher unwahrscheinlich ist, dass eine Technologie innerhalb kurzer Zeit alle anderen vollständig verdrängt. Während die allgemeine Tendenz weg von lokal installierten Programmen und VDI-Lösungen und hin zu SaaS-Bereitstellungen geht, bewegt sich die Mehrzahl der Unternehmen derzeit in einem hybriden Szenario zwischen diesen beiden Ansätzen.

Zusammenfassend lässt sich feststellen, dass der Bereich der Anwendungsbereitstellung kontinuierlich evolviert. Um in einem solchen dynamischen Umfeld erfolgreich zu sein, sollten Unternehmen die eigenen Anforderungen und Ziele regelmäßig überprüfen und technologische Entwicklungen gezielt evaluieren, statt jedem kurzfristigen Trend zu folgen. Hybride Szenarien, die sowohl lokale als auch Cloud-basierte Anwendungen kombinieren, bieten zum Beispiel die nötige Flexibilität, um Innovationen schrittweise und kontrolliert einzuführen. Entscheidend ist, die technologische Basis so zu gestalten, dass sie anpassungsfähig bleibt und zukünftige Entwicklungen integriert werden können, ohne bestehende Prozesse zu gefährden.

Chris Marks ist Principal Outbound Product Manager bei Parallels.