Unterschiedliche Verfügbarkeit

Die Verfügbarkeit von Anwendungen hängt von vielen Faktoren ab. Wartungsarbeiten, Upgrades und Patches, Tests der Entwicklungsabteilung und nicht zuletzt menschliche Irrtümer können dazu führen, dass Anwender vorübergehend nicht auf Applikationen zugreifen können. Eine entsprechend ausgelegte Storage-Infrastruktur kann solche Ausfälle vermeiden.

Nicht alle Applikationen sind geschäftskritisch. Was für Exchange oder SAP gilt, muss nicht für

die Reisekostenabrechnung gelten. In vielen Fällen genügt es, wenn die Anwendung nicht binnen fünf

Sekunden, aber bis fünf Minuten nach einem Ausfall wieder zur Verfügung steht. Ein Unternehmen

sollte die eingesetzten Anwendungen jeweils mit einer entsprechenden Priorität und darauf

zugeschnittenen Anforderungen versehen, um sie dann der entsprechenden Storage- und Serverklasse

sowie dem zugehörigen Service-Level zuordnen zu können. Auch diese muss ein Unternehmen jeweils für

seine IT-Umgebung definieren. Die Storage- und Serverklassen mit den zugeordneten Service-Levels

ziehen jeweils unterschiedliche Maßnahmen zum Absichern mit sich. Ein Unterscheidungsmerkmal sind

dabei zum Beispiel die geforderten Uptime-Zeiten.

So legt das Unternehmen darüber individuelle Richtwerte für zeitliche und inhaltliche

Wiederanlaufpunkte nach einem Systemausfall fest. Die so genannte Recovery Time Objective (RTO)

definiert die Zeit, die zur Wiederherstellung verlorener oder beschädigter Daten benötigt wird. Per

Recovery Point Objective (RPO) wird bestimmt, wie viel Datenverlust maximal in Kauf genommen wird.

Das Maß dafür ist der Zeitabstand zwischen zwei Backups oder Replikation. Abhängig von dessen Länge

ist im schlimmsten Fall mit großem Datenverlust zu rechnen. Für Datenbankapplikationen

beispielsweise kann Replizikation zwingend sein. Je kritischer die Verfügbarkeit der Datenbank ist,

desto eher wird ein Synchronverfahren zum Einsatz kommen, um die Risiken Downtime und Datenverlust

gegen null gehen zu lassen.

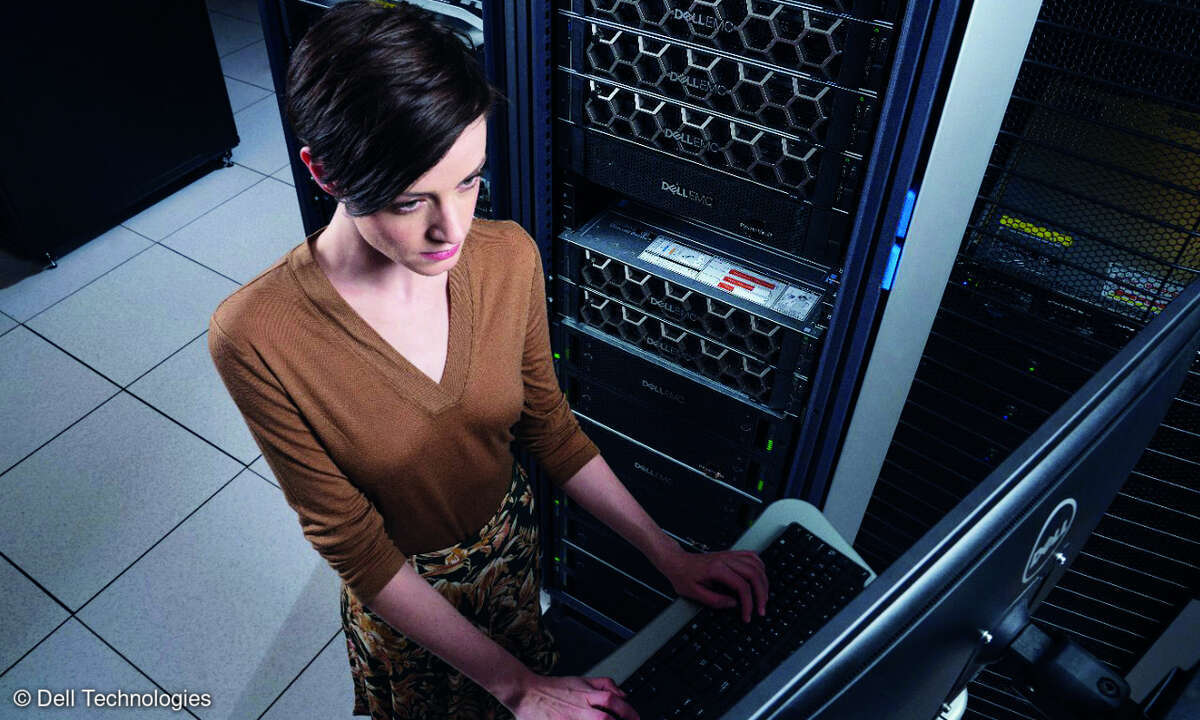

Storage-Architektur

Mit zunehmenden Verfügbarkeitsanforderungen steigen die Kosten für das Aufrechterhalten der

Service-Level. Zudem wird die IT-Infrastruktur komplexer, und es treten mehr potenzielle

Fehlerquellen auf. Bedienungsfehler und Applikationsfehler gelten als häufigste Gründe für

Betriebsunterbrechungen. Acht von zehn Fälle sind darauf zurückzuführen. Produktivumgebung sowie

Disaster-Recovery-Struktur lassen sich vereinfachen, indem die Daten auf einer möglichst

einheitlichen Storage-Architektur konsolidiert sind. So bietet Networked Storage gerade in

Verbindung mit Servervirtualisierung große Vorteile gegenüber dem Direct-Attached Storage, obwohl

sie größere Investitionen mit sich bringen: Eine einheitliche Architektur ermöglicht eine

protokollunabhängige Datenkonsolidierung für FC-SAN, IP-SAN und NAS sowie einheitliche, einfache

und automatisierbare Management-Tools und Prozesse, die menschliche Irrtümer auf ein Minimum

reduzieren.

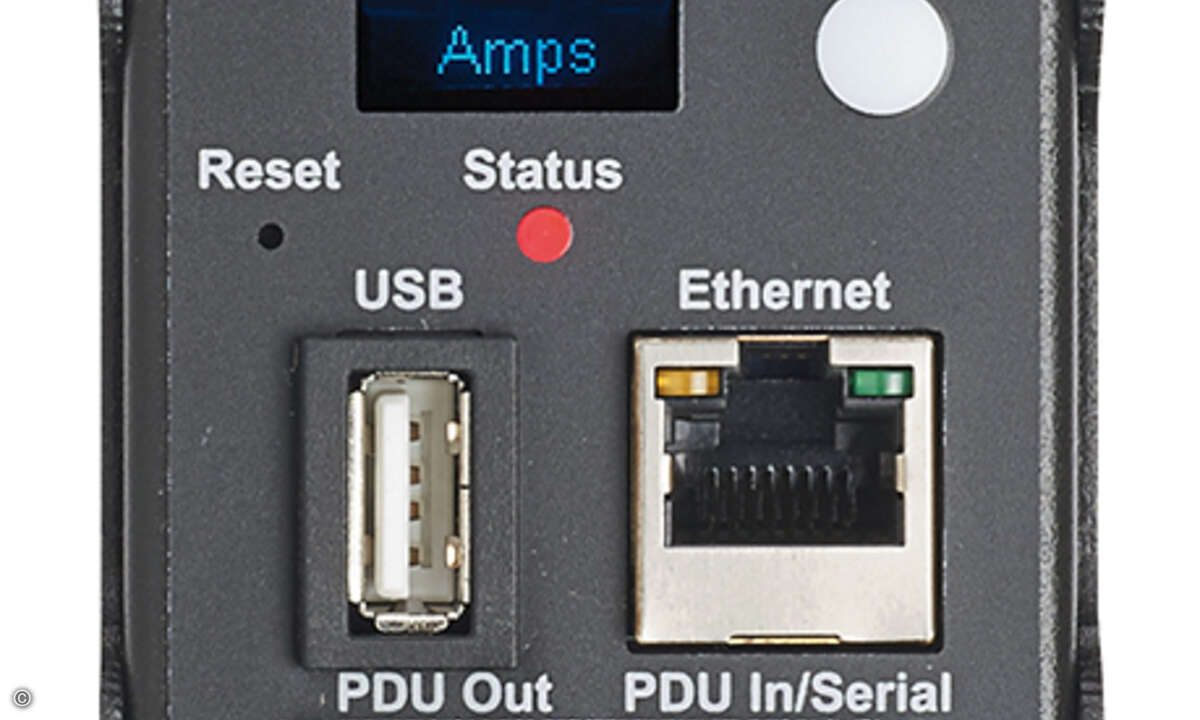

Redundanz

Um die Verfügbarkeit eines Storage-Systems hardwaretechnisch abzusichern, sind Single Points of

Failure zu vermeiden. Dies betrifft in erster Linie die Komponentenausstattung. Defekte Lüfter und

Netzteile sowie Fehler im Hauptspeicher können zu ungeplanten Ausfällen führen. Um diese

auszuschalten, müssen diese Komponenten redundant ausgelegt sein und beim Ausfall ein möglichst

automatisches Failover nach sich ziehen.

Darüber hinaus sollte das Backup-System mit RAID-Arrays ausgestattet sein. Um Hochverfügbarkeit

zu gewährleisten, sollte der RAID-Level mehr als RAID 5 bieten. Das gilt insbesondere, wenn

SATA-Disks eingesetzt werden. Dieser Plattentyp ist relativ preiswert und bietet eine hohe

Kapazität pro Laufwerk. Sie sind aber nicht so stabil wie FC-Platten. So eignen sich hier zum

Beispiel RAID-6-Implementierungen. Diese Systeme tolerieren bis zu zwei gleichzeitige

Plattenausfälle in einer RAID-Gruppe vor Abschluss der Wiederherstellung.

Skalierbarkeit on the fly

Aufgaben wie Erweiterungen, Upgrades oder Austauscharbeiten an bestehenden Systemen sind

unumgänglich, sollten aber ohne geplante Downtime durchführbar sein. Beim Storage ist

Skalierbarkeit "on the fly", also ohne Betriebsunterbrechung, heute Standard.

Virtualisierungstechniken wie das Thin Provisioning sorgen dafür, dass Applikationen Speicherplatz

nach Bedarf und ohne Effekt auf den laufenden Betrieb zugewiesen werden kann. Dies lässt sich

mithilfe von Schwellenwerten auch automatisieren. Somit sollten Meldungen wie "out of disk space"

der Vergangenheit angehören.

Auch Disk Shelves sind heute schnell und ohne Ausfallzeit austausch- und erweiterbar. Bei

besonders hohen Verfügbarkeitsanforderungen ist ein System mit zwei Storage-Controllern eine

einfache und verlässliche Methode zum Upgrade von Hard- und Software. Während ein Controller

aktualisiert wird, übernimmt der zweite den Datenservice und umgekehrt. So lassen sich ausfallfrei

Hardwarekomponenten erweitern oder austauschen, und Software ist mit minimaler Unterbrechung

aktualisierbar.

Cluster

Auf Systemebene sind Cluster die Standardmaßnahme für Hochverfügbarkeit und Ausfallsicherheit.

Maximalen Schutz bietet eine Konfiguration, bei der Controller, Daten und Verbindungen zweifach

abgesichert sind. Sowohl Hardware als auch Software eines Hochverfügbarkeits-Clusters sollten frei

von Single Points of Failure sein. Hochverfügbarkeits-Cluster finden ihren Einsatz besonders in

kritischen Umgebungen, für die nur wenige Minuten Ausfall im Jahr tolerierbar sind.

Disaster Recovery

Aus Kostengründen stufen Unternehmen oft nur fünf bis zehn Prozent ihrer Applikationen als

absolut unternehmenskritisch ein und integrieren sie in eine Disaster-Recovery-Lösung mit

synchroner Replikation. Dabei handelt es sich um die größtmögliche Absicherung. Die unmittelbar

darunter liegende Kategorie der geschäftskritischen Applikationen wird nicht mehr berücksichtigt,

sodass bei ihnen im Ernstfall auf das Backup zurückgegriffen werden muss. Je nach Applikation

kostet das wertvolle Zeit – vor allem dann, wenn der Administrator erst eine Recovery-Umgebung

aufsetzen muss, bevor er die Daten einspielen kann. Oft entspricht diese Einstufung nicht den für

die Anwendungen einmal festgelegten Verfügbarkeitsniveaus und RPO-Werten. Unter dem Gesichtspunkt

der Hochverfügbarkeit wäre es besser, diese festgelegten Anforderungen auch in der

Storage-Infrastruktur abzubilden.

Um Standortausfällen entgegenzuwirken, bietet sich eine synchrone Replizierung an. Sie sorgt für

die räumliche Trennung eines Clusters auf zwei Rechenzentren in einer Campus-Umgebung oder einem

städtischen Ballungsraum. Auf dem Markt sind auch Lösungen verfügbar, die

Hochverfügbarkeits-Cluster mit dem Failover des kompletten Standorts kombinieren. Wenn die Lösung

neben Anwendungen mit Hochverfügbarkeitsanspruch auch weniger anspruchsvolle Absicherungsaufgaben

mit einbinden kann, eignet sie sich als Komplettlösung mit einheitlicher Managementoberfläche.

Je größer die Entfernung zwischen Quell- und Zielsystem wird, desto mehr empfiehlt sich die

asynchrone Spiegelung. Aufgrund einer Verzögerung von ein paar Sekunden im Cluster wird diese

Methode für RPOs zwischen einer Minute und einem Tag eingesetzt und gewährleistet selbst bei

schweren Systemausfällen hohe Ausfallsicherheit für Applikationen. Mit der asynchrone

Datenspiegelung kann ein Administrator zudem Daten von einem Fibre-Channel-Primärspeicher auf

kostengünstigere SATA-Platten replizieren. Aufgrund der großen Entfernungen sollte das System mit

einer Snapshot-Technik arbeiten, die nur blockbasierte inkrementelle Änderungen über das Netz

überträgt, um Netzwerkbandbreite zu sparen.

Mit Ausnahme weniger unternehmenskritischer Applikationen, die Storage-Cluster sowohl im

primären als auch sekundären Rechenzentrum erfordern, ist die asynchrone Spiegelung eine

kostengünstige Lösung für die meisten Anwendungen.

Fazit

Die Hochverfügbarkeit von Applikationen hängt von zwei wesentlichen Aspekten einer

Storage-Architektur ab: Diese sollte Fehler und Systemausfälle zum einen frühzeitig erkennen und

durch selbst regulierende Prozesse vermeiden können. Zum anderen sollte sie über eine schnelle und

reibungslose Recovery-Funktion verfügen, die bei dennoch auftretenden Fehlern und Systemausfällen

den Schaden in Grenzen hält. Aufgrund des enormen Datenwachstums sind Lösungen sinnvoll, die eine

Ausfallsicherheit für Storage und Applikationen gewährleisten und die der Administrator auch

flexibel an veränderte Rahmenbedingungen anpassen kann.