Port-Nummern-Klassifizierung

Die Funktionsweise bei der Priorisierung ist im Grunde immer die gleiche. Pakete werden auf den Gateways und Knotenpunkten anhand dieser Unterscheidungsmerkmale in den Headern den Warteschlangen oder Queues unterschiedlicher Priorität zugeordnet.

Die Queues höherer Priorität werden dann entsprechend der Policy der jeweiligen Queuing-Mechanismen bevorzugt weitergeleitet. Welches Prinzip dieser Bevorzugung zu Grunde liegt, ist unterschiedlich. In vielen Fällen sollte eine Priorisierung aber nicht ohne eine Festlegung einer gewissen Maximalbandbreite erfolgen. Diese könnte beispielsweise so aussehen, dass die Queue mit der höchsten Priorität nur eine bestimmte maximale Bandbreite erhält.

Ohne diese Begrenzung kann es passieren, dass bei einer Überlast ausschließlich hoch eingestufte Pakete transportiert werden, während sich die Pakete in den unteren Queues stauen, bis sie verworfen werden. Ein solchen Verhalten ist bei reinen Strict-Priority-Mechanismen typisch.

Das Festlegen einer minimalen Bandbreite für Pakete niedrigerer Priorität erfüllt den selben Zweck. Moderne Switches verschieben diese Grenzen dynamisch, abhängig vom momentanen Verkehr. Zu beachten ist jedoch, dass bei voller Ausreizung der entsprechenden Bandbreiten und der den Queues zugeordneten Buffern auch Pakete höherer Priorität keine Chance mehr haben, transportiert zu werden und ebenso verfallen können.

Obwohl eigentlich alle aktuellen Netzwerkgeräte das ToS- beziehungsweise DS-Byte auswerten können, ist diese Funktion in den seltensten Fällen aktiviert und wird höchstens im In-House-Bereich oder anderen abgegrenzten und kontrollierbaren Umgebungen genutzt.

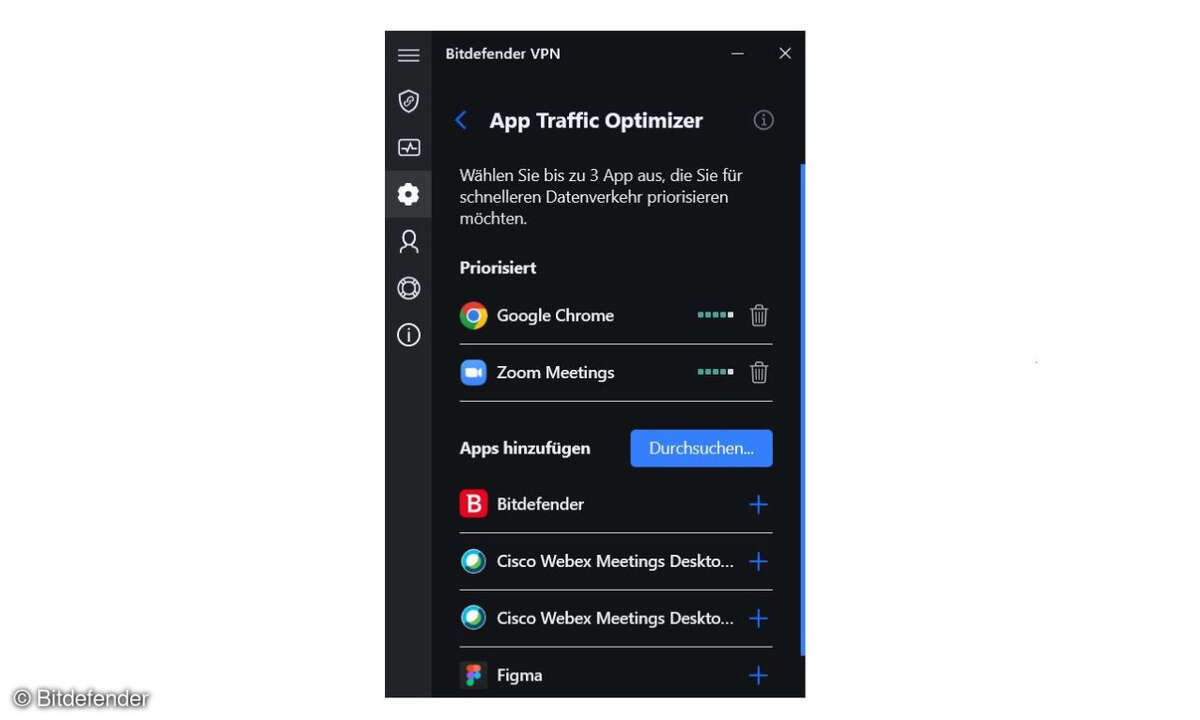

Die meisten Applikationen sowie Windows-Betriebssysteme beherrschen die Klassifizierung mit ToS und Diffserv nicht. Daher erfolgt zumeist eine erste Klassifizierung nach Diensten im Edge-Bereich sinnvoller Weise über die benutzten TCP- oder UDP-Port-Nummern.

Hierbei weist der Edge-Switch anhand der erfolgten Klassifizierung den Paketen die entsprechende Hardware-Queue zu. Optional können die Klassifizierungen dann auch auf ToS- beziehungsweise Diffserv-Werte gemappt werden. Dabei werden die schon vorhandenen Werte überschrieben. Diese generierten ToS- und Diffserv-Werte können dann die Core-Switches weiter verwenden, ohne dass sie erneut ein Mapping durchführen müssten.

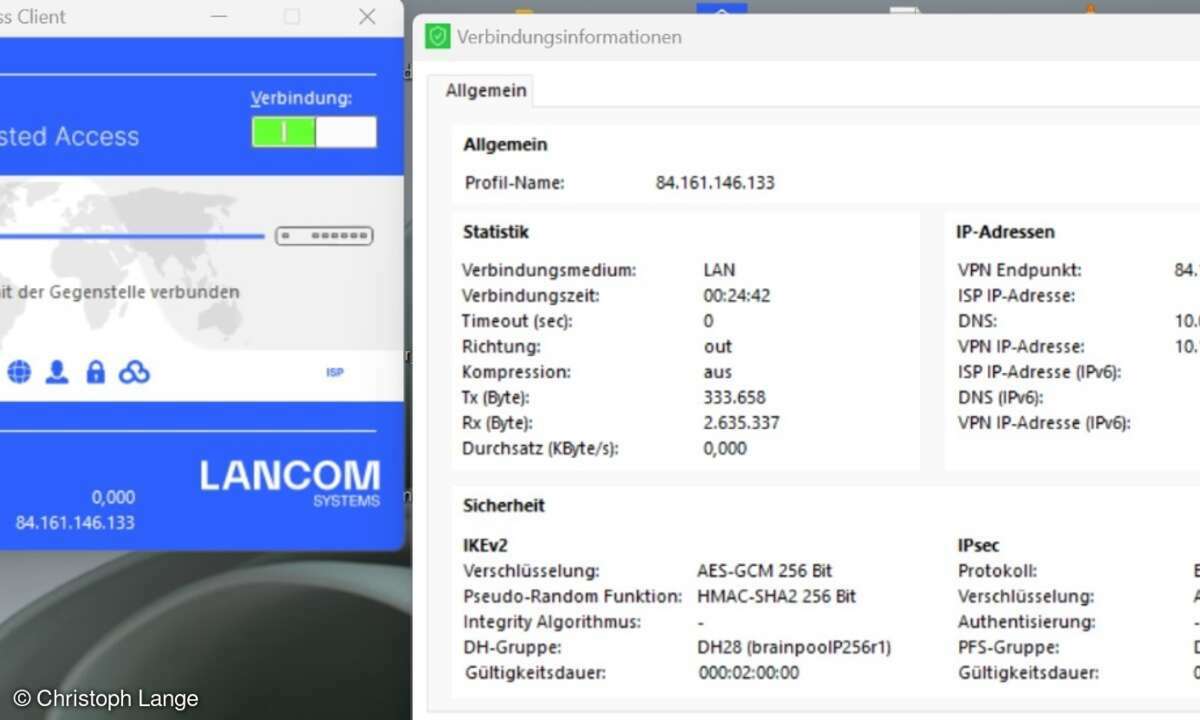

Im vorliegenden Vergleichstest wurden zur Festlegung der Prioritäten die jeweiligen UDP-Portnummern gesetzt. Die Klassifizierung der einzelnen Datenströme erfolgte durch den jeweiligen Switch, der die Datenströme empfing.

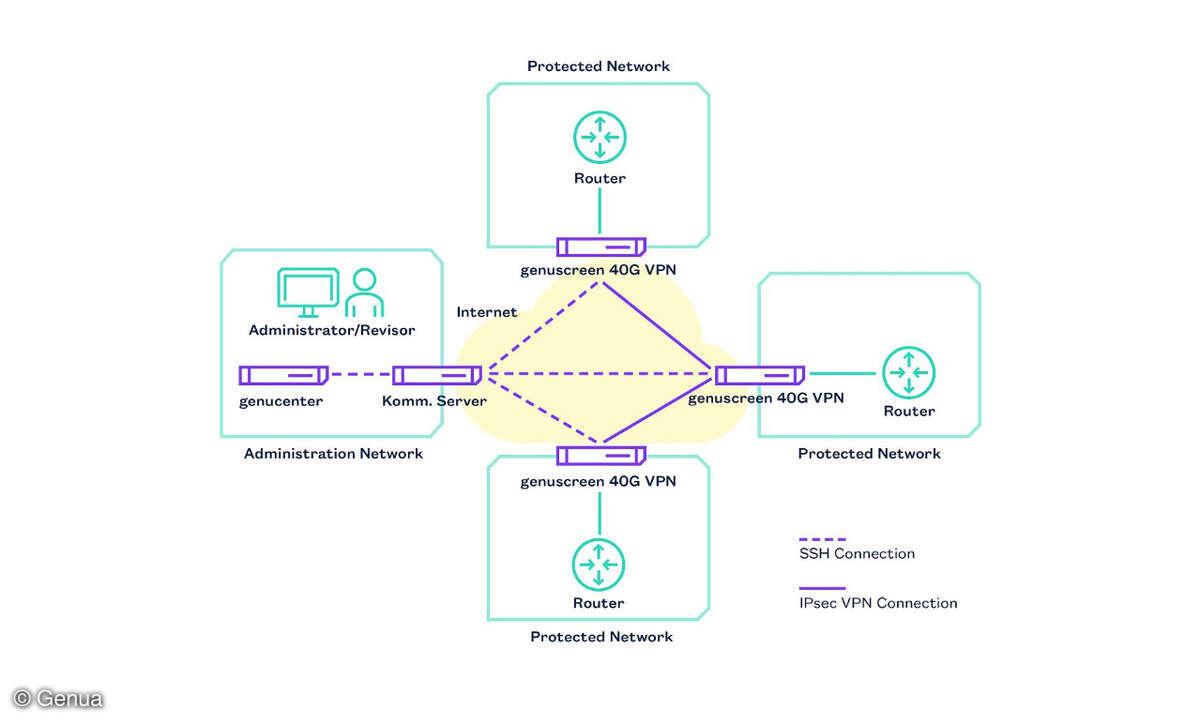

Generell erfolgt das Routing von Datenströmen nach Merkmalen, die in den Headern der Datenpakete festgelegt sind. Hierfür werden in der Praxis beispielsweise Port-Nummern oder IP-Adressen verwendet. Diese Mechanismen sind bereits im Standard-Linux implementiert. Somit sind alle Systeme, die auf Linux basieren, von Hause aus bereits für den Einsatz in Unified-Communications-Umgebungen geeignet.

Allerdings muss die Funktionalität auch vernünftig im GUI abgebildet sein. Voraussetzung ist dann noch, dass die erforderliche Rechenleistung für die entsprechende Funktionalität auch vorhanden ist. Alternativ ist es auch möglich, zur Verbesserung der Performance entsprechende Switch-Module zu integrieren, die eine Überlastung der Appliance vermeiden können.

Dies ist möglich, indem das Switch-Modul dazu eingesetzt wird, um mittels Bandbreitenlimitierung eine Überlastung der Filterfunktionalität zu verhindern. Wie gut aktuelle Security-Appliances in der Praxis sind, musste eine Reihe von Systemen in unseren Real-World Labs an der FH Stralsund beweisen.

Dipl.-Ing. Thomas Rottenau,

Prof. Dr. Bernhard G. Stütz,

dg@networkcomputing.de