Garantiert zum Ziel

Wer seine Pakete in weniger als 30 Millisekunden vom Start bis zum Ziel bringen muss, benötigt umfassende Policies, die diese Übertragungszeit garantieren. Eine Quality-of-Service-Strategie regelt diesen Vorgang.

Traffic-Shaper sind das Flaggschiff der QoS-Technologien. Sie können tief in die einzelnen Pakete hineinblicken.

Einige Pizza-Dienste werben mit dem Versprechen, eine heiße Pizza in weniger als 30 Minuten bis an die Tür zu liefern. Damit ist eine Dienstleistung – der manchmal zweifelhafte Genuss eines lauwarmen, belegten Teigs –, die innerhalb von bestimmten Parametern garantiert ist. Die Pizza braucht 25, 27 und manchmal auch 31 Minuten bis zur besagten Tür, aber man kann einigermaßen sicher sein, dass sie nicht viel länger benötigt.

Das gleiche System lässt sich auch, mit einigen Einschränkungen, für Quality-of-Service (QoS) anwenden. Das Produkt sind die Daten. Geschwindigkeit ist von größter Bedeutung, und auch die besten Techniken können letztlich nicht immer garantieren, dass die Qualität stimmt.

Leider wurden weder Ethernet, IP noch das Internet mit einem Blick auf garantierte Lieferung und Bandbreiten-Priorisierung entwickelt. Die Ping-Response-Zeiten variieren, der Durchsatz

ist nicht konstant, und manchmal ist das Netzwerk so beschäftigt, dass es nicht möglich ist, eine Session überhaupt zu starten. Die Ressourcen des Netzes – verfügbare Bandbreite, WAN-Nutzung, maximale Anzahl der gleichzeitigen Sessions oder Kapazität der Router – sind immer eingeschränkt. Die Unternehmen klagen beispielsweise nicht selten über schleppend langsame VPN-Verbindungen zu Außenstandorten. Das ist allerdings die Folge von Web-Nutzung und nicht von mangelnder Bandbreite.

Vier Problembereiche sind die hauptsächlichen Ursachen für Schwierigkeiten bei der Übertragung von konvergenten Paketen und machen den Einsatz von QoS zur Voraussetzung für die qualitativ hochwertige Kommunikation.

- Verzögerung: auch als Latenz bezeichnet. Hier ist die Zeit gemeint, die ein Paket benötigt, um vom Start bis zum Ziel zu gelangen. Mehrere Faktoren führen zu einer längeren Übertragungsdauer. Hierzu gehören die Auslastung der verfügbaren Bandbreite, ein Mangel an Ressourcen, beispielsweise CPU oder RAM, auf einem bestimmten Netzwerk-Gerät, die zu überbrückende Distanz und auch die Art der Verbindung. Verzögerungen sind bei Übertragungen immer vorhanden und lassen sich auch nur mit Einschränkungen verringern. So ist es technisch nicht möglich, eine Übertragung über einen Satelliten in weniger als 500 Millisekunden durchzuführen. Die minimal mögliche Latenzzeit wird immer durch die Signalgeschwindigkeit und die zu überbrückende Strecke definiert.

Echte QoS-Funktionalität kann nur im internen Netzwerk existieren und endet am Internet-Router. ISPs und Internet-Backbone-Provider müssen die Unternehmens-QoS-Policies nicht übernehmen, und es ist davon auszugehen, dass sie diese einfach ignorieren. Ist also mehr Bandbreite oder eine QoS-Implementierung der richtige Weg? Das »Mehr Bandbreite kaufen«-Argument ist einfach: Bandbreite ist billig, und QoS ist kompliziert. Mit ausreichender Kapazität wird QoS überflüssig. Das Internet legt ständig an Kapazität zu, und technische Fortschritte sorgen für höhere Geschwindigkeiten.

Diese Argumentation greift auf der LAN-Seite besser als im WAN. Gigabit-Ethernet ist verfügbar, und die meisten Unternehmen nutzen die Kapazitäten kaum voll aus, ganz zu schweigen von den Möglichkeiten mit dem kommenden 10-Gigabit-Ethernet. Die WAN-Geschwindigkeiten auf der anderen Seite sind nicht so schnell mit gewachsen, und es ist üblich, dass die Internet-Verbindung etliche Male pro Tag stockt. Viele QoS-Funktionen sind heute bereits in den Infrastruktur-Produkten integriert, einschließlich Multipurpose-Security-Boxes, VPN-Gateways und Router.

Was beim Bandbreiten-Argument oft übersehen wird, ist der menschliche Faktor. Wo Bandbreite im Überfluss vorhanden ist, findet irgend jemand einen Nutzen dafür. Das ist vergleichbar mit der Verkehrssituation auf der Straße. So hat die Stadt New York in den 30er Jahren zwei neue Brücken gebaut, um die Staus auf der bis dahin einzigen Brücke zu beenden. Kaum waren die neuen Brücken fertig, staute sich der Verkehr auf allen dreien, trotz der höheren Kapazität. Mit der explosionsartigen Nutzung von gemeinsam genutzten Dateien, P2P oder Streaming-Media sollte Bandbreite auch nicht als endlos vorhanden angesehen werden.

Einige unnötige Downloads lassen sich mittels Content-Filter blocken, vorausgesetzt, die Benutzer wissen nicht, dass sich der verschlüsselte HTTPS-Verkehr nur sehr schwer blocken lässt. Aber selbst wenn der Datenverkehr den Policies entspricht, ist das nicht immer zu Gunsten des Unternehmens und kann zu heftigen Problemen führen. So legt ein Attachment mit 5 MByte mit einem 100 Personen umfassenden Verteiler viele Netze lahm. Anwender mit Highspeed-Verbindungen belegen einen Großteil der verfügbaren Bandbreite und lassen Benutzer mit DSL-Verbindungen quasi verhungern. Mit QoS lässt sich sicherstellen, dass alle Anwender »zu ihrem Recht« kommen.

Und dann wäre da noch VoIP. Viele Administratoren planen zur Zeit Pilotprojekte, oder diese laufen bereits. Hier muss eine QoS-Lösung her. Selbst kleinere Spitzen in der Bandbreiten-Auslastung führen zu Aussetzern in der VoIP-Verbindung. Ohne eine Garantie, dass die Sprache über IP genau so gut arbeitet wie die klassische Telefonie, ist das VoIP-Projekt schnell gestorben.

- Jitter: Dieser Begriff bezeichnet die Schwankungen in der Verzögerung zwischen den einzelnen Paketen. Es ist nahezu nie der Fall, dass zwei Pakete mit exakt der gleichen Latenz an ihr Ziel gelangen. Das hat zur Folge, dass der Paketstrom nicht in der gleichen Reihenfolge ankommt, mit der er abgeschickt wurde. Wenn die Bandbreite gut ausgelastet ist, kommt es zu längeren Verzögerungen. Für Anwendungen wie Datei-Downloads oder Web-Browsing ist das kein größeres Problem. Für Video-Streaming oder VoIP bedeutet ein zu hoher Jitter einen großen Qualitätsverlust. QoS hilft hier mit einer größeren Bandbreitenzuteilung für Streaming-Traffic oder mit einer erhöhten Puffer-Größe.

- Paketverlust: In einer überlasteten Umgebung kommt es zu mehr oder minder großen Paketverlustraten oder gar zu einem Abbruch und erneutem Aufbau einer Verbindung. Für Echtzeitanwendungen hat das gravierende Folgen. Nicht nur fehlen Informationen im Datenstrom, die verlorenen Pakete müssen vielmehr erneut geschickt werden, wodurch das Problem schlimmer wird. QoS-Techniken ermöglichen, die Bandbreite für bestimmte Protokolle oder Anwendungen nur eingeschränkt zu erlauben, wodurch sich eine Überlastung des Systems vermeiden lässt.

- Bandbreitennutzung: Die Kontrolle über die Nutzung der Bandbreite ist ein wesentlicher Grund für den Einsatz von QoS-Techniken. FTP-Verkehr und Streaming-Video beispielsweise benötigen recht weite Bandbreiten. Auch Remote-Control-Software hat sich in einigen Unternehmen zu einem Problem entwickelt und die Leistungsfähigkeit des Netzwerks und hierbei insbesondere der Web-Server geschmälert.

Die Kontrolle der Bandbreitennutzung ist ganz besonders wichtig, wenn Bandbreite nicht im Überfluss vorhanden ist. Mit QoS erhalten die wichtigsten Anwendungen wie Sprache oder auch Citrix, Netzwerk-Management oder Datenbank-Abfragen den Vorzug gegenüber den weniger kritischen Applikationen.

Den Schaden, den ein Web-Browser anrichten kann, sollte man nicht unterschätzen. Die meisten QoS-Geräte erlauben es, die minimale und maximale Übertragungsrate pro Protokoll zu definieren. Fortgeschrittene Produkte gehen noch einen Schritt weiter und lassen den Administrator die Übertragungsraten pro Session festlegen. So kann der IT-Verantwortliche spezifizieren, dass Streaming-Video-Session mit einem Minimum von 100 KBit/s arbeiten, insgesamt aber nicht mehr als 1 MBit/s beanspruchen dürfen. Zudem können bestimmte Anwender je nach Bedarf mit einem höheren Anspruch auf Bandbreite ausgestattet werden.

In Lagen gedacht

Bei der Auswahl einer QoS-Implementierung ist ein Blick auf das OSI-Modell wichtig. Die meisten Produkte arbeiten entweder auf Layer-4 oder auf Layer-7. Auf Layer-4 werden nur die Port-Nummern und IP-Adressen untersucht. Das war lange Zeit völlig ausreichend, da jedes Protokoll mit einem eigenen Port arbeitete. Heute erlauben die meisten Firewalls, dass die Pakete von jedem Gerät durch Port 80 laufen. Hier arbeiten die Anwender unter anderem mit Streaming-Video, Web-Mail, P2P-Dienste und getunnelten SSH-Verbindungen. Einige dieser Aktivitäten nutzen HTTP oder das verschlüsselte HTTPS, was wiederum zu Problemen bei Content-Filtern führen kann.

Für Systeme, in denen die Anwender sehr stark kontrolliert werden oder in den meisten Fällen nur wenig technisch bewandert sind, reichen Layer-4-Mechanismen bereits aus. Wer aber für ein System mit technisch versierten oder experimentierfreudigen Anwendern verantwortlich ist, sollte keinesfalls auf Layer-7-QoS verzichten. Zudem entgehen dann auch einige nützliche Features. So können einige Produkte, wie QoS-Works von Sitara die Daten anhand des HTTP-Contents identifizieren. So lässt sich beispielsweise festlegen, dass HTML-Text mit einer höheren Priorität versehen ist als Bilder oder eingebundene Multimedia-Dateien. Andere Layer-7-Lösungen erkennen, ob es sich bei der HTTP-Session um eine Web-Seite oder um eine MP3-Datei handelt und es lassen sich entsprechende Policies erstellen.

Der einfache Weg

Über die Entscheidung zwischen Layer-4 beziehungsweise Layer-7 hinaus reicht die Palette der möglichen QoS-Lösungen von ganz einfach bis hin zu sehr kompliziert. Handelt es sich um begrenzt verfügbare Ressourcen, heißt die Lösung Überprovisionieren. Bei zu wenig Bandbreite hilft eine weitere Leitung. Wenn der Router zu viele Pakete verliert, sorgt ein RAM-Upgrade für Abhilfe. Was sich eher nach Pfusch anhört, ist aber letztendlich ein gangbarer und oft auch notwendiger Schritt auf dem Weg hin zu einer guten QoS-Lösung.

Andere Probleme lassen sich gar nicht lösen, auch nicht mit der ausgefeiltesten QoS-Lösung. So ist es nicht möglich, Video-Streams über eine 802.11b-WLAN-Verbindung in Echtzeit zu schicken. Qualitativ hochwertiges Digital-Video arbeitet mit 25 bis 36 MBit/s, und WLAN stellt nur 11 MBit/s zur Verfügung. In der Praxis sind meistens nur 4 bis 6 MBit/s nutzbar. Wer eine 128-kBit/s-ISDN-Verbindung betreibt, kann nicht viele gleichzeitige VoIP-Sessions erwarten. Jede QoS-Methode auf Routern, Firewalls und anderen Infrastruktur-Komponenten fordert eine höhere Leistungsfähigkeit von diesen Geräten. Das kann dazu führen, dass das Unternehmen größere Investitionen tätigen muss.

Bevor allerdings im großen Stil investiert wird, lohnt sich ein genauer Blick auf das Problem. Beklagt sich eine Außenstelle beispielsweise über entsetzlich langsame Verbindungen, wäre die einfachste Lösung, eine weitere Leitung hinzuzufügen. Das funktioniert zwar, kann sich aber als Kostenfalle herausstellen. Eine Analyse des Verkehrs zeigt auf, was die Anwender überhaupt über die Leitung schicken. Handelt es sich um Firlefanz wie Streaming-Internet-Radio, löst sich das Problem mittels QoS wesentlich kostengünstiger und für das Unternehmen auch produktiver. Über entsprechende Policies können überflüssige und nicht notwendige Übertragungen ausgeschlossen und so wieder für ausreichend Bandbreite gesorgt werden.

Kompression stellt eine weitere Methode dar, Bandbreite einzusparen. Bei Grafiken lässt sich die Auflösung oder die Farbdichte reduzieren, Videos mittels effizienter Codecs wie MPEG oder DivX komprimieren und Audio-Dateien mit niedrigerer Bit-Rate codieren oder von Stereo in Mono konvertieren. Allerdings lassen sich diese Maßnahmen nur bis zu einer gewissen Grenze durchführen, bevor es zu einem gravierenden Qualitätsverlust kommt.

Alternativ stehen Komprimierungsmethoden bereit, die nicht zu einem Verlust führen, wie zip, gzip oder Aladdin-Stuffit. Bei dieser Komprimierung leidet die Qualität nicht, aber die Größe der Dateien wird auch nicht wesentlich reduziert. Zudem ist die verlustfreie Komprimierung bei bereits komprimierten Daten, wie JPEG, MP3 oder Video, nicht effizient.

Ein weiterer Weg ist die HTTP-Kompression auf Web-Servern. Die Kompression wurde bereits für HTTP 1.0 definiert, allerdings als Option für den Client-Support. Mit HTTP 1.1 müssen die Clients die Kompression unterstützen. HTML lässt sich sehr effizient komprimieren. In den Real-World Labs schafften es die Testredakteure einen Text mit einer Größe von 8 GByte auf eine einzige standardisierte CD zu pressen. Der Nachteil: Es kommt zu zusätzlichem CPU-Overhead.

Hersteller wie Expand Networks, Packeteer oder Peribit Networks haben Site-to-Site-Compression-Appliances im Angebot. Diese Geräte sitzen hinter den Internet-Routern in den Zweigstellen und komprimieren alle ausgehenden Dateien. Die Produkte sind kostengünstig und maximieren die Leistungsfähigkeit der WAN-Verbindung. Falls diese einfachen Methoden alle nicht zum gewünschten Erfolg führen, ist es an der Zeit, sich mit umfassenderen Lösungen auseinander zu setzen.

Komplexe Lösungen

Anders als die Daten, die über das Internet gehen, kann der Verkehr innerhalb eines LANs QoS-Policies auch über mehrere Subnets hinweg aufrechterhalten. Die Daten sind in Klassen aufgeteilt, nach Protokoll, IP-Range, MAC-Adresse oder Flow. Die meisten Systeme bezeichnen

eine vollständige TCP-Session als einen Flow. Wenn beispielsweise ein Web-Benutzer den TCP-Handshake, einen HTTP-Transfer und anschließend die Session beendet, ist das alles Bestandteil des gleichen Flows. QoS-Geräte wenden Policies für eine ganze Klasse, für jeden einzelnen Flow oder für eine Kombination aus beiden an.

Um QoS zu erreichen gilt es die Type-of-Service-Bits, kurz ToS, zu modifizieren. ToS besteht insgesamt aus 8 Bits, die zwischen dem neunten und dem sechzehnten Bit des IPv4-Headers liegen. Die Bits 0, 1 und 2 des ToS-Felds definieren die relative Priorität eines Pakets auf einer Skala von 0 bis 7. Bit 3 weist auf normale oder niedrige Verzögerung hin, Bit 4 den normalen oder hohen Durchsatz, und Bit 5 definiert normale oder hohe Zuverlässigkeit. Die zuständige RFC-791 stellt fest, dass höchsten zwei dieser drei Optionen zum Einsatz kommen dürfen. Die Bits 6 und 7 sind für künftige Anwendungen reserviert.

Es gibt keine offiziellen Richtlinien, wie mit diesen Informationen umzugehen ist. Es wird davon ausgegangen, dass die Netzwerke Pakete mit niedriger Priorität zugunsten derer mit höheren Qualitätsanforderungen fallen lassen. Daten mit gleicher Priorität lassen sich nicht weiter differenzieren, und Network-Control-Traffic wie RIP oder ICMP-Messages haben üblicherweise die höchste Priorität. Damit stehen den Netzwerk-Verantwortlichen letztendlich sechs effektive Levels zur Verfügung.

Allerdings werden die Bits 1 bis 5 nicht von allen Herstellern gleich behandelt. So jedenfalls die Aussage von Cisco (siehe www.cisco.com/ warp/public/cc/pd/iosw/iofwft/prodlit/difse_wp.htm). Darüber hinaus wurden die Bits 3 bis 6 in der RFC-1349 neu definiert und sehen fünf Klassifizierungen vor: Verzögerung minimieren, Durchsatz maximieren, Zuverlässigkeit maximieren, Kosten minimieren oder normaler Service. Es kann lediglich eine Klassifizierung ausgewählt werden, und man hat dennoch keine garantierte Bandbreiten-Kapazität. In IPv6 ist das ToS-Oktett nicht mehr vorgesehen und wird durch ein »Traffic-Class-Octet« ersetzt. Letztendlich hat ToS, zumindest im LAN, ausgedient.

Integrated-Services, kurz Intserv, sorgen für durchgängiges QoS, indem ein bestimmtes Level an verfügbarer Bandbreite bereitgestellt wird. Das setzt voraus, dass jeder Router im Netzwerk mit dieser Funktionalität ausgestattet ist. Hier kommen zwei QoS-Levels zum Einsatz: garantierter Service und kontrollierte Last. Der garantierte Service stellt sicher, dass ausreichend Bandbreite verfügbar ist und keine weiteren Verzögerungen durch Queuing-Mechanismen aufkommen. Mit der »kontrollierten Last« verhält sich diese Übertragung im Netzwerk wie traditioneller IP-Verkehr in einer kaum ausgelasteten Umgebung auf Best-Effort-Basis und ohne starke Garantien. Bleiben Kapazitäten frei, stehen sie für Nicht-Intserv-Übertragungen bereit.

Problem Skalierbarkeit

Ein Host löst eine Intserv-QoS-Session aus, indem er einen Resource-Reservation-Protocol-Request, kurz RSVP, sendet. RSVP ist ein Signalisierungsprotokoll, das Ressourcen über das gesamte Netzwerk je nach Bedarf reserviert. Wenn jeder Hop entlang der Route die Vorgaben erfüllen kann, nimmt das Netzwerk die Reservierung an, falls nicht, lehnt es sie ab. Jeder Router unterhält eine Tabelle der Intserv-Sessions. Falls der Sender ausfällt oder die Verbindung verliert, entfällt die Reservierung automatisch.

Ein Problem von Intserv ist die Notwendigkeit, den Status über das gesamte Netzwerk zu halten. Das taxiert die ohnehin meist eingeschränkten CPU- und RAM-Ressourcen der Router. Zudem muss jedes Gerät entlang des Pfads, einschließlich der Endpunkte, Intserv-fähig sein. In der Praxis hat sich Intserv in einigen kleineren Umgebungen etabliert, allerdings nicht in verteilten oder sehr großen Netzwerken, da es hier zu Problemen bei der Skalierbarkeit kam.

Differentiated-Services, kurz Diffserv, adressieren einige der Einschränkungen von Intserv und ToS. Diffserv ist skalierbarer und kann, bei korrekter Implementierung, über mehrere Netzwerke hinweg arbeiten. Die ersten sechs ToS-Bits in einen IPv4-Paket beziehungsweise das Traffic-Class-Octet in einem IPv6-Paket laufen unter der Bezeichnung Differentiated-Service-Code-Point, kurz DSCP. Hier werden bis zu 64 Klassen unterstützt.

Mehrere Diffserv-Router formieren sich zu einer so genannten »Diffserv-Wolke«. Der Verkehr wird klassifiziert, wenn er in die Wolke eintritt.

Die jeweilige Dienstgüte hängt wiederum von den mit dem Provider vereinbarten Service-Levels ab. Diese bestimmen die Priorität in der Diffserv-Umgebung. Der größte Vorteil von Diffserv ist, dass es am Rand des Netzwerks arbeitet. Nachdem die Daten in der Diffserv-Wolke sind, müssen die internen Router die QoS-Informationen nicht mehr erhalten, das erlaubt es ihnen, sich vollständig auf das Routing zu fokussieren.

Allerdings ist Diffserv noch nicht ganz ausgereift und arbeitet auch nicht immer nach den gleichen Regeln. Einzelne interne Router können auf die Informationen im ToS-Feld abweichend reagieren oder die Daten gar verändern. Es existieren keine übergreifenden Standards. Der Gold-Service eines Providers kann dem Bronze-Service eines anderen entsprechen. Ebenso kann es sein, dass ein Unternehmen zwar den Gold-Service seines Providers in Anspruch genommen hat, dieser wiederum aber eine Vereinbarung mit niedrigerer Qualitätsgarantie mit anderen ISPs im Vertrag hat.

Diffserv arbeitet indem Pakete mit einer niedrigeren Priorität während Zeiten hoher Auslastung aus dem System entfernt werden. Damit verlieren Kunden mit niedrigeren Service-Levels unter Umständen die Verbindung, wenn entsprechende Konditionen im Netzwerk auftauchen. Diffserv bewährt sich in größeren LANs oder im WAN, da es einen niedrigeren Overhead als Intserv aufweist und zudem skalierbarer ist. Da die Klassifizierung am Rande des Netzes erfolgt, müssen weder die Endpunkte noch die internen Router die Diffserv-Bits verstehen.

Den Verkehr formen

Traffic-Shapers sind das Flaggschiff aller QoS-Methoden. In diese Kategorie gehören Produkte von Allot Communications, Lightspeed Systems, Packeteer und Sitara Networks. Neben den QoS-Mechanismen liefern diese Produkte Klassifizierung der Pakete, Traffic-Reporting und können tief in die einzelnen Pakete hinein blicken. Obwohl sie die Daten nach Diffserv- und ToS-Eingaben einordnen können, verlassen sie sich nicht allein auf diese Technologien. Zudem handelt es sich um Standalone-Geräte. Sie setzen keine Konfigurationsänderungen voraus, und üblicherweise kommt es auch nicht zu Schwierigkeiten bei der Interoperabilität.

Normalerweise sitzen diese Geräte am Rand des Netzwerks, allerdings können sie auch den internen LAN-Verkehr formen. Die meisten arbeiten auf Layer-7 und lösen damit das »Lass alles über Port 80 laufen und keiner wird es merken«-Syndrom. Dieses Problem taucht auf, wenn eine Policy bestimmt, dass hauptsächlich ein Port für die Übertragung aller Protokolle zum Einsatz kommt. Dann läuft beispielsweise HTTP, durchaus erwünscht, auf dem gleichen Port wie die unerwünschten Varianten wie P2P oder Streaming-Media. Layer-7-Geräte können den Verkehr auf Port 80 unterscheiden, egal, ob es sich um HTTP, P2P, Streaming-Video, HTML oder eine JPG-Übertragung handelt.

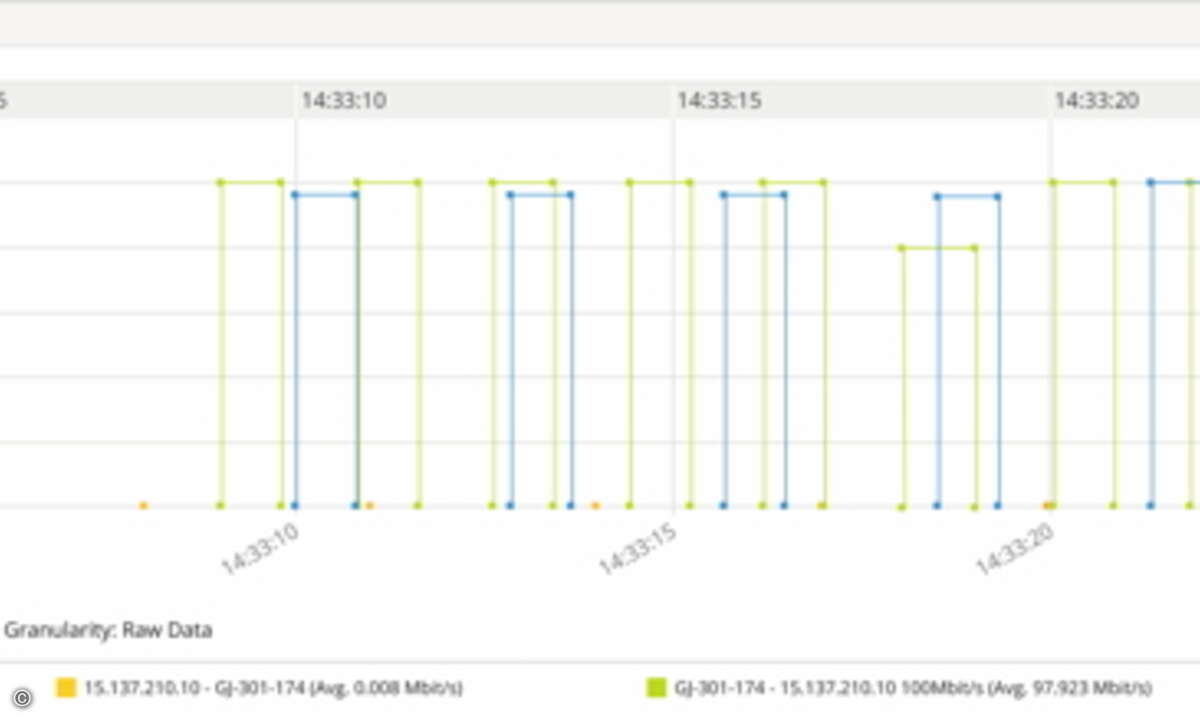

Normalerweise arbeiten Traffic-Shaper zunächst lediglich in einer Überwachungsfunktion. Damit hat der Administrator eine gute Übersicht über die tatsächlichen Daten in seinem System und weiß, welche davon die meiste Bandbreite beanspruchen. Die Reporting-Tools gehören zu den leistungsfähigsten Funktionen der Traffic-Shaper.

Obwohl sich die Traffic-Shaper in ihrem Leistungsumfang von Hersteller zu Hersteller unterscheiden, haben sie doch einige Gemeinsamkeiten. Der Verkehr kann nach Klasse wie Protokoll oder Subnet, nach Flow oder nach einer Kombination daraus »geformt« werden. Es lassen sich Mindest- und Höchstwerte für die verfügbare Bandbreite einstellen. Auch so genannte Bursts sind möglich. Diese kommen allerdings nur zum Zug, wenn entsprechend Bandbreite zur Verfügung steht. So kann beispielsweise vorgegeben werden, dass FTP üblicherweise mit bis zu 10 MBit/s ausgestattet wird, wenn es die Auslastung des Systems erlaubt, diese Zahl auf 15 MBit/s steigen kann. Viele Highend-Traffic-Shaper können mit fortgeschrittenen und für den Administrator klar verständlichen Befehlen arbeiten. So könnte eine Regel beispielsweise lauten: »Mindestens 8 KBit/s für jede VoIP-Session, jedoch nicht mehr als 1 MBit/s insgesamt für alle gleichzeitigen Sessions. Wenn 1 MBit/s erreicht ist, keine weiteren VoIP-Sessions zulassen.«

Info Kleines QoS-Wörterbuch

Die QoS-Welt ist voller Begriffe, die von Herstellern und Experten unterschiedlich definiert und genutzt werden. Das führt zu Verwirrung und manchmal auch zu einer widersprüchlichen Nutzung der Terminologie. Hier die Definitionen von Network Computing:

- Quality-of-Service: eine Methode, um besseren oder stabileren Service für ausgewählten Netzwerk-Verkehr zu liefern, entweder mittels Bandbreiten-Zuteilung oder durch Latenz-Kontrolle.

- Saturation-Point: der Punkt, an dem ein Netzwerk-Gerät beginnt, eine inakzeptable Menge an Paketen aus dem System zu entfernen, gemessen an Anzahl der Pakete, simultanen Sessions oder Bandbreiten-Auslastung.

- Flow: eine Session zwischen zwei Hosts, beispielsweise eine TCP-Session. Hierzu gehört das Handshaking, die Übertragung der Daten und das Beenden der Session. Es können mehrere simultane Flows zwischen zwei Hosts bestehen.

- Klasse: eine Gruppierung von Flows auf der Basis von gemeinsamen Kriterien. Hierzu gehören unter anderem Protokoll, Quellen-/Ziel-Adresse oder Subnet.

- Klassifizierung: das Entdecken, Identifizieren und mögliche Markieren von Flows.

- Burst-Rate vs. Maximum-Rate: Falls ein QoS-Gerät Bursts unterstützt, lässt sich eine Klasse oder ein Flow so konfigurieren, dass mehr Bandbreite als die maximal zulässige genutzt werden kann, aber nur, wenn ungenutzte Bandbreite zur Verfügung steht. In anderen Worten ist es eine zweite, höhere maximale Bandbreite. Die Burst-Rate ist immer höher als die maximale Rate.

Queues oder Windows

Traffic-Shaper arbeiten entweder mit Queues oder durch das Manipulieren der TCP-Windows-Größen. Hersteller, die mit Queuing arbeiten, behaupten, dass TCP sich durch die Queues automatisch herrunterfährt und damit TCP-Rate-Shaping (TRS) unnötig und auch nicht von der IETF spezifiziert ist. Zudem kann TRS keinen UDP-Verkehr verarbeiten. Das ist allerdings kein großer Nachteil, da die Hersteller, die TRS bevorzugen, einen zweiten auf Queuing basierenden Algorithmus einsetzen, der für den UDP-Verkehr zuständig ist. Allot Communications und Lightspeed haben beide Queuing-Traffic-Shaper im Angebot.

TRS arbeitet, indem es TCP-Kontrolldaten und die Windows-Größen manipuliert. Dieses Vorgehen überlistet quasi die TCP-Session, die dann davon ausgeht, dass mit einem Host auf einer viel langsameren Verbindung kommuniziert wird. Ähnliches passiert ganz automatisch, wenn ein Modem-User Verbindung mit einem Server auf einer sehr schnellen Leitung aufnimmt. TRS-Hersteller behaupten, dass Queuing zu größerer Latenz führt, mehr Pakete verloren gehen und die Technologie den eingehenden Verkehr nicht so gut verlangsamen. Packeteer und Sitara nutzen beide TRS.

Queuing-Hersteller arbeiten im Wesentlichen mit vier unterschiedlichen Methoden:

- Priority-Queuing, kurz PQ, arbeitet genau wie ToS. Queues mit höherer Priorität haben den Vorrang gegenüber jenen mit niedrigerer Priorität. Das bedeutet auch, dass die untersten Queues möglicherweise ihr Ziel nie erreichen.

- Class-Based-Queuing, kurz CBQ, löst das spezifische PQ-Problem. Die einzelnen Klassen lassen sich mit einem Minimum an Bandbreite konfigurieren und können von anderen Klassen Bandbreite »ausleihen«, falls verfügbar.

- Weighted-Fair-Queuing, kurz WFQ, verändert die Größe der Queue auf der Basis der Prioritätsebene. Die Ausnutzung der Bandbreite spielt hier keine Rolle.

- Hierarchical-Weighted-Fair-Queuing, kurz HWFQ, wertet den Worst-Case-Delay der Pakete aus und nutzt diese Daten, um entsprechende Entscheidungen zu treffen.

Die Diskussionen um Queuing oder Rate-Shaping laufen bereits seit einigen Jahren. Letztendlich kommt es aber auf die Management-Schnittstellen, die Qualität der Berichterstattung und natürlich in erster Linie auf die Leistungsfähigkeit an, und nicht auf die darunter liegende Technologie.

Bitte hinten anstellen

Der Einsatz von QoS muss nicht übermäßig schwierig oder zeitaufwändig sein. Es gilt in erster Linie die Anwendungen ausfindig zu machen, auf die keinesfalls verzichtet werden kann, und ihnen ausreichend Ressourcen bereit zu stellen. Andererseits besteht die Möglichkeit, die schlimmsten Bandbreiten-Fresser und unnötige Anwendungen zu entfernen oder nur zuzulassen, wenn die Bandbreite wirklich frei zur Verfügung steht.

Letztlich bedeutet dies, einen Mangel an Leistungsfähigkeit nicht immer mit einem Bedarf an mehr Bandbreite gleichzusetzen. Es besteht kein Grund, auf Gigabit-Ethernet umzurüsten, wenn durchdachtes QoS auf einigen Routern im System auch zu einem befriedigenden Ergebnis führt. Das ist meist kostensparend und durchaus ausreichend, bis der nächste große Upgrade des Netzwerks ansteht. [ nwc, ka ]