Kampf gegen explodierende Kosten

Kampf gegen explodierende Kosten Oft sprengen IT-Projekte im öffentlichen Sektor die Zeit- und Kosten-vorgaben. Neben softwaretechnischen Verbesserungen tut auch intensivere Kommunikation zwischen Auftraggebern und -nehmern not.

Die Schäden für die Kasse und das Ansehen sind immer wieder enorm, wenn öffentliche IT-Großprojekte Negativschlagzeilen machen: etwa der holpernde Start der Lkw-Maut, die Mehrkosten bei den Systemen für das Arbeitslosengeld II oder das komplett gescheiterte Fiscus-Projekt der Finanzämter. Solche Desaster bei steuerlich finanzierten IT-Projekten spiegeln den allgemeinen Stand der Dinge. Weltweit liefern nur 29 Prozent der Entwicklungsprojekte die bestellten Funktionen im vereinbarten Zeit- und Kostenrahmen, 53 Prozent verschlingen mehr Aufwand als geplant und 18 Prozent scheitern ganz. Dies hat die Standish Group in ihrem jüngsten Chaos Report herausgefunden, den sie alle zwei Jahre neu erstellt. Zuletzt wurden fast 10000 IT-Projekte untersucht.

Unklare Anforderungen

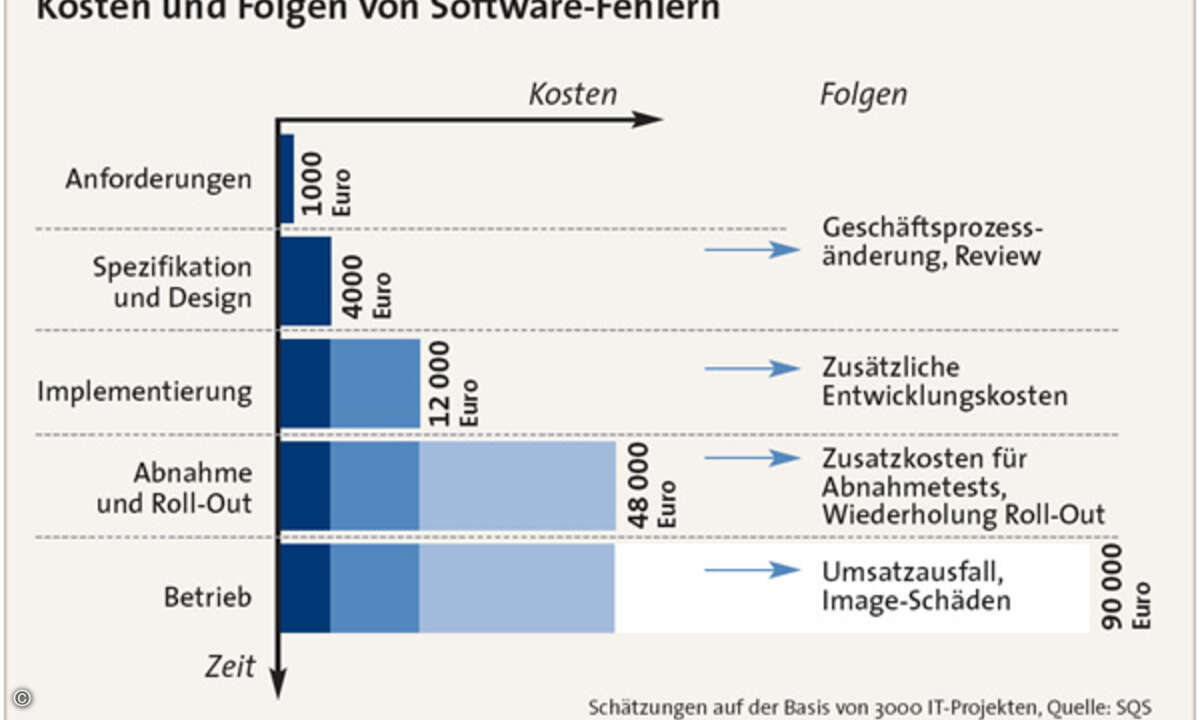

»Versäumnisse bei der Anforderungsdefinition, also in den frühen Phasen von Entwicklungsprojekten, sind die Ursache vieler dieser Probleme«, meint Wilhelm Kruth, Leiter des Gemeinsamen Gebietsrechenzentrums (GGRZ), eines Systemhauses des Bundeslandes Nordrhein-Westfalen mit Sitz in Köln. Schlechte Vorgaben lassen sich nach seinen Erfahrungen während der Programmierung nur noch aufwendig und in der Testphase gar nicht mehr wettmachen. Er fordert deshalb eine übergreifende Qualitätssicherung, die schon im Projektvorfeld beginnt und prüft, ob die Anforderungen der politisch verantwortlichen Auftraggeber eindeutig und systemtechnisch umsetzbar sind. Davon weiß auch Dietrich Kaiser ein Lied zu singen, der das Deutsche Institut für medizinische Dokumentation und Information (DIMDI) in Köln leitet: »Die Übersetzung fachlich formulierter Anforderungen in Vorgaben für die IT wird oft sträflich vernachlässigt.« Software-Systeme werden oft zu spät ausgeliefert, bieten nicht die eigentlich gewünschte Funktionalität und verursachen obendrein hohe Wartungskosten.

Kurzfristige Änderungen

Die grundlegende Bedeutung des Anforderungsmanagements für die Wirtschaftlichkeit von IT-Projekten ist zwar seit Jahren nichts Neues mehr. Doch immer noch tun sich viele öffentliche Auftraggeber mit Investitionen in diese vorbeugende Qualitätssicherung schwer. Der Grund: Der politische Entscheidungsprozess ist gerade dadurch gekennzeichnet, dass Anforderungen immer wieder auf den Prüfstand kommen und kurzfristig geändert werden. Gesetze und öffentliche Regularien tragen zumeist die Handschrift unterschiedlicher Interessensgruppen. Hinzu kommt, dass IT-Expertise noch keinen festen Platz in den politischen Entscheidungsprozessen hat. Dies führt zu dem bekannten Phänomen, dass die politisch Verantwortlichen die Implementierungsdauer ihrer Vorgaben regelmäßig unterschätzen. Aufgrund des zunehmenden Drucks seitens der Öffentlichkeit und angesichts leerer Kassen sehen sich viele staatliche Einrichtungen nach Gegenmaßnahmen um. So hat etwa der Deutsche Städte- und Gemeindebund (DStGB) einen Rahmenvertrag mit dem Dienstleister SQS Software Quality Systems geschlossen, um für seine Mitgliedkommunen beim Qualitätsmanagement Unterstützung zu bekommen. Voraussichtlich wird auch die neue Fassung des Vorgehensmodells für Software-Entwicklungsprojekte das Problembewusstsein schärfen. Das V-Modell XT nimmt die öffentlichen Auftraggeber bei der Anforderungsdefinition jedenfalls stärker in die Pflicht (siehe Kasten).

Brücken zur IT

In erster Linie geht es um eine stärkere Verzahnung der bisher weitgehend getrennten Welten Fachabteilung und IT-Organisation, also der fachlich und politisch Verantwortlichen mit den IT-Experten. Zum einen muss die IT-Expertise bei der Vertragsgestaltung stärkeren Einfluss bekommen. So können Auftraggeber und IT-Lieferanten zum Beispiel vermeiden, dass sie von vornherein unrealistischen Lieferterminen hinterherlaufen. Andererseits gilt es, die Fachexperten während der Entwicklung stärker einzubinden – sei es bei der Anforderungsdefinition oder der Priorisierung der verschiedenen Funktionen. Das Anforderungs- und Testmanagement kann durch den Einsatz entsprechender Werkzeuge an Effizienz gewinnen. Hilfreich sind auch Analyse-Verfahren und -Tools, welche die technische Qualität des Software-Codes vermessen. Der Marktforschungsfirma Forrester zufolge ist die kontinuierliche Durchleuchtung des Codes während der Entwicklung ein wichtiger Einflussfaktor für die späteren Wartungskosten – die inzwischen rund drei Viertel aller IT-Etats ausmachen.

Zunehmende Arbeitsteilung

Von Bedeutung ist darüber hinaus der Lieferantenmix: Wer übernimmt welche Aufgaben? Am DIMDI zum Beispiel hat man gute Erfahrungen damit gemacht, Entwicklungsprojekte nicht komplett in die Hände eines einzigen Dienstleisters zu legen, sondern Realisierung und Qualitätssicherung getrennt zu beauftragen. Denn nur Testexperten, die nicht Teil der Implementierung sind, können jenen unabhängigen Blick gewährleisten, der für eine verlässliche Qualitätssicherung notwendig ist. Diese Änderungen erfordern zum Teil erhebliche organisatorische Maßnahmen, die mit gewissen Störfaktoren einhergehen. So sind die unterschiedlichen Denk- und Vorgehensweisen der behördlichen Fach- und der IT-Experten nicht einfach zu überbrücken. Hier sind Kommunikationsprofis gefragt, die zwischen den beiden Welten vermitteln können. Hinzu kommt eine externe Schwierigkeit. Bund, Länder und Gemeinden führen größtenteils eine vorläufige Haushaltsplanung durch. Dies lenkt den Blick auf einen eher kurzfristigen Nutzen, Risiken können auf Folgehaushalte verschoben werden, die oft schon von anderen Personen zu verantworten sind. Allerdings arbeitet an dieser Stelle die Zeit einem auch langfristig konzipierten Qualitätsmanagement zu, da die öffentlichen Haushalte gegenwärtig Schritt für Schritt von der eher kurzfristig orientierten Kameralistik auf das nachhaltigere Buchhaltungsverfahren der Doppik umstellen.

Qualität nicht zum Nulltarif

Auf ihrem Weg, ein IT-Qualitätsmanagement einzuführen, das in einem vernünftigen Kosten-Nutzen-Verhältnis steht, setzen derzeit zahlreiche öffentliche Auftraggeber auf Risikomanagement. Als Teil des Testmanagements nutzen es die Behörden- und Projektleiter, um die Spreu vom Weizen zu trennen: Wo lohnen hohe Testaufwände, wo nicht? Auf diese Weise erhöhen die Projekte nicht nur die Systemqualität, sondern senken zugleich den Ressourceneinsatz. Risikomanagement reduziert die Anzahl der zu bearbeitenden Testfälle, da es den Blick auf die wichtigsten Fehlerquellen lenkt und viele unkritische Funktionen auch als solche definiert. Es unterscheidet dabei äußere Risiken, die vor allem in die Verantwortung des Auftraggebers fallen, und innere Risiken auf Seiten der IT-Dienstleister.

Dr. Martin Wieczorek ist Partner bei dem IT-Dienstleister SQS Software Quality Systems in Köln.