Wie HPC die Datenmengen der Zukunft managen soll

Rasant wachsende, riesige Datenmengen erwarten Unternehmen in der Zukunft. Um diese verarbeiten und verwalten zu können, braucht es passende Lösungen. High Performance Computing könnte ein Weg sein, den Anforderungen zu begegnen.

Sie sind nicht sichtbar, aber sie sind überall und werden immer mehr: Daten. Für das Jahr 2025 prognostiziert die International Data Corporation (IDC) ein weltweites Volumen von jährlich 175 Zettabyte erzeugten, verbrauchten und gespeicherten Daten. Das sind 175 Billionen Gigabyte oder um es noch anschaulicher zu machen: eine 175 mit 21 Nullen. 2020 waren es noch rund 64 Zettabyte. Das am schnellsten wachsende Datensegment sind nach Erkenntnissen der IDC IoT-Daten.

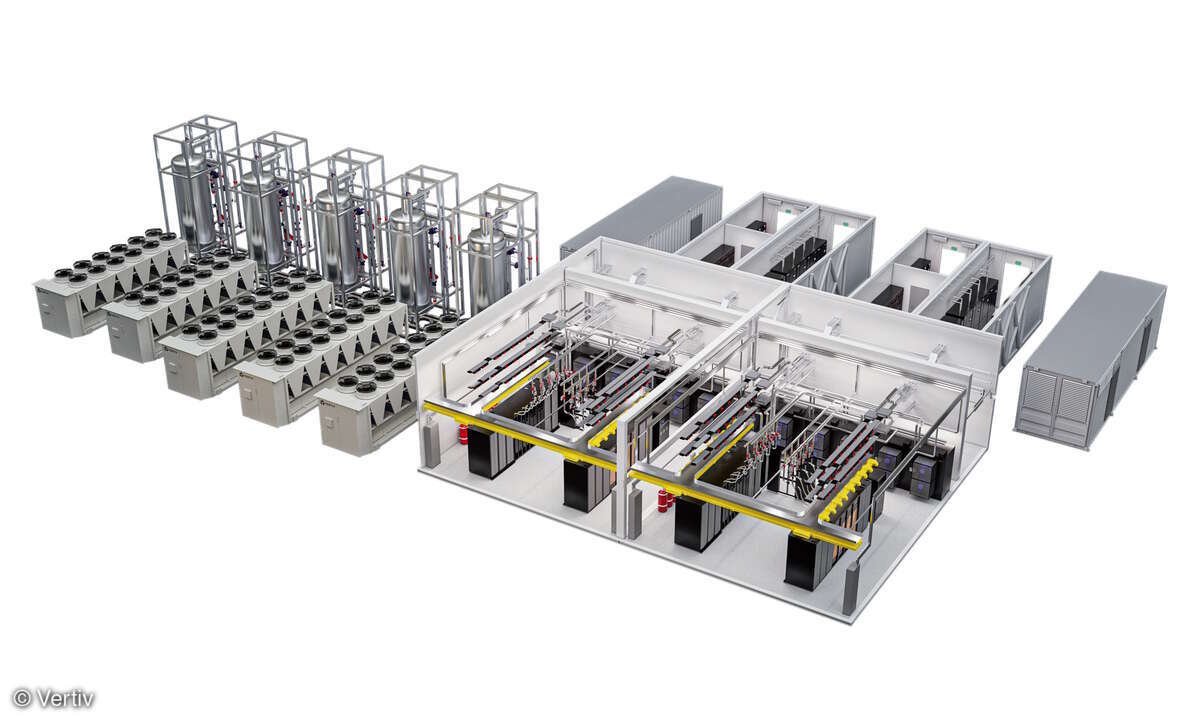

Der rasante und enorme Datenanstieg setzt eine massive Rechenleistung, geringe Latenzzeiten und hohe Sicherheit in Rechenzentren voraus. Nach Angaben des Bitkom sind die Kapazitäten der Rechenzentren in Deutschland in den letzten fünf Jahren zwar kontinuierlich und erheblich gestiegen und ihre Effizienz wurde deutlich verbessert, doch angesichts der extremen Datenströme wird auch in Zukunft ein weiterer Ausbau der Rechenzentrumsinfrastruktur notwendig sein. Rechenzentrumsbetreiber, die für die Zukunft gerüstet sein wollen, müssen handeln und ihre Rechenzentren an die neuen Gegebenheiten anpassen.

Anbieter zum Thema

Die Möglichkeiten von HPC

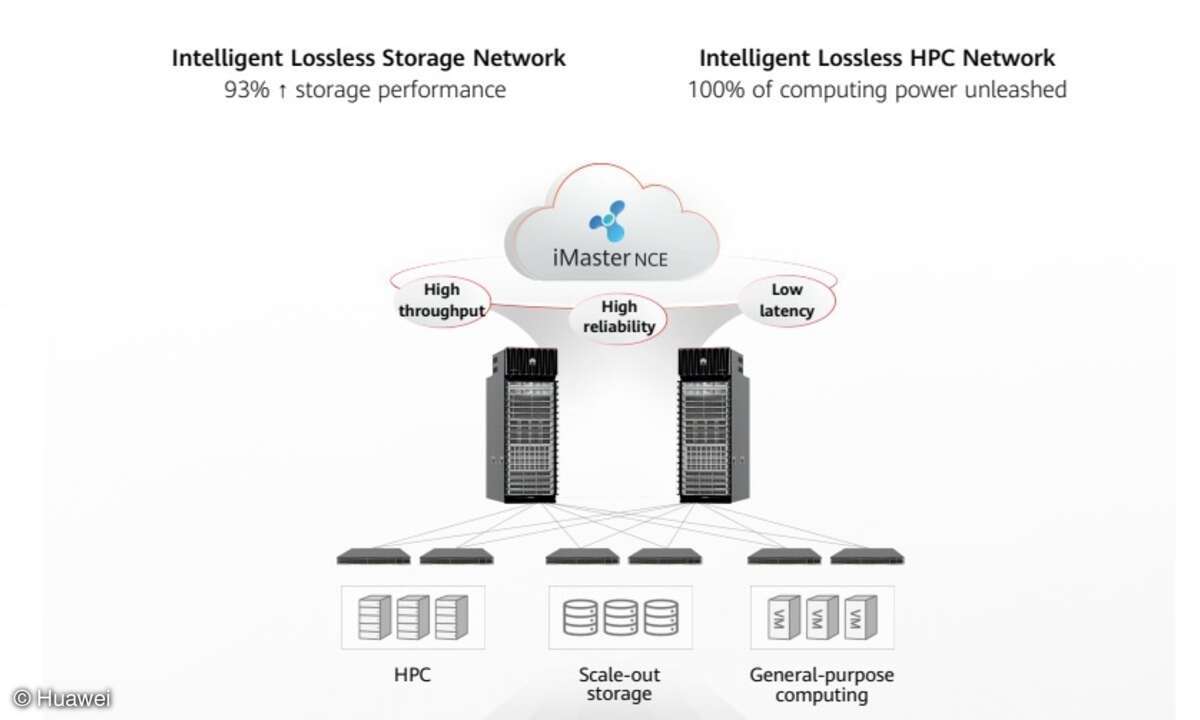

Sowohl Wissenschaft als auch Wirtschaft setzen dabei zunehmend auf High Performance Computing (HPC), denn es ermöglicht, diese anfallenden Datenmengen zu verarbeiten. Bei diesen Hochleistungsrechnern sind Rechenleistung und Speicherkapazität um ein Vielfaches höher als bei der klassischen Datenverarbeitung. Unterschiede zum klassischen Computing liegen zudem in der Anzahl der CPU- und GPU-Kerne, dem Betriebssystem und der Hardware. Sie sind als Cluster, also einer zusammenhängenden Struktur, aufgestellt und innerhalb eines Netzwerks miteinander verbunden. Dank spezieller Software verarbeitet diese Rechnerstruktur Daten parallel. So können große Datenmengen sehr viel schneller übertragen werden. Dies führt wiederum zu niedrigeren Latenzzeiten.

Um ihre Daten optimal zu nutzen, müssen Unternehmen eine Datenstrategie entwickeln, in ihr Datenmanagement investieren und ihre Rechenzentrumsinfrastruktur aufrüsten. Prozessoren, Storage und Netzwerktechnologien müssen auf den neusten Stand gebracht und regelmäßig aktualisiert werden. Das bedeutet hohe finanzielle Investitionen. Bauen sich Unternehmen eine eigene Infrastruktur für HPC auf, erfordert dies neben massiven finanziellen Ressourcen außerdem auch umfassendes Know-how zu Technologien und Einsatzbereichen. Datenkompetenz, die „Digital Literacy“, wird zur Schlüsselqualifikation der Zukunft.

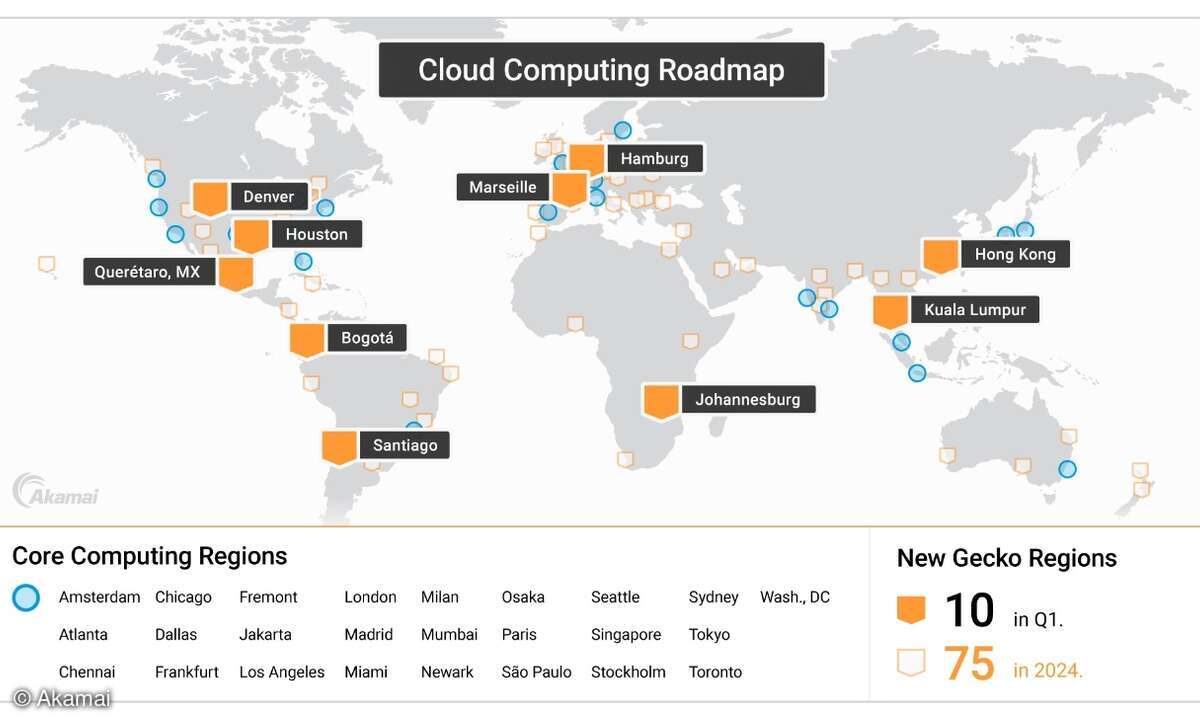

Diese hohen Anforderungen rund um HPC können meist nur große Konzerne stemmen, während kleine und mittlere Unternehmen hier an ihre Grenzen kommen. Eine gute Option, wie auch solche Betriebe mehr Rechenzentrumskapazitäten generieren können, bieten Rechenzentrums- oder Colocation-Anbieter, bei denen sich Unternehmen die notwendige Fläche für ihr High Performance Computing mieten. Immer mehr Unternehmen, die das Potenzial von HPC nutzen wollen, machen von dieser Möglichkeit Gebrauch und rüsten entsprechend auf: Die bereits erwähnte Bitkom-Studie ergab, dass der Colocation-Anteil der Rechenzentrums-Kapazitäten im Jahr 2020 bereits 40 Prozent betrug und bis 2025 auf 50 Prozent steigen wird.

Auch in Wissenschaft und Forschung ist High Performance Computing immer stärker verbreitet: Institute arbeiten mit Hochleistungsrechnern, um beispielsweise Simulationen oder aufwändige Animationen auf Basis von Künstlicher Intelligenz zu erstellen. Durch die hohe Rechenleistung sind etwa Simulationen im Rahmen von Crashtests oder in der Raumfahrt möglich. Der große Vorteil: Teure, physische Tests müssen dadurch teilweise überhaupt nicht mehr durchgeführt werden und das spart Kosten. HPC leistet außerdem einen wichtigen Beitrag zu technologischen Innovationen und wissenschaftlichen Entdeckungen, die die Zukunft maßgeblich mitgestalten. Die Charité in Berlin beispielsweise nutzt High Performance Computing für die Analyse und Verarbeitung der Daten aus der Genom-Sequenzierung, um Hochrisikopatienten zu identifizieren und gezielte Behandlungstherapien zu entwickeln.

Nächster Schritt Quantencomputing

Als spezielle Ausformung des High Performance Computing befindet sich Quantencomputing – der „Supercomputer der Zukunft“ – aktuell noch in der Entwicklungsphase. Doch obwohl die Standardisierung noch in den Kinderschuhen steckt, ist diese neue Technologie in Wirtschaft und Wissenschaft bereits auf dem Vormarsch. Einige Unternehmen haben sich bereits auf die Entwicklung von Quantencomputern spezialisiert, denn die Nachfrage wächst: Laut einer Studie von Atos und IQM planen 76 Prozent der HPC-Rechenzentren weltweit, bis 2023 Quantencomputing einzusetzen. Der Finanzdienstleister Morgan Stanley prognostiziert einen jährlichen Umsatz von neun Milliarden Euro bis zum Jahr 2025.

Beim Quantencomputing bilden nicht Bits, sondern Qubits, also Quanten-Bits, die Grundrecheneinheit. Anders als ein Bit kann ein Qubit nicht nur den Zustand 0 oder 1 annehmen, sondern den Zustand 0 und 1 gleichzeitig sowie theoretisch auch alle Zustände dazwischen. Dadurch können Quantencomputer mehrere Berechnungen mit mehreren Eingaben gleichzeitig vornehmen. Dieser Unterschied verleiht Quantencomputern das Potenzial, exponentiell schneller zu sein als die heutigen Großrechner und Server. Mit dem Einzug von Quantencomputing in Rechenzentren würde deren Rechenleistung enorm steigen, aber auch ihre Architektur verändern. Denn Qubits sind sehr empfindlich und müssen vor jeglicher Art der Außeneinwirkung geschützt werden.

Während Quantencomputer zum jetzigen Zeitpunkt noch für spezielle Anwendungsfälle maßgeschneidert konstruiert und mit herkömmlichen Computern gekoppelt werden müssen, setzen viele Unternehmen und Institutionen aus verschiedensten Branchen bereits heute auf High Performance Computing. Laut dem Marktforschungsinstitut MarketsandMarkets wird der globale HPC-Markt von 37,8 Milliarden US-Dollar im Jahr 2020 auf 49,4 Milliarden US-Dollar im Jahr 2025 ansteigen.

Die Hoffnungen, die Wirtschaft und Wissenschaft in die neuen Möglichkeiten der Datenverarbeitung setzen, sind vielfältig: Steigende Leistungsfähigkeit durch schnellere Geschwindigkeit, Prozessoptimierung, Kostenersparnis und nicht zuletzt auch stärkere Innovationsfähigkeit durch wissenschaftliche Durchbrüche. Welche Chancen und Möglichkeiten High Performance Computing tatsächlich bietet, wird für Unternehmen jedoch erst realisierbar sein, wenn die Technologie in den kommenden Jahren und Jahrzehnten weiter ausgereift und standardisiert ist.

Wolfgang Kaufmann, CEO bei Datacenter One