Object Storage und HCI erobern Backup-Markt

Backup-Plattformen auf Basis von Object-Storage-Systemen oder hyperkonvergenten Lösungen (HCI) sind gut skalierbar und vergleichsweise kostengünstig. Sie ermöglichen außerdem ein schnelles Disaster Recovery, verfügen über eine gute Cloud-Integration und lassen sich bei Bedarf problemlos auch für andere Anwendungen heranziehen.

Um die in einem Unternehmen geforderten Wiederherstellungszeiten einhalten zu können, setzen viele IT-Abteilungen bereits seit Längerem Backup-to-Disk-Lösungen ein. Disk-Systeme sind schneller als Bandlaufwerke und dadurch eher in der Lage, die Backup-Zeitfenster einzuhalten und Restores mit einer hohen Geschwindigkeit durchzuführen. Ein gutes Stück vom Backup-to-Disk-Markt konnte sich in den vergangenen Jahren die Produktgattung der Virtual Tape Libraries (VTL) erobern. Bei VTLs handelt es sich um Disk-Systeme, die sich wie eine klassische Bandbibliothek ansteuern lassen. Dadurch fügen sich VTLs nahtlos in vorhandene Backup-to-Tape-Infrastrukturen ein. Ein anderes Backup-to-Disk-Konzept verfolgen Lösungen wie SnapMirror von NetApp. Das primäre Speichersystem erzeugt eine Kopie der Daten, die auf einem sekundären System an einem anderen Standort gespeichert wird. Sobald es die initiale Kopie erstellt hat, muss es nur noch die seit dem letzten Snapshot-Backup veränderten Datenblöcke übertragen. Ähnliche Lösungen sind auch von anderen Storage-Array-Herstellern erhältlich. Beide Backup-to-Disk-Ansätze sind mit relativ hohen Kosten verbunden, da VTL-Appliances und Speichersysteme der traditionellen Storage-Hersteller meist im oberen Preissegment angesiedelt sind.

Secondary Storage als Backup-Plattform

Der Kostenaspekt ist ein wichtiger Grund, warum sich neue Anbieter mit vergleichsweise günstigen Secondary-Storage-Plattformen erfolgreich im Backup-Markt etabliert haben. Die Lösungen basieren auf Standard-x86-Servern mit lokalen Datenlaufwerken, die zu einem hochverfügbaren Verbund zusammengeschaltet sind. Die Plattformen lassen sich durch Hinzufügen weiterer Server-Nodes skalieren (Scale-out). Bei vielen Herstellern ist es möglich, zu einem solchen Verbund sowohl Systeme mit besonders hoher Kapazität als auch mit hoher CPU-, RAM- und I/O-Performance im laufenden Betrieb hinzuzufügen.

Zu den interessantesten Vertretern dieser Kategorie zählen Object-Storage-Systeme und hyperkonvergente HSS-Lösungen (Hyper-Converged Secondary Storage), die als Backup-Plattform genutzt werden. Object-Storage-Systeme speichern Dateien zusammen mit Metadaten und einem Unique Identifier in einem flachen Adressraum. Die Applikationen können die Objekte selbst direkt im System speichern und greifen über die Identifier auf sie zu. Ein zusätzliches Filesystem als Zwischenschicht ist bei Object-Storage-Systemen nicht erforderlich. Diese Speichermethode eignet sich besonders gut für sehr große Mengen an unstrukturierten Daten, die nach ihrer Erstellung nur noch selten verändert werden.

Die meisten Object-Storage- und HSS-Lösungen lassen sich gleichzeitig auch als Speicherplattform für Geschäftsdaten nutzen, die keine allzu hohen Performance-Anforderungen stellen, zum Beispiel für die Archivierung. Die Deduplizierung der zu sichernden Daten führt entweder das Storage-System oder die Backup-Software durch. Für den Schutz vor Datenverlusten kommen in der Regel intelligente Erasure-Coding-Verfahren zum Einsatz. Datenverschlüsselung und Schutzfunktionen gegen Ransomware zählen ebenfalls zum Standardrepertoire derartiger Lösungen.

Eine wichtige Rolle spielt zudem die Cloud-Integration. Zum einen lassen sich kritische Systeme für die Notfallvorsorge kostengünstig in die Cloud replizieren und bei einem Ausfall des primären Standortes aus der Cloud heraus starten. Eine Replikation können IT-Verantwortliche außerdem zwischen verschiedenen Unternehmensstandorten einrichten. Zum anderen unterstützen einige Lösungen mit speziellen Funktionen eine Migration von VMs zwischen verschiedenen Cloud-Anbietern und unterschiedlichen Hypervisor-Versionen.

Redundanzmechanismen

Um die Redundanz der gespeicherten Daten zu gewährleisten, stehen in der Regel zwei Mechanismen zur Verfügung. Zum einen lassen sich die zu einem Objekt oder einer Datei gehörenden Datenfragmente inklusive der Redundanzinformationen mit Erasure-Coding-Verfahren über zahlreiche Laufwerke auf verschiedene Nodes eines Clusters verteilen. Je nach gewähltem Schutzlevel können zum Beispiel bis zu fünf Laufwerke gleichzeitig ausfallen, ohne dass Daten verloren gehen. Erasure Coding kostet CPU-Performance, benötigt aber nur einen vergleichsweise geringen Overhead und eignet sich damit gut für die Speicherung von Backup-Daten.

Zum anderen ist es bei den meisten Herstellern möglich, von allen Datenblöcken automatisch eine oder mehrere Kopien auf verschiedene Knoten eines Rechnerverbundes zu verteilen. Bei Ausfällen einzelner Laufwerke oder ganzer Nodes hat dieses Verfahren den Vorteil, dass man die verloren gegangenen Daten nicht rekonstruieren muss, weil immer eine vollständige Kopie vorhanden ist. Sobald der IT-Verantwortliche die ausgefallene Komponente ersetzt hat, stellt das System die verloren gegangenen Kopien im Hintergrund automatisch wieder her.

Die Hyperstore-Objektspeichersysteme von Cloudian lassen sich nicht nur als Secondary-Storage-Plattform für Backups nutzen, sondern auch als hoch skalierbare Speicherlösung für sehr große Mengen an unstrukturierten Daten wie Videos oder CAD-Zeichnungen. Cloudian bietet standardmäßig Disaster-Recovery-Funktionen, indem sich ein Hyperstore-Cluster über bis zu zehn Standorte verteilen lässt, von denen jeder eine eigene Kopie der Produktivdaten vorhalten kann.

Hyperstore unterstützt zudem eine Datenreplikation zu Cloud-Anbietern. Die Integration mit Amazon Web Services (AWS) erfolgt über die S3-Schnittstelle (Simple Storage Service), die sich mittlerweile als De-facto-Standard für objektbasierte Speichersysteme etabliert hat. Cloudian hat in Hyperstore den kompletten nativen S3-Befehlssatz implementiert, wodurch sich alle S3-Kommandos direkt ausführen lassen. Von AWS neu entwickelte Funktionen wie S3 Select oder S3 Analytics übernimmt Cloudian innerhalb kurzer Zeit. Bei anderen Herstellern stehen oft nur Teilbereiche der S3-Funktionen zur Verfügung. Der Zugriff von Clients, die kein S3 unterstützen, erfolgt bei Cloudian über ein NFS-/SMB-Gateway.

Als Backup-Speicher sind die Object-Storage-Systeme von Cloudian unter anderem wegen der im Vergleich zu traditionellen Disk-Systemen und VTLs geringeren Kosten pro GByte interessant. Cloudian lässt sich auch als Speicherplattform für HCI-Backup-Lösungen einsetzen. So verfügt der Hersteller Rubrik über Backup-Appliances mit schnellen Datenlaufwerken, die eine Deduplizierung durchführen und ausgefallene VMs direkt aus der Backup-Kopie heraus hochfahren können. Für eine Langzeitsicherung und Datenarchivierung ist diese Hardware aber relativ teuer, weshalb einige Unternehmen Cloudian als kostengünstigeres Backup-Target einsetzen. Die Hyperstore-Systeme unterstützen auch ein hierarchisches Storage-Management (HSM), das die Backup-Daten nach definierbaren Regeln automatisch in die Cloud oder auf Bandbibliotheken auslagern kann.

Scality

Ein weiterer Object-Storage-Anbieter ist Scality, der mit Ring eine Software entwickelt hat, die aus Standard-x86-Servern leistungsfähige Objektspeicher macht. Die in einem ausfallsicheren Rechnerverbund laufenden Systeme lassen sich sowohl für die Speicherung sehr großer Datenmengen als auch als Backup-Plattform einsetzen. Scality unterstützt ebenfalls die S3-Schnittstelle. Anwendungen, die kein S3 unterstützen, greifen über NFS oder SMB auf die Storage-Plattform zu.

Für die Notfallvorsorge stehen verschiedene Verfahren zur Verfügung. Das klassische Aktiv-/Passiv-Modell repliziert die Daten zu einem zweiten Standort, der beim Ausfall des primären Standortes aktiviert wird. Im Aktiv-/Aktiv-Modell mit drei Standorten kann jede Site im Desasterfall die ausgefallenen Funktionen übernehmen. Wenn die Standorte nicht zu weit voneinander entfernt sind, lassen sich auch Echtzeitkopien der Produktivdaten erstellen. Eine Replikation zu Cloud-Providern unterstützt die Software ebenfalls, zum Beispiel um eine zusätzliche Backup-Kopie der Produktivdaten vorzuhalten. Wie bei Cloudian ist der Kostenaspekt ein wichtiger Grund, Object Storage auf Basis von Scality als Backup-Speicherplattform einzusetzen. Außerdem ist Scality kompatibel zu den meisten gängigen Backup-Lösungen.

Backup-Plattformen nutzen HCI-Konzept

Das Konzept der in den letzten Jahren sehr erfolgreichen HCI-Lösungen wird inzwischen auch für Backup-Plattformen genutzt. Zu den Anbietern von Hyper-Converged-Secondary-Storage-Systemen (HSS) zählen unter anderem die bereits erwähnte Firma Rubrik, der auf größere Unternehmen ausgerichtete Hersteller Cohesity sowie StorageCraft, der mit seinen Lösungen kleinere bis mittelgroße Unternehmen bedient. Auch Backup-Spezialist Commvault hat mit seinen Hyperscale-Appliances eine Lösung für dieses Marktsegment entwickelt.

Wie bei Object-Storage-Lösungen lassen sich auf HSS-Plattformen nicht nur Backup-Daten speichern, sondern zusätzliche Anwendungen bedienen. Vergleichbar ist auch der Scale-out-Ansatz, mit dem sich die Speicherkapazität und Performance durch Hinzufügen weiterer Server-Appliances unterbrechungsfrei ausbauen lässt. Eine Cloud-Anbindung per S3-Schnittstelle wird ebenfalls von allen HSS-Anbietern unterstützt.

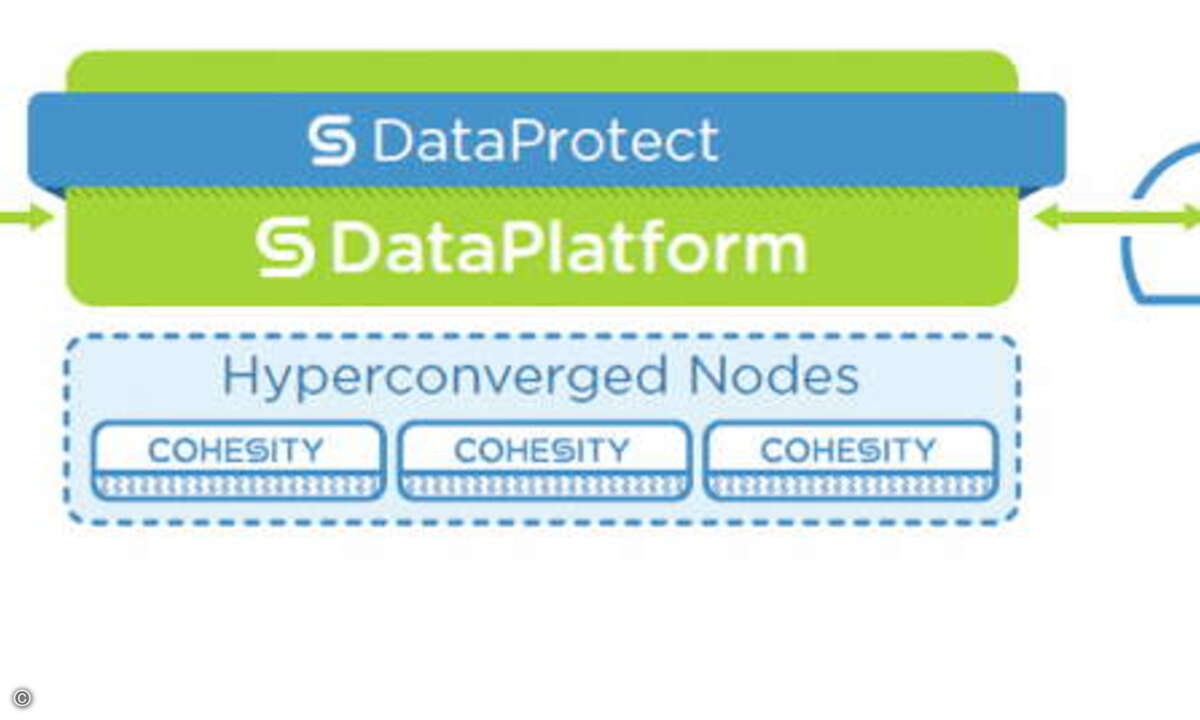

Cohesity

Cohesity positioniert seine Speicherplattform sowohl für die Aufnahme, Analyse und Verarbeitung von sehr großen Mengen unstrukturierter Daten als auch als Storage-Target für Backup-Anwendungen wie Commvault oder Veeam. Die Lösung ist mit zertifizierter Server-Hardware von Cisco, HPE oder Cohesity erhältlich. Für kleinere Außenstellen ist zudem eine virtuelle Edition verfügbar.

Das von Cohesity entwickelte Filesystem SpanFS basiert auf Linux. Standardmäßig schreibt Cohesity jeden Datenblock auf zwei verschiedene Systeme. Ab einem Verbund aus fünf Knoten werden von allen Datenblöcken drei Kopien erstellt. Die Speicherkapazitäten lassen sich den Clients per NFS oder SMB bereitstellen. SpanFS unterstützt sowohl Snapshots als auch Clones. Für eine schnelle Wiederherstellung lassen sich die Snapshots mounten. Mit der Funktion Instant Restore ist es möglich, mit einem Mausklick beliebig viele VMs gleichzeitig zurückzusichern.

Um die Backup-Daten schlank zu halten, unterstützt die Lösung eine Inline- oder Post-Process-Deduplizierung, die sich bei Bedarf auch ausschalten lässt. Cohesity ist zudem in der Lage, die Backup-Daten von VMs zu indizieren und zu durchsuchen. Durch die S3-Integration lassen sich die Daten in die Cloud replizieren. Die Lösung von Cohesity vereinfacht zudem Datenmigrationen zwischen verschiedenen Cloud-Anbietern.

Die Software unterstützt auch ein Storage-Tiering, mit dem sich Daten nach definierten Regeln automatisiert in die Cloud verschieben lassen. Eine Archivierung auf Bandbibliotheken ist mithilfe des Archive Storage Managers von QStar möglich.

StorageCraft

Auf kleinere bis mittlere Unternehmen ausgerichtet ist der Backup-Spezialist StorageCraft, der Anfang 2017 Exablocks übernommen hat. Storagecraft hat die Scale-out-Storage-Appliances von Exablocks um Backup-Funktionen ergänzt und im Sommer 2018 unter dem Namen OneXafe auf den Markt gebracht. Es handelt sich hierbei um eine HCI-Lösung, die derzeit pro Verbund maximal sieben Appliances unterstützt.

Mit der ebenfalls neu entwickelten Backup-Software ShadowXafe lassen sich auch physische Server auf der OneXafe-Plattform sichern. StorageCraft erstellt inkrementelle Image-Backups, die sich zu einer anderen OneXafe-Appliance oder in die Cloud replizieren lassen. Alternativ ist es möglich, eine Replikation auf Speichersystemebene durchzuführen, wobei die Lösung die Datenblöcke dedupliziert. Zudem unterstützt das System Snapshots für eine schnelle Wiederherstellung von VMs sowie Dateien und Verzeichnissen. Mithilfe der Virtual-Boot-Technik lassen sich VMs, die unter VMware laufen, direkt aus dem Backup heraus starten. Über Policies legt der Administrator fest, welche Backup-Versionen er wie lange aufbewahren will.

Kleinere Unternehmen können OneXafe sowohl als Primärspeicher für VMs als auch als Backup-Plattform nutzen. Den Speicher stellt das System per NFS und SMB bereit, der Support von iSCSI ist auf der Roadmap. OneXafe lässt sich auch als Backup-Target für Sicherungssoftware von anderen Herstellern wie zum Beispiel Acronis oder Veeam einsetzen.

Disaster-Recovery-Lösungen als Backup-Ersatz

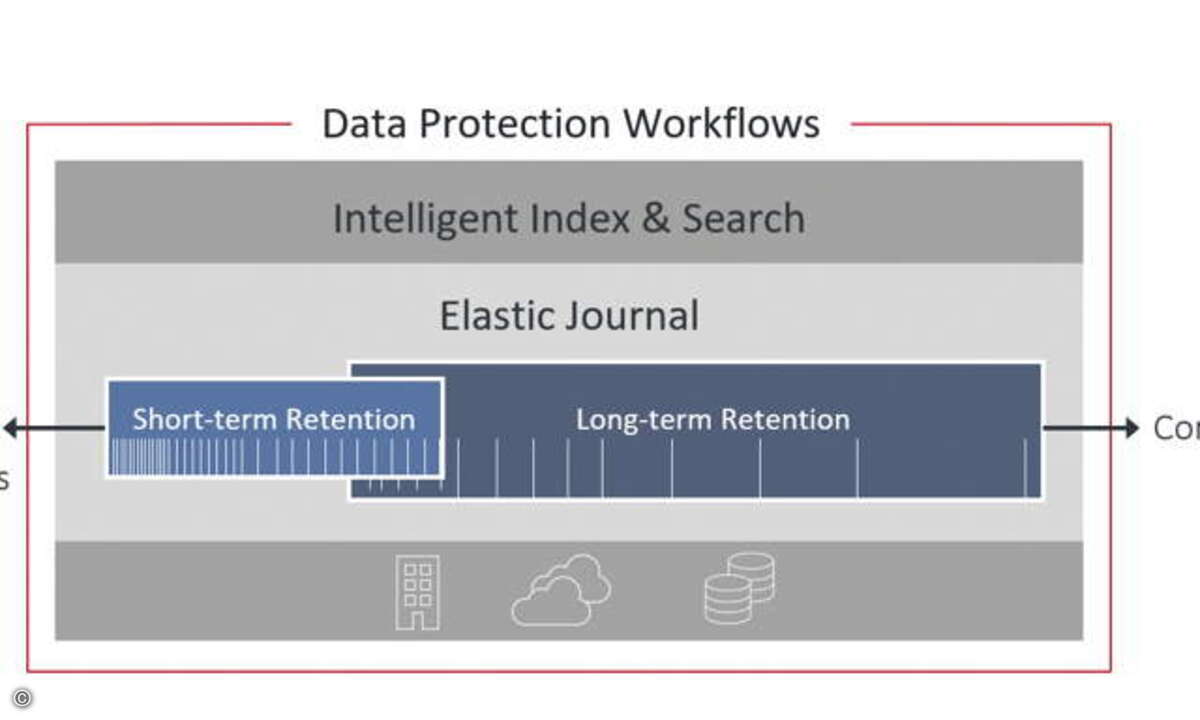

Bei den Anbietern von Disaster-Recovery-Lösungen (DR) gibt es ebenfalls interessante Entwicklungen. So baut beispielsweise Zerto seine DR-Software in Richtung Langzeitsicherung und Archivierung aus, damit Unternehmen keine zusätzliche Backup-Lösung mehr benötigen. Zerto ist in der Lage, VMs und die zugehörigen Daten per Continuous Data Protection (CDP) fortlaufend in Abständen von wenigen Sekunden zu einem anderen Standort oder in die Cloud zu replizieren. Die Versionsstände werden in einem leistungsfähigen Journal gespeichert. Mithilfe von Consistency Groups stellt Zerto sicher, dass die Lösung alle zu einer Anwendung gehörenden VMs zeitgleich repliziert, um die Konsistenz der Daten zu gewährleisten. Bei einem Standortausfall lassen sich die Replica-VMs automatisch in der gewünschten Reihenfolge hochfahren und skriptgesteuert mit den passenden IP-Adressen konfigurieren.

Die aktuelle Zerto IT Resilience Platform 6.5 kann von den replizierten Daten Backups erstellen und diese bis zu einem Jahr aufheben. Die Backups erzeugt Zerto mithilfe der replizierten Datenbestände, wodurch es die Produktivsysteme nicht belastet.

Die Speicherung der längerfristigen Backups erfolgt auf Secondary-Storage-Systemen. Die Speichersysteme für den Desasterschutz müssen dagegen leistungsfähiger sein, weil sie bei einem Standortausfall ausreichend Performance benötigen, um die Replica-VMs für einen längeren Zeitraum als Produktionsersatz bereitstellen zu können.

Die für das erste Halbjahr 2019 angekündigte Version 7 soll neben NFS auch SMB unterstützen und replizierte Datenversionen beliebig lange aufheben können. Laut Zerto wird die neue Version zudem in der Lage sein, die Dateisysteme von VMs zu indizieren und zu durchsuchen. Die längerfristig zu speichernden Daten lassen sich bei Bedarf in die Cloud übertragen. Die Zerto-Software eignet sich auch gut für eine Migration von virtuellen Maschinen zwischen verschiedenen Hypervisor-Plattformen und Cloud-Providern.

Fazit: HSS-Plattformen als neue Alternative

Die relativ neue Produktkategorie der Secondary-Storage-Plattformen bietet eine interessante Alternative zu traditionellen Backup-Lösungen. Durch den Scale-out-Ansatz auf Basis von kostengünstigen Standard-x86-Servern lassen sie sich problemlos ausbauen. Ob sich für ein Unternehmen eine Hyper-Converged-Plattform oder ein Object-Storage-System besser eignet, hängt von der Art und Menge der zu sichernden Daten ab sowie von den Applikationen, die zusätzlich zum Backup darauf laufen sollen. Durch die Cloud-Integration lassen sich mit Secondary-Storage-Systemen zudem kostengünstige Disaster-Recovery-Lösungen bei einem Cloud-Provider aufbauen, wodurch ein Unternehmen die Kosten für einen eigenen DR-Standort einsparen kann.