Von der Black Box zur Nachvollziehbarkeit: Erklärbare KI

KI-Systeme entscheiden längst über Bauteile, Kredite oder medizinische Befunde. Doch wie kommen sie zu ihren Ergebnissen? Erklärbarkeit wird zum zentralen Faktor für Vertrauen, Regulierung und Markterfolg.

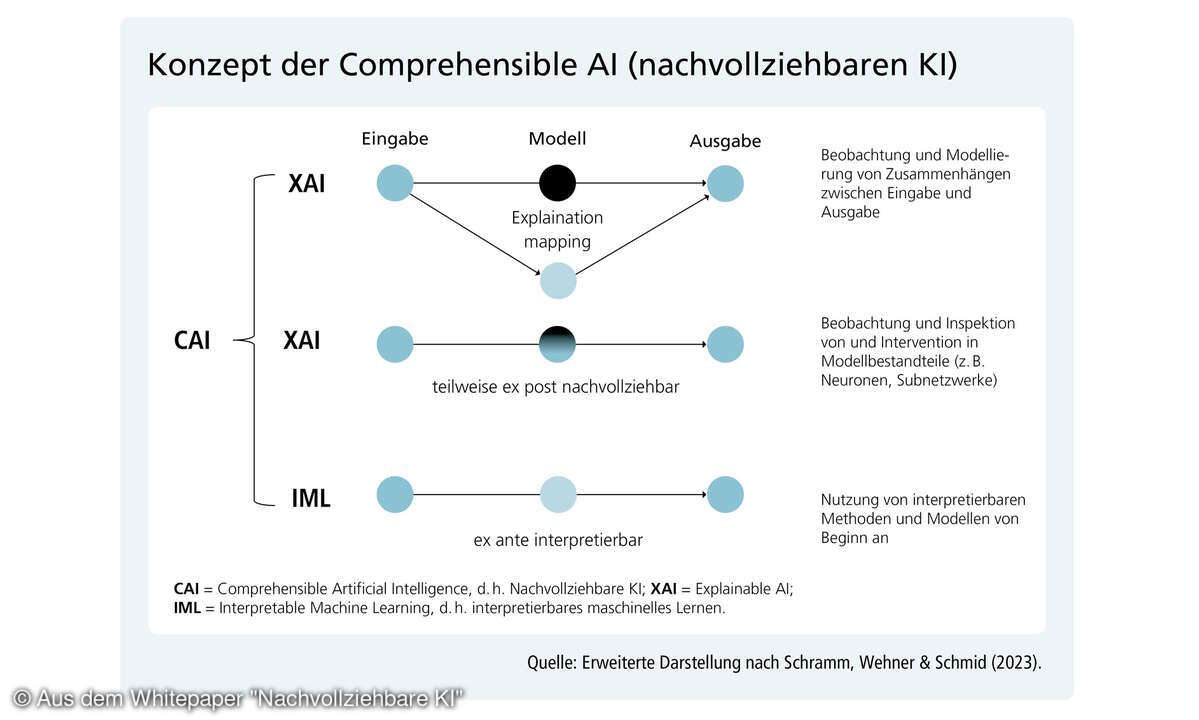

Neuronale Netze, insbesondere Deep-Learning-Modelle, bilden die Grundlage vieler aktueller KI-Anwendungen. Sie liefern beeindruckende Ergebnisse, doch für AnwenderInnen sind die Entscheidungswege oft undurchsichtig. Dieses „Black Box“-Image ist eine der größten Hürden für Akzeptanz und Marktdurchdringung. „Lange Zeit war unklar, was die Systeme gelernt haben, auf welcher Grundlage sie entscheiden oder warum sie manchmal fehlerhaft sind“, erklärt Wojciech Samek, Professor an der Technischen Universität Berlin und Leiter der KI-Abteilung am Fraunhofer Heinrich-Hetz-Institut (HHI) sowie Mitglied der Plattform Lernende Systeme. Erklärbarkeit – international als Explainable Artificial Intelligence (XAI) bezeichnet, im Deutschen oft auch Nachvollziehbare KI – soll genau hier ansetzen. Sie umfasst Methoden, die Menschen verstehen lassen, warum ein Modell ein bestimmtes Ergebnis liefert, und stärkt so das Vertrauen.

Dabei gibt es unterschiedliche methodische Ansätze: Model-aware-Verfahren benötigen direkten Zugriff auf das Modell und seine internen Aktivierungen, während model-agnostische Methoden Erklärungen auch ohne Kenntnis der internen Strukturen ermöglichen. Letztere approximieren das Modellverhalten lokal, indem sie Eingaben variieren und analysieren, wie die KI reagiert – zum Beispiel, ob ein Bild als „Katze“ erkannt wird, weil die Ohren oder die Schnurrhaare relevant sind.

Zielgruppen mit unterschiedlichen Erwartungen

Samek unterscheidet verschiedene Zielgruppen für Erklärbarkeit: Entwickler profitieren von Einblicken, um Systeme zu verbessern und Bias vorzubeugen. Prüfinstitutionen benötigen Nachvollziehbarkeit, um mit Blick auf den EU AI Act gesetzliche Vorgaben einzuhalten. Und Anwender – ob Ärztin, Callcenter-Mitarbeiter oder Bürger – wollen Entscheidungen überprüfen und zusätzliche Informationen erhalten. „Ein Arzt nutzt Erklärungen nicht nur zur Validierung, sondern auch als Zusatzinformation“, so Samek. In der Verwaltung wiederum sei es entscheidend, dass KI-Assistenten nicht nur Antworten liefern, sondern auch auf die zugrundeliegenden Gesetzestexte verweisen: um Halluzinationen vorzubeugen.

Das aktuelle Whitepaper der Plattform Lernende Systeme („Nachvollziehbare KI. Erklären, für wen, was und wofür“) liefert hierfür den systematischen Rahmen: Erklärungen müssen adressatengerecht erfolgen. Laien erwarten intuitive, leicht verständliche Begründungen, während Fachkräfte präzise technische Einblicke benötigen.

Datenqualität, Bias und der Prozessgedanke

Ein zentraler Punkt für Samek ist die Qualität der Trainingsdaten. „Wenn Daten fehlerhafte Labels oder einen Bias enthalten, übernehmen Modelle diese Artefakte“, warnt er. Für medizinische Anwendungen bedeutet das etwa: Eine KI, die nur auf einen Hauttyp trainiert ist, liefert unzuverlässige Ergebnisse für andere Patientengruppen. Erklärbarkeit kann hier entscheidend sein: Sie ermöglicht es, Entscheidungen auf Trainingsdaten zurückzuführen und so Schwachstellen sichtbar zu machen.

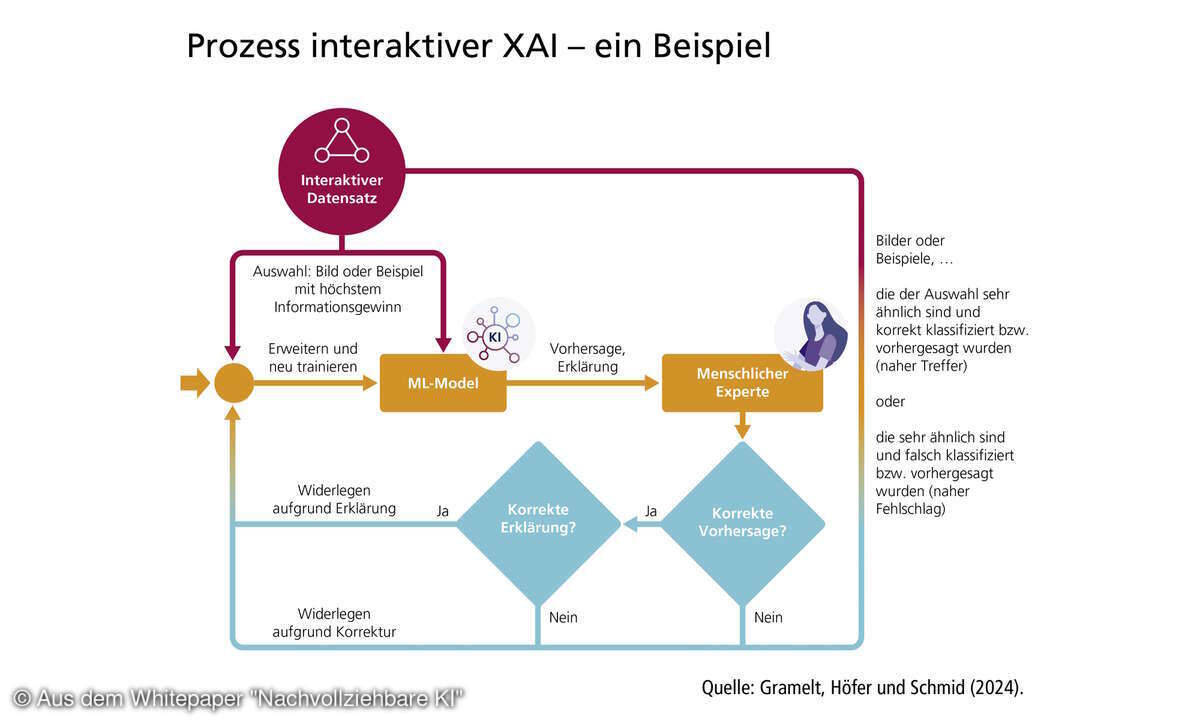

Samek sieht dies als Teil eines iterativen Prozesses: Modelle trainieren, mit XAI-Methoden überprüfen, Probleme identifizieren, Daten verbessern, neu trainieren. „Man muss Erklärbarkeit viel stärker als Prozess begreifen, nicht als Knopfdruck-Erklärung.“Das Whitepaper ordnet Erklärbarkeit in vier Zielrichtungen ein:

- Vertrauen schaffen,

- Systeme verbessern,

- Rechtskonformität sichern,

- Risiken managen.

Damit wird klar, dass Erklärbarkeit kein technisches Add-on ist, sondern ein essenzieller Bestandteil des KI-Lebenszyklus.

Von Forschung zu Praxis: Anwendungsfelder und Demos

Praxisbeispiele zeigen den Nutzen: In der industriellen Qualitätskontrolle erkennen KI-Modelle fehlerhafte Bauteile. In der Medizin lassen sich Hautkrebserkennungs-Systeme mit etablierten Lehrbuchregeln abgleichen. Besonders spektakulär: Ein Nature-Artikel beschrieb die Entdeckung einer neuen Antibiotikaklasse, unterstützt durch erklärbare KI. Doch es bleibt viel Entwicklungsarbeit. „Viele Unternehmen haben noch ein eindimensionales Bild von Erklärbarkeit, meist reduziert auf Heatmaps. Dabei gibt es längst Methoden, die interne Modellstrukturen und Zusammenhänge zwischen Daten und Entscheidungen sichtbar machen“, betont Samek.

Das Whitepaper verweist zudem auf die ökonomische Relevanz: Erklärbarkeit kann Innovation beschleunigen, Produkthaftungsrisiken verringern und die Einhaltung regulatorischer Vorgaben erleichtern – ein klarer Wettbewerbsvorteil.

Sameks Gruppe arbeitet außerdem an Demos, die den praktischen Mehrwert greifbar machen. Ein Beispiel: juristische Systeme, die nicht nur Antworten liefern, sondern zugleich auf einschlägige Urteile als Quellen verweisen. „So erhält der Anwalt nicht nur eine KI-Empfehlung, sondern eine nachvollziehbare Grundlage für seine Entscheidung.“

Standards, Regulierung und Marktimpulse

Mit dem EU AI Act erhält Erklärbarkeit neue Dringlichkeit. Doch bislang fehlen international einheitliche Standards. „In anderen Industrien – etwa Luftfahrt, Videokodierung oder Mobilfunk – existieren seit Langem Normen. In der KI-Welt entwickelt sich alles so schnell, dass wir hier hinterherhinken“, sagt Samek. Er plädiert für einen Bottom-up-Ansatz: Standards sollten aus konkreten Use Cases entstehen, damit sie praxistauglich sind. Die Plattform Lernende Systeme fordert ebenfalls, branchenspezifische Best Practices zu entwickeln und interdisziplinär abzustimmen. Nur so könne Erklärbarkeit Teil einer europäischen Strategie für vertrauenswürdige KI und digitale Souveränität werden.

Besonders in Deutschland ist der Bedarf hoch. Samek beobachtet, dass Unternehmen hier stärker Wert auf Nachvollziehbarkeit legen als in anderen Ländern. Auch wenn das Verständnis von XAI oft noch auf veraltete Visualisierungsmethoden beschränkt ist. Damit ist die Entwicklung erklärbarer KI nicht nur ein Forschungsthema, sondern auch industriepolitisch relevant. Deutschland und Europa könnten sich mit vertrauenswürdiger, nachvollziehbarer KI international profilieren – als Gegenmodell zu „Black Box“-Systemen großer US- und chinesischer Anbieter.Das Whitepaper benennt zentrale Spannungsfelder, die Standards berücksichtigen müssen: Transparenz vs. Schutz geistigen Eigentums, Verständlichkeit vs. Komplexität, Effizienz vs. Kontrolle. Genau diese Abwägungen entscheiden darüber, ob Erklärbarkeit im Alltag funktioniert:

Samek: „Erklärbarkeit ist kein Luxus, sondern ein Wettbewerbsvorteil – für Unternehmen wie für ganze Volkswirtschaften.“

Mensch und Maschine als Team

Samek betont, dass Erklärbarkeit keine Performance-Bremse darstellt. „Unsere Tools verändern die Modelle nicht, sondern erklären sie im Nachhinein.“ Entscheidend sei die Gestaltung der Mensch-Maschine-Interaktion: „Wenn man zu viele Informationen gibt oder sie falsch strukturiert, erreicht man das Gegenteil: mentale Überlastung.“ Daher sei es wichtig, dass Nutzer nicht nur Erklärungen erhalten, sondern auch lernen, wie KI funktioniert und wo ihre Grenzen liegen. „Die Gefahr ist groß, dass Nutzer KI als Alleskönner sehen. Erklärbarkeit kann helfen, Grenzen sichtbar zu machen und Mensch-Maschine-Teams zu stärken.“ Die Plattform Lernende Systeme sieht darin einen gesellschaftlichen Auftrag: Erklärbare KI soll Brücken schlagen zwischen technischer Leistungsfähigkeit, rechtlicher Sicherheit und gesellschaftlichem Vertrauen.