Appliance-Lösung für plattformübergreifendes Daten-Management

Mit der Hammerspace Data Platform können Anwender von überall aus auf Unternehmensdaten zugreifen, unabhängig davon wo sie gespeichert sind. Das von Hammerspace entwickelte Parallel Global File System fungiert als Zwischenschicht, die den Dateizugriff auf Storage-Systeme beliebiger Hersteller steuert. Für die Linux-Welt ist zudem ein High-Performance Parallel NFS erhältlich und für KI-GPU-Server eine Speziallösung für die Integration der lokalen NVMe-SSDs in einen zentralen Speicherpool. Wir testeten die Data Platform mit virtuellen Appliances in einer Cloud-Lab-Umgebung.

Das im Jahr 2018 in den USA gegründete Unternehmen Hammerspace hat eine Daten-Management-Lösung entwickelt, mit der sich die in vielen Firmen vorhandenen Storage-Silos aufbrechen lassen. Die Storage-Appliances ermöglichen einen transparenten Zugriff der Anwender auf unstrukturierte Geschäftsdaten, unabhängig davon, von wo aus sie darauf zugreifen und auf welchen Storage-Systemen die Daten gespeichert sind. Herzstück der Lösung ist das Hammerspace Parallel Global File System (PGFS), das die Datenzugriffe steuert, indem es als Zwischenschicht die Metadatenverwaltung übernimmt und die Dateizugriffe damit von der darunterliegenden Storage-Infrastruktur entkoppelt.

Die SDS-Lösung (Software Defined Storage) von Hammerspace lässt sich auf beliebigen Standard-Hardware-Servern oder virtuellen Rechnern installieren. Sie ist auch als Hardware-Appliance mit Servern von Dell, Supermicro oder Hitachi Vantara erhältlich. Der Hersteller bietet die Plattform zudem in den Clouds von AWS, Azure, Google und Oracle als vorkonfigurierte virtuelle Appliances an, wodurch auch Cloud-Migrationen unterstützt werden.

Die Data Platform besteht an jedem Standort immer aus zwei Appliance-Typen. Die Data Services Nodes (DSX) sind die Arbeitstiere, um Aktionen wie zum Beispiel eine Migration von Daten zwischen verschiedenen Storage-Tiers gemäß der vom Systemverwalter definierten Storage-Richtlinien auszuführen. Ein DSX-Cluster kann aus bis zu 60 Nodes bestehen. Die Control Plane für die Metadatenverwaltung stellen die Anvil Metadata Services Nodes bereit, die sich als hochverfügbarer 2-Node-Cluster betreiben lassen.

Einfache Integration vorhandener Speichersysteme

Hammerspace unterstützt Storage-Systeme beliebiger Hersteller und die wichtigsten Storage-Typen wie NVMe, NAS, Block, Object, Cloud S3, BLOB, Kubernetes CSI sowie Tape. Die Software kennt zudem von vielen gängigen Storage-Systemen die APIs und kann dadurch zum Beispiel auch native Snapshots unterstützen. Auf den Client-Systemen, von denen aus die Anwender auf die Dateien zugreifen, sind keine zusätzlichen Treiber erforderlich, weil Hammerspace die Dateifreigaben über dieselben Protokolle anbietet, wie die dahinterliegenden Storage-Systeme.

Der Hersteller hat in die Data Platform umfangreiche Funktionen für das Storage-Management integriert. Hierzu zählen unter anderem Immutable Snapshots, Clones, Antivirus-Scans, Auditing-Features sowie WORM-Support. Für Cloud- und Object-Storage kann der Systemverwalter auch Datenkomprimierung, De-Duplizierung und Verschlüsselung aktivieren. Hinzu kommen Data Orchestration Services wie Data-in-Place-Assimilation, Replikation, Storage-Tiering sowie eine automatische Platzierung von Daten anhand ihrer Metadaten oder gemäß der vom Systemverwalter konfigurierten sogenannten Objectives.Diese von Hammerspace entwickelten Objectives-Regelwerke spielen eine wichtige Rolle bei der automatisierten Datenverwaltung. Die Data Platform bringt standardmäßig zahlreiche Vorlagen mit, zum Beispiel um bestimmte Daten immer auf leistungsfähigen Storage-Systemen zu speichern oder immer automatisch zwei Kopien auf einem NVMe-System und auf einem S3-Speicher abzulegen. Der Systemverwalter kann eigene Objectives definieren, um beispielsweise die für die Erstellung von Monatsabschlüssen benötigten Daten temporär auf ein schnelleres Storage-System zu migrieren und nach dem Abschluss der Ultimo-Berechnungen automatisch wieder an ihren ursprünglichen kostengünstigeren Speicherort zurück zu verschieben.Die Data Platform eignet sich auch gut für KI-Workloads, die häufig Daten aus unterschiedlichen Quellen und von unterschiedlichen Storage-Plattformen als Input verwenden. Der zentrale Zugriff auf heterogene Speicherlandschaften vereinfacht dabei das Daten-Management deutlich.Für Linux bietet Hammerspace zudem ein High-Performance Parallel File System an. Es verwendet das vom Hersteller für NFS v4.2 entwickelte Parallel NFS, das für Linux-Systeme einen direkten Datenpfad vom Storage-Backend zum Linux-Client unterstützt. Diese unter dem Namen Hyperscale NAS Architecture angebotene Lösung eignet sich sehr gut für HPC-Anwendungen wie zum Beispiel das Training von KI-Modellen.Hammerspace hat des Weiteren eine Lösung entwickelt, die den schnellen lokalen NVMe-Storage von GPU-Servern, die für KI-Projekte eingesetzt werden, in den zentralen Speicherpool des Parallel Global File System integriert. Diese NVMe-SSDs lassen sich normalerweise nicht sinnvoll nutzen, weil damit nur lokale Zugriffe möglich sind. Hammerspace verwendet dazu die Eigenentwicklung LOCALIO für NFS v3, die im Linux Long-Term Support Kernel 6.12 veröffentlicht und im Mai 2025 in RHEL10 aufgenommen wurde. Der NVMe-Storage wird als NFS v3 exportiert, sodass er sich über das PGFS von externen Clients nutzen lässt.

Hammerspace im Testbetrieb

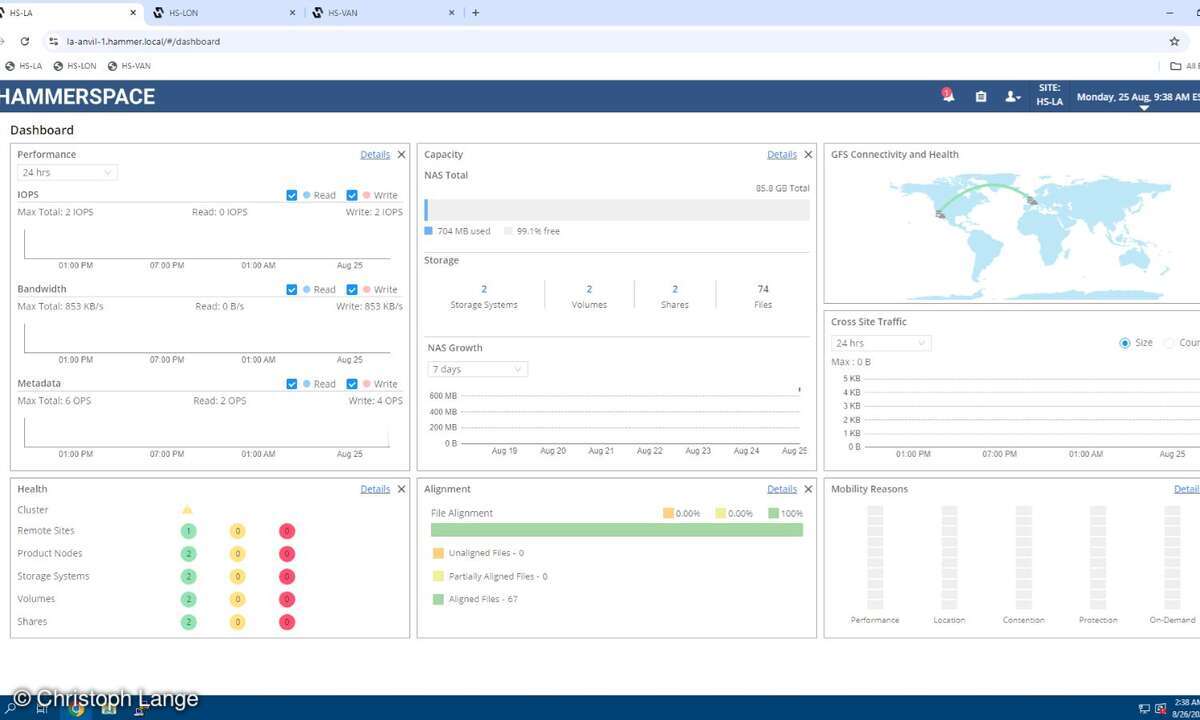

Für den Test der Data Platform verwendeten wir eine Lab-Umgebung mit virtuellen Hammerspace-Appliances, die der Hersteller in der Azure Cloud betreibt. Das Lab besteht aus den drei Standorten Los Angeles (LA), London (LON) und Vancouver (VAN). An jedem Standort läuft ein Anvil Metadata Services Node und ein Data Services Node (DSX). Die auf den DSX-Nodes gespeicherten Daten lassen sich zwischen den Standorten replizieren. Als Object Storage für den Austausch von Daten zwischen den Sites ist zudem an jedem Standort dasselbe Amazon S3 Speicher-Bucket angebunden. Die Dateizugriffe und die Verwaltung der Hammerspace-Systeme erfolgen über einen virtuellen Windows-Client der Testumgebung, der gleichzeitig als Active-Directory-Controller fungiert. Eine Firewall-VM schützt die Systeme vor unbefugten Zugriffen.Der Zugriff auf die Management-Konsolen der Anvil-Nodes erfolgt per Web-Browser. Der Lab-Benutzer kann sich bei Bedarf auch direkt an der Kommandozeile der Appliances anmelden. Die von uns für diesen Test durchgeführten Konfigurationsarbeiten ließen sich alle über die Web-GUI durchführen. Sie bietet eine Dashboard-Ansicht, die den aktuellen Zustand der Data Platform anzeigt. Der Systemverwalter sieht auf einen Blick aktuelle Performance-Daten wie IOPS und genutzte Bandbreite sowie die Auslastung der Speicherkapazität. Ampelfarbensymbole zeigen zudem den Status aller wichtigen Systemkomponenten an.Damit Hammerspace auf alle Unternehmensdaten zugreifen kann, müssen die Informationen zu den auf Third-Party-Speichersystemen liegenden Dateien zunächst in die Anvil-Metadatenbank aufgenommen werden. Dies erfolgt durch die sogenannte Assimilation der vorhandenen Filesysteme, wobei nur die Metadaten ausgelesen werden, die Dateien aber an ihrem ursprünglichen Speicherort verbleiben. Sobald dieser Prozess abgeschlossen ist, kann der Systemverwalter die Zugriffspfade für die Verzeichnisfreigaben im Unternehmensnetz so umkonfigurieren, dass alle Dateizugriffe immer über die Hammerspace Data Platform erfolgen.

Zahlreiche Features für die Share-Verwaltung

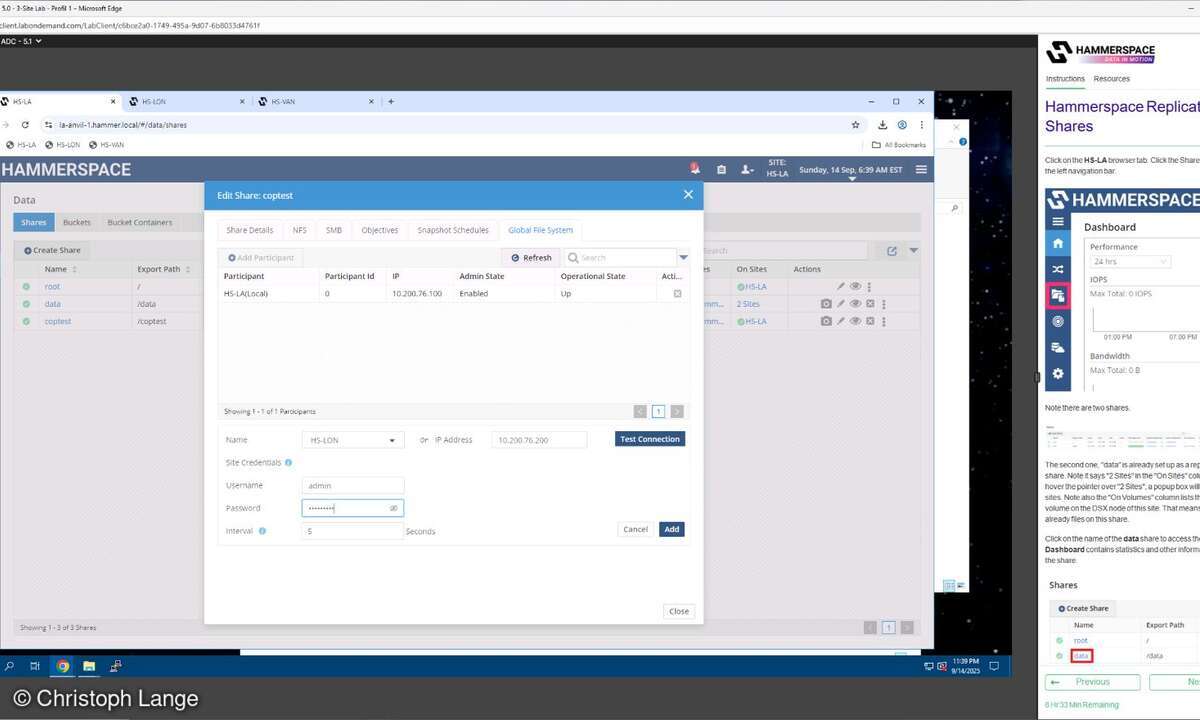

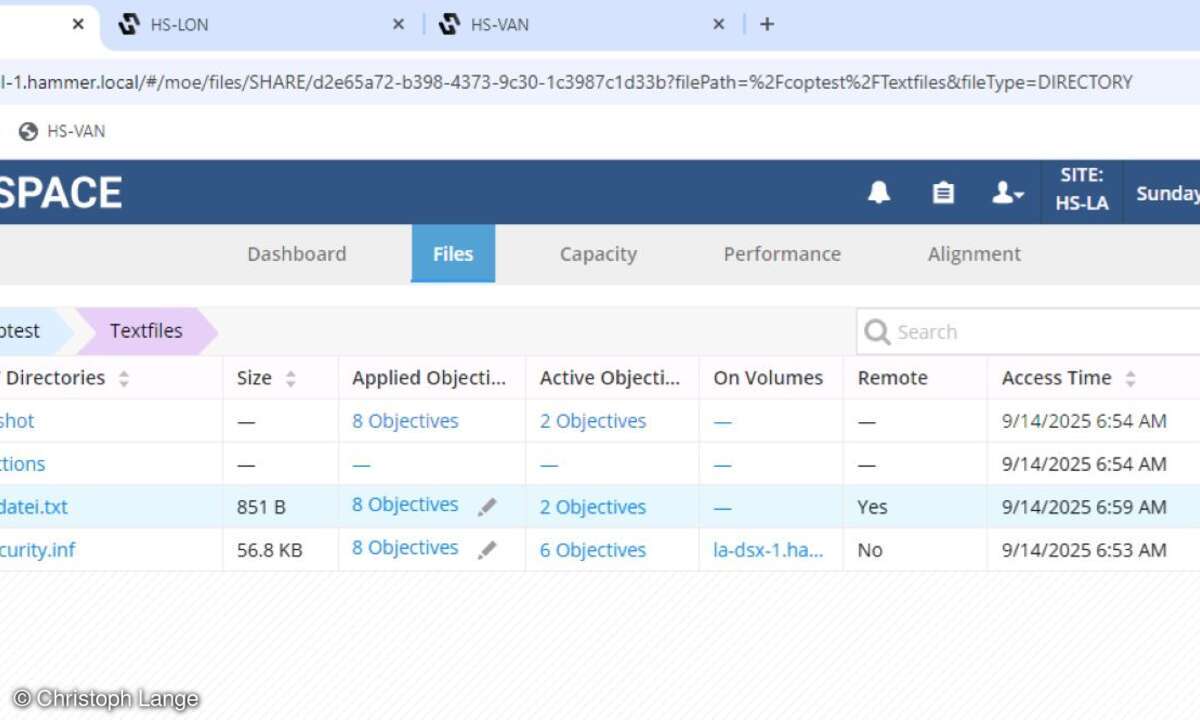

In der Lab-Umgebung war bereits ein Share /data für den Zugriff auf die auf den DSX-Nodes gespeicherten Testdateien vorkonfiguriert. Die Verwaltung der Verzeichnisfreigaben erfolgt über das Shares-Menü, das vielfältige Konfigurationsoptionen bereitstellt. Wir legten für den Test auf der Appliance am Standort LA das neue Share /coptest an und kopierten anschließend einige Dateien in die neue Freigabe. Die Dateien hatten wir zuvor aus dem Internet auf den Windows-Lab-Client heruntergeladen.Das Shares-Menü enthält ebenfalls eine Dashboard-Ansicht mit der aktuellen Performance- und Speicherkapazitätsauslastung der ausgewählten Freigabe. Der Systemverwalter kann auf der Share-Ebene Quotas setzen, um die maximale Speicherkapazität zu begrenzen. Mit Snapshot-Schedules ist zudem eine automatische Sicherung der Verzeichnisfreigaben möglich.Im Untermenü Files finden sich detaillierte Informationen zu allen Verzeichnissen und Dateien, die unter diesem Share-Pfad gespeichert sind. Da wir bei der Anlage des Shares die Replikation der Metadaten nicht aktiviert hatten, wurde in der File-Ansicht noch keine Remote-Site als alternativer Speicherort angezeigt. Wir suchten deshalb zunächst im Hauptmenü nach dem Dialog für die Replikationskonfiguration und fanden ihn schließlich im Edit-Menü von /coptest. Hier fügten wir unter dem Reiter Global File System den Standort London als Remote-Speicherort hinzu. Anschließend wurde in der Dateiansicht die Spalte Remote mit dem Status No angezeigt.Um das Verhalten von Hammerspace bei Dateizugriffen von unterschiedlichen Standorten aus zu testen, griffen wir über die /coptest-Freigabe der LON-Appliance auf die Dateien zu. Anschließend wechselten wir in den Unterordner Textfiles, fügten bei einer Datei eine neue Zeile Text hinzu und speicherten diese. Daraufhin wurde diese Datei am Standort LA im File-Menü jetzt mit dem Status Remote = Yes angezeigt. Auf der LON-Appliance dagegen hatte die Datei nun den Remote-Status No und als Speicherort wurde das Volume des DSX-Systems in London angezeigt.Für die Anwender erfolgt der Dateizugriff transparent und sie arbeiten mit der Standard-Storage-Policy immer mit lokal an ihrem Standort gespeicherten Dateien. Hammerspace unterstützt auch eine Multisite-Replikation, für die sich pro Standort individuelle Regeln definieren lassen. Der Systemverwalter kann für Shares mithilfe der sogenannten Objectives auch eine Policy konfigurieren, die sicher stellt, dass die Dateien immer am selben Standort oder sogar auf demselben Speichersystem gespeichert bleiben und bei Remote-Zugriffen nicht auf ein Storage-System am entfernten Standort verschoben werden.

Objectives für automatisiertes Daten-Management

Die von Hammerspace für die Data Platform entwickelten Objectives sind ein mächtiges Werkzeug für das Daten-Management. Damit lassen sich Regelwerke definieren, die zum Beispiel dafür sorgen, dass bestimmte Datentypen immer auf Storage-Systemen mit der vorgegebenen Verfügbarkeitsklasse gespeichert werden. Der Systemverwalter kann auch unterschiedliche Storage-Tiers mit langsameren und schnelleren Systemen anlegen, wodurch die Daten gemäß der für sie definierten Objectives immer auf den passenden Speichersystemen abgelegt werden. Es ist ebenso möglich, selten genutzte Dateien automatisch auf langsamere Storage-Tiers oder ein S3-Archiv zu verschieben.Für den Test erstellten wir am Standort London ein neues Share und konfigurierten im Objectives-Menü die Regel, dass alle Dateien auf dem Hammerspace DSX-Storage in London liegen sollen. Anschließend erstellten wir in der über die LA-Appliance gemappten Share-Freigabe eine neue Textdatei, die zunächst auf dem DSX-System am LA-Standort gespeichert wurde. Der File-Alignment-Prozess von Hammerspace läuft permanent im Hintergrund und sorgte automatisch dafür, dass die Datei gemäß der von uns definierten Regel von der DSX-Appliance in LA auf das Speichersystem in London verschoben wurde. Mithilfe der Objectives kann der Systemverwalter auch eigene Regelwerke für die unternehmensweite Speicherung von Daten erzeugen.Um den Überblick nicht zu verlieren, stellt Hammerspace mit dem Mobility-Menü eine grafische Darstellung der an den jeweiligen Standorten gespeicherten Daten zur Verfügung.

Anhand von farblich kodierten Datenflussdiagrammen lässt sich erkennen, welche Datenbewegungen in welcher Richtung und aufgrund welcher Policy in den vergangenen Tagen, Wochen oder Monaten stattgefunden haben. Die Data Platform von Hammerspace ist eine Art Schweizer Taschenmesser für das Datenmanagement, mit dessen Hilfe sich vielfältige Anforderungen abdecken lassen. Die Kosten für die Lösung richten sich nach der damit verwalteten Datenmenge.