DCIM weiter gedacht

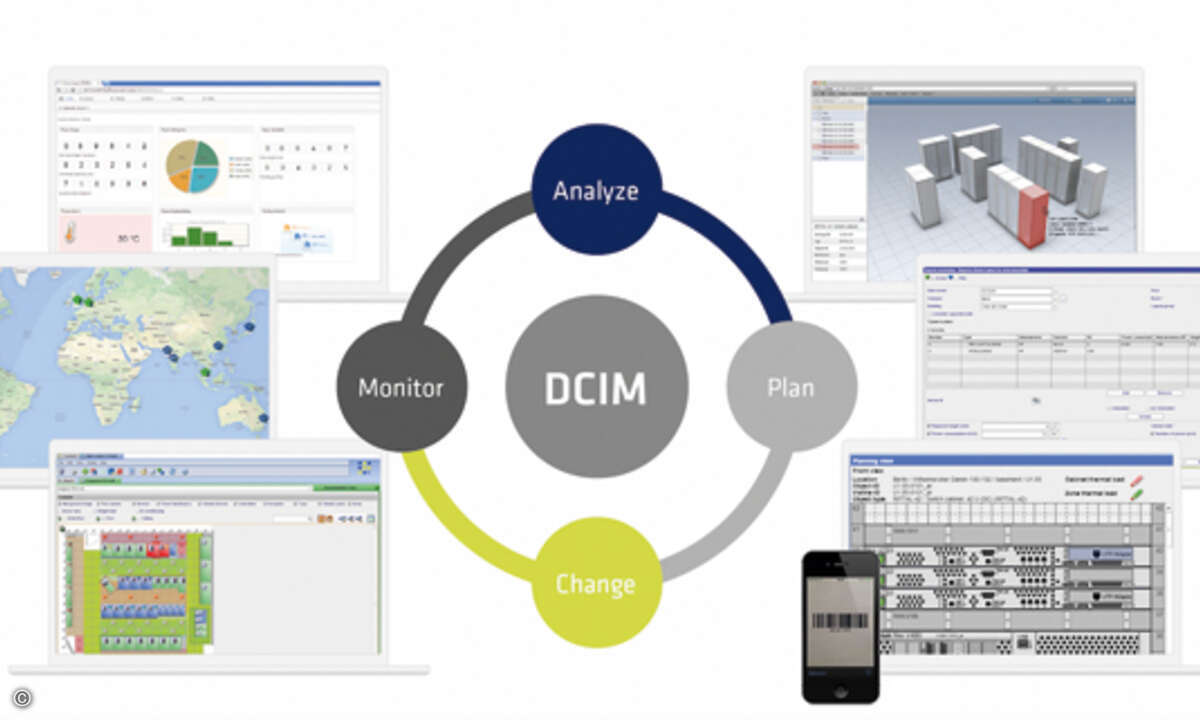

Data Center Infrastructure Management ist angetreten, Silos zu überbrücken und agile Methoden über die Grenzen von Fachabteilungen hinweg zu ermöglichen. Dieses "Bridging the Gap" nur als Verbindung von Facility-Management und Server-Management zu sehen, ist allerdings viel zu kurz gesprungen.

- DCIM weiter gedacht

- Digitale Transformation koordiniert angehen

- Neue Anforderungen an DCIM-Lösungen

In jedem Rechenzentrum treffen eine ganze Reihe von Disziplinen und Akteure aufeinander: Facility-Management-Teams, Server- und Storage-Admins, Datenbankspezialisten, Netzwerker geben sich ein Stelldichein. Teilweise sind diese Gruppen in ganz unterschiedlichen Bereichen der Firmenorganisation verankert und es ist im heutigen RZ-Betrieb leider selten ein wirklich synchronisiertes und orchestriertes Miteinander zu finden – weshalb oft von „Silos“ gesprochen wird.

Die Zuständigkeiten und Betriebskonzepte sind meist historisch gewachsen und selten konzeptioniert. So manche durch-geführte Umstrukturierung, um Verbesserungen zu schaffen, ist in Anbetracht veränderter Bedingungen, neuer Technologien oder von Zukäufen und Expansion schon wieder hinfällig. Dadurch ergibt sich eine erhebliche Diskrepanz zwischen tatsächlichem Aufgabenzuschnitt für Teams sowie deren Organigramm und den heutigen Bedürfnissen an den agilen Betrieb eines Rechenzentrums.

Silo-Strukturen und die Crux der Virtualisierung

An dieser Stelle stellt sich die Frage: Was ist „das“ Rechenzentrum eigentlich? Was ist mit dem Begriff gemeint? Abhängig von der eigenen Perspektive gibt es deutlich unterschiedliche Belegungen. Mal ist es der Raum, in dem die Server stehen, mal das gesamte Gebäude bestehend aus dem sogenannten „White Space“ und den zugehörigen Technikräumen, dem „Grey Space“, sowie sonstigen Räumen.

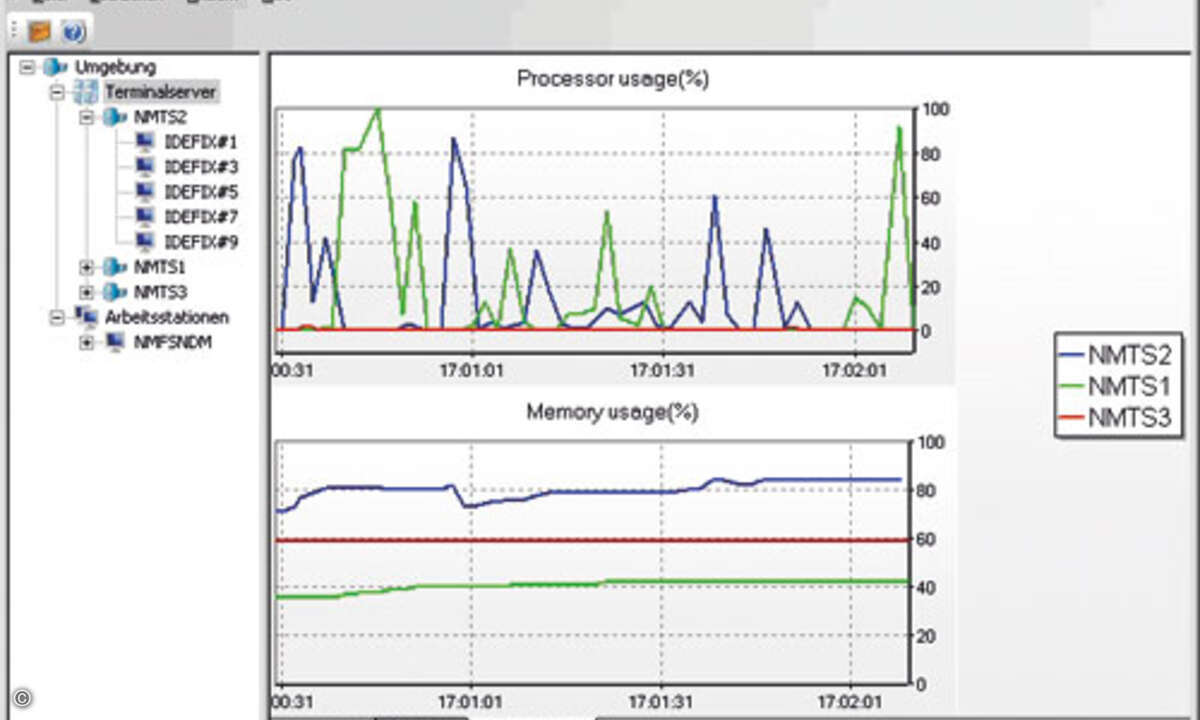

Ähnlich wie die Sprachverwirrung ist auch die individuelle Sicht der Akteure auf die Effizienz ihrer Abläufe und Methoden zu werten. Jedes Silo, sprich jedes Team, nutzt in der Regel eigene Methoden und Tools, um seinen Aufgabenbereich zu verwalten und die in seiner Verantwortung stehenden Systeme zu betreiben. Für die tägliche Arbeit der Servertruppe mag die Einschränkung auf „ihre“ Geräte hilfreich sein, aus der Sicht des Gesamtunternehmens ist eine derartig isolierte Betrachtung allerdings nicht zielführend. Virtualisierung von Systemen und die neuen „programmierbaren Netzwerke“ durch SDN (Software Defined Networking) haben enorme Geschwindigkeiten bei der Bereitstellung erreicht. Allerdings gibt es noch Optimierungspotenzial bei der Planung und der Einführung dieser Methoden und Technologien, weil oftmals solide Planungsgrundlagen und geeignete Planungstools fehlen. Denn in der Diskussion um „virtuell“ und „software-defined“ wird meist der Umstand außer Acht gelassen, dass diese Technologien eben nicht nur virtuell und abstrakt sind, sondern auf ganz real existierender Hardware beruhen.

Jedes Private Cloud-System läuft auf einem Server und die Datenpakete wandern durch eine erhebliche Anzahl tatsächlich existierender Kabel und Patch-Panel. Passive Komponenten sind aber weder durch Autodiscovery-Technologien zu erkennen, noch über Software-Tools zu steuern. Und diese Physik hat auch noch eigene Lebenszyklen, einen eigenen Rhythmus und leider auch ab und an eine Störung. Wenn es keine vernünftige Dokumentation und Planung der echten Zusammenhänge gibt, ist jede Fehlersuche im Störungsfall eine Sisyphus-arbeit und dauert viel zu lange. Auch die Wenn-Dann-Analyse für geplante Änderungen ist immer unvollständig – und eine Sicherheitsanalyse bei getrennter Betrachtung der Schichten schlichtweg unzulässig.