Gute Daten, schlechte Daten

Wie sich mit Augmented Intelligence die Datenqualität verbessern lässt.

- Gute Daten, schlechte Daten

- Augmented Intelligence

Bei Diskussionen zu den Möglichkeiten von Künstlicher Intelligenz (KI) für Echtzeitanalysen ging es bislang meist um das Thema Rechenleistung. Dies ist zwar eine wichtige Voraussetzung, um in kürzester Zeit umsetzbare Erkenntnisse aus einer Analyse zu liefern, jedoch nicht der einzige relevante Faktor. Die Marktanalysten von Gartner berichten in ihrem Report „Market Guide for Self-Service Data Preparation 2016“, dass Analytics-Anwender den größten Teil ihrer Zeit damit verbringen, Daten für die Analyse aufzubereiten oder darauf zu warten, dass die Daten für sie aufbereitet werden – es rückt also die Datenqualität immer mehr in den Fokus.

Eine hohe Datenqualität sorgt dafür, dass die Erkenntnisse aus Analytik und KI präzise und zuverlässig sind. Das bedeutet, dass die richtigen Daten an der richtigen Stelle vorhanden sein müssen. Schließlich gibt es keine KI ohne perfekte Daten, und es gibt keine perfekten Daten ohne Menschen. Auf diese Weise lässt sich die Künstliche Intelligenz als Erweiterung der menschlichen Intelligenz betrachten. KI ist nur so gut, wie die Daten, die der Mensch zur Verfügung stellt. Schließlich ist KI dazu bestimmt, Ergebnisse zu präsentieren, die ein Mensch nutzen kann. Man könnte sie daher auch als Augmented Intelligence bezeichnen, also eine Art erweiterte Intelligenz.

Anbieter zum Thema

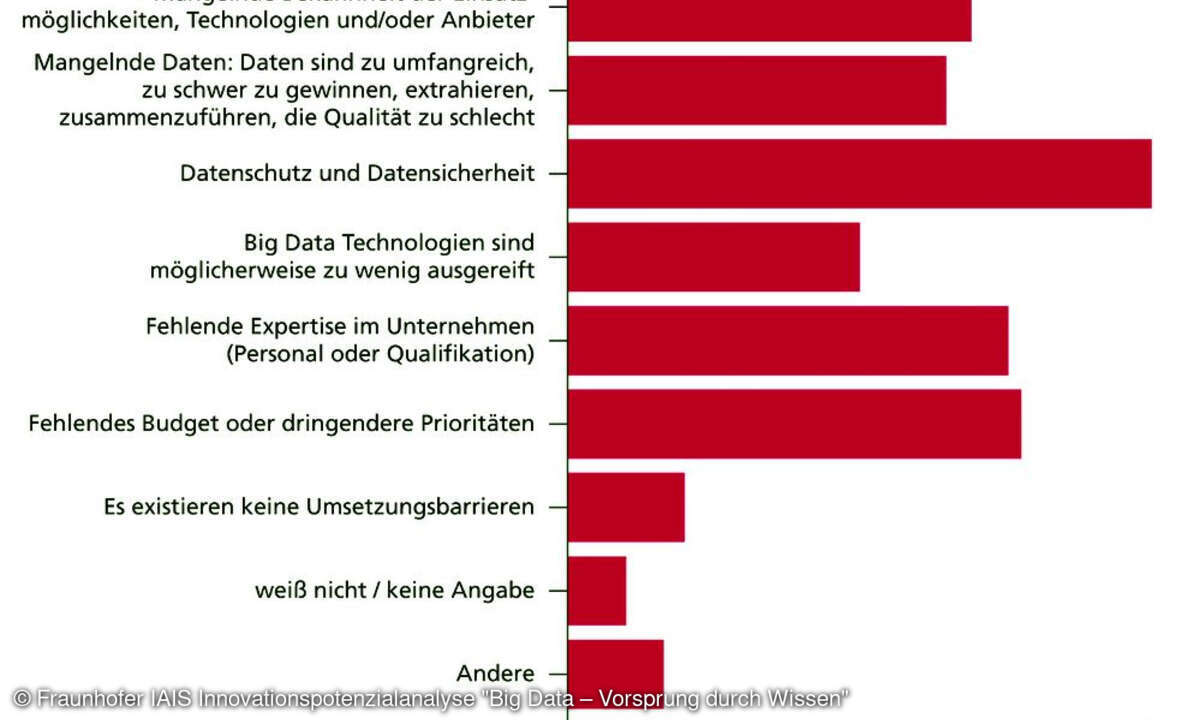

Schlechte Daten eliminieren

Laut IBM verursacht mangelhafte Datenqualität in den USA Kosten von umgerechnet rund 2,54 Billionen Euro pro Jahr. Die Analysten von Gartner schätzen die durchschnittlichen finanziellen Auswirkungen mangelhafter Daten auf umgerechnet 12,7 Millionen Euro jährlich. Das Wirtschaftsmagazin Harvard Business Review schreibt dies den sogenannten „hidden data factories“ zu: In verschiedenen Abteilungen müssen Mitarbeiter die bereits im System vorhandenen Daten auf Fakten und Konsistenz überprüfen. Diese Aufgabe führen Mitarbeiter zusätzlich zu ihrem Tagesgeschäft durch, was schließlich Stress und unnötige Mehrarbeit für das Team bedeutet. Dies wiederum führt zu fehlerhaften Daten, die in den Händen der Kunden landen, und Mitarbeitern, die bis zu 50 Prozent ihrer Zeit damit verbringen, Daten zu finden und zu korrigieren.

In einer Welt, in der Daten als „neues Öl“ bezeichnet werden, sollten Unternehmen daher sicherstellen, dass die verarbeiteten Informationen von entsprechend hoher Qualität sind. Häufig sind die innerhalb einer Organisation implementierten Prozesse dafür jedoch zu langwierig und ineffizient. Daher sind Organisationen nicht in der Lage, mit der riesigen Menge an rohen und unstrukturierten Daten umzugehen. In der Praxis wird daher selten der gesamte Datenbestand analysiert, um daraus echte Business Insights zu generieren. Laut den Analysten von IDC wurden im Jahr 2013 weniger als ein Prozent der weltweiten Daten analysiert. Haben es Data Scientists schließlich mit hohem Zeitaufwand doch geschafft, die vorhandenen Daten aufzubereiten, so sind die Erkenntnisse meist nicht mehr für Echtzeitprozesse nutzbar.

Aber warum sind eine Echtzeitanalyse und der Time-to-Insight-Faktor so wichtig? In der heutigen Wirtschaft können sich Märkte schnell verändern und damit verlieren Bestandsdaten rasch ihre Aktualität. Hubspot, ein Anbieter von Marketing-Software, schätzt in einem Bericht aus dem Jahr 2013 die Datenverfallsrate auf jährlich 22,5 Prozent – vermutlich dürfte der Wert mittlerweile schon etwas höher liegen. Unternehmen müssen also sicherstellen, dass sie mit diesem Tempo Schritt halten und alte Daten schnellstmöglich aktualisieren. Schließlich nutzen vom Marketing bis zum Management viele Geschäftsbereiche aktuelle Informationen zur Entscheidungsfindung, sodass eine hohe Datenqualität immer wichtiger wird. Realtime Analytics und KI helfen dabei, Angebote und Preise an die aktuelle Marktsituation anzupassen und die Kunden mit individuellen Angeboten anzusprechen. Auf Basis jeweils aktueller Marktdaten gelingt es zudem, schneller neue Produkte zu entwickeln, um sich einen Vorsprung vor der Konkurrenz zu sichern. Datengetriebene Echtzeitanalysen und KI werden damit zu einem zentralen Faktor für den Geschäftserfolg.