Die Eroberung der Anwendungen

Das Mittelalter von Ethernet war geprägt vom Übergang von der Bus-Technik (CSMA/CD) hin zu strukturierten Netzen. Dies ermöglichte eine Vergrößerung der Netzausdehnung und eine Erhöhung der Bandbreite. Damit war nun genügend Potenzial zur Eroberung neuer Anwendungen vorhanden. Hatten sich die Ethernet-Verfechter bisher im Büro und bestenfalls im Campus engagiert, so gerieten nun neue Anwendungen ins Visier

In der Urzeit hatten die Provider die Digitalisierung der Telefonie mit PDH-Technik (Plesiochronous Digital Hierarchy) gestartet, in den USA 1965 und in Europa 1968. Als diese Technik zu teuer wurde und den Ansprüchen der modernen Telefonie nicht mehr genügte, kam ab 1985 zunächst in den USA das SONET (Synchronous Optical Network) auf und drei Jahre später in Europa die SDH-Technik (Synchronous Digital Hierarchy). Die Digitalisierung betraf allerdings nur das Backbone, die Endgeräte arbeiteten nach wie vor analog. Dies änderte sich erst 1993, als ISDN zur Verfügung stand. Zu einer Zeit, als die Ethernet-Experten über 100 MBit/s nachdachten, meinte der deutsche Telefon-Provider noch, dass 2 x 64 kBit/s auch am Arbeitsplatz ausreichten. Mit der Einführung der DSL-Technik (Digital Subscriber Loop oder Line) 1999 änderte sich diese Meinung sehr schnell. Mit Datenraten bis zu 6 MBit/s standen den Benutzern nun Möglichkeiten offen, die ISDN zur Datenübertragung bald vergessen ließen. Mit der Datenübertragung über das Telefonnetz hatte man sich ein erhebliches Problem eingehandelt. Das für Telefongespräche ausgelegte Backbone-Netz schaffte die Datenlast nicht mehr. Daher mussten die Provider ein zusätzliches Datennetz aufbauen, und das Ganze migrierte nach und nach zu Ethernet. Zwar waren die damals zur Verfügung stehenden 1.000 MBit/s bei Weitem nicht ausreichend, aber es eröffnete sich eine Zukunftsperspektive. Da die Endanwender Ethernet bereits verwendeten, ergab es Sinn, diese Technik auch innerhalb der Provider-Netze zu nutzen.

Abbau der Geschwindigkeits- und Ausdehnungsdefizite

Dieses „eine Gigabit“ war vielleicht für die meisten Kunden der Provider ausreichend, aber das Backbone verlangte natürlich viel höhere Geschwindigkeiten. Auch die damaligen Reichweiten waren viel zu gering. Nachdem jedoch die Bustechnik aufgegeben war, waren weder Bandbreite noch Reichweite ein Problem. Heute stehen den Providern Geschwindigkeiten bis zu 400 GBit/s zur Verfügung. Auch die Reichweiten in den Standards stellen heute mit 40 km (80 km in Entwicklung) kein Hindernis für große Provider-Netze mehr dar.

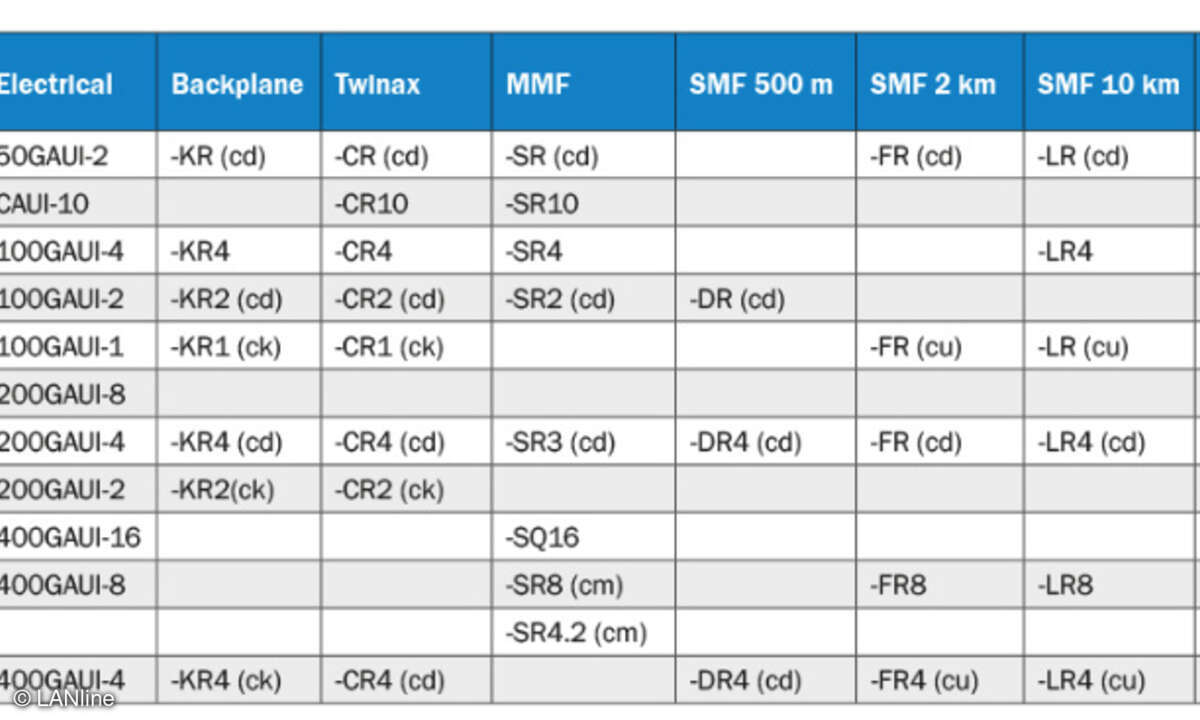

Tabelle 1 zeigt die heute für Provider und Rechenzentren zur Verfügung stehenden Interfaces ab 50 GBit/s. Die in Entwicklung befindlichen Interfaces sind gekennzeichnet durch den Arbeitskreis, der für die Normierung zuständig ist.

Die Zukunft

Mit der heute aufkommenden Grundgeschwindigkeit von 100 GBit/s per Lane und der gerade diskutierten 200-GBit/s-Technik ist die Branche nun in der Lage, Terabit-Netze zu realisieren. Mit einer solchen Technik werden in Zukunft Terabit-Netze auch ökonomisch machbar. Heute untersuchen die Experten Netze mit 800 oder 1.600 GBit/s, die in drei bis fünf Jahren zum Standard werden sollen.

Auch wenn Geschwindigkeiten und Reichweiten kein Problem mehr darstellten, blieb dennoch das Problem der Garantie von gewissen Netzparametern wie Geschwindigkeit, Verzögerung und Jitter (Schwankung der Verzögerung). All dies kann Ethernet allein nicht garantieren, da es keinerlei Informationen über die Datenflüsse innerhalb eines Netzes mit sich bringt. Abhilfe schuf hier die MPLS-Technik (Multi-Protocol Label Switching), die Ethernet gleich zweimal verwendet. Auf der physischen Ebene dient Ethernet als Autobahn, auf der MPLS sichere und qualitätskontrollierte Verbindungen herstellt. Diese Verbindungen stellen für den Kunden das (virtuelle) Ethernet dar, auf dem er all seine Anwendungen realisieren kann, auch die zeit- und sicherheitskritischen Applikationen. Ein solches MPLS-Netz ist ausfallsicher durch schnelles Umschalten der Verbindungen (Rapid Reconfiguration) und kann gleichzeitig den beim Verbindungsaufbau vereinbarten Service garantieren. Mit diesen Eigenschaften ist Ethernet heute die dominierende Technik für Provider-Netze geworden.

Ethernet in Zugangsnetzen

Mit den oben geschilderten Provider-Netzen erreicht man jedoch bei Weitem nicht alle Kunden, es sind vielmehr Zugangsnetze nötig. Um sich von den Providern abzugrenzen, die den Begriff „Last Mile“ verwendeten, nannte man die Zugangsnetze zunächst „Ethernet in the First Mile“ (EFM), was die unterschiedlichen Blickwinkel deutlich macht.

Anbieter zum Thema

Der Begriff EFM hat sich jedoch nicht lange gehalten, da er der Absicht entgegenstand, die Provider einzubinden. Heute steht in der Norm der Begriff „Subscriber Networks“. Anfangs hatte die Ethernet-Fraktion versucht, den bereits erfolgreich im Markt platzierten DSL eine Ethernet-Kupfertechnik entgegenzusetzen. Dies scheiterte jedoch, da man mit der Kupfertechnik (P2PoC, Point to Point on Copper) viel zu spät war. Auch der zweite Versuch war nicht besonders erfolgreich. P2PoF (Point to Point on Fiber) ist eine Standard-Ethernet Technik, die für die Anbindung einer Ansammlung von Wohnhäusern/Wohnungen zwei Bridges verwendet, eine beim Provider (Central Office) und eine in der Nähe der Kunden. Zwei Erweiterungen sind dazu definiert: Entfernungen zunächst bis zu zehn Kilometer und bidirektionale Übertragung. Uplink und Downlink verwenden nur noch eine Glasfaser, das Senden und Empfangen übernimmt also jeweils eine eigene Wellenlänge. Waren es zunächst Geschwindigkeiten bis zu 1 GBit/s und Entfernungen bis zehn Kilometer, so sind es heute bis zu 50 GBit/s und 40 km.

EPON löst das P2PoF-Problem

Ein Grund dafür, das P2PoF nicht so recht erfolgreich ist, besteht darin, dass die Bridge beim Kunden Strom benötigt, auch wenn sie möglicherweise mitten in der freien Landschaft steht. Folgerichtig hat man ein EPON (Ethernet Passive Optical Network) standardisiert, das an die Stelle der aktiven Bridge einen passiven optischen Splitter setzt, der das Laserlicht von der Zentrale an alle Kunden verteilt.

Dazu dient eine bidirektionale Technik, die in Richtung zum Kunden das Licht an alle auf einer Wellenlänge sendet und für den Rückweg eine zweite Wellenlänge verwendet. Auf dieser Wellenlänge erhalten die einzelnen Kunden Slots für ihre Datenübertragung. Zum Einsatz kommt also eine kombinierte WDM/TDM-Technik (Wavelength/Time Division Multiplexing). Damit konnte man anfangs 32 Kunden mit 1 GBit/s über maximal 20 km anschließen. Heute sind es maximal 64 Verbraucher mit 50 GBit/s über 40 km.

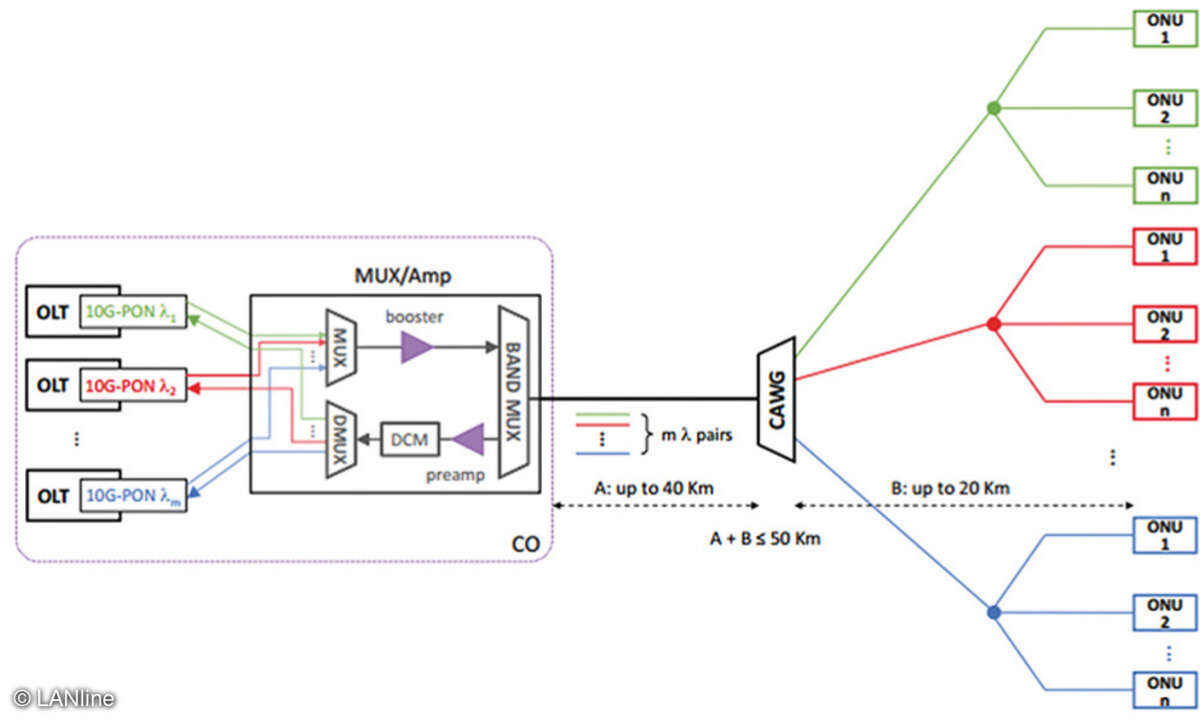

Optische Switches

Unter dem Label SuperPON arbeiten Experten heute an Terabit-Zugangsnetzen. Ein SuperPON ist als Überlagerung von maximal 16 EPONs realisiert. Über eine Glasfaser sind dabei maximal 16 EPONs an einen optischen Switch (CAWG, Cyclic Arrayed Waveguide Gratings) geführt, der diese auf passende Glasfasern verteilt. Diese verteilen dann über jeweils einen passiven Knoten die Information auf die Kunden. So sind in naher Zukunft 1.024 Kunden über maximal 60 km erreichbar. Mit SuperPON kann man die Anzahl der zu verlegenden Glasfaserkabel erheblich reduzieren, woraus sich sehr attraktive Anwendungsszenarien ergeben, auf die Teil 4 eingehen wird.

Hans Lackner ist Diplom-Informatiker und seit 1990 stimmberechtigtes Mitglied von IEEE 802.3. Er hat an sämtlichen Standards von 10Base-T bis zu den heutigen 400-GBit/s-Techniken mitgewirkt.