Big Data Analytics von MapR

Datenschätze in der Telekommunikation heben

Fortsetzung des Artikels von Teil 1

Datengestützte Verbesserungen des Angebots

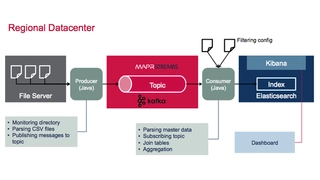

Telekom-Anbieter müssen Daten verteilen – zwischen Funkzellen, Nutzern und Verarbeitungszentren – und die schiere Menge erfordert es, die Daten so nah wie möglich an der Quelle zu verarbeiten, um sie danach an verschiedene Rechenzentren zur weiteren Nutzung zu überstellen.

Analyse und Verarbeitung großer Datenmengen

Wer geografisch verteilte Events mit hohem Durchsatz in Echtzeit verarbeiten kann, ist in der Lage, Probleme zu lokalisieren, nachzuvollziehen, und mögliche Auswirkungen auf Kunden vorherzusehen. Auch lassen sich so Muster in der Netzauslastung beobachten; so können rechtzeitig Rekonfigurationen vorgenommen werden, um kurzfristige Lastspitzen abzufangen – etwa die hohe Auslastung rund um die Allianz-Arena während einem Bayern-Spiel. Wer zudem sein Equipment im Blick behält, und mittels Event-Verarbeitung seine Kapazitätsplanung und vorausschauender Wartung optimiert, kann die größten Sorgen des Telekom-Anbieters effektiv angehen, etwa Gesprächsabbrüche, fehlende Bandbreite und langsame Downloadraten.

Data Science lässt sich zudem einsetzen, um das Verhalten der eigenen Kunden besser zu verstehen und sogar vorhersagen zu können. Es handelt sich dabei um einen iterativen Prozess, der im Prinzip drei Schritte beinhaltet: Data Discovery, Modellnutzung und Data Discovery. Nein, das ist kein Fehler. Data Discovery, also die Identifikation von Daten und deren Modellierung steht am Anfang und am Ende – einmal zur Erstellung eines Modells und einmal zu seiner Verbesserung mit frischen Daten.

Die Modellierung kann etwa über die Analyse historischer Daten erfolgen. Data Discovery beinhaltet jedoch noch mehr: Dazu gehört auch die Erschließung neuer Datenquellen, die traditionelle Analyse und Datenbanken noch nicht nutzen – meist wegen Problemen mit dem Format, der Größe oder Struktur der Daten. Ein weiterer Garant möglichst nützlicher Modellen ist die richtige Auswahl der Machine-Learning-Algorithmen, um die Daten zu verwerten. So stehen am Ende brauchbare Vorhersagen, mit denen der Telekom-Anbieter seinen Kunden besser und schneller versorgen kann.

- Datenschätze in der Telekommunikation heben

- Datengestützte Verbesserungen des Angebots

- Den Kunden verstehen

- Beispiel aus der Praxis