Datenrisiken bei ChatGPT & Co.

Generative KI braucht Regeln

Mitarbeiter lieben hilfreiche KI-Tools und setzen sie notfalls auch ohne Wissen oder Zustimmung der IT-Abteilung ein. Dabei übersehen sie häufig, welche Datenrisiken damit verbunden sind. Doch wie können Unternehmen sensible Daten schützen, ohne die hilfreichen Tools komplett zu sperren?

Der Artikel liefert unter anderem Antworten auf folgende Fragen:

- Was sind generative KI-Tools und warum sind sie beliebt?

- Welche Risiken birgt die Verwendung von generativer KI für Unternehmen

- Welche Maßnahmen können Unternehmen ergreifen, um den Umgang mit generativer KI sicherer zu gestalten?

- Warum ist das Sperren von KI-Tools keine effektive Lösung für Unternehmen?

- Welcher Ansatz kann Unternehmen helfen, sensible Daten bei der Nutzung von KI-Tools zu schützen?

- Welche Rolle spielen Sicherheitslösungen wie Data Loss Prevention (DLP) beim Schutz sensibler Daten in KI-Tools?

- Wie unterstützen DLP-Lösungen Unternehmen bei der Verbesserung der Datensicherheit?

- Welche Vorteile bietet eine richtige Datenklassifizierung in Bezug auf Datensicherheit und Zertifizierungen für Unternehmen?

- Wie können Unternehmen große und verteilte Datenbestände effizient klassifizieren?

- Welche Rolle spielen Sicherheitszertifizierungen bei der Sicherung von Daten in Unternehmen?

Was vor rund einem Jahr mit ChatGPT begann, ist heute aus vielen Unternehmen nicht mehr wegzudenken: generative KI, die Texte, Bilder und Videos erstellt, und das inzwischen so gut, dass die Ergebnisse oft nur noch schwer von menschengemachten Inhalten zu unterscheiden sind. Neben ChatGPT erfreuen sich auch Bard, Jasper, Copilot und andere Tools schnell wachsender Beliebtheit, weil sie den Arbeitsalltag enorm erleichtern und viel Zeit sparen. Statt Marketingtexte oder E-Mails mühsam selbst zu verfassen, geben Mitarbeiter der KI einfach die wichtigsten Informationen vor und überlassen ihr das Ausformulieren. Auf Wunsch erstellen die Algorithmen auch Präsentationen, optimieren Quellcode und liefern in Sekunden eine Übersetzung oder Zusammenfassung langer Texte. Vielfach ersetzen KI-Tools sogar die klassische Google-Suche, da sie Fragen direkt beantworten, statt auf unzählige Websites zu verweisen.

Letztlich sind die Tools aber nicht nur unglaublich hilfreich, sondern lassen sich auch so unkompliziert nutzen, dass Mitarbeiter kaum darüber nachdenken, wie sie funktionieren und was mit den eingegebenen Daten geschieht. Oft ist ihnen gar nicht klar, dass sie gegen Datenschutzgesetze verstoßen könnten, wenn sie beispielsweise Kundendaten eingeben, um sich ein Anschreiben formulieren zu lassen – schließlich speichern und verarbeiten die meisten Anbieter generativer KI die Daten auf Systemen außerhalb der EU. Oder dass sie womöglich geistiges Eigentum und andere vertrauliche Informationen des Unternehmens preisgeben, wenn sie Quellcode, Präsentationen oder E-Mails von KI überarbeiten lassen. Diese sensiblen Daten könnten im Falle eines Datenlecks beim Anbieter an die Öffentlichkeit gelangen oder, was fast noch schwerer wiegt, in den Antworten der KI für andere Anwender landen. Viele Anbieter nutzen die Eingaben nämlich, um ihre KI-Modelle zu trainieren und deren Antworten immer weiter zu optimieren.

Blocken ist nicht die Lösung

Für Unternehmen besteht damit Handlungsbedarf, wollen sie die Kontrolle über ihre sensiblen Daten nicht verlieren. Sinnvoll ist es zum Beispiel, das Bewusstsein der Mitarbeiter für die Risiken im Umgang mit generativer KI durch Schulungen zu schärfen und Nutzungsregeln zu vereinbaren. Diese könnten beispielsweise die Vorgabe umfassen, keine eigenen Accounts anzulegen und nur vom Unternehmen bereitgestellte und verwaltete Accounts zu verwenden, und ohne dedizierte Genehmigung keinen Code oder sensible Daten einzugeben. Ähnlich wie die inzwischen üblichen Verpflichtungserklärungen zum Datenschutz müssten Mitarbeiter die Kenntnis der vereinbarten KI-Regeln per Unterschrift bestätigen.

Einen richtigen Schutz sensibler Daten garantiert dieses Vorgehen indes nicht, denn Fehler sind menschlich. Insbesondere in hektischen Arbeitsphasen kann es durchaus passieren, dass Mitarbeiter unaufmerksam sind und die KI-Tools dennoch mit vertraulichen oder personenbezogenen Daten füttern. Aus diesem Grund greifen Unternehmen teilweise zur einfachsten und auch restriktivsten Lösung und sperren ChatGPT und Co. kurzerhand via DNS- oder URL-Filter. Angesichts der Vielzahl von KI-Tools, die es bereits gibt und die kontinuierlich neu hinzukommen, ist das allerdings ein fast aussichtsloses Unterfangen. Zumal Mitarbeiter die Sperren leicht umgehen können, indem sie von außerhalb des Unternehmensnetzwerks auf die Tools zugreifen.

Zudem sollten sich Unternehmen modernen KI-Tools nicht verschließen – zu groß ist ihr Mehrwert im Arbeitsalltag schon jetzt, obwohl ihre Entwicklung fast noch am Anfang steht. Ihre Nutzung komplett zu blockieren, hieße, auf effizientere Arbeitsweisen und produktivere Mitarbeiter zu verzichten. Bei denen wiederum kann das Blocken für Frust und sinkende Motivation sorgen, wenn liebgewonnene Tools plötzlich nicht mehr funktionieren. Was also tun?

Zero Trust verhindert Datenabflüsse

Im Prinzip müssen Unternehmen den Zugang zu KI-Tools wie den Zugang zu Cloud-Diensten reglementieren. Am besten funktioniert das mit einem Zero-Trust-Ansatz, bei dem Sicherheitslösungen wie Secure Web Gateway (SWG) und Cloud Access Security Broker (CASB) sicherstellen, dass nur von IT-Abteilung, Security-Team und Rechtsabteilung geprüfte und freigegebene KI-Tools genutzt werden, und das auch nur von autorisierten Mitarbeitern – unabhängig davon, mit welchem Gerät und von welchem Standort sie auf die Tools zugreifen. Wird ein nicht zugelassenes Tool aufgerufen, könnte ein Redirect zu einer intern genehmigten Alternative erfolgen.

Da sensible Daten auch durch versehentliche Eingaben autorisierter Nutzer bei genehmigten KI-Tools abfließen können, müssen Unternehmen darüber hinaus genau kontrollieren, welche Informationen die Tools erhalten. Am besten funktioniert das mit Lösungen für Data Loss Prevention (DLP), die nicht nur den Umgang mit Daten überwachen und regeln, sondern auch bei Datenklassifizierungen helfen. Entdecken sie, dass Mitarbeiter personenbezogene oder vertrauliche Daten in Formularfelder eintragen, unterbinden sie das. Bei weniger kritischen Daten reicht meist ein einfacher Warnhinweis für den Anwender, während die Übertragung besonders kritischer Daten an die KI-Tools blockiert wird.

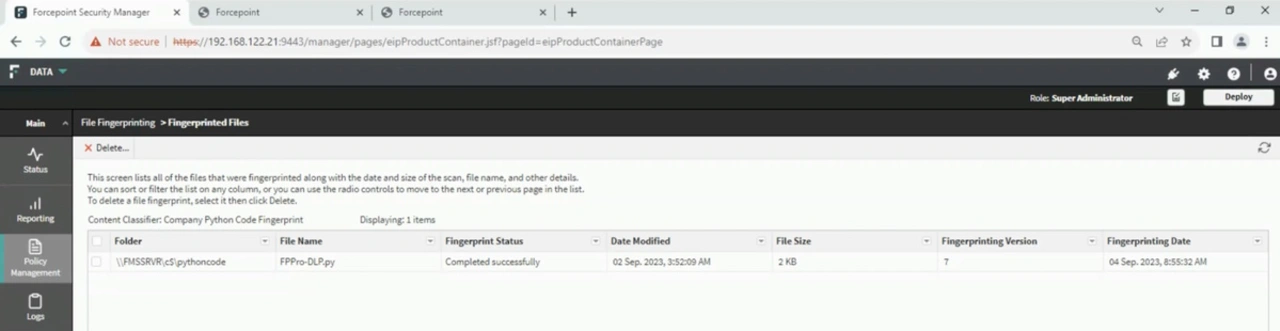

Häufig reicht es, sich zum Start auf die besonders kritischen Daten zu konzentrieren, um die Datensicherheit im Unternehmen bereits entscheidend zu verbessern. Fachbereiche können diese Daten – etwa Kundenlisten, Verträge, Quellcode oder Excel-Tabellen und Powerpoint-Präsentationen mit Finanzinformationen – leicht liefern. DLP-Lösungen analysieren die Dateien und erstellen einen Fingerabdruck, um die Inhalte später zuverlässig wiederzuerkennen und ihren Abfluss aus dem Unternehmen zu verhindern. Dank OCR-Funktionen funktioniert das selbst dann, wenn sich die Inhalte in einem Screenshot verstecken.

Dabei sollten Unternehmen auf Sicherheitslösungen setzen, die nahtlos zusammenarbeiten und einen zentralen Richtliniensatz nutzen. Andernfalls steigt nicht nur der Verwaltungsaufwand erheblich, sondern es besteht auch die Gefahr, dass die Richtliniensätze der verschiedenen Lösungen nicht konsistent sind und Lücken im Schutz entstehen. Einheitliche und zentral zu verwaltende Richtlinien hingegen erleichtern es, Verletzungen der Datensicherheit über alle KI-Tools, Kommunikationswege und Geräte hinweg zu verwalten.

DLP hilft bei Security-Zertifizierungen

Mittelfristig hilft eine richtige Datenklassifizierung, auch sensible Daten abseits der ganz kritischen Fälle zu schützen, die oft über eine Vielzahl von Speicherorten verteilt sind. Gute DLP-Lösungen beziehen hier bestehende Klassifizierungen beispielsweise aus der Azure Information Protection mit ein, damit Unternehmen, die bereits Daten klassifiziert haben, das nicht erneut tun müssen. Zudem können sie große und verteilte Datenbestände idealerweise mithilfe von KI und Machine Learning weitgehend automatisch klassifizieren, um den initialen Aufwand zu verringern und die DLP-Einführung zu beschleunigen. Auf diese Weise können Unternehmen nicht nur die Vorteile generativer KI nutzen, ohne den Abfluss schützenswerter Daten zu riskieren, sondern legen überdies den Grundstein für Zertifizierungen nach ISO 270011 oder TISAX 2.02, deren hohe Anforderungen an Datensicherheit und Datenschutz sich mit DLP leichter erfüllen lassen als ohne.

1 https://www.iso.org/standard/73906.html

2 https://portal.enx.com/de-DE/TISAX/tisaxassessmentresults/#